제스처 인식

Gesture recognition이 문서의 어조나 문체는 위키피디아에서 사용되는 백과사전적 어조를 반영하지 못할 수 있습니다.(2016년 11월 (이 및 ) |

제스처 인식은 수학적 알고리즘을 [1]통해 인간의 제스처를 해석하는 것을 목표로 하는 컴퓨터 과학 및 언어 기술의 주제입니다.그것은 컴퓨터 비전의 하위 분야이다.제스처는 신체적인 움직임이나 상태로부터 유래할 수 있지만, 일반적으로 얼굴이나 손으로부터 유래한다.현재[when?] 이 분야의 초점은 얼굴과 손동작 인식에서 감정 인식을 포함한다.사용자는 물리적으로 기기를 만지지 않고 간단한 제스처를 사용하여 기기를 제어하거나 상호 작용할 수 있습니다.수화를 해석하기 위해 카메라와 컴퓨터 비전 알고리즘을 사용하는 많은 접근법이 만들어졌다.그러나 자세, 보행, 프록시메틱 및 인간 행동의 식별과 인식은 제스처 인식 기술의 [2]주제이기도 하다.제스처 인식은 컴퓨터가 인간의 바디 랭귀지를 이해하기 시작하는 방법으로 볼 수 있습니다.따라서 입력의 대부분을 키보드와 마우스로 제한하고 기계 장치 없이 자연스럽게 상호작용하는 오래된 텍스트 사용자 인터페이스나 GUI(그래픽 사용자 인터페이스)보다 기계와 인간 사이에 더 나은 브릿지를 구축할 수 있습니다.

개요

제스처 인식 기능:

- 높은 정확도

- 높은 안정성

- 디바이스 잠금 해제 시간 단축

현재 제스처 인식의 주요 응용 분야[언제?] 시나리오는 다음과 같습니다.

제스처 인식은 컴퓨터 비전 및 이미지 [5]처리 기술을 사용하여 수행할 수 있습니다.

이 문헌에는 컴퓨터에 [6][7][8][9]연결된 카메라에 의한 제스처 또는 보다 일반적인 인간의 자세와 움직임을 포착하는 컴퓨터 비전 분야의 지속적인 연구가 포함되어 있습니다.

제스처 인식 및 펜 컴퓨팅:펜 컴퓨팅은 시스템의 하드웨어에 미치는 영향을 줄이고 제어에 사용할 수 있는 물리 세계의 오브젝트 범위를 키보드나 마우스 등의 기존 디지털 오브젝트보다 넓힙니다.이러한 실장에 의해, 모니터가 필요 없는 새로운 범위의 하드웨어가 가능하게 됩니다.이 아이디어는 홀로그래픽 디스플레이의 창조로 이어질 수 있다.제스처 인식이라는 용어는 그래픽 태블릿의 잉크, 멀티터치 제스처, 마우스 제스처 인식 등 텍스트 입력이 아닌 필기 기호를 더 좁게 지칭하기 위해 사용되었습니다.이것은 포인팅 디바이스 [10][11][12]커서로 기호를 그리는 것을 통한 컴퓨터 상호작용입니다.(펜컴퓨팅 참조)

제스처 타입

컴퓨터 인터페이스에서는, 다음의 2 종류의 제스처가 [13]구별됩니다.우리는 스케일링과 회전과 같은 직접적인 조작으로 간주될 수도 있는 온라인 제스처를 고려한다.반대로 오프라인 제스처는 일반적으로 상호작용이 완료된 후에 처리됩니다. 예를 들어 컨텍스트 메뉴를 활성화하기 위해 원을 그립니다.

- 오프라인 제스처:사용자가 개체와 상호 작용한 후 처리되는 제스처입니다.예를 들어 메뉴를 활성화하기 위한 제스처가 있습니다.

- 온라인 제스처:직접 조작 제스처그것들은 실제 물체를 스케일링하거나 회전하는 데 사용됩니다.

터치리스 인터페이스

터치리스 유저 인터페이스는 제스처 컨트롤에 관한 새로운 테크놀로지입니다.터치리스 유저 인터페이스(TUI)는, 키보드, [14]마우스, 또는 화면을 터치하지 않고, 몸의 움직임이나 제스처를 통해서 컴퓨터를 명령하는 프로세스입니다.제스처 컨트롤과 더불어 터치리스 인터페이스는 물리적으로 기기를 만지지 않고도 기기와의 상호작용을 할 수 있는 기능을 제공하므로 널리 보급되고 있습니다.

터치리스 테크놀로지의 종류

스마트폰, 노트북, 게임, 텔레비전, 음악 기기 등 이러한 종류의 인터페이스를 활용하는 기기들이 많이 있다.

터치리스 인터페이스 중 하나는 스마트폰의 블루투스 연결을 사용하여 회사의 방문자 관리 시스템을 활성화합니다.이를 통해 COVID-19 [15]대유행 중에 인터페이스에 접촉할 필요가 없어진다.

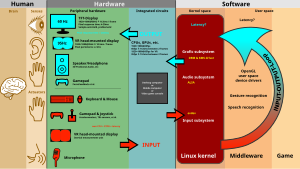

입력 장치

사람의 움직임을 추적하고 어떤 제스처를 하고 있는지 판단하는 기능은 다양한 도구를 통해 달성될 수 있습니다.Kinetic User Interface(KUI; 키네틱 사용자 인터페이스)는 사용자가 객체 및 본체의 [citation needed]움직임을 통해 컴퓨팅 장치와 상호 작용할 수 있도록 하는 새로운 유형의 사용자 인터페이스입니다.KUI의 예로는 Wii 및 Microsoft의 Kinect와 같은 동작 인식 게임과 기타 인터랙티브 [16]프로젝트가 있습니다.

이미지/비디오 기반의 제스처 인식에 대해서는 많은 연구가 이루어지고 있습니다만, 실장간에 사용되는 툴이나 환경에는 몇 가지 차이가 있습니다.

- 유선 장갑이들은 자기 또는 관성 추적 장치를 사용하여 손의 위치와 회전에 대한 입력을 컴퓨터에 제공할 수 있습니다.또한 일부 장갑은 손가락 굽힘을 정밀도(5~10도)로 검출하거나 촉각 피드백을 사용자에게 제공할 수 있어 촉각 시뮬레이션이다.시판되는 최초의 핸드 트래킹 글러브 [17]타입의 장치는 DataGlove로, 손의 위치, 움직임, 손가락의 구부림을 감지할 수 있는 글로브 타입의 장치였다.손등을 따라 내려오는 광케이블을 사용합니다.광펄스를 만들어 손가락이 구부러지면 작은 틈새로 빛이 새어 나와 손실이 기록돼 손모양의 근사치를 알 수 있다.

- 깊이 인식 카메라.구조화된 빛이나 비행 시간 카메라와 같은 특수 카메라를 사용하면 카메라를 통해 보이는 것에 대한 짧은 범위의 깊이 지도를 생성하고 이 데이터를 사용하여 보이는 것에 대한 3D 표현에 근접할 수 있습니다.이것들은 단거리 [18]능력으로 인해 손동작을 탐지하는 데 효과적일 수 있다.

- 스테레오 카메라.서로 관계가 알려진 두 대의 카메라를 사용하면 카메라의 출력으로 3D 표현을 근사할 수 있습니다.카메라의 관계를 파악하려면 렉시안 스트라이프나 적외선 방사체와 [19]같은 위치 측정 기준을 사용할 수 있습니다.직접 움직임 측정(6D-Vision)과 함께 사용하면 제스처를 직접 감지할 수 있습니다.

- 제스처 기반 컨트롤러이러한 컨트롤러는 몸의 연장선 역할을 하므로 제스처가 수행될 때 일부 동작을 소프트웨어에 의해 편리하게 캡처할 수 있습니다.제스처 기반 모션 캡처의 예로는 가상현실 및 증강현실 애플리케이션용으로 개발 중인 골격 손 추적을 들 수 있습니다.이 기술의 예는 추적 회사 [20][21]uSens와 Gestigon에 의해 보여집니다.이 회사는 사용자가 컨트롤러 없이 주변 환경과 상호작용할 수 있도록 합니다.

- 와이파이 감지[22]

이것의 또 다른 예는 마우스 제스처 트래킹으로, 마우스의 움직임은 제스처를 나타내기 위해 시간에 따른 [23][24][25]가속도의 변화를 연구할 수 있는 사람의 손에 의해 그려지는 기호와 관련이 있다.이 소프트웨어는 또한 사람의 떨림과 부주의한 [26][27][28]움직임을 보상합니다.이 스마트 발광 큐브의 센서는 손과 손가락뿐만 아니라 주변의 다른 물체를 감지하는 데 사용될 수 있고 데이터를 처리하는 데 사용될 수 있습니다.대부분의 애플리케이션은 음악 및 사운드 [29]합성이지만 다른 분야에도 적용할 수 있습니다.

- 싱글 카메라표준 2D 카메라는 다른 형태의 이미지 기반 인식에 적합하지 않은 리소스/환경에서 제스처 인식에 사용할 수 있습니다.이전에는 하나의 카메라가 스테레오나 깊이 인식 카메라만큼 효과적이지 않다고 생각되었지만, 일부 회사들은 이 이론에 이의를 제기하고 있다.표준 2D 카메라를 사용하여 강력한 손동작을 감지할 수 있는 소프트웨어 기반 제스처 인식 기술입니다.

알고리즘

입력 데이터의 유형에 따라 제스처를 해석하는 접근방식은 다른 방법으로 수행될 수 있습니다.그러나 대부분의 기술은 3D 좌표계로 표현되는 주요 포인터에 의존합니다.이러한 상대적인 움직임에 근거해, 입력의 품질이나 알고리즘의 어프로치에 따라, 제스처를 고정밀로 검출할 수 있다.

신체의 움직임을 해석하기 위해서는 공통적인 특성과 움직임이 표현할 수 있는 메시지에 따라 그것들을 분류해야 한다.예를 들어, 수화에서 각 제스처는 단어나 구를 나타냅니다.

일부 문헌은 제스처 인식에서 3D 모델 기반과 외관 기반이라는 두 가지 접근 방식을 [30]구분합니다.가장 중요한 방법은 손바닥 위치 또는 관절 각도와 같은 몇 가지 중요한 매개변수를 얻기 위해 신체 부위의 주요 요소의 3D 정보를 사용합니다.반면, 외관 기반 시스템은 이미지나 비디오를 직접 해석하기 위해 사용합니다.

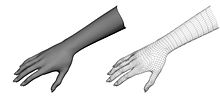

3D 모델 기반 알고리즘

3D 모델 접근 방식은 체적 또는 골격 모델을 사용하거나 둘의 조합을 사용할 수 있습니다.부피 측정 접근법은 컴퓨터 애니메이션 업계와 컴퓨터 비전 목적으로 많이 사용되어 왔습니다.모델은 일반적으로 NURBS 또는 폴리곤 메쉬와 같은 복잡한 3D 표면에서 만들어집니다.

이 방법의 단점은 계산 부하가 매우 높고 실시간 분석을 위한 시스템은 아직 개발 중이라는 것입니다.현재로선 단순한 원시 물체를 사람의 가장 중요한 신체 부위(예를 들어 팔과 목을 위한 실린더, 머리를 위한 구체)에 매핑하고 그것들이 서로 상호작용하는 방식을 분석하는 것이 더 흥미로운 접근법이 될 것이다.또한 슈퍼 4차원이나 일반 실린더와 같은 추상적인 구조는 신체 부위를 근사하는 데 훨씬 더 적합할 수 있습니다.

골격 기반 알고리즘

3D 모델의 집중적인 처리와 많은 매개변수를 처리하는 대신 세그먼트 길이와 함께 단순화된 버전의 접합 각도 매개변수를 사용할 수 있습니다.이것은 신체의 골격 표현으로 알려져 있는데, 여기서 사람의 가상 골격이 계산되고 신체 일부가 특정 세그먼트에 매핑됩니다.여기서 분석은 이들 세그먼트의 위치 및 방향과 각 세그먼트 간의 관계(예를 들어 관절과 상대 위치 또는 방향 사이의 각도)를 사용하여 이루어집니다.

골격 모델을 사용하는 장점:

- 주요 파라미터만 분석되므로 알고리즘이 더 빠릅니다.

- 템플릿 데이터베이스에 대한 패턴 매칭 가능

- 핵심 포인트를 사용하면 감지 프로그램이 신체의 중요한 부분에 초점을 맞출 수 있습니다.

외관 기반 모델

이러한 모델은 템플릿 데이터베이스를 사용하여 이미지나 비디오에서 직접 매개변수를 도출하기 때문에 더 이상 신체 공간 표현을 사용하지 않습니다.일부는 인체 부위, 특히 손의 변형 가능한 2D 템플릿을 기반으로 합니다.변형 가능한 템플릿은 객체의 윤곽에 있는 점 집합으로 객체의 윤곽 근사치를 위한 보간 노드로 사용됩니다.가장 간단한 보간 함수 중 하나는 점 집합, 점 가변성 매개변수 및 외부 변형을 수행하는 선형 함수입니다.이러한 템플릿 기반 모델은 대부분 수동 추적에 사용되지만 간단한 제스처 분류에도 사용할 수 있습니다.

외관 기반 모델을 사용한 제스처 검출의 두 번째 접근법은 이미지 시퀀스를 제스처 템플릿으로 사용합니다.이 메서드의 파라미터는 이미지 자체 또는 이미지에서 파생된 특정 피쳐입니다.대부분의 경우 1개(모노스코픽) 또는 2개(스테레오스코픽) 보기만 사용됩니다.

근전도 기반 모델

근전도(EMG)는 신체의 근육에 의해 생성되는 전기 신호의 연구와 관련이 있습니다.팔 근육으로부터 수신한 데이터의 분류에 의해서, 동작을 분류해, 제스처를 외부 [1]소프트웨어에 입력할 수 있다.소비자 EMG 장치는 암 또는 다리 밴드와 같은 비침습적 접근을 허용하고 Bluetooth를 통해 연결합니다.따라서 EMG는 시각적인 방법보다 사용자가 카메라를 마주하지 않아도 입력이 가능하기 때문에 보다 자유로운 이동이 가능하다.

과제들

제스처 인식 소프트웨어의 정확성과 유용성과 관련된 많은 과제가 있습니다.이미지 기반 제스처 인식의 경우 사용하는 기기 및 이미지 노이즈에 제한이 있습니다.이미지 또는 비디오가 일관된 조명 아래 또는 같은 위치에 있지 않을 수 있습니다.배경 항목이나 사용자의 특징에 따라 인식이 더 어려워질 수 있습니다.

또, 이미지 베이스의 제스처 인식의 실장이 다양하기 때문에, 일반적인 사용의 테크놀로지의 실행 가능성에 문제가 생기는 일이 있습니다.예를 들어, 한 카메라에 대해 보정된 알고리즘은 다른 카메라에 대해 작동하지 않을 수 있습니다.배경 소음의 양은 특히 (부분 및 전체) 막힘이 발생할 때 추적 및 인식의 어려움을 야기한다.게다가 카메라와의 거리, 카메라의 해상도나 화질도 인식 정밀도에 변화를 일으킨다.

시각 센서로 인간의 제스처를 포착하기 위해서는 손 추적과 손 자세 인식 또는[31][32][33][34][35][36][37][38][39] 머리의 움직임, 얼굴 표정 또는 시선 방향을 포착하는 등 강력한 컴퓨터 비전 방법도 필요하다.

사회적 수용성

스마트폰이나 스마트워치와 같은 소비자 모바일 장치에 제스처 인터페이스를 채택하는 데 있어 중요한 과제 중 하나는 제스처 입력의 사회적 수용 가능성에서 비롯됩니다.제스처는 많은 새로운 폼 팩터 컴퓨터에서 빠르고 정확한 입력을 촉진할 수 있지만, 제스처의 채택과 유용성은 기술적 요소가 아닌 사회적 요인에 의해 제한되는 경우가 많습니다.이를 위해 제스처 입력 방법의 설계자는 기술적 고려사항과 다른 사회적 [40]맥락에서 제스처를 수행하려는 사용자의 의지의 균형을 추구할 수 있다.또한 다양한 디바이스 하드웨어 및 감지 메커니즘이 서로 다른 종류의 인식 가능한 제스처를 지원합니다.

모바일 디바이스

모바일 및 소형 폼 팩터 장치의 제스처 인터페이스는 관성 측정 장치(IMU)와 같은 모션 센서의 존재에 의해 종종 지원됩니다.이러한 디바이스에서 제스처 감지는 모션 센서에 의해 인식될 수 있는 움직임 기반의 제스처를 수행하는 사용자에게 의존합니다.이로 인해 자연스러운 움직임이나 노이즈와 구별하기 어려워지기 때문에 미묘한 제스처나 저동작 제스처로부터의 포착 신호가 어려워질 수 있습니다.제스처 사용성에 대한 조사와 연구를 통해 연구자들은 기존의 기술과 비슷해 보이는 미묘한 움직임, 모든 동작과 비슷해 보이는 모습 또는 느낌이 비슷한 제스처는 사용자에게 받아들여질 가능성이 더 높으며, 반면 이상하게 보이는 제스처는 실행하기에 불편하고 의사소통을 방해한다는 것을 발견했다.사용자가 자신의 [40]사용을 거부하기 쉽도록 유도하거나 흔치 않은 이동을 수반합니다.모바일 디바이스 제스처의 사회적 수용성은 제스처의 자연스러움과 사회적 맥락에 크게 좌우됩니다.

온바디 및 웨어러블 컴퓨터

웨어러블 컴퓨터는 일반적으로 사용자의 신체에서 사용 및 상호 작용 위치가 발생한다는 점에서 기존의 모바일 장치와 다릅니다.이러한 상황에서 제스처 인터페이스는 크기가 작기 때문에 터치스크린이나 키보드의 매력이 떨어지기 때문에 기존 입력 방식보다 선호될 수 있습니다.그럼에도 불구하고 이들은 제스처 상호작용에 관한 한 모바일 기기와 동일한 사회적 수용성 장애물을 많이 공유합니다.그러나 웨어러블 컴퓨터가 보이지 않게 숨겨지거나 의류와 같은 다른 일상 사물에 통합될 수 있는 가능성은 제스처 입력이 셔츠 깃을 조정하거나 앞 [41][42]바지 주머니를 문지르는 것과 같은 일반적인 의류 상호작용을 모방할 수 있게 한다.웨어러블 컴퓨터 상호작용의 주요 고려사항은 기기 배치 및 상호작용 위치입니다.미국과 한국 전역에서 실시된 웨어러블 기기 상호작용에 대한 제3자의 태도를 조사한 결과, 남성과 여성의 웨어러블 컴퓨팅 사용에 대한 인식 차이는 부분적으로 [42]사회적으로 민감한 것으로 간주되는 신체 부위의 차이 때문인 것으로 나타났다.신체 투사 인터페이스의 사회적 수용 가능성을 조사한 또 다른 연구에서는 유사한 결과가 나왔으며, 두 연구 모두 허리, 사타구니 및 상체(여성의 경우)의 라벨 부착 부위는 가장 수용성이 낮은 반면 팔뚝과 손목 주변 부위는 [43]가장 수용성이 높은 것으로 나타났다.

공공 시설

대화형 공개 디스플레이와 같은 공공 설치에서는 정보에 액세스하고 박물관, 갤러리, [44]극장 등의 공공 환경에서 대화형 미디어를 표시할 수 있습니다.터치 스크린은 공공 디스플레이에서 자주 사용되는 입력 형태이지만 제스처 인터페이스는 위생 개선, 원거리에서의 상호작용, 발견 가능성 향상 등의 추가적인 이점을 제공하며 성능적인 [41]상호작용을 선호할 수 있습니다.공공 디스플레이와의 제스처 상호작용에 대한 중요한 고려사항은 관객의 [44]높은 확률 또는 기대이다.

"고릴라 팔"

"고릴라 암"은 수직 방향 터치 스크린이나 라이트 펜의 부작용이었다.장시간 사용 시 사용자의 팔이 피로하거나 불편함을 느끼기 시작했다.이러한 효과는 1980년대 [45][46]초기 인기에도 불구하고 터치 스크린 입력의 감소에 기여하였다.

팔의 피로와 고릴라 팔의 부작용을 측정하기 위해, 연구원들은 소모된 [47][48]지구력이라고 불리는 기술을 개발했다.

「 」를 참조해 주세요.

레퍼런스

- ^ a b Kobylarz, Jhonatan; Bird, Jordan J.; Faria, Diego R.; Ribeiro, Eduardo Parente; Ekárt, Anikó (2020-03-07). "Thumbs up, thumbs down: non-verbal human-robot interaction through real-time EMG classification via inductive and supervised transductive transfer learning". Journal of Ambient Intelligence and Humanized Computing. Springer Science and Business Media LLC. 11 (12): 6021–6031. doi:10.1007/s12652-020-01852-z. ISSN 1868-5137.

- ^ Matthias Rehm, Nikolaus Bee, Elizabeth André, Wave Like a Egypte – 문화 고유의 상호작용을 위한 가속도계 기반 제스처 인식, 영국 컴퓨터 협회, 2007

- ^ "Patent Landscape Report Hand Gesture Recognition PatSeer Pro". PatSeer. Retrieved 2017-11-02.

- ^ 차이, 슈촨 등"Wayback Machine에서 kinect Archived 2021-01-10으로 수화 인식 및 번역" IEEE Conf.AFGR. Vol. 655. 2013에 수록되어 있다.

- ^ Sultana A, Rajapuspha T(2012), "SVM 분류기를 사용한 알파벳 손동작에 대한 시각 기반 제스처 인식", International Journal of Computer Science & Engineering Technology(IJCSET), 2012.

- ^ Pavlovic, V., Sharma, R. & Huang, T.(1997), "인간과 컴퓨터의 상호작용을 위한 손동작의 시각적 해석: 리뷰", IEEE Transactions on Pattern Analysis and Machine Intelligence, 1997년 7월.제19권(7), 677-695페이지.

- ^ R. Cipolla와 A.Pentland, Cambridge University Press, 1998, ISBN 978-0-521-62253-0

- ^ Ying Wu와 Thomas S.Huang, "비전 기반 제스처 인식: 리뷰" 2011-08-25 웨이백 머신에서 아카이브됨, In: 인간과 컴퓨터의 상호작용 제스처 기반 커뮤니케이션, 컴퓨터 사이언스 Springer 강의 노트 제1739권, 103-115, 1999 페이지, ISBN 9-78-3-540-66

- ^ Alejandro Jaimes와 Nicu Sebe, Multimodal 인간-컴퓨터 상호작용: Wayback Machine, Computer Vision and Image Understanding Volume 108호, 2007년 10월 - 11월호, 인간과 컴퓨터의 상호작용에 관한 비전에 관한 116-134페이지, doi:10.1016/jcviu.2006.019에서 2011-06에 아카이브된 설문 조사입니다.

- ^ Dopertchouk, Oleg; "손글씨 제스처 인식", gamedev.net, 2004년 1월 9일

- ^ Chen, Shijie; "수기 인식 응용 프로그램에서의 제스처 인식 기술", 수기 인식 분야 프런티어 p 142-147 2010년 11월

- ^ Balaji, R; Deepu, V; Madhvanath, Sriganesh; Prabhakaran, Jayasree " 제스처 키보드의 손글씨 제스처 인식" 2008-09-06년 Hewlett-Packard Laboratories 웨이백 머신 아카이브

- ^ Dietrich Kammer, Mandy Keck, Georg Freitag, Markus Waker, 멀티터치 프레임워크 분류 및 개요: 2011년 1월 25일 웨이백 머신에 아카이브된 아키텍처, 범위 및 기능

- ^ "touchless user interface Definition from PC Magazine Encyclopedia". pcmag.com. Retrieved 2017-07-28.

- ^ "The emerging need for touchless interaction technologies". ResearchGate. Retrieved 2021-06-30.

- ^ S. Benford; H. Schnadelbach; B. Koleva; B. Gaver; A. Schmidt; A. Boucher; A. Steed; R. Anastasi; C. Greenhalgh; T. Rodden; H. Gellersen (2003). "Sensible, sensable and desirable: a framework for designing physical interfaces" (PDF). CiteSeerX 10.1.1.190.2504. Archived from the original (PDF) on January 26, 2006.

{{cite journal}}:Cite 저널 요구 사항journal=(도움말) - ^ 토마스 G. 짐머맨, 재론 래니어, 척 블랜차드, 스티브 브라이슨, 영 하빌.https://portal.acm.org 를 참조해 주세요."A Hand Gesture Interface Device." http:https://portal.acm.org

- ^ Yang Liu, Yunde Jia, 웨어러블 비주얼 인터페이스와 그 응용 프로그램을 위한 강력한 손 추적 및 제스처 인식 방법, 제3회 이미지 및 그래픽에 관한 국제회의(ICIG'04) 진행, 2004

- ^ Kue-Bum Lee, Jung-Hyun, 홍광석, PDA 기반 멀티모달 게임 인터페이스 구현, 제5회 소프트웨어 엔지니어링 연구, 관리 및 응용 국제회의, 2007

- ^ "Gestigon Gesture Tracking - TechCrunch Disrupt". TechCrunch. Retrieved 11 October 2016.

- ^ Matney, Lucas. "uSens shows off new tracking sensors that aim to deliver richer experiences for mobile VR". TechCrunch. Retrieved 29 August 2016.

- ^ Khalili, Abdullah; Soliman, Abdel‐Hamid; Asaduzzaman, Md; Griffiths, Alison (March 2020). "Wi‐Fi sensing: applications and challenges". The Journal of Engineering. 2020 (3): 87–97. doi:10.1049/joe.2019.0790. ISSN 2051-3305.

- ^ Malmestig, Sofie Sundberg, SignWiver – 수화 테크놀로지 구현 2008-12-25 Wayback Machine에서 아카이브 완료

- ^ Thomas Schlomer, Benjamin Poppinga, Niels Henze, Susanne Boll, Wii 컨트롤러를 사용한 제스처 인식, 2008년 제2회 유형 및 임베디드 상호작용 국제회의 진행

- ^ AiLive Inc., LiveMove 화이트 페이퍼 2007-07-13 at the Wayback Machine, 2006년

- ^ 일렉트로닉 디자인 2011년9월 8일윌리엄 웡.Natural User Interface는 센서 통합을 채택하고 있습니다.

- ^ 케이블 & 새틀라이트 인터내셔널 2011년 9월/10월스티븐 커즌스.스릴 넘치는 광경.

- ^ Tech Journal South 2008년1월 7일Hillcrest Labs가 2500만 달러를 조달했습니다.

- ^ Percusa AudioCubes 블로그 2012년 10월 4일음성 합성에서의 제스처 컨트롤.2015-09-10 Wayback Machine에서 아카이브 완료

- ^ 블라디미르 I. 파블로비치, 라지예프 샤르마, 토마스 S.Huang, 인간과 컴퓨터의 상호작용을 위한 손동작의 시각적 해석; A Review, IEEE Transactions on Pattern Analysis and Machine Intelligence, 1997

- ^ Ivan Laptev와 Tony Lindeberg는 "입자 필터링과 다중 스케일 이미지 특징을 이용한 다중 상태 핸드 모델의 추적", 컴퓨터 비전의 진행 척도 공간과 형태학, 컴퓨터 사이언스의 스프링거 강의 노트 제2106권, 63-74쪽, 밴쿠버, 1999년.ISBN 978-3-540-42317-1, doi:10.1007/3-540-4778-0

- ^ von Hardenberg, Christian; Bérard, François (2001). "Bare-hand human-computer interaction". Proceedings of the 2001 workshop on Perceptive user interfaces. ACM International Conference Proceeding Series. Vol. 15 archive. Orlando, Florida. pp. 1–8. CiteSeerX 10.1.1.23.4541.

- ^ Lars Bretzner, Ivan Laptev, Tony Lindeberg, "다단계 색채 특징, 계층적 모델 및 입자 필터링을 사용한 손 제스처 인식", 제5회 IEEE 국제 자동 얼굴 및 제스처 인식 회의의 진행, 워싱턴 DC, 2002년 5월 21일~21일자, 4234쪽.ISBN 0-7695-1602-5, doi:10.1109/AFGR.2002.1004190

- ^ 도미티야 델 베키오, 리처드 M.Murray Pietro Perona, "인간의 움직임을 동적 기반 원리로 분해(그림 작업에 적용)" 2010-02-02 Wayback Machine, Automata Volume 39, 제12호, 2003년 12월호, 2085-2098 페이지, doi:10.1016/S0005-1098 (03)-250-4에 보관.

- ^ 토마스 B.Moeslund와 Lau Nörgaard, "Wearable Human Computer Interface에서 사용되는 손동작의 개요" 2011-07-19년 Wayback Machine 아카이브, 기술 보고서: CVMT 03-02, ISSN 1601-3646, 컴퓨터 비전 및 미디어 연구소, aal,

- ^ M. 콜슈와 M.Turk "Fast 2D Hand Tracking with Features and Multi-Cue Integration" 2008-08-21을 Wayback Machine, CVPRW '04에서 아카이브.프로시딩 컴퓨터 비전 및 패턴 인식 워크숍, 2004년 5월 27일~6월 2일, doi:10.1109/CVPR.2004.71

- ^ Xia Liu Fujimura, K., "깊이 데이터를 사용한 손동작 인식", 제6회 IEEE 얼굴 및 몸짓 자동 인식 국제회의 진행, 2004년 5월 17~19일 페이지 529-534, ISBN 0-7695-212-3, doi:10.1109/AF1587.

- ^ Stenger B, Thayananthan A, Torr PH, Cipolla R: "계층형 베이지안 필터를 사용한 모델 기반 핸드 트래킹", IEEE Transactions on Pattern Analysis and Machine Intelligence, 28(9):1372-84, 2006년 9월

- ^ A Erol, G Bebis, M Nicolescu, RD Boyle, X Twombly, "시력 기반 손 포즈 추정: A", 컴퓨터 비전과 이미지의 이해 제108호, 2007년 10월 - 11월호, 52-73페이지, 인간과 컴퓨터의 상호작용에 관한 비전에 관한 특별호, doi:10.1016/j.cviu.2006.10.012.

- ^ a b Rico, Julie; Brewster, Stephen (2010). "Usable Gestures for Mobile Interfaces: Evaluating Social Acceptability". Proceedings of the SIGCHI Conference on Human Factors in Computing Systems. CHI '10. New York, NY, USA: ACM: 887–896. doi:10.1145/1753326.1753458. ISBN 9781605589299. S2CID 16118067.

- ^ a b Walter, Robert; Bailly, Gilles; Müller, Jörg (2013). "StrikeAPose : Revealing mid-air gestures on public displays". StrikeAPose. Proceedings of the SIGCHI Conference on Human Factors in Computing Systems - CHI '13. New York, New York, USA: ACM Press. pp. 841–850. doi:10.1145/2470654.2470774. ISBN 9781450318990. S2CID 2041073.

- ^ a b Profita, Halley P.; Clawson, James; Gilliland, Scott; Zeagler, Clint; Starner, Thad; Budd, Jim; Do, Ellen Yi-Luen (2013). "Don'T Mind Me Touching My Wrist: A Case Study of Interacting with On-body Technology in Public". Proceedings of the 2013 International Symposium on Wearable Computers. ISWC '13. New York, NY, USA: ACM: 89–96. doi:10.1145/2493988.2494331. ISBN 9781450321273. S2CID 3236927.

- ^ Harrison, Chris; Faste, Haakon (2014). "Implications of Location and Touch for On-body Projected Interfaces". Proceedings of the 2014 Conference on Designing Interactive Systems. DIS '14. New York, NY, USA: ACM: 543–552. doi:10.1145/2598510.2598587. ISBN 9781450329026. S2CID 1121501.

- ^ a b Reeves, Stuart; Benford, Steve; O'Malley, Claire; Fraser, Mike (2005). "Designing the spectator experience" (PDF). Proceedings of the SIGCHI Conference on Human Factors in Computing Systems - CHI '05. New York, New York, USA: ACM Press: 741–750. doi:10.1145/1054972.1055074. ISBN 978-1581139983. S2CID 5739231.

- ^ Rupert Goodwins. "Windows 7? No arm in it". ZDNet.

- ^ "gorilla arm". catb.org.

- ^ 힌카피에-라모스, J.D., 궈, X., 모가디아, P. 및 이란.P. 2014."소비된 내구성: 대기 중 상호작용의 팔 피로를 정량화하기 위한 지표"입니다.제32회 컴퓨터 시스템의 인적 요인에 관한 연례 ACM 회의의 속행(CHI '14).ACM, 뉴욕, 뉴욕, 미국, 1063–1072.DOI=10.1145/2556288.2557130

- ^ Hincapié-Ramos, J.D., Guo, X. 및 Irani, P. 2014."소비된 내구성 작업대: 공중 상호작용 중 팔의 피로를 평가하는 도구"2014년 대화형 시스템 설계에 관한 동반 출판물(DIS Companion '14).ACM, 뉴욕, 뉴욕, 미국, 109-112DOI=10.1145/2598784.2602795

외부 링크

- 제스처 및 펜 컴퓨팅에 대한 참조에 대한 주석이 달린 참고 문헌 목록

- 펜 기반 컴퓨팅의 역사에 관한 메모(YouTube)

- 미래에는 모두 제스처 - 제스처 인터페이스와 비디오 게임

- Ford의 제스처리 인터랙티브 광고—디지털 사이니지와 상호 작용하기 위해 사용되는 제스처

- 3D 핸드 트래킹—프린터 조사