KR101177710B1 - Accident Detecting System based on the Sensor Network And Method thereof - Google Patents

Accident Detecting System based on the Sensor Network And Method thereof Download PDFInfo

- Publication number

- KR101177710B1 KR101177710B1 KR1020100133324A KR20100133324A KR101177710B1 KR 101177710 B1 KR101177710 B1 KR 101177710B1 KR 1020100133324 A KR1020100133324 A KR 1020100133324A KR 20100133324 A KR20100133324 A KR 20100133324A KR 101177710 B1 KR101177710 B1 KR 101177710B1

- Authority

- KR

- South Korea

- Prior art keywords

- accident

- image

- sensor

- information

- object information

- Prior art date

Links

Images

Classifications

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/01—Detecting movement of traffic to be counted or controlled

- G08G1/04—Detecting movement of traffic to be counted or controlled using optical or ultrasonic detectors

-

- G—PHYSICS

- G08—SIGNALLING

- G08C—TRANSMISSION SYSTEMS FOR MEASURED VALUES, CONTROL OR SIMILAR SIGNALS

- G08C17/00—Arrangements for transmitting signals characterised by the use of a wireless electrical link

- G08C17/02—Arrangements for transmitting signals characterised by the use of a wireless electrical link using a radio link

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/01—Detecting movement of traffic to be counted or controlled

- G08G1/0104—Measuring and analyzing of parameters relative to traffic conditions

- G08G1/0108—Measuring and analyzing of parameters relative to traffic conditions based on the source of data

- G08G1/0116—Measuring and analyzing of parameters relative to traffic conditions based on the source of data from roadside infrastructure, e.g. beacons

Landscapes

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Engineering & Computer Science (AREA)

- Computer Networks & Wireless Communication (AREA)

- Chemical & Material Sciences (AREA)

- Analytical Chemistry (AREA)

- Traffic Control Systems (AREA)

Abstract

본 발명은 사고 검출에 관한 것으로, 이러한 본 발명은 복수개의 센서 노드들이 배치된 위치에서 영상을 촬영하는 단계, 상기 각 센서 노드들이 촬영된 영상에서 특정 객체들의 객체 정보를 추출하는 단계, 상기 추출된 객체 정보를 마스터 노드에 전송하는 단계, 상기 마스터 노드가 상기 객체 정보들을 통합하여 통합 정보를 생성하는 단계, 상기 마스터 노드가 상기 통합 정보를 서버에 전송하는 단계, 상기 서버가 상기 전달된 통합 정보에 대하여 ROI 블록 매칭 및 운동 벡터 계산을 통하여 사고 발생 추론을 수행하는 단계, 상기 사고 발생 추론 결과 사고 발생으로 결정되는 경우 상기 복수개의 센서 노드들 및 적어도 하나의 마스터 노드에 사고 발생 시점을 기준으로 일정 시간 범위의 영상을 요청하여 상기 서버에 저장하는 단계를 포함하는 센서 네트웍 기반의 사고 검출 방법의 구성을 개시한다.The present invention relates to an accident detection, the present invention comprises the steps of capturing an image at a position where a plurality of sensor nodes are arranged, extracting object information of specific objects from the image of each sensor node, the extracted Transmitting object information to a master node, the master node integrating the object information to generate integration information, the master node transmitting the integration information to a server, and the server to the delivered integration information Performing accident occurrence inference through ROI block matching and motion vector calculation, and when the accident occurrence inference is determined as the occurrence of the accident, the sensor nodes and the at least one master node for a predetermined time based on the occurrence of the accident Requesting a video of a range and storing the sensor in the server It discloses a configuration of the Walk-based accident detection method.

Description

본 발명은 사고 검출에 관한 것으로, 특히 네트웍으로 연결된 복수개의 지능형 센서 노드를 사고 발생 예상 지점 등 다양한 위치에 설치하고 각 센서 노드들로부터 전달되는 정보를 바탕으로 사건 발생을 자율적으로 인지하고 판단할 수 있도록 지원하는 센서 네트웍 기반의 사고 검출 시스템 및 사고 검출 방법에 관한 것이다.The present invention relates to an accident detection, and in particular, a plurality of intelligent sensor nodes connected to a network may be installed at various locations such as an accident occurrence point and autonomously recognize and determine an occurrence of an event based on information transmitted from each sensor node. The present invention relates to an accident detection system and an incident detection method based on a sensor network.

산업이 발전함에 따라서 교통수단인 차량대수가 증가하면서, 교통량이 급격하게 증가되고 도로의 고속화가 진행되면서 이에 따른 부작용으로 교통사고 또한 증가하고 있다. 이와 같이 도로상에서 발생하는 사고는 단순히 가해 운전자와 피해 운전자간의 문제로 국한되는 것이 아니라, 후속 여파로 인하여 진행 중인 차량들에게도 많은 영향을 미치고 있다. 이러한 후유 증상은 도로상을 주행하는 차량의 숫자가 많을수록, 또 차량 흐름의 속도가 빠를수록 그 여파도 클 수밖에 없다. 3차선 도로상의 임의의 한 개 차선에서 발생한 사고의 지속시간이 10분이 초과되면 최대 10Km 후방까지 여파가 미치게 되기도 한다. 따라서 도로상에서 발생하는 사고 혹은 돌발 상황의 조기 검지는 사고 및 돌발 상황의 신속한 처리를 가능케 하기 때문에 교통 소통에 매우 큰 영향을 미치는 요소라고 할 수 있다. 이러한 도로상에서 발생하는 사고 혹은 돌발 상황에 대하여 사고 검출 시스템을 도입함으로써 교통소통 및 정체 시간을 크게 줄일 수 있을 뿐 아니라, 경우에 따라서는 우회도로를 통해 사고지역으로 집중하는 차량의 분산을 유도할 수도 있는 장점이 있다.As the industry develops, the number of vehicles, which are the means of transportation, increases, the traffic volume increases rapidly, and the speed of the roads progresses. Accidents occurring on the road are not limited to the problem between the driver and the victim, but also have a lot of influence on the vehicles in progress due to the aftermath. Such aftereffects are inevitably larger as the number of vehicles driving on the road and the speed of vehicle flow are faster. If the duration of an accident in any one lane on a three-lane road exceeds 10 minutes, the aftermath may extend up to 10 km back. Therefore, early detection of accidents or accidents on the road can be said to have a great influence on traffic communication because it enables the rapid handling of accidents and accidents. By introducing an accident detection system for accidents or accidents that occur on these roads, you can significantly reduce traffic and congestion times, and in some cases, induce decentralization of vehicles that concentrate on the accident area through bypass roads. There is an advantage.

그러나 종래 사고 검출 시스템은 감시자가 모니터를 통해 사고의 유무를 판단할 수 있도록 지원하는 형태의 시스템이었다. 따라서 종래 사고 검출 시스템은 모니터를 통해 사고 유무를 판단하는 감시자의 개인차에 의해 사고 검출률이 다르게 나타나는 문제점이 있었다. 또한 종래 사고 검출 시스템은 시간적 및 공간적 제약으로 인해 많은 인력 및 장비의 투자에도 불구하고 사고 발생에 대한 확정 및 조치를 적절하게 취하지 못하는 문제점이 있었다. 한 연구결과에 의하면 통합 관제 센터의 운영 요원이 2대 이상의 모니터를 동시에 감시하게 되면 12분 경과 시 위반상황의 45%를 인식하지 못하며, 22분 경과 시 95%를 놓치게 된다는 결과를 개시한 바 있다. 따라서 막대한 비용을 들여 보안 시스템을 구축하고 유능한 보안요원을 채용해 기업이나 사회 안전을 보호하고자 하더라도 막대한 손실 발생이나 보안의 허점을 막을 수 없다. 따라서 이러한 물리적 지리적 제약사항을 극복하고 보다 효과적이며 자동적으로 사고 발생에 대한 인식 및 상황 대처를 수행할 수 있도록 하여 사고 발생 이후 2차 또는 3차에 걸쳐 발생할 수 있는 추가 피해를 예방할 수 있는 시스템 개발이 절실한 실정이다.However, the conventional accident detection system was a system that supports the monitor to determine the presence of an accident through a monitor. Therefore, the conventional accident detection system has a problem that the accident detection rate is different by the individual difference of the monitor to determine the presence of the accident through the monitor. In addition, the conventional accident detection system has a problem in that it is not possible to properly determine and take measures for the occurrence of the accident despite the investment of a large number of people and equipment due to time and space constraints. According to one study, if two or more monitors were monitored simultaneously by an integrated control center, they would not recognize 45% of violations after 12 minutes and miss 95% after 22 minutes. . Therefore, even if a large amount of money is required to build a security system and employ competent security personnel to protect corporate or social safety, it cannot prevent huge losses or security loopholes. Therefore, it is possible to develop a system that can overcome these physical and geographic constraints and enable more effective and automatic recognition and situational response to the occurrence of accidents, thereby preventing further damages that may occur in the second or third phase after the accident. It is a desperate situation.

따라서 본 발명의 목적은 광범위한 지역에 다중 복합 센서 기반의 자율성장, 사건 인지 기능을 가진 복수개의 지능형 센서 노드를 일정 위치에 설치하고 각 센서 노드들을 네트웍으로 연결하여, 사건(화재, 교통사고, 범죄) 주위에 설치된 센서 노드들이 사건발생을 자율적으로 인지하고 판단하도록 함으로써, 감시 인력이 필요로 하는 정보를 최소화하여 24시간 소수의 인력으로도 실시간 사건 발생을 감지하고 대응할 수 있도록 지원하는 센서 네트웍 기반의 사고 검출 시스템 및 사고 검출 방법을 제공함에 있다.Therefore, an object of the present invention is to install a plurality of intelligent sensor nodes having multiple autonomous growth and event recognition functions based on multiple composite sensors in a wide range of locations, and to connect each of the sensor nodes to a network, and to generate an event (fire, traffic accident, crime). Sensor nodes installed around them are able to autonomously recognize and judge the occurrence of the event, thus minimizing the information required by the monitoring personnel to detect and respond to the real-time occurrence of the event with a small number of personnel for 24 hours. An accident detection system and an accident detection method are provided.

상술한 바와 같은 목적을 달성하기 위한 본 발명의 바람직한 실시 예에 따른 센서 네트웍 기반의 사고 검출 시스템은 배치된 위치에서 일정 범위의 영상을 수집하고, 수집된 영상 내에 포함된 특정 객체들의 객체 정보를 추출하는 복수 개의 센서 노드, 상기 복수 개의 센서 노드로부터 객체 정보를 전달받아 각 객체 정보들을 통합하여 통합 정보를 생성하는 적어도 하나의 마스터 노드, 상기 적어도 하나의 마스터 노드로부터 통합 정보를 수신하고 상기 통합 정보를 기반으로 사고 발생 여부를 추론하는 서버를 포함하는 구성을 개시한다.Sensor network-based accident detection system according to an embodiment of the present invention for achieving the above object collects a certain range of images from the arrangement position, and extracts object information of specific objects included in the collected image A plurality of sensor nodes, at least one master node receiving object information from the plurality of sensor nodes and integrating respective object information to generate integration information, and receiving integration information from the at least one master node and receiving the integration information. Disclosed is a configuration including a server to infer whether an accident occurred based on.

상기 센서 노드는 상기 영상 수집을 위한 적어도 하나의 영상 카메라, 상기 영상 카메라가 수집한 영상으로부터 해당 영상 내에 포함된 객체 정보를 추출하는 센서 제어부, 상기 추출된 객체 정보를 상기 적어도 하나의 마스터 노드에 전송하는 센서부 통신 인터페이스, 상기 수집된 영상 및 객체 정보를 저장하는 센서 저장부를 포함할 수 있다.The sensor node may include at least one image camera for collecting the image, a sensor controller which extracts object information included in the image from the image collected by the image camera, and transmits the extracted object information to the at least one master node. The sensor unit may include a communication interface and a sensor storage unit configured to store the collected image and object information.

특히 상기 센서 제어부는 이미지 모자이크 방식 및 돌출 맵 처리 방식을 기반으로 영상 내의 불연속 객체 정보를 연속된 동적 객체 정보로 추출하는 객체 검출부, 상기 영상의 보정을 수행하는 전처리부를 포함할 수 있다.In particular, the sensor controller may include an object detector that extracts discontinuous object information in the image as continuous dynamic object information based on an image mosaic method and a protrusion map processing method, and a preprocessor that corrects the image.

또한 상기 마스터 노드는 상기 복수개의 센서 노드로부터 상기 객체 정보 수신을 위한 마스터 통신 인터페이스, 상기 복수개의 센서 노드가 전송한 객체 정보들을 통합하여 통합 정보를 생성하는 마스터 제어부를 포함하며, 상기 마스터 제어부는 상기 객체 정보 통합을 위한 정보 통합부, 상기 통합 정보의 영상 보정을 수행하는 영상 보정부를 포함할 수 있다.The master node may include a master communication interface for receiving the object information from the plurality of sensor nodes, and a master controller for integrating object information transmitted from the plurality of sensor nodes to generate integrated information. An information integrator for integrating object information may include an image corrector for correcting an image of the integrated information.

그리고 본 발명의 상기 서버는 상기 마스터 노드로부터 통합 정보를 수신하기 위한 서버 통신 인터페이스, 상기 통합 정보를 기반으로 사고 추론을 수행하기 위한 서버 제어부, 상기 사고 추론 결과를 저장함과 아울러 사고 발생 결정 시 사고 발생과 관련된 일정 시간 범위의 영상을 상기 복수개의 센서 노드들 및 적어도 하나의 마스터 노드로부터 수신하여 저장하는 서버 저장부, 상기 사고 추론 결과를 출력하는 표시부 또는 오디오 처리부를 포함할 수 있다.The server of the present invention stores a server communication interface for receiving integration information from the master node, a server control unit for performing accident inference based on the integration information, and stores the accident inference result and generates an accident when determining an accident occurrence. And a server storage unit configured to receive and store an image of a predetermined time range associated with the plurality of sensor nodes and at least one master node, and a display unit or an audio processor to output the accident inference result.

여기서 상기 서버 제어부는 상기 통합 정보에 포함된 객체들에 대하여 ROI 블록 매칭을 수행하여 충돌 체크를 수행하는 ROI 기반의 규칙 판별부, 상기 객체들의 운동 벡터를 연산하는 운동 벡터 계산부, 상기 객체들의 ROI 블록들의 충돌 체크 및 운동 벡터들 계산 결과를 기반으로 사고 발생 여부를 추론하는 사고 추론부를 포함할 수 있으며, 특히 상기 사고 추론부는 상기 추론 결과 사고 발생으로 판단되는 경우 상기 복수개의 센서 노드들 및 적어도 하나의 마스터 노드에 상기 사고 발생과 관련된 일정 시간 범위의 영상을 전송하도록 요청하는 것을 특징으로 한다.Herein, the server controller is a ROI-based rule discriminator for performing collision check by performing ROI block matching on the objects included in the integrated information, a motion vector calculator for calculating motion vectors of the objects, and ROI of the objects. And an accident inference unit that infers whether or not an accident occurs based on a collision check of the blocks and a calculation result of motion vectors. In particular, the accident inference unit may include the plurality of sensor nodes and at least one when it is determined that the accident has occurred. It is characterized by requesting the master node of the transmission of the image of the predetermined time range associated with the occurrence of the accident.

또한 본 발명은 복수개의 센서 노드들이 배치된 위치에서 영상을 촬영하는 단계, 상기 각 센서 노드들이 촬영된 영상에서 특정 객체들의 객체 정보를 추출하는 단계, 상기 추출된 객체 정보를 마스터 노드에 전송하는 단계, 상기 마스터 노드가 상기 객체 정보들을 통합하여 통합 정보를 생성하는 단계, 상기 마스터 노드가 상기 통합 정보를 서버에 전송하는 단계, 상기 서버가 상기 전달된 통합 정보에 대하여 ROI 블록 매칭 및 운동 벡터 계산을 통하여 사고 발생 추론을 수행하는 단계, 상기 사고 발생 추론 결과 사고 발생으로 결정되는 경우 상기 복수개의 센서 노드들 및 적어도 하나의 마스터 노드에 사고 발생 시점을 기준으로 일정 시간 범위의 영상을 요청하여 상기 서버에 저장하는 단계를 포함하는 센서 네트웍 기반의 사고 검출 방법의 구성을 개시한다.In another aspect, the present invention comprises the steps of photographing an image at a position where a plurality of sensor nodes are arranged, extracting object information of specific objects from the image of each sensor node, transmitting the extracted object information to the master node The master node integrating the object information to generate integration information, the master node transmitting the integration information to a server, and the server performing ROI block matching and motion vector calculation on the transferred integration information. In the case of inferring the occurrence of the accident through the incident, if it is determined that the accident occurred as a result of the inference of the occurrence of the incident, the plurality of sensor nodes and at least one master node requests the image of a predetermined time range based on the occurrence time of the accident to the server The configuration of the sensor network-based incident detection method comprising the step of storing The deadline.

본 발명의 실시 예에 따른 센서 네트웍 기반의 사고 검출 시스템 및 사고 검출 방법에 따르면, 본 발명은 사고 발생 확인 및 결정에 이용되는 신뢰성 높은 정보를 최적화함으로써, 사고를 모니터링하는 사용자의 피로도는 낮추면서 집중도는 높일 수 있도록 지원한다. According to an accident detection system and an accident detection method based on a sensor network according to an embodiment of the present invention, the present invention optimizes reliable information used for checking and determining an occurrence of an accident, thereby reducing concentration of the user while monitoring an accident and reducing concentration. Support to increase.

또한 본 발명은 보다 영상 분석을 계층별로 분할하여 수행하여 보다 효율적인 사고 검출을 수행함으로써 시스템 관리를 최적화하여 시스템 관리에 소요되는 비용을 절감할 수 있도록 지원한다.In addition, the present invention supports to reduce the cost of system management by optimizing system management by performing more efficient accident detection by dividing image analysis by layers.

이러한 본 발명은 무인자동차, 국방, 보안, 사회 안전 등 다양한 분야에서 상황인지 임베이디드 SW 및 HW 모듈이 사용되어지며, 특히 수동적인 면에 그치지 않고 능동적서비스를 제공할 수 있는 제품 개발을 가능하도록 지원하고, 국방 무인경계시스템, 홈 네트워크 시큐리티, 사회 안전 방재시스템, 무인자동차, 무인비행기, 무인선박, U-City 산업 등에도 활용 가능하다. 또한 본 발명은 각종 재난, 재해, 화재 등 위험요소 지역에 대한 사전예방과 상황발생 시 신속한 대응이 가능한 종합방재 시스템 구축이 가능하도록 지원하며 교통사고 방지를 위해 교차로 및 주요 도로에 지능형 무인 감시 시스템을 설치하고 사고 발생 시 주변 차량과 무선 통신을 통해 2차적인 사고를 예방하는 시스템 구축이 가능하도록 지원한다. 그리고 본 발명은 사회 기반 시설에 대한 지능형 무인 감시 시스템과 개별 건물에 대한 감시 시스템 연동도 가능하도록 지원할 수 있다.The present invention is used in a variety of fields, such as driverless vehicles, defense, security, social safety, embedded SW and HW modules for situational awareness, and in particular to enable the development of products that can provide active services, not just passive. It can be used for defense unmanned border system, home network security, social safety disaster prevention system, unmanned vehicle, unmanned aircraft, unmanned vessel, and U-City industry. In addition, the present invention supports the construction of a comprehensive disaster prevention system that can prevent the accidents, disasters, fires, etc. area in advance, and prompt response in the event of a situation, and intelligent unmanned monitoring system at intersections and major roads to prevent traffic accidents. It installs and supports the construction of a system that prevents secondary accidents through wireless communication with nearby vehicles in the event of an accident. In addition, the present invention can support the intelligent unmanned surveillance system for the infrastructure and the interlocking surveillance system for individual buildings.

도 1은 본 발명의 실시 예에 따른 센서 네트웍 기반의 사고 검출 시스템의 구성을 개략적으로 나타낸 도면.

도 2는 본 발명의 실시 예에 따른 센서 노드의 구성을 보다 상세히 나타낸 블록도.

도 3은 본 발명의 실시 예에 따른 이미지 모자이크에 적용되는 영상을 나타낸 도면.

도 4는 도 3에 도시된 영상들에 대하여 이미지 모자이크를 수행한 영상을 나타낸 도면.

도 5는 본 발명의 실시 예에 따른 돌출 맵 적용에 따른 이미지 변환을 설명하기 위한 도면.

도 6은 본 발명의 실시 예에 따른 마스터 노드의 구성을 보다 상세히 나타낸 블록도.

도 7은 본 발명의 실시 예에 따른 서버 제어부 구성을 보다 상세히 나타낸 블록도.

도 8 및 도 9는 본 발명의 ROI 블록 겹침에 따른 충돌 체크를 설명하기 위한 도면.

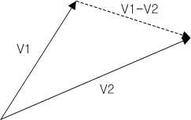

도 10 및 도 11은 본 발명의 운동 벡터 연산에 따른 결과를 기반으로 충돌 체크를 설명하기 위한 도면.

도 12 및 도 13은 운동 벡터 및 사고 발생에 따른 벡터 값 변화량을 나타낸 그래프 기반의 사고 추론 과정을 설명하기 위한 도면.

도 14는 본 발명의 실시 예에 따른 센서 네트웍 기반의 사고 검출 방법을 설명하기 위한 신호 흐름도.1 is a view schematically showing the configuration of a sensor network-based accident detection system according to an embodiment of the present invention.

2 is a block diagram showing in more detail the configuration of the sensor node according to an embodiment of the present invention.

3 is a view showing an image applied to the image mosaic according to an embodiment of the present invention.

FIG. 4 is a view illustrating an image mosaic performed on the images illustrated in FIG. 3. FIG.

5 is a view for explaining image conversion according to the application of the protrusion map according to an embodiment of the present invention.

6 is a block diagram showing in more detail the configuration of a master node according to an embodiment of the present invention.

7 is a block diagram showing in more detail the configuration of the server control unit according to an embodiment of the present invention.

8 and 9 are diagrams for explaining a collision check according to overlapping ROI blocks of the present invention.

10 and 11 are views for explaining a collision check based on the result of the motion vector calculation of the present invention.

12 and 13 are diagrams for explaining a graph-based thinking reasoning process showing the variation of the vector value according to the occurrence of the motion vector and the accident.

14 is a signal flow diagram for explaining a sensor network-based accident detection method according to an embodiment of the present invention.

이하, 본 발명에 따른 바람직한 실시 예를 첨부한 도면을 참조하여 상세히 설명한다. 하기의 설명에서는 본 발명의 실시 예에 따른 동작을 이해하는데 필요한 부분만이 설명되며, 그 이외 부분의 설명은 본 발명의 요지를 흩트리지 않도록 생략될 것이라는 것을 유의하여야 한다.Hereinafter, preferred embodiments of the present invention will be described in detail with reference to the accompanying drawings. In the following description, only parts necessary for understanding the operation according to the embodiment of the present invention will be described, and the description of other parts will be omitted so as not to disturb the gist of the present invention.

이하에서 설명되는 본 명세서 및 청구범위에 사용된 용어나 단어는 통상적이거나 사전적인 의미로 한정해서 해석되어서는 아니 되며, 발명자는 그 자신의 발명을 가장 최선의 방법으로 설명하기 위해 용어의 개념으로 적절하게 정의할 수 있다는 원칙에 입각하여 본 발명의 기술적 사상에 부합하는 의미와 개념으로 해석되어야만 한다. 따라서 본 명세서에 기재된 실시 예와 도면에 도시된 구성은 본 발명의 가장 바람직한 실시 예에 불과할 뿐이고, 본 발명의 기술적 사상을 모두 대변하는 것은 아니므로, 본 출원시점에 있어서 이들을 대체할 수 있는 다양한 균등물과 변형 예들이 있을 수 있음을 이해하여야 한다.The terms and words used in the present specification and claims should not be construed as limited to ordinary or dictionary meanings and the inventor is not limited to the meaning of the terms in order to describe his invention in the best way. It should be interpreted as meaning and concept consistent with the technical idea of the present invention. Therefore, the embodiments described in the present specification and the configuration shown in the drawings are only the most preferred embodiments of the present invention, and do not represent all of the technical idea of the present invention, and various equivalents may be substituted for them at the time of the present application. It should be understood that there may be water and variations.

이하, 본 발명에 따른 바람직한 실시 예를 첨부한 도면을 참조하여 상세히 설명한다. 하기의 설명에서는 본 발명의 실시 예에 따른 동작을 이해하는데 필요한 부분만이 설명되며, 그 이외 부분의 설명은 본 발명의 요지를 흩트리지 않도록 생략될 것이라는 것을 유의하여야 한다.Hereinafter, preferred embodiments of the present invention will be described in detail with reference to the accompanying drawings. In the following description, only parts necessary for understanding the operation according to the embodiment of the present invention will be described, and the description of other parts will be omitted so as not to disturb the gist of the present invention.

이하에서 설명되는 본 명세서 및 청구범위에 사용된 용어나 단어는 통상적이거나 사전적인 의미로 한정해서 해석되어서는 아니 되며, 발명자는 그 자신의 발명을 가장 최선의 방법으로 설명하기 위해 용어의 개념으로 적절하게 정의할 수 있다는 원칙에 입각하여 본 발명의 기술적 사상에 부합하는 의미와 개념으로 해석되어야만 한다. 따라서 본 명세서에 기재된 실시 예와 도면에 도시된 구성은 본 발명의 가장 바람직한 일실시 예에 불과할 뿐이고, 본 발명의 기술적 사상을 모두 대변하는 것은 아니므로, 본 출원시점에 있어서 이들을 대체할 수 있는 다양한 균등물과 변형 예들이 있을 수 있음을 이해하여야 한다.The terms and words used in the present specification and claims should not be construed as limited to ordinary or dictionary meanings and the inventor is not limited to the meaning of the terms in order to describe his invention in the best way. It should be interpreted as meaning and concept consistent with the technical idea of the present invention. Therefore, the embodiments described in the present specification and the configurations shown in the drawings are merely the most preferred embodiments of the present invention, and not all of the technical ideas of the present invention are described. Therefore, It is to be understood that equivalents and modifications are possible.

이하 본 발명의 센서 네트웍 기반의 사고 검출 시스템의 구성과 각 구성의 역할에 대하여 도면을 참조하여 보다 상세히 설명하기로 한다.Hereinafter, the configuration of the sensor network-based accident detection system of the present invention and the role of each configuration will be described in detail with reference to the accompanying drawings.

도 1은 본 발명의 실시 예에 따른 센서 네트웍 기반의 사고 검출 시스템의 구성을 개략적으로 나타낸 도면이다.1 is a diagram schematically illustrating a configuration of a sensor network-based accident detection system according to an exemplary embodiment of the present invention.

상기 도 1을 참조하면, 본 발명의 센서 네트웍 기반의 사고 검출 시스템(10)은 센서 노드들(100), 마스터 노드들(200) 및 서버(300)의 구성을 포함할 수 있다.Referring to FIG. 1, the sensor network-based

이와 같은 구성을 가지는 본 발명의 사고 검출 시스템(10)은 센서 노드들(100)이 다양한 위치에 각각 설치된 후 해당 센서 노드들(100)이 마련하고 있는 영상 카메라를 이용하여 설정된 범위의 영상을 수집할 수 있다. 이 과정에서 상기 센서 노드들(100)은 수집된 영상에 대하여 각각 객체 정보 예를 들면 객체의 좌표 정보 및 움직이는 객체인 경우 객체의 움직임 좌표 정보를 추출하고, 추출된 객체 정보를 상위 마스터 노드들(200)에게 전송하도록 배치된다. 그러면 마스터 노드들(200)은 센서 노드들(100)이 전송한 객체 정보를 통합하여 통합 정보를 생성하고, 생성된 통합 정보를 서버(300)에 전송할 수 있다. 결과적으로 서버(300)는 통합된 객체 정보들을 기반으로 일정 규칙에 따라 사고 발생 여부만을 추론하고, 추론 결과를 표시부 등에 출력하여 사고 발생 여부에 대한 정보를 서버 운영자에게 전달할 수 있다. 이러한 구조를 가지는 본 발명의 사고 검출 시스템(10)은 각 센서 노드들(100)이 객체 정보 추출을 수행하며, 마스터 노드들(200)이 정보 통합을 수행하기 때문에 서버(300) 측에서 다루게 되는 데이터를 최소화함과 아울러 효과적인 정보 처리를 수행할 수 있도록 한다. 이에 따라 사고 검출 시스템(10) 관리자는 신뢰성이 높은 정보를 기반으로 사고 발생에 대한 빠른 결과 획득을 달성할 수 있다. 이하 상기 각 구성에 대하여 보다 상세히 설명하기로 한다.The

상기 센서 노드들(100)은 다양한 사고 발생 예상 지점이나 기타 설계자가 요구하는 다양한 지점에 복수개가 배치될 수 있다. 예를 들면 상기 센서 노드들(100)은 교차로 인근 지역에 다수개가 배치될 수 있다. 이러한 센서 노드들(100)은 포함된 영상 카메라를 이용하여 일정 범위의 영상을 촬영하고, 촬영된 영상 내에 포함된 객체들의 객체 정보를 추출할 수 있다. 그리고 센서 노드들(100)은 추출한 객체 정보를 상위 센서 노드 즉 마스터 노드들(200)에 전송할 수 있다. 본 발명에서는 2개의 센서 노드 그룹(110, 120)을 예시적으로 나타내었다. 제1 센서 노드 그룹(110)은 제11 센서 노드(SN11) 및 제12 센서 노드(SN12)를 포함하며, 제2 센서 노드 그룹(120)은 제21 센서 노드(SN21) 및 제22 센서 노드(SN22)를 포함하도록 예시하였다. 그러나 본 발명의 센서 네트웍 기반의 사고 검출 시스템(10)이 도시된 센서 노드들의 개수에 한정되는 것은 아니며 보다 많은 개수의 센서 노드들이 일정 그룹별로 구분되어 배치될 수 있을 것이다. 바람직하게는 하나의 센서 그룹에 포함되는 센서 노드들은 인접된 영역에 각각 배치되어 촬영하는 영상이 유사한 범위를 가지는 것이 바람직하다. 각 센서 노드의 세부 구성 및 구성들의 역할에 대해서는 후술하는 도면을 참조하여 보다 상세히 설명하기로 한다.The

상기 마스터 노드들(200)은 각 센서 노드 그룹들(110, 120)과 연결되는 제1 마스터 노드(210) 및 제2 마스터 노드(220)를 포함할 수 있다. 여기서 상기 마스터 노드들(200) 또한 도시된 바와 같은 개수에 한정되는 것은 아니며, 센서 노드 그룹의 개수 증가에 따라 추가되거나 센서 노드 그룹의 개수 감소에 따라 제거될 수 있을 것이다. 도면을 참조하면 제1 마스터 노드(210)는 제1 센서 노드 그룹(110)과 연결되며, 제2 마스터 노드(220)는 제2 센서 노드 그룹(120)과 연결될 수 있다. 이에 따라 제1 마스터 노드(210)는 제1 센서 노드 그룹(110)에 포함된 제11 센서 노드(SN11) 및 제12 센서 노드(SN12)가 촬영한 영상 정보에 대하여 분석한 객체 정보들을 수신할 수 있다. 또한 제2 마스터 노드(220)는 제2 센서 노드 그룹(120)에 포함된 제21 센서 노드(SN21) 및 제22 센서 노드(SN22)가 촬영한 영상 정보에 대하여 분석한 객체 정보들을 수신할 수 있다. 그러면 제1 마스터 노드(210) 및 제2 마스터 노드(220)는 각각의 센서 노드들이 전달한 객체 정보를 통합하여 통합 객체 정보를 산출한다. 이 과정에서 상기 마스터 노드들(200)은 산출된 통합 객체 정보에 대하여 영상 보정을 수행하도록 지원할 수 있다. 그리고 마스터 노드들(200)은 산출한 통합 객체 정보를 연결된 서버(300)에 전달할 수 있다. 한편 상기 센서 네트웍 기반의 사고 검출 시스템(10)의 구성에서 마스터 노드들(200)을 센서 노드들(100)과 구분하여 설명하고 있으나 본 발명이 이에 한정되는 것은 아니다. 즉 상기 센서 노드들(100)과 동일한 역할을 수행하는 센서 노드이되, 각 센서 노드들(100)이 수집 분석한 객체 정보들을 통합한 후 서버(300)에 전송하는 기능을 지원하는 모듈을 포함하는 센서 노드가 별도의 마스터 노드 역할을 수행할 수 도 있다. 상기 마스터 노드의 세부 구성에 대해서는 후술하는 도면을 참조하여 보다 상세히 설명하기로 한다.The

상기 서버(300)는 일정 규칙을 기준으로 마스터 노드들(200)이 전송한 통합 객체 정보에 대하여 사고 발생 여부를 추론할 수 있다. 이 과정에서 상기 서버(300)는 사고 발생 확률이 설정 값 이상으로 산출되는 경우 해당 결과를 표시부 또는 오디오 처리부 등을 통하여 출력하고 센서 노드들(100) 및 마스터 노드들(200)에게 해당 객체 정보와 관련된 영상 및 해당 영상을 기준으로 전후 일정 시간 이내의 영상을 전송할 것을 요청할 수 있다. 이후 상기 서버(300)는 해당 수신된 영상과 마스터 노드들(200)이 전송한 통합 객체 정보를 바탕으로 사고 발생 여부를 재결정하거나, 전송된 영상을 사고 자료로서 저장 및 관리하도록 지원할 수 있다. 상기 서버(300)의 세부 구성에 대해서는 후술하는 도면을 참조하여 보다 상세히 설명하기로 한다.The

이상에서 설명한 바와 같이 본 발명의 실시 예에 따른 센서 네트웍 기반의 사고 검출 시스템(10)은 다수개의 센서 노드들(100)이 개별적인 객체 정보를 추출하고, 추출된 정보를 상위 계층으로 전달함으로써 사고 발생 검지를 위한 데이터 처리를 분업화하여 빠르고 정확하게 처리할 수 있도록 지원하며, 서버(300) 측면에서는 사고 발생 검지에 필요한 데이터만을 필요시마다 확인하도록 함으로써 데이터 처리 효율 및 관리를 높일 수 있다. 서버(300) 관리자 측면에서는 사고 발생 확률이 높은 영상만을 수집 및 판별함으로써 사고 발생 여부 확인을 보다 빠르고 정확하게 결정할 수 있게 된다.As described above, in the sensor network-based

도 2는 본 발명의 실시 예에 따른 센서 노드들(100) 중 하나의 센서 노드 구성을 보다 상세히 나타낸 블록도이다. 이하 설명의 편의를 위하여 센서 노드들에 부여한 참조 번호 100을 "센서 노드" 명칭에도 동일하게 부여하여 설명하기로 한다. 또한 이하 설명의 편의를 위하여 마스터 노드들에 부여한 참조 번호 200을 "마스터 노드" 명칭에도 동일하게 부여하여 설명하기로 한다.2 is a block diagram illustrating in detail a configuration of one sensor node among the

상기 도 2를 참조하면, 본 발명의 센서 노드(100)는 센서부 통신 인터페이스(101), 센서 전원부(103), 영상 카메라(105), 센서 저장부(107) 및 센서 제어부(160)를 포함할 수 있다.2, the

이와 같은 구성을 가지는 본 발명의 센서 노드(100)는 영상 카메라(105)를 이용하여 설치된 방향에 대한 영상을 촬영하고, 촬영된 영상에 포함된 객체 정보 추출을 수행한 후, 해당 객체 정보 추출을 자신과 연결된 마스터 노드에 전송하도록 지원할 수 있다. 추가적으로 상기 센서 노드(100)는 서버(300)로부터 특정 객체 정보에 관련된 영상 요청을 수신하면 해당 객체 정보와 관련된 일정 시간 범위의 영상을 상기 서버(300)에 전송하도록 지원할 수 있다. The

이를 위하여 상기 센서부 통신 인터페이스(101)는 마스터 노드(200)와 통신 채널을 형성하고 상기 영상 카메라(105)가 수집한 영상으로부터 추출된 객체 정보를 마스터 노드(200)에 전송하도록 지원한다. 이러한 상기 센서부 통신 인터페이스(101)는 마스터 노드(200)와 유선 또는 무선의 형태 중 적어도 하나로 연결될 수 있다. 즉 센서부 통신 인터페이스(101)는 센서 노드(100)의 영상 및 객체 정보를 상기 마스터 노드(200)와 연결된 유선 케이블 통하여 전송할 수 있다. 또한 상기 센서부 통신 인터페이스(101)는 무선 통신 모듈로 구성되어 상기 영상 및 객체 정보를 무선으로 상기 마스터 노드(200)에 전송할 수 있다.To this end, the sensor

상기 센서 전원부(103)는 상기 센서 노드(100)의 각 구성들의 운용에 필요한 전원을 공급하는 구성이다. 이러한 센서 전원부(103)는 영구전원으로부터 전원을 공급받기 위한 형태로 구성되거나, 배터리 형태로 제작되어 일정 주기 단위로 교체될 수 있다. 또한 상기 센서 전원부(103)는 충전형 배터리 형태로 제작되어 평상시에는 영구전원으로부터 공급받은 전원을 상기 센서 노드(100)의 각 구성에 전달하고, 영구전원의 단전 시 충전된 전원을 공급하도록 지원할 수 있다.The

상기 영상 카메라(105)는 배치된 위치에서 일정 각도 내에 포함되는 배경 영상과 해당 배경 상에서 움직이는 객체들을 촬영한다. 그리고 상기 영상 카메라(105)는 촬영된 영상을 센서 제어부(160)에 전달할 수 있다. 상기 영상 카메라(105)는 센서 노드(100)에 하나가 포함되거나 설계자의 목적에 따라 하나의 센서 노드(100)에 다수개가 마련될 수 있다.The

상기 센서 저장부(107)는 상기 센서 노드(100) 운용에 필요한 운영 체제, 상기 센서 노드(100) 운용 과정에서 발생하는 다양한 데이터들을 저장한다. 특히 상기 센서 저장부(107)는 상기 영상 카메라(105)가 제공하는 영상 내에서 특정 객체에 대한 객체 정보를 검출하기 위한 객체 정보 추출 알고리즘, 영상 카메라(105)가 수집한 영상에 대한 전처리 과정을 수행하기 위한 전처리 알고리즘을 포함할 수 있다. 또한 상기 센서 저장부(107)는 영상 카메라(105)가 수집하는 영상에 대하여 일정 시간 동안 저장하고, 일정 시간 경과 후 기 저장된 영상을 제거하거나 해당 영상을 사전 설정된 기기로 전송하도록 지원할 수 있다.The

상기 센서 제어부(160)는 본 발명의 센서 노드(100) 운용에 필요한 신호 흐름을 제어하며, 특히 영상 카메라(105)가 수집한 영상 내에서 객체 정보를 추출하고, 해당 영상에 대한 전처리 과정을 수행하도록 지원할 수 있다. 이를 위하여 상기 센서 제어부(160)는 객체 검출부(161) 및 전처리부(163)를 포함할 수 있다.The

상기 객체 검출부(161)는 상기 영상 카메라(105)가 수집한 영상을 분석하여 해당 영상 내에 포함된 적어도 하나의 객체에 대한 객체 정보를 추출하도록 지원할 수 있다. 이를 위하여 상기 객체 검출부(161)는 도 3 및 도 4에 도시된 바와 같은 이미지 모자이크 방식에 따라 촬영된 영상들의 객체 블록들을 영역 매칭하여 해당 영상 내에서 불연속적인 영상을 결합함으로서 사고 상황 분석을 수행할 수 있는 동적 객체 정보를 추출할 수 있다. 도 3에 도시된 도면은 특정 센서 노드가 촬영한 영상 내에서 차량 객체의 이동을 추적하기 위한 두개의 영상을 상하로 나란하게 배치한 도면이며, 도 4는 도 3의 나란한 두개의 영상에 대한 블록 매칭을 통하여 이미지 모자이크 처리 결과를 나타낸 것이다.The

또한 상기 객체 검출부(161)는 도 5에 나타낸 바와 같이 객체 검출을 위하여 Saliency map(돌출 맵)을 이용하여 객체 좌표 검출 및 동적 객체 정보 검출을 수행할 수 있다. 상기 도 5를 참조하면 상기 객체 검출부(161)는 영상 카메라(105)가 수집한 영상 "Camera input image"에 대하여 계조 변환 즉 "Convert gray"를 수행한 영상 처리를 수행하고, 이후 영상 처리된 영상에 대하여 "Static saliency map(정적 돌출 맵)"을 산출한 후, "Dynamic saliency map(동적 돌출 맵)"을 산출한다. 그리고 상기 객체 검출부(161)는 정적 돌출 맵 및 동적 돌출 맵 산출을 수행한 이후 주요 객체를 제외한 주변 객체들을 제거하는 "Removing outlier"를 수행하며, 주변 객체가 제거된 영상에서 주요 객체들에 대한 "Labeling"을 수행 후 객체 검출(Objects detection)을 수행하도록 지원한다. 상기 객체 검출부(161)는 상술한 돌출 맵 기반의 객체 정보 검출을 수행한 이후 해당 객체 정보를 마스터 노드(200)에 전달하도록 제어할 수 있다. 이때 상기 객체 검출부(161)는 라벨링 과정을 수행하면서 검출된 객체들에 고유 식별 번호를 부여하고, 해당 고유 식별 번호를 가지는 객체의 위치 정보를 이용하여 동적 객체 정보 산출 후 이를 마스터 노드(200)에 전달하도록 제어할 수 있다. 특히 본 발명의 객체 검출부(161)는 가우시안 블러링을 이용하여 3개 층의 피라미드 영상으로부터 정적 돌출 영상을 생성하고, 5개의 정적 돌출 영상을 이용하여 동적 돌출 영상을 생성할 수 있다. 이후 상기 객체 검출부(161)는 모폴로지를 이용하여 이상점을 제거하고 객체를 검출할 수 있다.In addition, the

상기 전처리부(163)는 상기 객체 검출부(161)가 객체 검출을 수행하기 이전에 또는 이후에 상기 영상 카메라(105)가 수집한 영상 또는 검출된 객체 영상에 대하여 노이즈 제거, 화소 보정, 분광 보정, 공간 보정 등을 수행할 수 있으며, 대비도 개선을 수행하도록 지원할 수 있다. 또한 상기 전처리부(163)는 영상 카메라(105)가 수집한 영상에 대하여 분광 보정을 수행함으로써 채광 변화에 관계없이 동일한 영상으로 분석될 수 있도록 지원할 수 있다. 그리고 상기 전처리부(163)는 필요에 따라 공간적 보정을 수행할 수 도 있다. 이러한 전처리부(163)는 센서 노드(100)에 포함되지 않고 이후에 설명하는 마스터 노드(200)에 마련되어 영상 보정을 수행하면서 함께 수행될 수 도 있을 것이다.The

상술한 바와 같이 본 발명의 실시 예에 따른 센서 노드(100)는 영상 카메라(105)가 수집한 영상 내에 포함된 주요 객체들에 대한 객체 정보를 산출하고, 산출된 객체 정보 및 주변 환경 정보를 마스터 노드(200)에 전달하는 기능을 수행할 수 있다. 이러한 센서 노드(100)는 임베이디드 시스템 방식에 의하여 구현될 수 있다.As described above, the

도 6은 본 발명의 실시 예에 따른 마스터 노드들(200) 중 하나의 마스터 노드 구성을 보다 상세히 나타낸 블록도이다. 6 is a block diagram illustrating a configuration of one master node among the

상기 도 6을 참조하면, 본 발명의 마스터 노드(200)는 마스터 통신 인터페이스(201), 마스터 전원부(203), 마스터 저장부(207) 및 마스터 제어부(260)를 포함할 수 있다.Referring to FIG. 6, the

이와 같은 구성을 가지는 마스터 노드(200)는 마스터 통신 인터페이스(201)를 통하여 센서 노드들(100)로부터 특정 영상 내에 포함된 객체 정보들을 수집하고, 수집된 객체 정보들을 통합하도록 지원한다. 이때 상기 마스터 노드(200)는 객체 정보 통합 과정에서 일정한 정합을 수행함과 아울러 영상 보정을 수행하도록 지원할 수 있다.The

이를 보다 상세히 설명하면, 상기 마스터 통신 인터페이스(201)는 상기 센서 노드(100)에 마련된 센서부 통신 인터페이스(101)와 동일 또는 호환이 가능한 유사한 통신 모듈 예를 들면 유선 케이블이나 무선 통신 모듈의 형태로 마련되어, 센서 노드(100)가 전달하는 객체 정보 및 영상을 수신할 수 있다. 상기 마스터 통신 인터페이스(201)는 상기 센서 노드(100)로부터 객체 정보 및 영상을 수신하는 경우, 해당 정보들을 마스터 제어부(260)에 전달할 수 있다.In more detail, the

상기 마스터 제어부(260)는 센서 노드들(100)로부터 특정 객체들에 대한 객체 정보를 수신하면 해당 객체 정보들을 마스터 저장부(207)에 임시 저장하도록 지원할 수 있다. 그리고 상기 마스터 제어부(260)는 상기 임시 저장된 객체 정보들을 통합하도록 지원할 수 있다. 이를 위하여 상기 마스터 제어부(260)는 정보 통합부(261) 및 영상 보정부(263)를 포함할 수 있다. 상기 정보 통합부(261)는 다수개의 센서 노드들(100)이 전달하는 객체 정보를 해당 객체별로 분류하고, 분류된 정보들을 통합하도록 제어한다. 이를 위하여 상기 정보 통합부(261)는 상기 센서 노드들(100)이 전달한 객체 정보의 고유 식별 번호를 참조하여 특정 객체들에 대한 정보 통합을 수행할 수 있다. 상기 영상 보정부(263)는 정보 통합 과정에서 발생하는 영상의 왜곡 정보를 최소화하도록 지원하는 구성이다. 이러한 영상 보정부(263)는 Harris corner를 이용한 특징점을 추출하는 방법과, 직접 선형 변환(Direct Linear Transformation : DLT)를 운용할 수 있다. 그리고 상기 영상 보정부(263)는 Stitching 기법을 이용하여 영상의 일그러짐을 최소화하도록 지원할 수 있다. 상기 마스터 제어부(260)는 영상 보정되고 정보 통합된 데이터를 서버(300)에 전송하도록 제어할 수 있다.When the

상기 마스터 전원부(203)는 상기 마스터 노드(200) 운용에 필요한 전원을 공급하는 구성이다. 이러한 마스터 전원부(203)는 상기 센서 전원부(103)와 유사한 형태로 구성될 수 있다.The master

상술한 바와 같이 본 발명의 마스터 노드(200)는 상기 센서 노드(100)가 전달한 객체 정보들을 통합 및 영상 보정을 수행하고, 해당 데이터를 서버(300)에 전달하는 역할을 수행한다. As described above, the

도 7은 본 발명의 실시 예에 따른 서버(300)의 구성을 보다 상세히 나타낸 블록도이다.7 is a block diagram illustrating in more detail the configuration of the

상기 도 7을 참조하면 본 발명의 서버(300)는 서버 통신 인터페이스(301), 서버 저장부(307), 오디오 처리부(309), 입력부(313), 표시부(311) 및 서버 제어부(360)를 포함할 수 있다.Referring to FIG. 7, the

이와 같은 구성을 가지는 본 발명의 서버(300)는 서버 통신 인터페이스(301)를 기반으로 마스터 노드(200)가 전달하는 통합 정보를 수신하고, 해당 통합 정보를 기반으로 사고 발생 여부에 대한 추론을 수행할 수 있다. 이하 상기 각 구성에 대하여 보다 상세히 설명하기로 한다.The

상기 서버 통신 인터페이스(301)는 마스터 통신 인터페이스(201)와 통신을 수행하여 마스터 노드(200)가 전송하는 통합 정보를 수신한다. 그리고 상기 서버 통신 인터페이스(301)는 수신한 통합 정보를 서버 제어부(360)에 전달할 수 있다. 이러한 서버 통신 인터페이스(301)는 마스터 노드(200)와의 연결 방식에 따라 유선 또는 무선 등 다양한 형태의 통신 모듈로 구성될 수 있다.The

상기 서버 저장부(307)는 상기 서버(300)의 구동에 필요한 다양한 응용 프로그램을 저장하며, 상기 마스터 노드(200)가 전달한 통합 정보를 저장할 수 있다. 특히 본 발명의 서버 저장부(307)는 마스터 노드(200)가 전달한 통합 정보로부터 사고 검출에 관한 추론을 위해 필요한 다양한 응용 프로그램을 저장할 수 있다. 예를 들면 상기 서버 저장부(307)는 통합 정보에 대한 ROI 기반 규칙 판별 알고리즘, 운동 벡터 연산 알고리즘, 사고 추론 알고리즘 등을 저장할 수 있다. ROI 기반 규칙 판별 알고리즘은 통합 정보에 포함된 객체들 중 ROI로 지정된 영역들의 겹침 정보에 따라 현재 전달된 통합 정보에 대한 사고 추론을 할지 여부를 결정하는 루틴들을 포함할 수 있다. 상기 ROI는 관심 영역에 관한 것으로 영상 내에 일정 객체들 예를 들면 차량 객체들이 ROI 대상이 될 수 있다. 상기 운동 벡터 연산 알고리즘은 영상에 포함된 객체들의 운동 벡터를 연산하는 알고리즘이다. 그리고 상기 사고 추론 알고리즘은 상기 ROI 기반 규칙 판별 알고리즘에 의하여 사고 추론 진행이 요청되면 현재 전달된 통합 정보에 포함된 모든 데이터들에 대하여 확률 추론을 수행하여 사고 발생 여부를 결정하도록 지원하는 루틴들을 포함한다. 상술한 각 알고리즘들을 서버 제어부(360)에 로드되어 사고 검출을 위한 동작 수행을 지원한다. 한편 상기 서버 저장부(307)는 사고 추론 결과에 따라 센서 노드들(100) 및 마스터 노드들(200)로부터 사고와 관련된 일정 영상 및 주변 정보 등을 수신하여 저장할 수 있다.The

상기 오디오 처리부(309)는 서버(300) 운용에 필요한 다양한 오디오 신호를 출력하는 구성이다. 이러한 오디오 처리부(309)는 스피커 등을 포함할 수 있다. 특히 상기 오디오 처리부(309)는 상기 서버 제어부(360)에서 마스터 노드(200)로부터 전달된 통합 정보가 사고 발생에 해당하는 것으로 결정되는 경우 그에 대한 알람에 대응하는 오디오 데이터를 출력하도록 지원할 수 있다. 그러면 서버(300)를 운용하는 운영자는 출력된 오디오 데이터를 인지하여 사고 발생에 따른 영상들을 보다 면밀히 확인할 수 있다.The

상기 입력부(313)는 상기 서버(300) 운용에 필요한 입력 신호를 생성하는 구성이다. 실질적으로 상기 센서 네트웍 기반의 사고 검출 시스템(10)은 센서 노드(100), 마스터 노드(200) 및 서버(300) 등이 각각 자동으로 데이터들을 전송 및 분석하고 그에 따른 사고 검출을 수행할 수 있어 별도의 정보 입력을 위한 입력부(313)가 생략될 수 도 있다. 한편 상기 입력부(313)는 상기 사고 검출 진행을 위한 데이터 분석과 요청을 수동으로 설정하기 위한 입력 신호 및 자동으로 설정하기 위한 입력 신호를 사용자 요청에 따라 생성할 수 있다. 입력부(313)에 의하여 자동 설정을 위한 입력 신호가 발생하면 상기 사고 검출 시스템(10)은 별도의 입력 신호 발생이 없더라도 사전 설정된 루틴들에 따라 센서 노드들(100)이 수집한 영상에 대한 자동 사고 검출 수행 및 알람 수행을 할 수 있다. 입력부(313)에 의하여 수동 설정을 위한 입력 신호가 발생하면 상기 사고 검출 시스템(10)은 자동 설정을 기본으로 하되, 사용자 요청에 따라 특정 통합 정보에 대하여 재검사를 수행하거나, 요청에 따라 센서 노드들(100) 및 마스터 노드들(200)에 영상 요청을 수행할 수 있다.The

상기 표시부(311)는 상기 서버(300) 운용 과정에서 필요한 다양한 화면이 출력되는 구성이다. 이러한 표시부(311)는 적어도 하나의 표시 영역 또는 적어도 하나의 표시 장치를 포함하여 구성될 수 있다. 다수개의 표시 영역 또는 표시 장치를 포함하는 경우 상기 표시부(311)는 각 마스터 노드들(200)이 전달한 통합 정보를 다수개의 표시 영역에 출력하도록 지원할 수 있다. 이때 표시부(311)는 서버(300)에서 수행되는 ROI 기반 규칙 판별 결과, 운동 벡터 연산 결과 및 사고 추론 결과 등을 일정 화면 영역에 출력할 수 있다.The

상기 서버 제어부(360)는 본 발명의 서버(300)를 구성하는 각 구성들을 초기화하는 한편, 본 발명의 실시 예에 따른 사고 검출 운용에 필요한 다양한 신호 흐름을 제어한다. 이를 위하여 상기 서버 제어부(360)는 ROI 기반 규칙 판별부(361), 운동 벡터 계산부(363), 사고 추론부(365)를 포함할 수 있다.The

상기 ROI 기반 규칙 판별부(361)는 마스터 노드들(200)이 전달한 통합 정보 내에서 검출된 객체들을 ROI 영역으로 설정하고, 각 ROI 영역들의 겹침 정도가 기 설정된 값과 일정 차이 이상을 가지는지를 검사한다. 예를 들면 상기 ROI 기반 규칙 판별부(361)는 도 8 및 도 9에 나타낸 바와 같이 각각의 차량 객체들을 ROI 블록으로 지정하고, ROI 블록들이 겹치는 범위를 판별하여 충돌 체크를 수행할 수 있다. 도 8 및 도 9를 참조하면 해당 ROI 블록들이 일정 부분 이상 겹치는 형태로 검출되기 때문에 상기 ROI 기반 규칙 판별부(361)는 해당 통합 정보가 사고 발생 확률이 높은 정보로 판단할 수 있다. 이에 따라 상기 ROI 기반 규칙 판별부(361)는 해당 통합 정보에 포함된 데이터들에 대하여 사고 추론을 진행하도록 사고 추론부(365)에 요청하거나, 사고 추론 요청 이전에 운동 벡터 계산을 수행하도록 운동 벡터 계산부(363)에 해당 통합 정보와 관련된 운동 벡터 연산을 요청할 수 있다.The ROI-based

상기 운동 벡터 계산부(363)는 마스터 노드들(200)이 전달한 통합 정보들에 포함된 객체들의 운동 벡터를 연산하는 구성이다. 그리고 상기 운동 벡터 계산부(363)는 객체의 동적 정보로부터 산출된 운동 벡터를 기반으로 사고 발생 여부에 대한 충돌 검사를 수행할 수 있다. 예를 들면, 운동 벡터 계산부(363)는 도 10 및 도 11에 도시된 바와 같이 일정 통합 정보에 포함된 두 개의 동적 객체에 대한 운동 벡터들을 연속적으로 산출하고, 해당 운동 벡터들을 하나의 좌표에 동시 출력함으로써 두 객체가 상호 충돌할 확률을 연산할 수 있다. 특히 도 10은 통합 정보에 포함된 객체의 ROI 영역의 중심점 X, Y 좌표가 프레임마다 변화하는 정도를 나타낸 것이다. 도시된 바와 같이 두 개 객체의 운동 벡터들 이동 방향이 한 지점으로 이동하고 있어 객체 간 충돌 확률이 매우 높음을 나타낼 수 있다. 상기 운동 벡터 계산부(363)는 산출된 운동 벡터들의 결과를 사고 추론부(365)에 전달할 수 있다.The

상기 사고 추론부(365)는 상기 ROI 기반 규칙 판별부(361)가 전달하는 ROI 블록들에 대한 정보 및 상기 운동 벡터 계산부(363)가 전달한 객체들의 운동 벡터 결과를 기반으로 사고 추론을 수행할 수 있다. 사고 발생 시 사고에 관련된 객체들은 운동 방향과 속도가 크게 변화한다. 따라서 사고 추론부(365)는 사고에 연관된 2개 이상의 객체 사이의 운동 벡터의 차이를 계산한 후 그 변화량 즉 증가 또는 감소를 사고 추론에 반영할 수 있다. 상기 사고 추론부(365)의 운동 벡터를 이용한 사건 상황 분석의 예를 도 12 및 도 13에 나타내었다. 상기 도 12 및 도 13에서 상대적으로 높은 꼭지점을 가지는 그래프는 두 개의 객체들 간 운동 벡터 차이의 변화량을 나타낸 것이며, 상대적으로 낮은 꼭지점을 가지는 그래프에서 해당 꼭지점은 사고 발생의 순간을 나타낸 것이다. 본 발명의 사고 추론부(365)는 이러한 운동 벡터들 기반의 그래프를 활용하여 마스터 노드들(200)이 전송하는 다양한 통합 정보들에 대한 사고 발생 여부를 검지할 수 있다.The

한편 상기 사고 추론부(365)는 통합 정보에 대하여 사고 발생으로 결정되는 경우, 해당 정보와 관련된 주변 영상 예를 들면 사고인지 후 사고 전 후 10초전 영상을 해당 센서 노드(100)와 마스터 노드(200)에 요구할 수 있다. 그리고 상기 사고 추론부(365)는 해당 요구에 응답한 정보를 각 센서 노드(100) 및 마스터 노드(200)로부터 수신하면 이를 서버 저장부(307)에 저장하도록 제어하고, 사고 후속처리를 위한 의사결정 정보로서 제공할 수 있다.On the other hand, when the

이상에서는 본 발명의 실시 예에 따른 센서 네트웍 기반의 사고 검출 시스템(10)의 각 구성들과 구성들의 역할에 대하여 설명하였다. 이하에서는 상기 사고 검출 시스템을 기반으로 운용되는 사고 검출 방법에 대하여 도면을 참조하여 보다 상세히 설명하기로 한다.In the above, the components of the sensor network-based

도 14는 본 발명의 실시 예에 따른 센서 네트웍 기반의 사고 검출 시스템의 사고 검출 방법을 설명하기 위한 각 구성들 간의 신호 흐름을 나타낸 도면이다.14 is a diagram illustrating a signal flow between components for explaining an accident detection method of a sensor network based accident detection system according to an exemplary embodiment of the present invention.

상기 도 14를 참조하면, 본 발명의 사고 검출 방법은 먼저, 센서 노드(100)가 S101 단계에서 영상 수집 및 객체 정보 검출을 수행한다. 이를 위하여 센서 노드(100)는 센서 전원부(103)로부터 전원을 공급받고 영상 카메라(105)를 초기화하도록 제어할 수 있다. 그리고 상기 센서 노드(100)는 상기 영상 카메라(105)가 지시하는 일정 범위의 영상을 수집하고, 수집된 영상에 대한 객체 정보 검출을 수행할 수 있다. 이 과정에서 상기 센서 노드(100)는 이미지 모자이크 및 Saliency 맵 기반의 객체 추출 방식에 따라 이미지 처리 및 객체 정보 추출을 수행할 수 있다. Referring to FIG. 14, in the accident detection method of the present invention, first, the

이후 상기 센서 노드(100)가 검출된 객체 정보를 S103 단계에서 마스터 노드(200)에 전달할 수 있다. 이 과정에서 상기 센서 노드(100)는 상기 객체의 주변 환경 정보를 함께 상기 마스터 노드(200)에 전송할 수 있다. 또한 상기 센서 노드(100)는 수집된 영상 프레임들에 대하여 실시간으로 객체 정보 추출을 수행하여 해당 객체들의 불연속 정보들을 마스터 노드(200)에 실시간으로 전송할 수 있다. 그러나 상기 센서 노드(100)의 하드웨어 특성에 따라 고용량의 데이터 처리가 불가능한 경우 센서 노드(100)는 일정 시간 간격으로 영상 프레임에 대한 객체 정보 추출을 수행하고, 추출된 객체 정보를 일정 주기로 상기 마스터 노드(200)에 전송할 수 있다. 한편 상기 센서 노드(100)는 각 불연속 객체 정보들을 통합하여 연속된 동적 객체 정보를 생성한 후 이를 마스터 노드(200)에 전달할 수 도 있다. 이때 상기 센서 노드(100)는 영상 내에 포함된 객체에 대하여 고유 식별 번호를 부여하여 해당 고유 식별 번호를 가지는 객체에 대한 정보 추적을 통하여 연속된 동적 객체 정보를 생성할 수 있다.Thereafter, the

상기 마스터 노드(200)는 S105 단계에서 복수개의 센서 노드들(100)로부터 수신된 객체 정보들을 통합하며, 필요에 따라 영상 보정을 수행한다. 예를 들어 센서 노드(100)들이 불연속 객체 정보를 전달하는 경우, 해당 불연속 객체 정보를 통합하여 연속된 동적 객체 정보로 변환할 수 있다. 또한 상기 마스터 노드(200)는 센서 노드들(100)이 연속된 동적 객체 정보를 전달하는 경우, 각각의 센서 노드들(100)의 객체 정보를 통합하도록 지원하며, 이 과정에서 통합 정보에 대한 영상 보정을 수행할 수 있다. 영상 보정 과정은 통합 정보의 영상 일그러짐이나 화소 결핍, 모서리 영역의 구부러짐 등을 보정하는 과정이 될 수 있다.The

그리고 상기 마스터 노드(200)는 S107 단계에서 통합 정보를 서버(300)에 전송할 수 있다. 그러면 상기 서버(300)는 S109 단계에서 전달된 통합 정보를 기반으로 사고 추론을 수행한다. 이를 위하여 상기 서버(300)는 객체들에 대한 ROI 블록 지정과, ROI 블록들의 겹침 정도에 따른 충돌을 체크하거나, ROI 블록의 중심점을 X, Y 좌표로 한 후 복수개의 객체들의 운동 벡터에 따른 프레임 변화를 이용하여 충돌을 체크할 수 있다. 또한 상기 서버(300)는 상기 ROI 블록들의 겹침 및 ROI 블록으로 지정된 객체들의 운동 벡터 변화량 등을 이용하여 사고 추론을 수행할 수 있다.In addition, the

이후 상기 서버(300)는 사고 추론 결과가 사고 발생으로 결정되면 S111 단계에서 센서 노드들(100) 및 마스터 노드들(200)에게 해당 사고 발생 시점의 객체들에 대한 영상 정보 및 기타 정보를 포함하는 수집 정보 요청을 수행할 수 있다.After that, when the accident inference result is determined to be an accident, the

그러면 상기 센서 노드들(100) 및 마스터 노드들(200)은 S113 단계에서 서버(300) 요청에 따른 수집 정보를 서버(300)에 전송할 수 있다. 상기 서버(300)는 상기 센서 노드들(100) 및 마스터 노드들(200)로부터 전달되는 수집 정보를 서버 저장부(307)에 저장하고 추후 사고 후속처리를 위하여 정보로 제공할 수 있다.Then, the

상술한 바와 같이 본 발명의 실시 예에 따른 센서 네트웍 기반의 사고 검출 시스템 및 사고 검출 방법은 각각의 센서 노드들이 영상 내 객체들에 대한 정보 추출을 수행하고, 마스터 노드들이 이를 통합한 후 서버에 제공함으로써 서버에서 처리할 데이터 연산량을 최적화할 수 있으며, 이에 따라 보다 효율적인 시스템 관리 및 사고 검출 관리를 수행하도록 지원할 수 있다.As described above, the sensor network-based accident detection system and the incident detection method according to an embodiment of the present invention provide each server to extract information about objects in the image, and provide them to the server after the master nodes integrate them. By optimizing the amount of data processing to be processed in the server, it is possible to support more efficient system management and incident detection management.

이상 본 발명을 몇 가지 바람직한 실시 예를 사용하여 설명하였으나, 이들 실시 예는 예시적인 것이며 한정적인 것이 아니다. 이와 같이, 본 발명이 속하는 기술 분야에서 통상의 지식을 지닌 자라면 본 발명의 사상과 첨부된 특허청구범위에 제시된 권리범위에서 벗어나지 않으면서 균등론에 따라 다양한 변화와 수정을 가할 수 있음을 이해할 것이다. While the present invention has been described with reference to several preferred embodiments, these embodiments are illustrative and not restrictive. As such, those of ordinary skill in the art will appreciate that various changes and modifications can be made according to equivalents without departing from the spirit of the present invention and the scope of rights set forth in the appended claims.

10 : 사고 검출 시스템 100 : 센서 노드

101 : 센서부 통신 인터페이스 103 : 센서 전원부

107 : 센서 저장부 110 : 제1 센서 노드 그룹

120 : 제2 센서 노드 그룹 160 : 센서 제어부

161 : 객체 검출부 163 : 전처리부

200, 210, 220 : 마스터 노드 201 : 마스터 통신 인터페이스

203 : 마스터 전원부 207 : 마스터 저장부

260 : 마스터 제어부 261 : 정보 통합부

263 : 영상 보정부 300 : 서버

301 : 서버 통신 인터페이스 307 : 서버 저장부

309 : 오디오 처리부 311 : 표시부

313 : 입력부 360 : 서버 제어부

361 : ROI 기반 규칙 판별부 363 : 운동 벡터 계산부

365 : 사고 추론부10: accident detection system 100: sensor node

101: sensor unit communication interface 103: sensor power supply unit

107: sensor storage unit 110: the first sensor node group

120: second sensor node group 160: sensor control unit

161: object detection unit 163: preprocessing unit

200, 210, 220: master node 201: master communication interface

203: master power supply unit 207: master storage unit

260: master control unit 261: information integration unit

263: image correction unit 300: server

301: server communication interface 307: server storage unit

309: audio processor 311: display unit

313

361: ROI based rule determination unit 363: motion vector calculation unit

365: accident reasoning unit

Claims (8)

상기 복수 개의 센서 노드로부터 객체 정보를 전달받아 각 객체 정보들을 통합하여 통합 정보를 생성하는 적어도 하나의 마스터 노드;

상기 적어도 하나의 마스터 노드로부터 통합 정보를 수신하고 상기 통합 정보에 대하여 ROI 블록 매칭 및 운동 벡터 계산을 통하여 사고 발생 여부를 추론하는 서버;

를 포함하는 것을 특징으로 하는 센서 네트웍 기반의 사고 검출 시스템.A plurality of sensor nodes which collect a range of images at the arranged position and extract object information of specific objects included in the collected images;

At least one master node receiving object information from the plurality of sensor nodes and integrating object information to generate integration information;

A server that receives the integrated information from the at least one master node and infers whether or not an accident has occurred through ROI block matching and motion vector calculation on the integrated information;

Sensor network-based accident detection system comprising a.

상기 센서 노드는

상기 영상 수집을 위한 적어도 하나의 영상 카메라;

상기 영상 카메라가 수집한 영상으로부터 해당 영상 내에 포함된 객체 정보를 추출하는 센서 제어부;

상기 추출된 객체 정보를 상기 적어도 하나의 마스터 노드에 전송하는 센서부 통신 인터페이스;

상기 수집된 영상 및 객체 정보를 저장하는 센서 저장부;

를 포함하는 것을 특징으로 하는 센서 네트웍 기반의 사고 검출 시스템.The method of claim 1,

The sensor node is

At least one image camera for collecting the image;

A sensor controller configured to extract object information included in the corresponding image from the image collected by the image camera;

A sensor unit communication interface configured to transmit the extracted object information to the at least one master node;

A sensor storage unit storing the collected image and object information;

Sensor network-based accident detection system comprising a.

상기 센서 제어부는

이미지 모자이크 방식 및 돌출 맵 처리 방식을 기반으로 영상 내의 불연속 객체 정보를 연속된 동적 객체 정보로 추출하는 객체 검출부;

상기 영상의 보정을 수행하는 전처리부;

를 포함하는 것을 특징으로 하는 센서 네트웍 기반의 사고 검출 시스템.The method of claim 2,

The sensor controller

An object detection unit extracting discontinuous object information in the image as continuous dynamic object information based on an image mosaic method and a protrusion map processing method;

A preprocessor for correcting the image;

Sensor network-based accident detection system comprising a.

상기 마스터 노드는

상기 복수개의 센서 노드로부터 상기 객체 정보 수신을 위한 마스터 통신 인터페이스;

상기 복수개의 센서 노드가 전송한 객체 정보들을 통합하여 통합 정보를 생성하는 마스터 제어부;를 포함하며,

상기 마스터 제어부는

상기 객체 정보 통합을 위한 정보 통합부;

상기 통합 정보의 영상 보정을 수행하는 영상 보정부;

를 포함하는 것을 특징으로 하는 센서 네트웍 기반의 사고 검출 시스템.The method of claim 1,

The master node

A master communication interface for receiving the object information from the plurality of sensor nodes;

And a master controller configured to generate object information by integrating object information transmitted by the plurality of sensor nodes.

The master control unit

An information integration unit for integrating the object information;

An image corrector configured to correct an image of the integrated information;

Sensor network-based accident detection system comprising a.

상기 서버는

상기 마스터 노드로부터 통합 정보를 수신하기 위한 서버 통신 인터페이스;

상기 통합 정보를 기반으로 사고 추론을 수행하기 위한 서버 제어부;

상기 사고 추론 결과를 저장함과 아울러 사고 발생 결정 시 사고 발생과 관련된 일정 시간 범위의 영상을 상기 복수개의 센서 노드들 및 적어도 하나의 마스터 노드로부터 수신하여 저장하는 서버 저장부;

상기 사고 추론 결과를 출력하는 표시부 또는 오디오 처리부;

를 포함하는 것을 특징으로 하는 센서 네트웍 기반의 사고 검출 시스템.The method of claim 1,

The server

A server communication interface for receiving integration information from the master node;

A server controller configured to perform accident inference based on the integrated information;

A server storage unit for storing the accident inference result and receiving and storing an image of a predetermined time range related to an accident occurrence from the plurality of sensor nodes and at least one master node when determining an accident occurrence;

A display unit or an audio processor which outputs the accident inference result;

Sensor network-based accident detection system comprising a.

상기 서버 제어부는

상기 통합 정보에 포함된 객체들에 대하여 ROI 블록 매칭을 수행하여 충돌 체크를 수행하는 ROI 기반의 규칙 판별부;

상기 객체들의 운동 벡터를 연산하는 운동 벡터 계산부;

상기 객체들의 ROI 블록들의 충돌 체크 및 운동 벡터들 계산 결과를 기반으로 사고 발생 여부를 추론하는 사고 추론부;

를 포함하는 것을 특징으로 하는 센서 네트웍 기반의 사고 검출 시스템.The method according to claim 5,

The server control unit

A ROI-based rule determination unit performing a collision check by performing ROI block matching on the objects included in the integrated information;

A motion vector calculator for calculating motion vectors of the objects;

An accident inference unit that infers whether an accident has occurred based on a collision check of the ROI blocks of the objects and a calculation result of motion vectors;

Sensor network-based accident detection system comprising a.

상기 사고 추론부는

상기 추론 결과 사고 발생으로 판단되는 경우 상기 복수개의 센서 노드들 및 적어도 하나의 마스터 노드에 상기 사고 발생과 관련된 일정 시간 범위의 영상을 전송하도록 요청하는 것을 특징으로 하는 센서 네트웍 기반의 사고 검출 시스템.The method of claim 6,

The accident reasoning unit

Sensor network based incident detection system, characterized in that for requesting the plurality of sensor nodes and at least one master node to transmit an image of a predetermined time range associated with the accident occurs if it is determined that the accident occurred.

상기 각 센서 노드들이 촬영된 영상에서 특정 객체들의 객체 정보를 추출하는 단계;

상기 추출된 객체 정보를 마스터 노드에 전송하는 단계;

상기 마스터 노드가 상기 객체 정보들을 통합하여 통합 정보를 생성하는 단계;

상기 마스터 노드가 상기 통합 정보를 서버에 전송하는 단계;

상기 서버가 상기 전달된 통합 정보에 대하여 ROI 블록 매칭 및 운동 벡터 계산을 통하여 사고 발생 추론을 수행하는 단계;

상기 사고 발생 추론 결과 사고 발생으로 결정되는 경우 상기 복수개의 센서 노드들 및 적어도 하나의 마스터 노드에 사고 발생 시점을 기준으로 일정 시간 범위의 영상을 요청하여 상기 서버에 저장하는 단계;

를 포함하는 것을 특징으로 하는 센서 네트웍 기반의 사고 검출 방법.Photographing an image at a position where a plurality of sensor nodes are arranged;

Extracting object information of specific objects from the captured images of the respective sensor nodes;

Transmitting the extracted object information to a master node;

The master node integrating the object information to generate integration information;

Transmitting, by the master node, the integration information to a server;

The server performing accident occurrence inference through the ROI block matching and motion vector calculation on the transmitted integrated information;

Requesting the plurality of sensor nodes and at least one master node for an image in a predetermined time range based on an accident occurrence time and storing the image in the server when it is determined that the accident has occurred;

Sensor network-based accident detection method comprising a.

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| KR1020100133324A KR101177710B1 (en) | 2010-12-23 | 2010-12-23 | Accident Detecting System based on the Sensor Network And Method thereof |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| KR1020100133324A KR101177710B1 (en) | 2010-12-23 | 2010-12-23 | Accident Detecting System based on the Sensor Network And Method thereof |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| KR20120071686A KR20120071686A (en) | 2012-07-03 |

| KR101177710B1 true KR101177710B1 (en) | 2012-08-28 |

Family

ID=46706622

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| KR1020100133324A KR101177710B1 (en) | 2010-12-23 | 2010-12-23 | Accident Detecting System based on the Sensor Network And Method thereof |

Country Status (1)

| Country | Link |

|---|---|

| KR (1) | KR101177710B1 (en) |

Families Citing this family (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| CN103700250B (en) * | 2012-09-28 | 2016-05-04 | 姜廷顺 | Public security traffic accident immediate processing method and system |

Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2004100103A1 (en) | 2003-05-07 | 2004-11-18 | Koninklijke Philips Electronics N.V. | Event detection system |

-

2010

- 2010-12-23 KR KR1020100133324A patent/KR101177710B1/en active IP Right Grant

Patent Citations (1)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| WO2004100103A1 (en) | 2003-05-07 | 2004-11-18 | Koninklijke Philips Electronics N.V. | Event detection system |

Also Published As

| Publication number | Publication date |

|---|---|

| KR20120071686A (en) | 2012-07-03 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| US20180204335A1 (en) | System for tracking object, and camera assembly therefor | |

| CN108983806B (en) | Method and system for generating area detection and air route planning data and aircraft | |

| US20210397203A1 (en) | Information collection system and server apparatus | |

| Niu et al. | A UAV-based traffic monitoring system-invited paper | |

| US11475671B2 (en) | Multiple robots assisted surveillance system | |

| KR101283965B1 (en) | Adaptive Accident Detecting System And Method thereof | |

| EP2867873B1 (en) | Surveillance process and apparatus | |

| JP2019114196A (en) | Information collection system and information collection device | |

| KR102335994B1 (en) | Integrated control apparatus of surveillance devices for drone surveillance | |

| US20100315508A1 (en) | Video monitoring system and method | |

| CN110543800A (en) | target identification and tracking method and device for nacelle and nacelle | |

| CN111988524A (en) | Unmanned aerial vehicle and camera collaborative obstacle avoidance method, server and storage medium | |

| CN105741477A (en) | Aircraft with intelligent fire control voice assistant | |

| KR101697060B1 (en) | Method of sening event and apparatus performing the same | |

| KR20190097337A (en) | Unexpected incident detecting system using vehicle position information based on C-ITS | |

| KR20180040255A (en) | Airport robot | |

| KR101719799B1 (en) | CCTV monitoring system | |

| KR20170058767A (en) | Smart plantation care system and method | |

| KR101177710B1 (en) | Accident Detecting System based on the Sensor Network And Method thereof | |

| KR20210041337A (en) | Control system and control device for patrol and moving out, and operation method thereof | |

| JP6253950B2 (en) | Image surveillance system | |

| CN117608302A (en) | Automatic routing inspection path planning method, device, equipment and storage medium | |

| CN207027526U (en) | A kind of mobile security robot with video analysis function based on binocular vision | |

| CN111901217B (en) | Key area land-air integrated warning system based on microvibration perception | |

| KR102328910B1 (en) | Apparatus for collecting data based on raspberry pi, integrated management server for building emergency vehicle dynamic guidance system using the same and method for operating it |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A201 | Request for examination | ||

| E902 | Notification of reason for refusal | ||

| E701 | Decision to grant or registration of patent right | ||

| GRNT | Written decision to grant | ||

| FPAY | Annual fee payment |

Payment date: 20150626 Year of fee payment: 4 |

|

| FPAY | Annual fee payment |

Payment date: 20160822 Year of fee payment: 5 |