JP7510258B2 - Image processing device, image processing method, imaging device, program, and storage medium - Google Patents

Image processing device, image processing method, imaging device, program, and storage medium Download PDFInfo

- Publication number

- JP7510258B2 JP7510258B2 JP2020028363A JP2020028363A JP7510258B2 JP 7510258 B2 JP7510258 B2 JP 7510258B2 JP 2020028363 A JP2020028363 A JP 2020028363A JP 2020028363 A JP2020028363 A JP 2020028363A JP 7510258 B2 JP7510258 B2 JP 7510258B2

- Authority

- JP

- Japan

- Prior art keywords

- gradation correction

- image processing

- gradation

- image data

- image

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 238000003384 imaging method Methods 0.000 title claims description 23

- 238000003672 processing method Methods 0.000 title claims 2

- 230000000694 effects Effects 0.000 claims description 19

- 238000004458 analytical method Methods 0.000 claims description 16

- 238000002834 transmittance Methods 0.000 claims description 8

- 238000000034 method Methods 0.000 description 115

- 230000008569 process Effects 0.000 description 99

- 239000003595 mist Substances 0.000 description 60

- 125000001475 halogen functional group Chemical group 0.000 description 22

- 238000004364 calculation method Methods 0.000 description 12

- 238000010586 diagram Methods 0.000 description 9

- 238000002156 mixing Methods 0.000 description 9

- 230000006870 function Effects 0.000 description 8

- 239000000203 mixture Substances 0.000 description 7

- 238000005516 engineering process Methods 0.000 description 5

- 238000001514 detection method Methods 0.000 description 4

- 230000009467 reduction Effects 0.000 description 3

- 230000002411 adverse Effects 0.000 description 2

- 238000006243 chemical reaction Methods 0.000 description 2

- 238000007906 compression Methods 0.000 description 2

- 230000006835 compression Effects 0.000 description 2

- 238000000926 separation method Methods 0.000 description 2

- 238000004501 airglow Methods 0.000 description 1

- 230000008901 benefit Effects 0.000 description 1

- 230000008859 change Effects 0.000 description 1

- 238000013144 data compression Methods 0.000 description 1

- 230000001419 dependent effect Effects 0.000 description 1

- 230000001815 facial effect Effects 0.000 description 1

- 239000004973 liquid crystal related substance Substances 0.000 description 1

- 238000012986 modification Methods 0.000 description 1

- 230000004048 modification Effects 0.000 description 1

- 230000003287 optical effect Effects 0.000 description 1

- 239000004065 semiconductor Substances 0.000 description 1

- 238000010257 thawing Methods 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T5/00—Image enhancement or restoration

- G06T5/73—Deblurring; Sharpening

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T5/00—Image enhancement or restoration

- G06T5/40—Image enhancement or restoration using histogram techniques

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T5/00—Image enhancement or restoration

- G06T5/90—Dynamic range modification of images or parts thereof

- G06T5/92—Dynamic range modification of images or parts thereof based on global image properties

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T7/00—Image analysis

- G06T7/10—Segmentation; Edge detection

- G06T7/13—Edge detection

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/20—Special algorithmic details

- G06T2207/20172—Image enhancement details

- G06T2207/20192—Edge enhancement; Edge preservation

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06T—IMAGE DATA PROCESSING OR GENERATION, IN GENERAL

- G06T2207/00—Indexing scheme for image analysis or image enhancement

- G06T2207/30—Subject of image; Context of image processing

- G06T2207/30196—Human being; Person

- G06T2207/30201—Face

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Theoretical Computer Science (AREA)

- Computer Vision & Pattern Recognition (AREA)

- Image Processing (AREA)

- Studio Devices (AREA)

Description

本発明は、霧霞が発生している状況で撮影した画像の霧霞を除去して視認性を向上させる技術に関するものである。 The present invention relates to a technology for removing fog from images captured in foggy conditions to improve visibility.

従来の監視等の用途で使用されるカメラにおいては、屋外を撮影する際に霧霞が発生して視認性が低下する場合がある。このような画像を救済するため、霧霞が発生した場合にそれらを除去する補正処理を行う技術が知られている。補正処理には、全画面に対してトーンカーブを用いてコントラストを補正する方法、大気モデルにおいてミー散乱とレイリー散乱を分離し、霧霞など波長に依存しないミー散乱成分を除去する散乱分離方式を採用する方法とがある。 Conventional cameras used for surveillance and other purposes can sometimes produce haze when capturing images outdoors, reducing visibility. To save such images, there are known techniques for performing correction processing to remove the haze when it occurs. Correction processing includes a method that uses a tone curve to correct contrast for the entire screen, and a scattering separation method that separates Mie scattering and Rayleigh scattering in an atmospheric model and removes Mie scattering components that are not wavelength-dependent, such as haze.

散乱分離方式は、画像の領域毎のダークチャネル値を用いて透過率を推定し、階調を制御して霧霞を除去する方式である。具体的には、大気モデルにおける霧霞の濃度に起因する透過率を推定し、階調制御を行う技術が提案されている。 The scattering separation method estimates the transmittance using the dark channel value for each region of the image and controls the gradation to remove mist and haze. Specifically, a technology has been proposed that estimates the transmittance caused by the concentration of mist and haze in an atmospheric model and performs gradation control.

特許文献1では、空領域または逆光領域を算出し、その領域におけるダークチャネル値を補正し、ダークチャネル値から透過率を算出し、その透過率を用いて入力画像から霧霞成分の除去を行う。 In Patent Document 1, the sky region or backlit region is calculated, the dark channel value in that region is corrected, the transmittance is calculated from the dark channel value, and the mist component is removed from the input image using the transmittance.

特許文献2では、カラー画像で散乱光の基準強度の導出に用いる画素を選択し、散乱光の第1の色成分に対応する第1の基準強度と、第2の色成分に対応する第2の基準強度を導出する。第1の基準強度と重み値を用いてカラー画像の第1の色成分の画素値を補正するとともに、第2の基準強度と重み値を用いて第2の色成分の画素値を補正し、補正画像を生成する。 In Patent Document 2, pixels used to derive the reference intensity of scattered light in a color image are selected, and a first reference intensity corresponding to a first color component of the scattered light and a second reference intensity corresponding to a second color component are derived. The first reference intensity and weighting value are used to correct the pixel values of the first color component of the color image, and the second reference intensity and weighting value are used to correct the pixel values of the second color component to generate a corrected image.

しかしながら、特許文献1に開示された従来技術では、ダークチャネル値を用いて散乱光に対する補正は可能であるが、画像内の輪郭部にハローノイズが発生してしまい、そのノイズを抑制することができない。 However, in the conventional technology disclosed in Patent Document 1, although it is possible to correct for scattered light using dark channel values, halo noise occurs at the edges of the image, and this noise cannot be suppressed.

また、特許文献2に開示された従来技術でも同様に、大気モデルにおける散乱光を用いて霧霞の濃度に起因する成分を除去して補正することはできるが、やはり画像内の輪郭部にハローノイズが発生してしまい、そのノイズを抑制することができない。 Similarly, the conventional technology disclosed in Patent Document 2 can also use scattered light in an atmospheric model to remove and correct components caused by the concentration of fog and haze, but it still generates halo noise at the edges of the image and cannot suppress the noise.

本発明は上述した課題に鑑みてなされたものであり、その目的は、画像内の霧霞を良好に除去することができる画像処理装置を提供することである。 The present invention has been made in consideration of the above-mentioned problems, and its purpose is to provide an image processing device that can effectively remove fog from an image.

本発明に係わる画像処理装置は、 画像データを取得する取得手段と、前記画像データの領域毎のダークチャネル値を取得して透過率を推定し、階調を補正する第1の階調補正手段と、トーンカーブを用いて前記画像データの階調を補正する第2の階調補正手段と、どの階調補正手段を用いて階調補正を行うかを制御する制御手段と、を備え、前記制御手段は、前記第1の階調補正手段に、徐々に補正効果を得るように階調補正を行わせ、前記画像データにおける被写体の輪郭部に白領域が抽出された場合に、前記第1の階調補正手段による前記階調補正を停止させることを特徴とする。 The image processing device of the present invention comprises an acquisition means for acquiring image data, a first gradation correction means for acquiring a dark channel value for each region of the image data to estimate transmittance and correct the gradation, a second gradation correction means for correcting the gradation of the image data using a tone curve, and a control means for controlling which gradation correction means is to be used for the gradation correction , wherein the control means causes the first gradation correction means to perform gradation correction so as to gradually obtain a correction effect, and stops the gradation correction by the first gradation correction means when a white region is extracted at the contour of a subject in the image data .

本発明によれば、画像内の霧霞を良好に除去することができる画像処理装置を提供することが可能となる。 The present invention makes it possible to provide an image processing device that can effectively remove fog and haze from an image.

以下、添付図面を参照して実施形態を詳しく説明する。なお、以下の実施形態は特許請求の範囲に係る発明を限定するものではない。実施形態には複数の特徴が記載されているが、これらの複数の特徴の全てが発明に必須のものとは限らず、また、複数の特徴は任意に組み合わせられてもよい。さらに、添付図面においては、同一若しくは同様の構成に同一の参照番号を付し、重複した説明は省略する。 The following embodiments are described in detail with reference to the attached drawings. Note that the following embodiments do not limit the invention according to the claims. Although the embodiments describe multiple features, not all of these multiple features are necessarily essential to the invention, and multiple features may be combined in any manner. Furthermore, in the attached drawings, the same reference numbers are used for the same or similar configurations, and duplicate explanations are omitted.

(第1の実施形態)

図1は、本発明の画像処理装置の第1の実施形態であるデジタルカメラ100の構成を示す図である。

First Embodiment

FIG. 1 is a diagram showing the configuration of a

図1において、レンズ部102は、被写体の光学像を、CCDやCMOSセンサなどからなる撮像素子を有する撮像部101に結像させる。また、レンズ駆動装置103によってズーム制御、フォーカス制御、絞り制御などが行われる。撮像信号処理回路104は、撮像部101から出力される画像信号に各種の補正処理やデータ圧縮処理等を行う。また、撮像信号処理回路104は、内部に画像の霧霞を除去するための画像処理回路120を有する。撮像素子駆動回路105は撮像部101内の撮像素子に各種電源や撮影モードの指示信号、各種タイミング信号を出力する。

In FIG. 1, a

メモリ部106は、画像データを一時的に記憶するためのメモリとして機能し、全体制御演算部107は各種演算とデジタルカメラ100全体の制御を行う。記録媒体制御I/F部108は記録媒体へのデータの記録または記録媒体からのデータの読み出しを行うためのインターフェースである。記録媒体109は、画像データの記録または読み出しを行うための着脱可能な半導体メモリである。さらに、表示部110は、各種情報や撮影画像を表示する液晶表示装置などの表示デバイスである。

The memory unit 106 functions as a memory for temporarily storing image data, and the overall

図2は、図1における画像処理回路120の構成を示すブロック図である。画像処理回路120は、画像の輪郭部に発生するハローノイズを抑制しつつ霧霞を除去する機能を備える。

Figure 2 is a block diagram showing the configuration of the

図2において、画像処理回路120は、第1の画像処理部11、第1のかすみ補正部12、第2のかすみ補正部14、第2の画像処理部15、画像出力部16、ヒストグラム取得・解析部13を備える。

In FIG. 2, the

撮像部101により撮像された画像データは、画像処理回路120に入力される。第1の画像処理部11は、画像データの1段目の画像処理部である。具体的には撮像部101から取得した画像データに対して、センサ補正処理、キズ補正処理、ベイヤー型のRGB信号からYC信号に変換する変換処理、輪郭強調処理、ノイズリダクション処理、ホワイトバランス処理などを行う。第1のかすみ補正部12は、画像の領域毎のダークチャネル値を用いて透過率(濃度マップ)を推定し、階調を制御する第1の階調補正処理(階調補正動作)を行う第1段の階調補正部である。ヒストグラム取得・解析部13は第1の階調補正処理を行った後の補正画像において、輝度成分のヒストグラムを取得し、その分散値を算出することにより画像のコントラストを検出する。第2のかすみ補正部14はトーンカーブを用いてコントラストや中間階調の制御を行う第2の階調補正処理(階調補正動作)を行う第2段の階調補正部である。

Image data captured by the

以下、第1の階調補正処理の詳細について説明する。まず、霧霞が発生している画像Iと、霧霞除去後の画像Jは式(1)のような大気モデルで関係づけられる。 The details of the first tone correction process are described below. First, image I in which mist and haze have occurred and image J after mist and haze have been removed are related by an atmospheric model such as equation (1).

I(x,y)=J(x,y)・t(x,y)+A(1-t(x,y) 式(1)

x,yは画像内における水平方向と垂直方向の2次元座標位置、tは霧霞の濃度マップ、Aは環境光を示す。ここで、濃度マップt(x,y)は大気による減衰を意味しており、カメラからの被写体距離が長いほど減衰量(画素値)が大きく、近いほど減衰量(画素値)は小さくなる。式(1)において、環境光Aおよび、濃度マップt(x,y)を推定することで、霧霞除去後のJ(x,y)を求めることが可能になる。

I(x,y)=J(x,y)·t(x,y)+A(1−t(x,y) Equation (1)

x, y are two-dimensional coordinate positions in the horizontal and vertical directions in the image, t is the mist density map, and A is the ambient light. Here, the density map t(x, y) represents attenuation due to the atmosphere, and the longer the subject distance from the camera, the greater the amount of attenuation (pixel value), and the closer the subject is, the smaller the amount of attenuation (pixel value). In formula (1), by estimating the ambient light A and the density map t(x, y), it is possible to find J(x, y) after mist removal.

まず、環境光Aの推定方法について数式を用いて説明する。環境光Aは、空領域のRGB成分の平均画素値であり、式(2)のようにして算出される。 First, we will explain how to estimate the ambient light A using a formula. Ambient light A is the average pixel value of the RGB components of the sky region, and is calculated using formula (2).

ave関数は引数内の平均値を算出する関数を表し、cは色成分を表し、Ωskyは空領域内の局所領域を示す。ここで、空領域は、例えば、ヒストグラムの分布に基づき算出する方法や、予め指定した座標位置を用いる方法、ユーザーからの指示位置を用いる方法等により特定することができる。 The ave function is a function that calculates the average value in the arguments, c represents a color component, and Ωsky represents a local area within the sky region. Here, the sky region can be identified by, for example, a method of calculation based on the distribution of a histogram, a method of using a coordinate position specified in advance, or a method of using a position indicated by the user.

続いて、濃度マップt(x,y)の推定方法について説明する。本実施形態における第1の階調処理は、ダークチャネル値に基づき濃度マップt(x,y)を推定する処理であり、霧霞が発生していない屋外画像において、RGB成分の少なくとも1つの成分の画素値が局所的に非常に小さいことを前提にしている。ダークチャネル値Idrkは、式(3)のようにして算出される。 Next, a method for estimating the density map t(x, y) will be described. The first gradation process in this embodiment is a process for estimating the density map t(x, y) based on the dark channel value, and is based on the premise that in an outdoor image without haze, the pixel value of at least one of the RGB components is locally very small. The dark channel value I drk is calculated as shown in Equation (3).

cは色成分を表し、Ωは注目座標(x,y)を含む局所領域を示す。式(3)に示されるように、ダークチャネル値は、注目画素を含む局所領域内におけるRGB成分の最小値となる。式(1)の大気モデルに、式(3)のダークチャネルの算出式を代入すると、大気モデルからダークチャネル値を算出する式(4)が得られる。 c represents a color component, and Ω represents a local region including the target coordinates (x, y). As shown in equation (3), the dark channel value is the minimum value of the RGB components in the local region including the target pixel. By substituting the dark channel calculation formula (3) into the atmospheric model (1), equation (4) is obtained to calculate the dark channel value from the atmospheric model.

Idrk=Jdrk(x,y)・t(x,y)+A(1-t(x,y)) 式(4)

ここで、霧霞が発生していない画像において、RGB成分の少なくとも1つの成分の画素値は局所的に小さいという前提を考慮すると、式(4)における霧霞除去画像のダークチャネル値Jdrk(x,y)は0に限りなく近い値となる。従って、式(4)は式(5)のように近似することができる。

I drk = J drk (x, y) · t (x, y) + A (1 - t (x, y)) Equation (4)

Here, assuming that in an image without fog or haze, the pixel value of at least one of the RGB components is locally small, the dark channel value J drk (x, y) of the defrosted image in equation (4) is extremely close to 0. Therefore, equation (4) can be approximated as equation (5).

Idrk(x,y)≒A(1-t(x,y)) 式(5)

式(5)の近似式を変形することで、式(6)のようにして濃度マップt(x,y)を推定することができる。

I drk (x, y) ≈ A (1-t (x, y)) Equation (5)

By modifying the approximation of equation (5), the concentration map t(x, y) can be estimated as in equation (6).

t(x,y)≒1-{ω×Idrk(x,y)/A} 式(6)

ここで、ωは霧霞の補正度合いを制御するパラメータであり、0.0から1.0の範囲で定義され、値が大きいほど霧霞の補正効果を強く設定することができる。以上説明した式(2)~(6)によって算出される大気光A、濃度マップt(x,y)を式(7)に代入することで、霧霞除去後のJ(x,y)を求めることができる。

t(x,y)≈1-{ω×I drk (x,y)/A} Equation (6)

Here, ω is a parameter that controls the degree of mist/haze correction and is defined in the range from 0.0 to 1.0, and the larger the value, the stronger the mist/haze correction effect can be set. By substituting the airglow A and concentration map t(x, y) calculated by equations (2) to (6) described above into equation (7), it is possible to find J(x, y) after mist/haze removal.

J(x,y)={(I(x,y)-A)/t(x,y)}+A 式(7)

式(1)に示されるように、ダークチャネルに基づく第1の階調補正処理は、環境光Aに加えて、カメラからの被写体距離に応じて変化する濃度マップも考慮して、画素毎に補正量を算出する。従って、近景の被写体だけでなく、遠景の被写体に対しても、霧霞を効果的に除去できる。しかしながら、式(3)で示されるように、ダークチャネル値の算出がエッジ情報を考慮していない点や、式(4)で示されるように、濃度マップを近似で求めている点があるため、エッジ部周辺で誤補正、具体的には、白く浮きあがってしまう現象(以降、この現象をハローノイズ(白領域)と呼ぶ)が発生してしまう。

J(x,y)={(I(x,y)-A)/t(x,y)}+A Equation (7)

As shown in formula (1), the first tone correction process based on the dark channel calculates the correction amount for each pixel, taking into account not only the ambient light A but also the density map that changes depending on the subject distance from the camera. Therefore, it is possible to effectively remove fog and haze not only from close-up subjects but also from distant subjects. However, as shown in formula (3), the calculation of the dark channel value does not take into account edge information, and as shown in formula (4), the density map is calculated by approximation, so that erroneous correction occurs around the edge portion, specifically, a phenomenon in which the edge portion appears white (hereinafter, this phenomenon is called halo noise (white area)).

続いて、第2のかすみ補正部14の詳細について説明する。まず、ヒストグラム取得・解析部13では、入力画像のヒストグラムを生成し、生成したヒストグラムの分布密度を表す統計値を算出する。例えば、式(8)のようにして、ヒストグラムの分散σ2を求める。

Next, the second

σ2={(x1-μ)2・f1+(x2-μ)2・f2+…+(xN-μ)2}/n 式(8)

ここで、xiは入力輝度レベル、xNは入力輝度レベルの最大値、fは頻度、nはデータの合計(総画素数)、μは平均を示す。なお、本実施形態では、分布密度を表す統計値として、ヒストグラムの分散を用いたが、これに限るものではない。

σ 2 = {(x1 - μ) 2 · f1 + (x2 - μ) 2 · f2 + ... + (xN - μ) 2 } / n Equation (8)

Here, x is the input luminance level, x is the maximum value of the input luminance level, f is the frequency, n is the sum of the data (total number of pixels), and μ is the average. Note that in this embodiment, the variance of the histogram is used as a statistical value representing the distribution density, but this is not limiting.

更に、ヒストグラム取得・解析部13では、前述のヒストグラムおよび、統計値に基づき、霧霞の発生度合いを算出する。一般的に霧霞が発生している画像は、図3(a)に示すように、ヒストグラムの分布が一部領域に集中し、コントラストの低い映像になっている。従って、霧霞が発生している場合は、分散値は比較的小さな値になる。そこで、霧霞補正部2は、任意の閾値Thと分散値σ2を比較することで、霧霞の発生度合いHを算出する。例えば、式(9)のようにして算出する。

Furthermore, the histogram acquisition and

0.0 (if σ2<0)

H= (Th-σ2)/Th (if 0≦σ2≦Th)

1.0 (if Th<σ2) 式(9)

ここで、式(9)で表される霧霞の発生度合いHは、0.0から1.0の範囲で正規化され、値が大きいほど霧霞の発生度合いが強い指標となる。

0.0 (if σ2 < 0)

H = (Th - σ2 ) /Th (if 0≦ σ2 ≦Th)

1.0 (if Th < σ 2 ) Equation (9)

Here, the degree of occurrence of mist/haze expressed by the formula (9) is normalized in the range of 0.0 to 1.0, and the larger the value, the stronger the degree of occurrence of mist/haze becomes.

続いて、第2のかすみ補正部14は、ヒストグラム取得・解析部13で算出される霧霞の発生度合いに応じて、トーカーブを調整する。具体的には、図4に示されるように、霧霞の発生度合いが強いほど、暗部を下げ、明部を持ち上げるトーンカーブを適用する。前述のトーンカーブを適用することで、図3(b)に示すように、ヒストグラムが滑らかに分布することになり、霧霞を除去することができる。

Then, the second

従って、第2のかすみ補正部14は、ヒストグラムの分布(霧霞の発生度合い)に応じて、画面全体のコントラストを向上させることで、弊害を抑えつつ、霧霞を除去することが可能になる。しかしながら、被写体距離を考慮した補正量を算出してないため、遠景の被写体に対して効果が弱い手法となる。

The second

なお、上記では第1のかすみ補正部12(一方のかすみ補正部)で第1の階調補正処理を行った後に第2のかすみ補正部14(他方のかすみ補正部)で第2の階調補正処理を行っているが、その順番は逆にしてもよい。つまり、第1のかすみ補正部12で第2の階調補正処理を行った後に第2のかすみ補正部14で第1の階調補正処理を行っても同様な霧霞除去効果が得られる。

In the above, the first haze correction unit 12 (one of the haze correction units) performs the first gradation correction process and then the second haze correction unit 14 (the other haze correction unit) performs the second gradation correction process, but the order may be reversed. In other words, a similar mist removal effect can be obtained by performing the second gradation correction process in the first

第2の画像処理部15では第1のかすみ補正部12、第2のかすみ補正部14で霧霞を除去した画像に対して2段目の画像処理を行う。具体的には輪郭強調処理、ノイズリダクション処理、色補正処理、解像度変換処理などを行う。ここで、輪郭強調処理、ノイズリダクション処理、色補正処理等は、第1の画像処理部11で行ってもよいし、第2の画像処理部15で行ってもよい。画像出力部16は、画像処理や霧霞除去処理を行った画像を画像圧縮処理等を行う別の画像処理部や表示部110等に出力する。

The second

なお、第1の階調補正処理においては、時間をかけて徐々に補正効果を得るように補正処理を実行する。具体的には、式(6)のωの値を小さな値から徐々に大きく設定する。そして、輪郭部にハローノイズを抽出した場合、第1の階調補正処理を中止(停止)する。そうすることにより、第1の階調補正処理で発生しうる輪郭部のハローノイズを抑制することが可能となる。 In the first gradation correction process, the correction process is performed so as to gradually obtain a correction effect over time. Specifically, the value of ω in equation (6) is set gradually from a small value to a large value. Then, if halo noise is extracted from the edge, the first gradation correction process is stopped (stopped). By doing so, it is possible to suppress halo noise from the edge that may occur in the first gradation correction process.

また、上記で説明したように、第1のかすみ補正部12で第1の階調補正処理を行い、第2のかすみ補正部14で第2の階調補正処理を行う場合と、階調補正処理の順番をその逆とする場合とが考えられる。それぞれの場合について、以下のような方法で階調補正処理が行われる。

As described above, it is also possible to consider a case where the first

まず、第1のかすみ補正部12で第1の階調補正処理を行い、第2のかすみ補正部14で第2の階調補正処理を行う場合は、次のような方法をとる。すなわち、第1のかすみ補正部12で上記のようにハローノイズの出方を見ながら、徐々に第1の階調補正処理を行い、その階調補正処理が止まってから画像の統計量、具体的には輝度ヒストグラムをみて階調制御の効果(補正結果)を判断する。もし階調制御の効果が不十分な場合には、第2のかすみ補正部14で、時間をかけて十分な効果が得られる階調補正量(目標とする階調)に達するまで第2の階調補正処理を行う。ただし、第2の階調補正処理は、ハローノイズを考慮する必要がないので、必ずしもゆっくり行う必要はない。

First, when the first

また、第1のかすみ補正部12で第2の階調補正処理を行い、第2のかすみ補正部14で第1の階調補正処理を行う場合は、次のような方法をとる。すなわち、第1のかすみ補正部12で、第2の階調補正処理の効果を見ながら、時間をかけて徐々に第2の階調補正処理を行う。第2の階調補正処理では、遠景部分には霧霞除去の大きな効果が得られないので、その効果の程度を見ながら処理を行う。ただし、第2の階調補正処理は、時間をかけて行った方が効果の変化を見やすいというメリットがあるが、上記で述べたようにハローノイズを考慮する必要がないので、必ずしもゆっくり行う必要はない。そして、第2の階調補正処理が止まってから、もし階調制御の効果が不十分な場合には、第2のかすみ補正部14で、時間をかけて十分な効果が得られる階調補正に達するまで第1の階調補正処理を行う。この場合も、第1の階調補正処理では、輪郭部にハローノイズを抽出したら、処理を中止する。

In addition, when the first

以上のような方法により、ハローノイズの発生を抑制した良好な霧霞除去処理を行うことができる。 By using the above method, it is possible to perform good de-haze processing that suppresses the occurrence of halo noise.

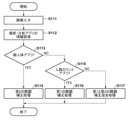

図3は、画像の輪郭部にハローノイズが発生しないように霧霞の除去を行う動作を示したフローチャートである。なお、図3は、第1のかすみ補正部12で第1の階調補正処理を行い、第2のかすみ補正部14で第2の階調補正処理を行う場合の例を示している。

Figure 3 is a flow chart showing the operation of removing mist and haze so that halo noise does not occur at the edges of an image. Note that Figure 3 shows an example in which the first

霧霞除去処理のフローが開始されると、ステップS31では、撮像部101により取得された画像が画像処理部120に入力される。ステップS32では、第1のかすみ補正部12が、第1の階調補正処理を行う。ここでは、前述したように画像の輪郭部にハローノイズが発生しない範囲で補正処理を行う。

When the flow of the mist removal process starts, in step S31, the image captured by the

ステップS33では、全体制御演算部107は、ステップS32において第1の階調補正処理を行った結果の画像に対して、コントラストの大きさを判断する。コントラストが所定の値より小さい場合には、ステップS34に進み、コントラストが所定の値以上の場合には階調補正処理を終了する。

In step S33, the overall

ステップS34では、ステップS32において実行した第1の階調補正処理で取りきれなかった霧霞を除去するために、第2の階調補正処理を実行し、階調補正処理を終了する。 In step S34, a second gradation correction process is performed to remove any mist or haze that could not be completely removed by the first gradation correction process performed in step S32, and the gradation correction process is terminated.

なお、図3では、ステップS32において第1の階調補正処理を行い、ステップS34において第2の階調補正処理を行う例を示した。しかし、既に説明したように、ステップS32において第2の階調補正処理を行い、ステップS34において第1の階調補正処理を行うようにしてもよい。どちらの場合でも、第1の階調補正処理では、ハローノイズが発生しない範囲で補正処理を行う。 Note that FIG. 3 shows an example in which the first gradation correction process is performed in step S32, and the second gradation correction process is performed in step S34. However, as already explained, it is also possible to perform the second gradation correction process in step S32, and the first gradation correction process in step S34. In either case, the first gradation correction process performs correction within a range in which halo noise does not occur.

以上説明したように、第1の実施形態によれば、ハローノイズが発生しない範囲で、効果的な霧霞除去処理を行うことが可能となる。 As described above, according to the first embodiment, it is possible to perform effective mist removal processing to the extent that halo noise does not occur.

(第2の実施形態)

以下、本発明の画像処理装置の第2の実施形態であるデジタルカメラについて説明する。第2の実施形態におけるデジタルカメラの全体構成は、図1に示した第1の実施形態の構成と同様であるので、その説明を省略する。この第2の実施形態では、第1の実施形態で説明した第1の階調補正処理と第2の階調補正処理に重みをつけて実施する。

Second Embodiment

A digital camera that is a second embodiment of the image processing device of the present invention will be described below. The overall configuration of the digital camera in the second embodiment is similar to that of the first embodiment shown in Fig. 1, so a description thereof will be omitted. In this second embodiment, the first tone correction process and the second tone correction process described in the first embodiment are weighted and executed.

図4は、第2の実施形態における画像の輪郭部にハローノイズが発生しないように霧霞除去を行う動作を示したフローチャートである。 Figure 4 is a flowchart showing the operation of de-misting an image in the second embodiment to prevent halo noise from occurring at the edges of the image.

霧霞除去処理のフローが開始されると、ステップS41では、撮像部101により取得された画像が画像処理部120に入力される。ステップS42では、第1の画像処理部11は、入力された画像の輝度値の統計量、具体的には輝度ヒストグラムを取得する。

When the flow of the mist removal process starts, in step S41, the image captured by the

ステップS43では、全体制御演算部107は、ステップS42において取得した輝度ヒストグラムからコントラストの大きさを判断する。コントラストが所定値よりも小さければ、霧霞が強くかかっていると判断してステップS44へ進み、コントラストが所定値以上であれば、霧霞がそれほど強くはないと判断してステップS46へ進む。

In step S43, the overall

ステップS44では、第1の実施形態で説明した第1の階調補正処理の重みを大きくする。ここでは、画像の輪郭部に発生するハローノイズを多少許容してでも、霧霞の除去度合いを強くする。また、ステップS45では、ステップS44で取り切れなかった霧霞を除去するために、第1の実施形態で説明した第2の階調補正処理を行う。そして、霧霞除去処理を終了する。なお、ステップS44とステップS45の順序は逆でも同様な効果が得られる。 In step S44, the weight of the first tone correction process described in the first embodiment is increased. Here, the degree of mist and haze removal is increased, even if it means allowing some halo noise to occur at the edges of the image. In addition, in step S45, the second tone correction process described in the first embodiment is performed to remove any mist and haze that could not be removed in step S44. Then, the mist and haze removal process ends. Note that the same effect can be obtained even if the order of steps S44 and S45 is reversed.

ステップS46では、コントラストがそれほど小さくはなく霧霞が強くはかかっていないため、画像の輪郭部のハローノイズが発生しないように、第1の階調補正処理の重みを小さくする。ステップS47では、ステップS46で取りきれなかった霧霞を除去するために、第2の階調補正処理の重みを大きくする。そして、霧霞除去処理を終了する。なお、ステップS46とステップS47の順序は逆でも同様な効果が得られる。 In step S46, since the contrast is not particularly low and the mist is not strong, the weight of the first gradation correction process is reduced so as to prevent halo noise from occurring at the edges of the image. In step S47, the weight of the second gradation correction process is increased in order to remove any mist that was not completely removed in step S46. The mist removal process then ends. Note that the same effect can be obtained even if the order of steps S46 and S47 is reversed.

以上説明したように、第2の実施形態によれば、霧霞の強さに応じて、効果的な霧霞除去処理を行うことが可能となる。 As described above, according to the second embodiment, it is possible to perform effective mist removal processing depending on the strength of the mist.

(第3の実施形態)

以下、本発明の画像処理装置の第3の実施形態であるデジタルカメラについて説明する。第3の実施形態におけるデジタルカメラの全体構成も、図1に示した第1の実施形態の構成と同様である。ただし、本実施形態では、画像処理回路121の構成が、第1の実施形態の画像処理回路120の構成とは異なる。この第3の実施形態では、注目領域に応じて、霧霞除去の方式を切り換えて実行する。

Third Embodiment

A digital camera according to a third embodiment of the image processing device of the present invention will now be described. The overall configuration of the digital camera in the third embodiment is also similar to that of the first embodiment shown in Fig. 1. However, in this embodiment, the configuration of the

図5は、第3の実施形態における画像処理回路121の構成を示す図である。画像処理回路121は、注目領域を指定(設定)し、その領域の被写体距離を測定し、被写体距離に応じて階調制御の方式を切り換え、霧霞の除去を行う。

Figure 5 is a diagram showing the configuration of the

図5において、画像処理回路121は、第1の画像処理部21、注目領域指定部22、距離情報取得部23、第1のかすみ補正部24、第2のかすみ補正部25、第2の画像処理部26、画像出力部27を備える。

In FIG. 5, the

撮像部101により撮像された画像データは、画像処理回路121に入力される。第1の画像処理部21は、画像データの1段目の画像処理部であり、第1の実施形態で説明した第1の画像処理部11と同様である。注目領域指定部22は、画像データ内で注目したい領域を指定する機能を有し、注目したい領域をユーザーが指定するGUI等を備える。距離情報取得部23は、注目領域指定部22によって指定された注目領域までの距離を測定する。ここで注目領域までの距離は、レンズ部102に配置されたフォーカスレンズやズームレンズの制御情報等を用いて測定する。

Image data captured by the

第1のかすみ補正部24は、第1の実施形態で説明した第1の階調補正処理を実行する。第2のかすみ補正部25は、第1の実施形態で説明した第2の階調補正処理を実行する。第2の画像処理部26は、第1のかすみ補正部24で補正された画像と第2のかすみ補正部25で補正された画像の選択処理もしくは混合処理、及び2段目の画像処理を行う。第1のかすみ補正部24は、遠い距離にある注目領域の霧霞を除去するのに効果があるため、距離情報取得部23で取得した距離情報が第1の所定距離より遠い場合に、第1のかすみ補正部24が選択される。第2のかすみ補正部25は、近い距離にある注目領域の霧霞を除去するのに効果があるために、距離情報取得部23で取得した距離情報が第2の所定距離より近い場合に、第2のかすみ補正部25が選択される。距離情報取得部23により取得された距離情報が第1の所定距離以下で、第2の所定距離以上の場合には、第1のかすみ補正部24で補正された画像と第2のかすみ補正部25で補正された画像の混合処理(合成処理)を行う。

The first

ここで、画像の合成比率は、領域ごとに被写体のエッジ情報を用いて決定する。具体的には、エッジであると考えられる領域に関しては、第1の実施形態で説明した第2の階調補正処理の比率を大きく設定する。一方、平坦であると考えられる領域に関しては、第1の実施形態で説明した第1の階調補正処理の比率を大きく設定する。このような比率で合成することで、エッジ部のハローノイズを抑制しつつ、霧霞除去を効果的に実行することができる。具体的な手順を以下で述べる。 Here, the image blending ratio is determined for each region using edge information of the subject. Specifically, for regions considered to be edges, the ratio of the second gradation correction process described in the first embodiment is set to a large value. On the other hand, for regions considered to be flat, the ratio of the first gradation correction process described in the first embodiment is set to a large value. Blending at such ratios makes it possible to effectively remove mist and haze while suppressing halo noise in edge areas. The specific steps are described below.

まず始めに、画像からエッジを検出する。エッジ検出の方法として、霧霞が発生している入力画像Iに対して、ソーベルフィルタを実行することで、エッジ情報を濃淡画像として抽出することができる。 First, edges are detected from the image. To detect edges, a Sobel filter is applied to the input image I, which is foggy, to extract edge information as a grayscale image.

続いて、生成されたエッジ情報(濃度値 F(x,y))に基づき、例えば、式(10)のようにして、混合比率Blend(x,y)を求める。 Next, the blending ratio Blend(x, y) is calculated based on the generated edge information (density value F(x, y)) using, for example, equation (10).

Blend(x,y)=F(x,y)/Fmax 式(10)

ここで、Fmaxは濃度値の最大値を示し、混合比率は0.0から1.0の値で正規化される。

Blend(x,y)=F(x,y)/Fmax Equation (10)

Here, Fmax indicates the maximum density value, and the mixture ratio is normalized to a value between 0.0 and 1.0.

最後に、式(10)の混合比率に基づき、第1のかすみ補正部24で補正された画像Dehaze1(x,y)と、第2のかすみ補正部25で補正された画像Dehaze2(x,y)を式(11)のようにして合成する。

Finally, based on the mixing ratio of equation (10), the image Dehaze1(x, y) corrected by the first

DehazeBlend(x,y)

=(1.0-Blend(x,y))×Dehaze1(x,y)+Blend(x,y)×Dehaze2(x,y)

式(11)

以上のような手順を踏むことで、エッジ部のハローノイズを抑制しつつ、霧霞除去を効果的に実行された混合画像DehazeBlend(x,y)が得られる。

Dehaze Blend (x,y)

= (1.0 - Blend(x,y)) x Dehaze1(x,y) + Blend(x,y) x Dehaze2(x,y)

Equation (11)

By following the above procedure, a blended image Dehaze Blend (x, y) in which haze removal has been effectively performed while suppressing halo noise at edges is obtained.

なお、第2の画像処理部26は、第1の実施形態で説明した第2の画像処理部15と同様である。各画像処理機能は第1の画像処理部21で行ってもよいし、第2の画像処理部26で行ってもよい。画像出力部27は、画像処理や霧霞除去処理を行った画像を、画像圧縮処理等を行う別の画像処理部や表示部110等に出力する。

The second

図6は、指定した注目領域の距離に応じて階調制御の方式を切り換えて霧霞の除去を行う動作を示すフローチャートである。 Figure 6 is a flowchart showing the operation of removing mist and haze by switching the gradation control method depending on the distance of the specified area of interest.

霧霞除去処理のフローが開始されると、ステップS61では、撮像部101により取得された画像が画像処理部121に入力される。ステップS62では、ユーザーが注目したい領域をGUI等で指定する。ステップS63では、距離情報取得部23が、ユーザーが指定した注目領域までの距離を測定する。注目領域までの距離は、レンズ部102に配置されたフォーカスレンズやズームレンズの制御情報等を用いて測定される。

When the flow of the mist removal process starts, in step S61, the image captured by the

ステップS64では、全体制御演算部107は、注目領域に含まれる被写体までの距離が第1の所定距離より遠いか否かを判別する。被写体までの距離が第1の所定距離より遠い場合には、ステップS65に進む。被写体までの距離が第1の所定距離より遠くない場合には、ステップS66に進む。

In step S64, the overall

ステップS65では、遠い被写体にかかっている霧霞を除去するのに効果的な第1の実施形態で説明した第1の階調補正処理を実行する。 In step S65, the first tone correction process described in the first embodiment is executed, which is effective in removing the haze that hangs over distant subjects.

ステップS66では、注目領域に含まれる被写体までの距離が第2の所定距離より近いか否かを判別する。被写体までの距離が第2の所定距離より近い場合には、ステップS67に進む。被写体までの距離が第2の所定距離より近くない場合には、ステップS68に進む。 In step S66, it is determined whether the distance to the subject included in the region of interest is closer than a second predetermined distance. If the distance to the subject is closer than the second predetermined distance, the process proceeds to step S67. If the distance to the subject is not closer than the second predetermined distance, the process proceeds to step S68.

ステップS67では、近い被写体にかかっている霧霞を除去するのに効果的な第1の実施形態で説明した第2の階調補正処理を実行する。ステップS68では、式(10)で求められる合成比率に基づき。第1の実施形態で説明した第1の階調補正処理で得られた画像と第2の階調補正処理で得られた画像を式(11)に示されるように混合処理を行う。このステップS68は、注目領域に含まれる被写体までの距離が第1の所定距離以下で、第2の所定距離以上の場合に実行される。ステップS65、またはS67、またはS68を実行後、霧霞の除去動作を終了する。 In step S67, the second tone correction process described in the first embodiment, which is effective in removing mist from nearby objects, is executed. In step S68, based on the blending ratio calculated using equation (10), the image obtained by the first tone correction process described in the first embodiment and the image obtained by the second tone correction process are blended as shown in equation (11). This step S68 is executed when the distance to the object included in the region of interest is equal to or less than a first predetermined distance and equal to or greater than a second predetermined distance. After executing step S65, S67, or S68, the mist removal operation is terminated.

以上説明したように、第3の実施形態によれば、被写体の距離に応じて、効果的な霧霞除去処理を行うことが可能となる。 As described above, according to the third embodiment, it is possible to perform effective de-haze processing depending on the distance of the subject.

(第4の実施形態)

以下、本発明の画像処理装置の第4の実施形態であるデジタルカメラについて説明する。第4の実施形態における画像処理回路の構成は、図5に示した第3の実施形態の構成と同様である。ただし、本実施形態では、注目領域指定部22は、注目したい被写体を検出して、その被写体が存在する領域を自動で指定する。

Fourth Embodiment

A digital camera that is a fourth embodiment of an image processing device of the present invention will now be described. The configuration of the image processing circuit in the fourth embodiment is similar to that of the third embodiment shown in Fig. 5. However, in this embodiment, the attention

図7は、注目被写体を検出して、注目被写体までの距離に基づいて階調制御の方式を切り換えて霧霞の除去を行う動作を示すフローチャートである。 Figure 7 is a flowchart showing the operation of detecting a subject of interest and removing mist by switching the gradation control method based on the distance to the subject of interest.

霧霞除去処理のフローが開始されると、ステップS71では、撮像部101により取得された画像が画像処理部121に入力される。ステップS72では、注目したい被写体を検出し、その被写体が存在する領域を自動的に指定する。注目したい被写体を検出するためには、例えばユーザーが注目したい物体や人を指定する。そしてオブジェクト検出やAI技術等を用いて注目したい物体や人を検知し、それらを含む領域を指定する。あるいは動体検知などを用いて動いている物体や人を検知して、それらを含む領域を指定してもよい。

When the flow of the mist removal process is started, in step S71, the image captured by the

ステップS73では、距離情報取得部23は、指定された注目被写体を含む領域までの距離を測定する。注目領域までの距離は、レンズ部102に配置されたフォーカスレンズやズームレンズの制御情報等を用いて測定される。

In step S73, the distance

ステップS74では、全体制御演算部107は、注目被写体までの距離が第1の所定距離より遠いか否かを判別する。被写体までの距離が第1の所定距離より遠い場合には、ステップS75に進む。被写体までの距離が第1の所定距離より遠くない場合には、ステップS76に進む。

In step S74, the overall

ステップS75では、遠い被写体にかかっている霧霞を除去するのに効果的な第1の実施形態で説明した第1の階調補正処理を実行する。 In step S75, the first tone correction process described in the first embodiment is executed, which is effective in removing the haze that hangs over distant subjects.

ステップS76では、注目被写体までの距離が第2の所定距離より近いか否かを判別する。被写体までの距離が第2の所定距離より近い場合には、ステップS77に進む。被写体までの距離が第2の所定距離より近くない場合には、ステップS78に進む。 In step S76, it is determined whether the distance to the subject of interest is closer than a second predetermined distance. If the distance to the subject is closer than the second predetermined distance, the process proceeds to step S77. If the distance to the subject is not closer than the second predetermined distance, the process proceeds to step S78.

ステップS77では、近い被写体にかかっている霧霞を除去するのに効果的な第1の実施形態で説明した第2の階調補正処理を実行する。ステップS78では、第1の実施形態で説明した第1の階調補正処理で得られた画像と第2の階調補正処理で得られた画像の混合処理を行う。このステップS78は、注目被写体までの距離が第1の所定距離以下で、第2の所定距離以上の場合に実行される。ステップS75、またはS77、またはS78を実行後、霧霞の除去動作を終了する。 In step S77, the second tone correction process described in the first embodiment, which is effective in removing mist from nearby objects, is executed. In step S78, a blending process is performed on the image obtained by the first tone correction process described in the first embodiment and the image obtained by the second tone correction process. This step S78 is executed when the distance to the target object is equal to or less than a first predetermined distance and equal to or greater than a second predetermined distance. After executing step S75, S77, or S78, the mist removal operation is terminated.

以上説明したように、第4の実施形態によれば、検出された注目被写体の距離に応じて、効果的な霧霞除去処理を行うことが可能となる。 As described above, according to the fourth embodiment, it is possible to perform effective de-haze processing depending on the distance of the detected subject of interest.

(第5の実施形態)

以下、本発明の画像処理装置の第5の実施形態であるネットワークカメラについて説明する。第5の実施形態における画像処理回路の構成は、図10に示されるように、ネットワークカメラと、ネットワーク、クライアント装置から構成されている。

Fifth Embodiment

A network camera as a fifth embodiment of the image processing device of the present invention will be described below. The configuration of an image processing circuit in the fifth embodiment is made up of a network camera, a network, and a client device, as shown in FIG.

この第5の実施形態では、クライアント装置で実行される認識・解析アプリに応じて、霧霞除去の方式を切り替えて実行する。本実施形態では、人の顔の識別を行う顔識別アプリ、および、画面内に存在する被写体をカウントする人数カウントアプリを用いて例示的に説明する。 In this fifth embodiment, the defrosting method is switched depending on the recognition/analysis application executed on the client device. In this embodiment, an example will be described using a face recognition application that identifies human faces, and a people counting application that counts the number of subjects present on the screen.

それぞれのアプリの特徴として、顔識別アプリは、顔の細かな特徴をベースに識別を行うため、前述のハローノイズに代表されるアーチファクトの発生をなるべく抑える必要がある。一方、人数カウントアプリは、細かな構造をベースに検出を行う和ではなく、顔識別アプリと比較すると、より大雑把な構造、形状の検出を行い、人数をカウントする。そのため、人数カウントアプリを実行時に、霧霞を除去する場合、ハローノイズを抑えるよりは、霧霞の除去効果を優先した方が被写体の検出精度が向上する。なお、認識・解析アプリはこれに限るものではなく、例えば、人の動線をヒートマップ化する解析アプリ、特定人物を追尾するアプリ、被写体の属性を解析するアプリ等でもよい。 As for the characteristics of each app, face recognition apps perform recognition based on minute facial features, so it is necessary to suppress the occurrence of artifacts such as the aforementioned halo noise as much as possible. On the other hand, people counting apps do not perform detection based on minute structures, but rather detect rougher structures and shapes compared to face recognition apps and count people. Therefore, when removing fog when running a people counting app, the detection accuracy of the subject is improved by prioritizing the removal of fog rather than suppressing halo noise. Note that the recognition and analysis apps are not limited to these, and may be, for example, an analysis app that creates a heat map of people's movements, an app that tracks specific people, an app that analyzes the attributes of the subject, etc.

図11は、本実施形態において霧霞除去を行う動作を示すフローチャートである。 Figure 11 is a flowchart showing the operation of de-misting in this embodiment.

霧霞除去処理のフローが開始されると、ステップS111では、撮像部101により取得された画像が画像処理部121に入力される。ステップS112では、クライアント装置で実行される認識・解析アプリの情報を取得する。

When the flow of the mist removal process starts, in step S111, the image captured by the

ステップS113では、全体制御演算部107は、取得された認識・解析アプリの種類が顔識別アプリであるか否かを判別する。顔識別アプリである場合には、ステップS114に進む。顔識別アプリでない場合には、ステップS115に進む。

In step S113, the overall

ステップS114では、弊害を抑えつつ、霧霞を除去するのに効果的な第1の実施形態で説明した第2の階調補正処理を実行する。 In step S114, the second tone correction process described in the first embodiment is performed, which is effective in removing mist while minimizing adverse effects.

ステップS115では、取得された認識・解析アプリの種類が人数カウントアプリであるか否かを判別する。人数カウントアプリである場合には、ステップS116に進む。顔識別アプリでも人数カウントアプリでもない場合は、ステップS117に進む。 In step S115, it is determined whether the type of the acquired recognition/analysis app is a people counting app. If it is a people counting app, the process proceeds to step S116. If it is neither a face recognition app nor a people counting app, the process proceeds to step S117.

ステップS116では、遠い被写体にかかっている霧霞を除去するのに効果的な第1の実施形態で説明した第1の階調補正処理を実行する。 In step S116, the first tone correction process described in the first embodiment is executed, which is effective in removing the haze that hangs over distant subjects.

ステップS117では、第3の実施形態で説明したステップS68と同様に、エッジ情報に基づき、第1の階調補正処理で得られた画像と第2の階調補正処理で得られた画像の混合処理を行う。ステップS114、またはステップS116、またはステップS117を実行後、霧霞の除去動作を終了する。 In step S117, similar to step S68 described in the third embodiment, a blending process is performed on the image obtained in the first gradation correction process and the image obtained in the second gradation correction process based on the edge information. After step S114, step S116, or step S117 is performed, the mist removal operation is terminated.

以上説明したように、第5の実施形態によれば、クライアント装置で実行される認識・解析アプリに応じて、効果的な霧霞除去処理を行うことが可能となる。 As described above, according to the fifth embodiment, it is possible to perform effective fog and haze removal processing depending on the recognition and analysis application executed on the client device.

(他の実施形態)

また本発明は、上述の実施形態の1以上の機能を実現するプログラムを、ネットワーク又は記憶媒体を介してシステム又は装置に供給し、そのシステム又は装置のコンピュータにおける1つ以上のプロセッサーがプログラムを読出し実行する処理でも実現できる。また、1以上の機能を実現する回路(例えば、ASIC)によっても実現できる。

Other Embodiments

The present invention can also be realized by a process in which a program for realizing one or more of the functions of the above-described embodiments is supplied to a system or device via a network or a storage medium, and one or more processors in a computer of the system or device read and execute the program. The present invention can also be realized by a circuit (e.g., ASIC) for realizing one or more of the functions.

発明は上記実施形態に制限されるものではなく、発明の精神及び範囲から離脱することなく、様々な変更及び変形が可能である。従って、発明の範囲を公にするために請求項を添付する。 The invention is not limited to the above-described embodiment, and various modifications and variations are possible without departing from the spirit and scope of the invention. Therefore, the following claims are appended to disclose the scope of the invention.

100:デジタルカメラ、101:撮像部、102:レンズ部、104:撮像信号処理回路、107:全体制御演算部、120,121:画像処理回路 100: Digital camera, 101: Imaging unit, 102: Lens unit, 104: Imaging signal processing circuit, 107: Overall control and calculation unit, 120, 121: Image processing circuit

Claims (12)

前記画像データの領域毎のダークチャネル値を取得して透過率を推定し、階調を補正する第1の階調補正手段と、

トーンカーブを用いて前記画像データの階調を補正する第2の階調補正手段と、

どの階調補正手段を用いて階調補正を行うかを制御する制御手段と、

を備え、

前記制御手段は、前記第1の階調補正手段に、徐々に補正効果を得るように階調補正を行わせ、前記画像データにおける被写体の輪郭部に白領域が抽出された場合に、前記第1の階調補正手段による前記階調補正を停止させることを特徴とする画像処理装置。 An acquisition means for acquiring image data;

a first gradation correction means for acquiring a dark channel value for each region of the image data, estimating transmittance, and correcting gradation;

a second gradation correction means for correcting the gradation of the image data using a tone curve;

A control means for controlling which gradation correction means is to be used for gradation correction;

Equipped with

The image processing device is characterized in that the control means causes the first gradation correction means to perform gradation correction so as to gradually obtain a correction effect, and when a white area is extracted at the contour of a subject in the image data, the control means stops the gradation correction by the first gradation correction means .

6. The image processing apparatus according to claim 2, wherein the control means causes the second tone correction means to perform the first-stage tone correction.

請求項1乃至8のいずれか1項に記載の画像処理装置と、

を備えることを特徴とする撮像装置。 An imaging means for imaging a subject;

An image processing device according to any one of claims 1 to 8 ,

An imaging device comprising:

前記画像データの領域毎のダークチャネル値を取得して透過率を推定し、階調を補正する第1の階調補正工程と、

トーンカーブを用いて前記画像データの階調を補正する第2の階調補正工程と、

どの階調補正工程を用いて階調補正を行うかを制御する制御工程と、

を有し、

前記制御工程では、前記第1の階調補正工程において徐々に補正効果を得るように階調補正を行わせ、前記画像データにおける被写体の輪郭部に白領域が抽出された場合に、前記第1の階調補正工程における前記階調補正を停止させることを特徴とする画像処理方法。 An acquisition step of acquiring image data;

a first gradation correction step of acquiring a dark channel value for each region of the image data, estimating transmittance, and correcting gradation;

a second gradation correction step of correcting the gradation of the image data using a tone curve;

a control step of controlling which gradation correction step is to be used for gradation correction;

having

The image processing method is characterized in that, in the control step, gradation correction is performed in the first gradation correction step so as to gradually obtain a correction effect, and when a white area is extracted at the contour of the subject in the image data, the gradation correction in the first gradation correction step is stopped .

Priority Applications (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| US16/881,425 US11301974B2 (en) | 2019-05-27 | 2020-05-22 | Image processing apparatus, image processing method, image capturing apparatus, and storage medium |

| EP20176632.6A EP3745348B1 (en) | 2019-05-27 | 2020-05-26 | Image processing for removing fog or haze in images |

| CN202010460486.2A CN112001853A (en) | 2019-05-27 | 2020-05-27 | Image processing apparatus, image processing method, image capturing apparatus, and storage medium |

Applications Claiming Priority (2)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2019098808 | 2019-05-27 | ||

| JP2019098808 | 2019-05-27 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2020195127A JP2020195127A (en) | 2020-12-03 |

| JP7510258B2 true JP7510258B2 (en) | 2024-07-03 |

Family

ID=73548076

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2020028363A Active JP7510258B2 (en) | 2019-05-27 | 2020-02-21 | Image processing device, image processing method, imaging device, program, and storage medium |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP7510258B2 (en) |

Citations (9)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2010062920A (en) | 2008-09-04 | 2010-03-18 | Ricoh Co Ltd | Image processor, image processing method, program, and recording medium |

| CN103700079A (en) | 2013-12-17 | 2014-04-02 | 中国科学院深圳先进技术研究院 | Image defogging method and device |

| CN104463816A (en) | 2014-12-02 | 2015-03-25 | 苏州大学 | Image processing method and device |

| CN105574830A (en) | 2016-02-04 | 2016-05-11 | 沈阳工业大学 | Low-quality image enhancement method under extreme weather conditions |

| CN106548463A (en) | 2016-10-28 | 2017-03-29 | 大连理工大学 | Based on dark and the sea fog image automatic defogging method and system of Retinex |

| CN107277299A (en) | 2017-07-27 | 2017-10-20 | 广东欧珀移动通信有限公司 | Image processing method, device, mobile terminal and computer-readable recording medium |

| CN107481202A (en) | 2017-08-14 | 2017-12-15 | 深圳市华星光电半导体显示技术有限公司 | A kind of method of dynamic range of images enhancing |

| CN107767353A (en) | 2017-12-04 | 2018-03-06 | 河南工业大学 | A kind of adapting to image defogging method based on definition evaluation |

| WO2019064825A1 (en) | 2017-09-27 | 2019-04-04 | ソニー株式会社 | Information processing device, information processing method, control device, and image processing device |

-

2020

- 2020-02-21 JP JP2020028363A patent/JP7510258B2/en active Active

Patent Citations (9)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2010062920A (en) | 2008-09-04 | 2010-03-18 | Ricoh Co Ltd | Image processor, image processing method, program, and recording medium |

| CN103700079A (en) | 2013-12-17 | 2014-04-02 | 中国科学院深圳先进技术研究院 | Image defogging method and device |

| CN104463816A (en) | 2014-12-02 | 2015-03-25 | 苏州大学 | Image processing method and device |

| CN105574830A (en) | 2016-02-04 | 2016-05-11 | 沈阳工业大学 | Low-quality image enhancement method under extreme weather conditions |

| CN106548463A (en) | 2016-10-28 | 2017-03-29 | 大连理工大学 | Based on dark and the sea fog image automatic defogging method and system of Retinex |

| CN107277299A (en) | 2017-07-27 | 2017-10-20 | 广东欧珀移动通信有限公司 | Image processing method, device, mobile terminal and computer-readable recording medium |

| CN107481202A (en) | 2017-08-14 | 2017-12-15 | 深圳市华星光电半导体显示技术有限公司 | A kind of method of dynamic range of images enhancing |

| WO2019064825A1 (en) | 2017-09-27 | 2019-04-04 | ソニー株式会社 | Information processing device, information processing method, control device, and image processing device |

| CN107767353A (en) | 2017-12-04 | 2018-03-06 | 河南工业大学 | A kind of adapting to image defogging method based on definition evaluation |

Also Published As

| Publication number | Publication date |

|---|---|

| JP2020195127A (en) | 2020-12-03 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN111402135B (en) | Image processing method, device, electronic equipment and computer readable storage medium | |

| CN111028189B (en) | Image processing method, device, storage medium and electronic equipment | |

| JP4748244B2 (en) | Image selection apparatus, image selection method, and program | |

| KR101662846B1 (en) | Apparatus and method for generating bokeh in out-of-focus shooting | |

| KR101590868B1 (en) | A image processing method an image processing apparatus a digital photographing apparatus and a computer-readable storage medium for correcting skin color | |

| US11301974B2 (en) | Image processing apparatus, image processing method, image capturing apparatus, and storage medium | |

| JP6559229B2 (en) | Image processing apparatus, imaging apparatus, image processing method, and storage medium storing image processing program of image processing apparatus | |

| KR20200023651A (en) | Preview photo blurring method and apparatus and storage medium | |

| TWI462054B (en) | Estimation Method of Image Vagueness and Evaluation Method of Image Quality | |

| JP2017138647A (en) | Image processing device, image processing method, video photographing apparatus, video recording reproduction apparatus, program and recording medium | |

| JP6352547B2 (en) | Image processing apparatus and image processing method | |

| CN108259770B (en) | Image processing method, image processing device, storage medium and electronic equipment | |

| US20200389573A1 (en) | Image processing system, image processing method and storage medium | |

| CN112767392A (en) | Image definition determining method, device, equipment and storage medium | |

| US20180115745A1 (en) | Information processing device, information processing method, program, and recording medium | |

| JP2004310475A (en) | Image processor, cellular phone for performing image processing, and image processing program | |

| US9338354B2 (en) | Motion blur estimation and restoration using light trails | |

| JP2009123081A (en) | Face detection method and photographing apparatus | |

| WO2013114803A1 (en) | Image processing device, image processing method therefor, computer program, and image processing system | |

| CN116263942A (en) | Method for adjusting image contrast, storage medium and computer program product | |

| JP7510258B2 (en) | Image processing device, image processing method, imaging device, program, and storage medium | |

| CN113379631B (en) | Image defogging method and device | |

| EP4090006A2 (en) | Image signal processing based on virtual superimposition | |

| CN104112266B (en) | Image edge blurring detecting method and device | |

| JP5093540B2 (en) | Eye position detection method and detection system |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| RD01 | Notification of change of attorney |

Free format text: JAPANESE INTERMEDIATE CODE: A7421 Effective date: 20210103 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20210113 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20230213 |

|

| A977 | Report on retrieval |

Free format text: JAPANESE INTERMEDIATE CODE: A971007 Effective date: 20240122 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20240213 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20240409 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20240524 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20240621 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 7510258 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |