JP5924295B2 - Parameter estimation apparatus, parameter estimation program, device determination system, and device determination program - Google Patents

Parameter estimation apparatus, parameter estimation program, device determination system, and device determination program Download PDFInfo

- Publication number

- JP5924295B2 JP5924295B2 JP2013049093A JP2013049093A JP5924295B2 JP 5924295 B2 JP5924295 B2 JP 5924295B2 JP 2013049093 A JP2013049093 A JP 2013049093A JP 2013049093 A JP2013049093 A JP 2013049093A JP 5924295 B2 JP5924295 B2 JP 5924295B2

- Authority

- JP

- Japan

- Prior art keywords

- microphone

- camera

- information

- coordinate system

- parameter

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Landscapes

- Studio Devices (AREA)

- Obtaining Desirable Characteristics In Audible-Bandwidth Transducers (AREA)

- Circuit For Audible Band Transducer (AREA)

- Measurement Of Velocity Or Position Using Acoustic Or Ultrasonic Waves (AREA)

Description

本発明は、パラメータ推定装置、パラメータ推定プログラム、機器決定システム及び機器決定プログラムに関し、例えば、空間的に配置された撮像機器や収音機器のパラメータをキャリブレーションするシステム及び方法に適用し得るものである。 The present invention, parameter estimation device, parameter estimation program relates appliance determination system and device determination program, for example, may apply the parameters of the imaging device or sound receiving device that is spatially arranged in a system and method for calibration Li ablation Is.

例えば、空間的に複数のカメラや複数のマイク等が任意に配置され、カメラが撮像した映像(以下、静止画像、動画像等を含むものを映像と呼ぶ)の情報や、マイクが収音した音響(以下、音、音声、音響を含むものを音響と呼ぶ)等の情報を用いて、その空間状況を認識する技術がある。 For example, spatially a plurality of cameras, microphones, etc. are arbitrarily arranged, and information of video captured by the camera (hereinafter referred to as video including still images, moving images, etc.) and microphones have collected sound. There is a technique for recognizing the spatial state using information such as sound (hereinafter, sound, voice, and sound including sound are referred to as sound).

空間内における任意の場所(位置座標)の状況を知るためには、その場所を撮像するカメラやその場所の音響を収音するマイクを指定することが必要となる。しかし、任意に配置されているカメラやマイク等の機器の位置(位置座標)や向きを認識することは極めて難しい。従来、空間内の指定した位置(位置座標)の状況を認識するために、特許文献1〜特許文献3、非特許文献1等のような技術がある。 In order to know the situation at an arbitrary place (positional coordinate) in the space, it is necessary to designate a camera that picks up the place and a microphone that picks up the sound at that place. However, it is extremely difficult to recognize the position (positional coordinates) and orientation of devices such as cameras and microphones that are arbitrarily arranged. Conventionally, there are techniques such as Patent Document 1 to Patent Document 3, Non-Patent Document 1 and the like for recognizing the situation of a designated position (position coordinates) in a space.

特許文献1では、例えば、遠隔地において、所定の画像を表示するディスプレイをカメラで撮影し、そのカメラで撮影した画像において被制御装置の表示領域を同定するなど技術が記載されており、同定された位置を指定することで、指定した位置の装置を指示できるというものである。 In Patent Document 1, for example, in a remote place, a technique is described in which a display that displays a predetermined image is captured by a camera, and a display area of a controlled device is identified in the image captured by the camera. By specifying the specified position, the device at the specified position can be indicated.

特許文献2の記載技術は、あらかじめ設置位置や向き等のカメラパラメータが設定された複数のカメラを遠隔地に配置しておき、その遠隔地の様子を表示する地図上の1点を指定すると、その指定点を撮影しているカメラが選択され、そのカメラが写し出す映像を見ることができるというものである。

In the technology described in

特許文献3では、カメラの相互の位置や向きの相対関係を自動的に決定する技術が記載されている。 Patent Document 3 describes a technique for automatically determining the relative positions and orientations of cameras.

しかしながら、上述した従来技術は、以下のような問題が生じ得る。 However, the above-described conventional technology may cause the following problems.

特許文献1の記載技術により位置が指定できるのは、キャリブレーションされた限定的な対象物である。それら限定的な対象物は、特許文献1では被制御装置と呼ばれている。被制御装置は、再帰性反射素材を用いて外部からの光を反射するもの、所定の光や音や電磁波のうちの少なくともいずれかを発するもの、あらかじめ形状がわかっているもの、所定の画像を表示するもの等のように、その性質があらかじめ判っている必要がある。 The position can be designated by the technique described in Patent Document 1 is a calibrated limited object. These limited objects are called controlled devices in Patent Document 1. The controlled device uses a retroreflective material to reflect light from the outside, emits at least one of predetermined light, sound, and electromagnetic waves, has a known shape, and displays a predetermined image. It must be known in advance, such as what is displayed.

しかし、特許文献1に記載の方法で指定可能な場所は、上述の被制御装置の同定された場所に限られ、遠隔地の任意の場所(位置座標)を指定して、その場所に関する情報を取得することができないという問題がある。 However, the location that can be specified by the method described in Patent Document 1 is limited to the identified location of the controlled device described above, and an arbitrary location (positional coordinate) in a remote location is designated and information regarding the location is obtained. There is a problem that it cannot be acquired.

特許文献2の記載技術は、複数のカメラ毎にカメラの位置座標及びカメラの向きをテーブルにあらかじめ設定しておく必要がある。また、特許文献2の記載技術は、遠隔地の映像情報を取得することはできるが、音響情報を取得することはできない。音響情報も取得するためには、遠隔地にカメラだけでなく、複数のマイクを配置し、そのマイクの配置位置や収音範囲などの情報をあらかじめ設定し、カメラやマイクの配置情報を事前に用意することで、地図上の座標指定に基づき、必要なカメラやマイクを選択し、カメラやマイクからの情報に基づいて指定した場所に関する情報を取得するシステムを考えられる。このような方法によれば、遠隔地の任意の場所の座標を指定し、その場所を撮影しているカメラや、その場所の音響を収音しているマイクを選択することが可能となり得る。

The technique described in

しかし、特許文献2の記載技術を適用するために、カメラやマイクが遠隔地のどの場所に設置されているか、またどの向きに設置されているかといった設置の位置座標と向きに関する情報が予め判っている必要がある。これらカメラやマイクの設置に係る位置座標及び向きの情報は、例えば、カメラやマイクを遠隔地に設置する際に、全部の機器の設置場所の座標を物差しで計り、またその方向を分度器などで測定することで取得するという方法が考えられる。このような作業は非常に煩雑であり、また、手作業で行うため、作業に誤りが生じ得るという問題がある。特に、遠隔地の複数の場所から情報を取得するために、それぞれの場所に多数の機器を配置する場合には、手作業による誤りの入る可能性が高くなり、実用的では無い。

However, in order to apply the technology described in

また、特許文献2の記載技術は、遠隔地におけるカメラの配置に関して、あらかじめ定めた情報を用いるか、又は位置のわかっているカメラの撮影している映像を見ながらひとつずつ遠隔操作で向きだけを変えて、適切な向きになった時点でその向きの情報を設定情報として記憶させるということを述べている。この場合、カメラの個数が非常に多くなると操作が非常に煩雑になる。

In addition, the technology described in

特許文献3の記載技術によれば、例えば2個のカメラのうち、一方のカメラの位置座標や向きがわかっていれば、他方のカメラの位置座標や向きを自動的に求めることができる。多数のカメラが配置されている場合でも、上記の操作を他のカメラについて繰り返し行うことで、すべてのカメラの位置座標や向きを求めることができる。そのため、カメラの位置座標や向きを収集するための煩雑さが低減し、誤りも少なくなると考えられる。 According to the technique described in Patent Document 3, for example, if the position coordinates and orientation of one of two cameras are known, the position coordinates and orientation of the other camera can be automatically obtained. Even when a large number of cameras are arranged, the position coordinates and orientations of all the cameras can be obtained by repeating the above operation for other cameras. Therefore, it is considered that the complexity for collecting the position coordinates and orientation of the camera is reduced and errors are reduced.

しかし、特許文献3の記載技術は、マイクの絶対的な位置座標や向きの収集する手段若しくはカメラとマイクとの間の相対関係を決定する手段については言及されていないため、マイクの位置や方向の情報を取得するのは人手に頼る必要があり、非常に煩雑かつ誤りが生じ得る。 However, since the technique described in Patent Document 3 does not mention a means for collecting the absolute position coordinates and orientation of the microphone or a means for determining a relative relationship between the camera and the microphone, the position and direction of the microphone are not described. It is necessary to rely on human resources to obtain the information, which can be very complicated and error-prone.

そのため、空間的に配置されるカメラやマイクのグローバル座標上の位置や向きを調べる際に、その作業の煩雑さや手作業による誤りを回避することができるパラメータ推定装置、パラメータ推定プログラム、機器決定システム及び機器決定プログラムが求められている。 Therefore, a parameter estimation device, a parameter estimation program, and a device determination system that can avoid complicated operations and errors due to manual operations when checking the position and orientation of spatially arranged cameras and microphones on global coordinates And a device determination program is needed.

かかる課題を解決するために、第1の本発明は、複数のカメラによって撮像された、空間配置された位置較正器を含む映像情報を用いて、グローバル座標系における1又は複数のマイクロホンの位置情報及び向きに関するパラメータを推定するパラメータ推定装置であって、(1)グローバル座標系における複数のカメラの位置情報及び向きと、複数のカメラによって撮像された位置較正器を含む映像情報とに基づいて、グローバル座標系における位置較正器の位置情報を測定する基準点測定手段と、(2)グローバル座標系において基準点とする位置較正器の位置情報と、音源とする位置較正器から発せられた音響の1又は複数のマイクロホンのそれぞれにおける相対的な到来方向を示す到来方向情報とを取得する情報取得手段と、(3)グローバル座標系での音源としての位置較正器の位置情報と、各マイクロホンにおける到来方向情報とに基づいて、各マイクロホンの相対的な位置情報及び向きに関するパラメータを推定するパラメータ推定手段とを備えることを特徴とするパラメータ推定装置である。 In order to solve such a problem, the first aspect of the present invention provides position information of one or a plurality of microphones in a global coordinate system using image information including a position calibrator arranged in space, which is imaged by a plurality of cameras. And a parameter estimation device for estimating a parameter related to an orientation, (1) based on position information and orientation of a plurality of cameras in a global coordinate system and video information including a position calibrator imaged by the plurality of cameras, a reference point measuring unit for measuring the position information of the position calibrator in the global coordinate system, (2) and the position information of the position calibrator as a reference point in the global coordinate system, sound emitted from a position calibrator to the sound source information acquisition means for acquiring the arrival direction information indicating a relative arrival direction of each of the one or more microphones, (3 ) Provided with parameter estimation means for estimating parameters related to the relative position information and direction of each microphone based on the position information of the position calibrator as a sound source in the global coordinate system and the arrival direction information of each microphone. Is a parameter estimation device characterized by

第2の本発明は、複数のカメラによって撮像された、空間配置された位置較正器を含む映像情報を用いて、グローバル座標系における1又は複数のマイクロホンの位置情報及び向きに関するパラメータを推定するパラメータ推定プログラムであって、コンピュータを、(1)グローバル座標系における複数のカメラの位置情報及び向きと、複数のカメラによって撮像された位置較正器を含む映像情報とに基づいて、グローバル座標系における位置較正器の位置情報を測定する基準点測定手段、(2)グローバル座標系において基準点とする位置較正器の位置情報と、音源とする位置較正器から発せられた音響の1又は複数のマイクロホンのそれぞれにおける相対的な到来方向を示す到来方向情報とを取得する情報取得手段、(3)グローバル座標系での音源としての位置較正器の位置情報と、各マイクロホンにおける到来方向情報とに基づいて、各マイクロホンのグローバル座標系での位置情報及び向きに関するパラメータを推定するパラメータ推定手段として機能させることを特徴とするパラメータ推定プログラムである。 The second aspect of the present invention is a parameter for estimating parameters related to position information and orientation of one or a plurality of microphones in a global coordinate system using image information including a position calibrator arranged in a space and captured by a plurality of cameras. An estimation program comprising: (1) a position in a global coordinate system based on (1) position information and orientation of a plurality of cameras in the global coordinate system and video information including a position calibrator imaged by the plurality of cameras; reference point measuring unit for measuring the position information of the calibrator, (2) and the position information of the position calibrator as a reference point in the global coordinate system, the sound emitted from a position calibrator to the sound source 1 or more microphones information obtaining means for obtaining an arrival direction information indicating a relative DOA in each, (3) glow The position information of the position calibrator serving as the sound source of Le coordinate system, based on the arrival direction information at each microphone to function as a parameter estimation means for estimating parameters related to the position information and orientation in the global coordinate system of each microphone This is a parameter estimation program.

第3の本発明は、(1)第1の本発明に係るパラメータ推定装置としてのマイクパラメータ推定手段と、(2)少なくとも、マイクパラメータ推定手段により推定された1又は複数のマイクロホンの位置情報及び向きに関するパラメータを保持するマイクパラメータ保持手段と、(3)グローバル座標系で指定された位置情報を、各マイクロホンのマイク座標系における位置情報に変換して、指定された位置の情報を収集するマイクロホンを選択するマイクロホン選択手段とを備えることを特徴とする機器決定システムである。 According to a third aspect of the present invention, (1) microphone parameter estimation means as a parameter estimation apparatus according to the first aspect of the present invention, and (2) position information of one or more microphones estimated by at least the microphone parameter estimation means, and A microphone parameter holding means for holding a parameter relating to the orientation; and (3) a microphone that converts position information specified in the global coordinate system into position information in the microphone coordinate system of each microphone and collects information on the specified position. A device selection system comprising: a microphone selection means for selecting

第4の本発明は、コンピュータを、(1)第2の本発明に係るパラメータ推定プログラムとして機能させるマイクパラメータ推定手段、(2)少なくとも、マイクパラメータ推定手段により推定された1又は複数のマイクロホンの位置及び向きに関するパラメータを保持するマイクパラメータ保持手段、(3)グローバル座標系で指定された位置情報を、各マイクロホンのマイク座標系における位置情報に変換して、指定された位置の情報を収集するマイクロホンを選択するマイクロホン選択手段として機能させることを特徴とする機器決定プログラムである。 According to a fourth aspect of the present invention, there is provided: (1) a microphone parameter estimation unit that causes a computer to function as a parameter estimation program according to the second aspect of the present invention; (2) at least one or more microphones estimated by the microphone parameter estimation unit; Microphone parameter holding means for holding parameters relating to position and orientation, (3) converting the position information specified in the global coordinate system into position information in the microphone coordinate system of each microphone, and collecting information on the specified position A device determination program that functions as a microphone selection unit that selects a microphone.

本発明によれば、空間的に配置されるカメラやマイクのグローバル座標上の位置や向きを調べる際に、その作業の煩雑さや手作業による誤りを回避することができる。 According to the present invention, it is possible to avoid complicated operations and errors due to manual work when examining the positions and orientations of spatially arranged cameras and microphones on global coordinates.

(A)主たる実施形態

以下では、本発明のパラメータ推定装置、パラメータ推定プログラム、機器決定システム及び機器決定プログラムの主たる実施形態を、図面を参照しながら詳細に説明する。

(A) Main Embodiments Hereinafter, main embodiments of a parameter estimation device, a parameter estimation program, a device determination system, and a device determination program according to the present invention will be described in detail with reference to the drawings.

(A−1)実施形態の構成

図1は、実施形態に係るキャリブレーションシステム100の全体構成を示す構成図である。

(A-1) Configuration of Embodiment FIG. 1 is a configuration diagram illustrating an overall configuration of a

図1において、実施形態に係るキャリブレーションシステム100は、複数のカメラ101−1〜101−n(nは整数)、複数のマイクロホン(以下、マイクと呼ぶ)102−1〜102−m(mは整数)、パラメータ推定器103、パラメータ保持器104、視聴点指示器105を有する。

In FIG. 1, a

キャリブレーションシステム100は、音・映像位置較正器200を利用して、空間上の座標系(以下、グローバル座標系と呼ぶ)でのカメラ101−i(1≦i≦n)及びマイク102−j(1≦j≦m)の位置座標及び向きに関する情報(パラメータ)を推定して保持しておき、空間内の任意の場所を指定し、その指定された場所を撮像するカメラ101−i及びその指定された場所の音響を収音するマイク102−jを決定して、その指定された場所の画像及び音響を取得するものである。

The

カメラ101−iは、空間内において任意の位置に配置されるものであり、撮像した撮像した撮像画像情報を、接続しているパラメータ推定器103に与えるものである。後述するパラメータ推定部103が、グローバル座標系におけるカメラ101−iの位置座標及び向きに関する情報を推定する際、カメラ101−iは、カメラ座標系で撮像した音・映像位置推定器200を含む撮像画像情報をパラメータ推定器103に与える。

The camera 101-i is arranged at an arbitrary position in the space, and gives captured image information to the

マイク102−jは、空間内において任意の位置に配置されるものであり、収音した音響情報を、接続しているパラメータ推定部103に与えるものである。

The microphone 102-j is arranged at an arbitrary position in the space, and gives the collected sound information to the connected

また、マイク102−jは、例えばマイクロホンアレーなどのように、音源の到来方向を特定する機能を有するものである。なお、後述するパラメータ推定部103が、グローバル座標系におけるマイク102−iの位置座標及び向きに関する情報を推定する際、マイク102−iは、後述する音・映像位置推定器200が発した音響を収音し、マイク座標系での音源の座標を含む音響情報をパラメータ推定器103に与える。

The microphone 102-j has a function of specifying the direction of arrival of a sound source, such as a microphone array. Note that when the

パラメータ推定器103は、グローバル座標系におけるカメラ101−iの位置座標及び向きに関する情報を、他のカメラ101−iとの相対的な位置関係に基づいて推定するものである。また、パラメータ推定器103は、グローバル座標系におけるマイク102−jの位置座標及び向きに関する情報を、他のマイク102−jとの相対的な位置関係に基づいて推定するものである。パラメータ推定器103は、推定したグローバル座標系でのカメラ101−i及びマイク102−jの位置座標及び向きに関する情報をパラメータ保持器104に保存するものである。

The

図2は、パラメータ推定器103の内部構成を示す内部構成図である。パラメータ推定器103は、例えば、CPU、ROM、RAM、EEPROM、入出力インタフェース等を有するものであり、CPUがROMに格納される処理プログラムを実行することにより、所定の処理を実現することができる。

FIG. 2 is an internal configuration diagram showing an internal configuration of the

図2において、パラメータ推定器103は、大別して、カメラパラメータ推定部310と、マイクパラメータ推定部320とを有する。

In FIG. 2, the

カメラパラメータ推定部310は、カメラ101−iからカメラ座標系での音・映像位置較正器200を含む撮像画像情報を取得し、各カメラ101−iの撮像画像情報に基づいて、複数のカメラ101−iの相対的な関係から各カメラ101−iの位置座標及び向きに関する情報を推定するものである。カメラパラメータ推定部310は、その機能部として、カメラ位置座標・向き情報推定部311、カメラ撮影範囲情報取得部312、カメラパラメータ保存部313を有する。なお、カメラパラメータ推定部310によるカメラ101−iの位置座標及び向きの推定処理の詳細な説明は動作の項で説明する。

The camera

マイクパラメータ推定部320は、マイク102−jからマイク座標系での音・映像位置較正器200の位置座標を含む音響情報を取得し、各カメラ101−iの撮像画像情報とパラメータ保持器104に保存されているカメラパラメータからグローバル座標系での音・映像位置較正器200の位置座標を取得し、取得したマイク座標系での音・映像位置較正器200の位置座標を含む音響情報と取得したグローバル座標系での音・映像位置較正器200の位置座標から、グローバル座標系での各マイク102−jの位置座標及び向きに関する情報を推定するものである。マイクパラメータ推定部320は、その機能部として、マイク位置座標・向き情報推定部321、マイク収音範囲情報取得部322、マイクパラメータ保存部323を有する。なお、マイクパラメータ推定部320によるマイク102−jの位置座標及ぶ向きの推定処理の詳細な説明は動作の項で説明する。

The microphone

パラメータ保持器104は、パラメータ推定器103により推定されたカメラ101−iのカメラパラメータ及びマイク102−jのマイクパラメータを保持するものである。

The

視聴点指示器105は、カメラ101−i及びマイク102−jが配置されている空間において指定された場所(位置座標)の映像を撮像するカメラ101−i及び音響を収音するマイク102−jを選定するものである。

The

図3は、視聴点指示器105の内部構成を示す内部構成図である。視聴点指示器105は、例えば、CPU、ROM、RAM、EEPROM、入出力インタフェース等を有するものであり、CPUがROMに格納される処理プログラムを実行することにより、所定の処理を実現することができる。

FIG. 3 is an internal configuration diagram showing an internal configuration of the

図3において、視聴点指示器105は、視聴点指定取得部401、カメラ選定部402、マイク選定部403を有する。なお、視聴点指示器105によるカメラ101−i及びマイク102−jの選定方法の詳細な説明は動作の項で詳細に説明する。

In FIG. 3, the

音・映像位置較正器200は、カメラ101−i及びマイク102−jのグローバル座標系での位置座標及び向きに関する情報を推定する際に、その基準マーク又は音源とするものである。

The sound /

図4は、音・映像位置較正器200の外観構成を示す外観図である。図4に示すように、音・映像位置較正器200は、映像提示部201と、音響発生部202とを有する。

FIG. 4 is an external view showing an external configuration of the sound /

映像提示部201は、例えば、予め決められた映像を表示したり、又は光の点灯又は光の点滅をしたりするものである。映像提示部201が提示した映像や光の明滅等をカメラ101−iが撮像し、その撮像画像情報がパラメータ推定器103に与えられる。

The

音響発生部202は、例えば、予め決められた周波数の音の出力、予め決められた音階パターンの出力等を行うものである。音響発生部202が発した音響をマイク102−jが収音する。

The

(A−2)実施形態の動作

次に、実施形態に係るキャリブレーションシステム100における処理の動作を、図面を参照しながら詳細に説明する。

(A-2) Operation of Embodiment Next, a processing operation in the

(A−2−1)カメラ位置座標及び向きに関する情報の説明

まず、パラメータ推定器103のカメラパラメータ推定部310によるカメラの位置座標及び向きに関する情報について説明する。なおカメラパラメータ推定部310においてカメラパラメータをパラメータ保持器104に保持する動作はカメラパラメータ保存部313によって行われる。

(A-2-1) Description of Information on Camera Position Coordinate and Orientation First, information on the camera position coordinate and orientation by the camera

ここでは、グローバル座標系の基準点Vが、カメラ101−iに撮像素子上の画素位置に映っている状況を考える。 Here, a situation is considered in which the reference point V of the global coordinate system is reflected by the camera 101-i at the pixel position on the image sensor.

基準点Vのグローバル座標系での位置座標が(gX,gY,gZ)Tであるとし、カメラ101−iの撮像素子上の画素位置が(CP_iu,CP_iν)であるとする。 Assume that the position coordinate of the reference point V in the global coordinate system is (gX, gY, gZ) T, and the pixel position on the image sensor of the camera 101-i is (CP_iu, CP_iv).

グローバル座標系の基準点Vの位置座標とカメラ座標系の基準点Vの位置座標との関係は、一般に射影変換で表すことができ、式(1)のような関係にある。

ここで、wは媒介変数である。C_iRgはカメラ101−iについて空間での回転を表す3×3行列である。なお、表記上の制限のため、R、Aの表記は式(1)の表記と異なる点に留意されたい。 Here, w is a parameter. C_iRg is a 3 × 3 matrix representing rotation in space for the camera 101-i. It should be noted that the notation of R and A is different from the notation of formula (1) due to restrictions on notation.

C_iTは、カメラ101−iについての空間内での平行移動を表す3次元ベクトルである。(C_iRg|C_iT)は、3行×4列の行列となる。 C_iT is a three-dimensional vector that represents translation in space for the camera 101-i. (C_iRg | C_iT) is a 3 × 4 matrix.

ここで、CP_iAC_i(C_iRg|C_iT)は、カメラ101−iのカメラパラメータと呼ばれるものである。CP_iAC_iは、カメラ101−iの内部パラメータと呼ばれ、カメラ101−i自体の光学系の特性を表すものである。(C_iRg|C_iT)は、カメラ101−iの外部パラメータと呼ばれるものである。特に、C_iRgはグローバル座標系でのカメラ101−iの向きを表し、C_iTはカメラ101−iの位置座標を表すものである。 Here, CP_iAC_i (C_iRg | C_iT) is called a camera parameter of the camera 101-i. CP_iAC_i is called an internal parameter of the camera 101-i and represents the characteristic of the optical system of the camera 101-i itself. (C_iRg | C_iT) is called an external parameter of the camera 101-i. In particular, C_iRg represents the orientation of the camera 101-i in the global coordinate system, and C_iT represents the position coordinate of the camera 101-i.

グローバル座標系の基準点Vとそれに対応する撮像素子上の画素位置との組が複数個ある場合、カメラパラメータCP_iAC_i,C_iRg,C_iT,を推定する問題は、PnP(Perspective n−Point Problem)問題と呼ばれている。一般的にPnP問題は、6点以上の基準点とそれに対応する画素位置が分かれば、最小二乗法によってカメラパラメータを推定することができる(非特許文献1参照)。 When there are a plurality of pairs of the reference point V of the global coordinate system and the corresponding pixel position on the image sensor, the problem of estimating the camera parameters CP_iAC_i, C_iRg, C_iT is a PnP (Perspective n-Point Problem) problem. being called. Generally, in the PnP problem, if six or more reference points and corresponding pixel positions are known, camera parameters can be estimated by the least square method (see Non-Patent Document 1).

なお、カメラ101−iのレンズが無歪であれば、カメラパラメータCP_iAC_iは、式(2)と表すことができる。

ここで、(Cx,Cy)Tは、撮影画像の画像中心座標である。fxはx軸方向のスケール変換を表し、fyはy軸方向のスケール変換を表す。 Here, (Cx, Cy) T is the image center coordinates of the captured image. fx represents scale conversion in the x-axis direction, and fy represents scale conversion in the y-axis direction.

(A−2−2)カメラ及びマイクの位置座標及び向きの推定手順

図5は、パラメータ推定器103によるカメラ101−i及びマイク102−jの位置座標及び向きの推定処理を示すフローチャートである。

(A-2-2) Camera and Microphone Position Coordinate and Orientation Estimation Procedure FIG. 5 is a flowchart showing the position coordinate and orientation estimation processing of the camera 101-i and microphone 102-j by the

図5において、パラメータ推定器103は、グローバル座標系におけるカメラ101−iの位置座標及び向きを推定し(S100)、次に、グローバル座標系におけるマイク102−jの位置座標及び向きを推定する(S200)。

In FIG. 5, the

(A−2−3)カメラの位置座標及び向きの推定手順

図6は、パラメータ推定器103のカメラパラメータ推定部310によるカメラ101−iの位置座標及び向きの推定処理を説明するフローチャートである。

(A-2-3) Camera Position Coordinate and Orientation Estimation Procedure FIG. 6 is a flowchart for explaining the position coordinate and orientation estimation processing of the camera 101-i by the camera

カメラパラメータ推定部310は、カメラ位置座標・向き情報推定部311によって、空間におけるカメラ101−iの位置座標及び向きを推定する。この推定方法は、種々の方法を広く適用することができるが、例えば、複数のカメラ101−iの間の相対的な関係に基づいてそれぞれの位置情報及び向きを推定する方法を適用することができる。例えば、この相対的な関係に基づいてカメラ101−iの位置情報及び向きを推定する方法の一例としては、特許文献3に記載される技術を適用することができる。

The camera

図6を用いて、カメラ位置座標・向き情報推定部311によるカメラ101−iの位置座標及び向きを推定する詳細な手順を説明する。

A detailed procedure for estimating the position coordinates and orientation of the camera 101-i by the camera position coordinate / orientation

まず、空間に配置されるカメラ101−1〜101−nのうち、少なくとも1台のカメラ101−iのグローバル座標系での位置座標及び向きを測定しておく。すなわち、少なくとも1台のカメラ101−iの位置座標及び向きに関する情報として、当該カメラ101−iの外部パラメータC_iRgおよびC_iTを測定しておく。 First, the position coordinate and direction in the global coordinate system of at least one camera 101-i among the cameras 101-1 to 101-n arranged in the space are measured in advance. That is, the external parameters C_iRg and C_iT of the camera 101-i are measured as information regarding the position coordinates and orientation of at least one camera 101-i.

なお、ここでは、カメラ101−iの内部パラメータCP_iAC_iは、予め分かっているものとし、例えばパラメータ保持器104に保存されているものとする。

The internal parameters CP_iAC_i this Kodewa, camera 101-i is assumed known in advance, for example, assumed to be stored in the

カメラ位置座標・向き情報推定部311は、グローバル座標系で既に位置座標及び向きが推定されているカメラ(ここでは、カメラAと呼ぶ)を選択する(S101)。

The camera position coordinate / orientation

次に、カメラ位置情報・向き情報推定部311は、位置座標及び向きが推定されていないカメラ(ここでは、カメラBと呼ぶ)を選択する(S102)。つまり、カメラ位置情報・向き情報推定部311は、既に位置座標及び向きが推定されているカメラAと、未推定のカメラBとを選択する。

Next, the camera position information / orientation

カメラ位置情報・向き情報推定部311は、カメラAとカメラBとの相対的な関係に基づいて、カメラBの位置座標及び向きを推定する(S103)。

The camera position information / orientation

つまり、カメラ位置情報・向き情報推定部311は、例えば特許文献3に記載される技術を利用する。詳細な技術的な内容は省略するが、パラメータ推定器3は、カメラAの撮像画面における基準点(特徴的な画像)の位置座標及び向きと、カメラBの撮像画面における基準点(カメラAが撮影した基準点と同一又は類似する特徴的な画像)の位置座標及び向きとを抽出する。例えば、カメラA及びカメラBの撮像画面における基準点は、音・映像位置較正器200の映像とすることができる。

That is, the camera position information / orientation

次に、カメラ位置情報・向き情報推定部311は、カメラAの撮像画像における基準点の位置座標及び向きを逆投影変換して、当該基準点のグローバル座標系の位置座標及び向きを求める。そして、カメラ位置情報・向き情報推定部311は、当該基準点のグローバル座標系の位置座標と、カメラBの撮像画面における基準点の位置座標とを用いて、式(1)よりカメラBの外部パラメータC_iRgおよびC_iTを推定する。すなわち、これにより、カメラAとカメラBとの間の相対的な位置関係を推定できる。

Next, the camera position information / orientation

カメラAの位置と向きがグローバル座標系で既知であるため、相対的な位置関係のわかったカメラBのグローバル座標系での位置も一意に定まる。相対的な位置関係がわかったというのは、カメラAとカメラBとの間の位置ベクトルPABが求まったことになる。カメラAのグローバル座標系での位置ベクトルをPOSAとし、カメラBのカメラAに対する位置ベクトルをPOSABとすると、カメラBのグローバル座標系での位置ベクトルPOSBは、PosA+POSABになる。 Since the position and orientation of the camera A are known in the global coordinate system, the position of the camera B whose relative positional relationship is known in the global coordinate system is also uniquely determined. When the relative positional relationship is known, the position vector PAB between the camera A and the camera B is obtained. If the position vector of the camera A in the global coordinate system is POSA and the position vector of the camera B with respect to the camera A is POSAB, the position vector POSB of the camera B in the global coordinate system is PosA + POSAB.

同様に、カメラAのグローバル座標系での向きを表すベクトルをDirAとし、カメラBのカメラAに対する相対的な向きを表すベクトルをDirABとすると、グローバル座標系でのカメラBの向きDirBはDirA+DirABとなる。 Similarly, if the vector representing the orientation of the camera A in the global coordinate system is DirA and the vector representing the relative orientation of the camera B with respect to the camera A is DirAB, the orientation DirB of the camera B in the global coordinate system is DirA + DirAB. Become.

カメラ位置情報・向き情報推定部311は、全てのカメラ101−1〜101−nについて位置座標及び向きを推定したか否かを判断し、全てのカメラ101−1〜101−nの位置座標及び向きを推定するまで、S101〜S103の処理を繰り返し行う。そして、全てカメラ101−1〜101−jの位置座標及び向きが推定されると、パラメータ推定部103は処理を終了する。

The camera position information / orientation

(A−2−4)マイクの位置座標及び向きの推定手順

図7は、パラメータ推定器103のマイクパラメータ推定部320によるマイク102−iの位置座標及び向きの推定処理を説明するフローチャートである。なおマイクパラメータ推定部320においてマイクパラメータをパラメータ保持器104に保持する動作はマイクパラメータ保存部323によって行われる。

(A-2-4) Microphone Position Coordinate and Orientation Estimation Procedure FIG. 7 is a flowchart for explaining the process of estimating the position coordinate and orientation of the microphone 102-i by the microphone

マイクパラメータ推定部のマイク位置座標・向き情報推定部321は、空間におけるマイク102−iの位置座標及び向きを推定する。

The microphone position coordinate / orientation

まず、マイク位置座標・向き情報推定部321では、空間において音・映像位置較正器200を適切な位置に固定した状態で(S201)、音・映像位置較正器200のグローバル座標系での位置座標を測定する(S202)。

First, the microphone position coordinate / orientation

音・映像位置較正器200のグローバル座標系での位置座標の測定方法は、種々の方法を適用できるが、例えば以下のような方法を適用することができる。

Various methods can be applied to the position coordinate measurement method in the global coordinate system of the sound /

例えば、カメラ101−1〜101−nのうち少なくとも2台のカメラが音・映像位置較正器200を撮影できる位置に動かし、音・映像位置較正器200を固定する。このとき、音・映像位置較正器200は、映像提示部201が所定の映像情報を提示するようにしておく。

For example, at least two of the cameras 101-1 to 101-n are moved to positions where the sound /

そして、マイク位置座標・向き情報推定部321は、少なくとも2台のカメラが音・映像位置較正器200を撮像した撮像映像情報を取得し、少なくとも2台のカメラの撮像映像情報と、少なくとも2台のカメラのグローバル座標系での位置座標及び向きとに基づいて、光線交差法を用いて、音・映像位置較正器200の位置座標を測定する。

The microphone position coordinate / orientation

マイク位置座標・向き情報推定部321が、光線交差法を用いて、音・映像位置較正器200のグローバル座標系での位置座標を測定する方法を図8を用いて説明する。

A method in which the microphone position coordinate / orientation

図8において、2個のカメラをカメラCX601、カメラCY602とする。図8において、カメラCX601、カメラCY602はグローバル座標系での位置座標及び向きが分かっている。そのため、カメラCX601及びカメラCY602の撮像画像に写っている物体(音・映像位置較正器200)が、それぞれのカメラCX601及びカメラCY602から見てどの方向にあるかがわかる。これは、グローバル座標系でカメラCX601、カメラCY602と、その物体(音・映像位置較正器200)とを通る直線が決定できるということである。光線交差法は、それぞれのカメラCX601、カメラCY602から、その写っている物体(音・映像位置較正器200)に伸ばした直線が交差する点に物体(音・映像位置較正器200)があると判断するものである。

In FIG. 8, two cameras are referred to as a

従って、マイク位置座標・向き情報推定部321は、カメラCX601及びカメラCY602のグローバル座標系での位置座標と、カメラCX601及びカメラCY602のグローバル座標系での向きとに基づき、それぞれのカメラCX601及びカメラCY602からの直線が交差する点を、音・映像位置較正器200のグローバル座標系での位置座標とする。

Therefore, the microphone position coordinate / orientation

次に、手順S202で、グローバル座標上の位置座標を測定した音・映像位置較正器200を音源とする。このとき、音・映像位置較正器200は、音響発生器202が所定の音響を発する。

Next, in step S202, the sound /

マイク102−1〜102−mは、マイクに対して相対的にどの方向から音響が到来しているかを推定できる機能を有しており、この音響の到来方向を含む音響情報をマイク位置座標・向き情報推定部321に与える。

The microphones 102-1 to 102-m have a function of estimating from which direction the sound is coming relative to the microphone, and the acoustic information including the direction of arrival of the sound is represented by the microphone position coordinates / The direction

マイク位置座標・向き情報推定部321は、マイク102−1〜102−mからの音響情報を取得し、マイク102−iのグローバル座標系での位置座標及び向きを推定する(S203)。

The microphone position coordinate / orientation

ここで、マイク102−jの向きと位置座標が、カメラ101−iのPnP問題と同等に取り扱えることに関して説明する。 Here, description will be made regarding that the direction and position coordinates of the microphone 102-j can be handled in the same way as the PnP problem of the camera 101-i.

音源の位置座標をグローバル座標系で(gX,gY,gZ)Tとする。また、マイク102−jのマイク座標系での同じ音源の座標を(M_jx,M_jy,M_jz)とする。 The position coordinates of the sound source are (gX, gY, gZ) T in the global coordinate system. Further, the coordinates of the same sound source in the microphone coordinate system of the microphone 102-j are assumed to be (M_jx, M_ji, M_jz).

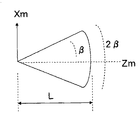

マイク102−jは音源の方向が分かっている。つまり、これは、図9に示すように、平面状のマイク102−jを考えたときに、マイク102−jの平面の水平方向にXm軸、Ym軸をとり、マイク102−jの平面の垂直方向にZm軸をとる。このとき、Zm軸と原点Oとベクトル(M_jx,0,M_jz)のなす角角度θと、Zm軸と原点Oとベクトル(0,M_jy,M_jz)のなす角度δが判る。従って、角度θは式(3)の関係にあり、角度δは式(4)の関係にある。 The microphone 102-j knows the direction of the sound source. That is, as shown in FIG. 9, when a planar microphone 102-j is considered, the Xm axis and Ym axis are taken in the horizontal direction of the plane of the microphone 102-j, and the plane of the microphone 102-j taking Z m axis in the vertical direction. At this time, the angle θ formed by the Zm axis and the origin O and the vector (M_jx, 0, M_jz) and the angle δ formed by the Zm axis and the origin O and the vector (0, M_jy, M_jz) are known. Therefore, the angle θ is in the relationship of the equation (3), and the angle δ is in the relationship of the equation (4).

一方、音源のグローバル座標系の位置座標(gX,gY,gZ)Tと、マイク102−jのマイク座標系での位置座標(M_jx,M_jy,M_jz)との間には、空間の回転行列M_jRgと平行移動を表すベクトルM_jTとを用いると、式(5)と表す関係がある。

ここで、図10に示すように、マイク座標系のXm−Ym平面に平行な平面Fを考える(図8)。平面Fはマイク座標系のZm軸とZm=fで交わるものとする。fの値は任意とする。この平面Fと、マイク座標系の原点と音源とを結ぶ直線の交わる点を点Qとし、点Qの平面F上の座標を(xq,yq)とする。 Here, as shown in FIG. 10, a plane F parallel to the Xm-Ym plane of the microphone coordinate system is considered (FIG. 8). The plane F intersects with the Zm axis of the microphone coordinate system at Zm = f. The value of f is arbitrary. A point where a straight line connecting the plane F and the origin of the microphone coordinate system and the sound source intersects is a point Q, and the coordinates of the point Q on the plane F are (xq, yq).

そうすると、平面F上の座標(xq,yq)と、音源のグローバル座標系の位置座標(gX,gY,gZ)Tとの間には、式(6)及び式(7)の関係にある

一方、図10において、マイク102−jの代わりに仮想的にカメラsを置いたと仮定する。そして、音源位置を基準点とする。カメラsの光軸をZm軸とした場合に、撮影された画像上の位置(CP_Su,CP_Sν)Tに基準点が写るものとする。 On the other hand, in FIG. 10, it is assumed that the camera s is virtually placed instead of the microphone 102-j. The sound source position is set as a reference point. When the optical axis of the camera s is the Zm axis, it is assumed that the reference point appears at a position (CP_Su, CP_Sν) T on the photographed image.

そのとき、(CP_Su,CP_Sν)Tと、音源のグローバル座標系の位置座標(gX,gY,gZ)Tとの関係は、CP_SAC_Sを仮想的なカメラsの内部パラメータとすると、式(1)と式(2)より、式(8)及び式(9)と表すことができる。

式(9)のCP_SAC_Sは、式(10)としたものが、式(6)のMP_jAmM_jである。

つまり、マイク102−jは内部パラメータがMP_jAmM_jであるカメラであるとみなすことができる。カメラであれば、PnP問題としてそのカメラパラ

メータを求めることができる。すなわち、グローバル座標系で位置のわかっている基準点として音源を用い、それに対応する(xq,yq)が取得でき、前述したように、これらが6組以上収集できれば、PnP問題を解くことで、変換行列M_jRg、M_jTを求めることができる。

That is, the microphone 102-j can be regarded as a camera whose internal parameter is MP_jAMm_j. If it is a camera, its camera parameters can be obtained as a PnP problem. That is, a sound source is used as a reference point whose position is known in the global coordinate system, and (xq, yq) corresponding to the sound source can be acquired. As described above, if six or more of these can be collected, solving the PnP problem, Conversion matrices M_jRg and M_jT can be obtained.

ところで、図10において、明らかに、角度θ及び角度δは、式(11)及び式(12)の関係にある。ここで、fは任意でよいため、f=1とすると、角度θ及び角度δは式(13)及び式(14)の関係にある。

従って、マイク上で音源からの音響の到来方向(θ,δ)が判っていれば、(xq,yq)が判ることになる。すなわち、変換行列M_jRg、M_jTを求めるためには、基準点となる音源のグローバル座標系の位置座標(gX,gY,gZ)Tとその音源のマイク上での到来方向(θ,δ)の組が6組以上あればよい。 Therefore, if the sound arrival direction (θ, δ) from the sound source is known on the microphone, (xq, yq) is known. That is, in order to obtain the transformation matrices M_jRg and M_jT, a set of the position coordinates (gX, gY, gZ) T of the sound source serving as the reference point and the arrival direction (θ, δ) of the sound source on the microphone There should be more than 6 pairs.

つまり、各マイク102−jは、音・映像位置較正器200を音源として、その音響の到来方向を測定する(S203)。そして、各マイク102−jは、音響の到来方向(θ、δ)とそのときの音源の位置(X,Y,Z)とを含む音響情報をマイク位置座標・向き情報推定部321に与える。マイク位置座標・向き情報推定部321は、各マイク102−jから取得した音響の到来方向(θ、δ)とそのときの音源の位置座標(X,Y,Z)との組をマイク102−j毎にパラメータ保持器104に保存する。

That is, each microphone 102-j uses the sound /

次に、マイク位置座標・向き情報推定部321は、それぞれのマイク102−jについて、音響の到来方向と音源の位置座標との組が6個以上あるか否かを判断し、マイク位置座標と向きを推定することができるマイクがあるか否かを判断する(S204)。

Next, the microphone position coordinate / orientation

そして、音響の到来方向と音源の位置座標との組が6個以上ある場合、マイク位置座標・向き情報推定部321は、処理をS205に移行させ、マイク102−jの位置座標及び向きを推定する(S205)。そして、マイク位置座標・向き情報推定部321は、6個以上の音響の到来方向と音源の位置座標との組で求めた変換行列M_jRg、M_jTをマイク102−j毎にパラメータ保持器104に保存する。

If there are six or more pairs of the sound arrival direction and the sound source position coordinates, the microphone position coordinate / orientation

次に、マイク位置座標・向き情報推定部321は、全てのマイク102−1〜102−mについて位置座標及び向きを推定したか否かを判断する(S206)。そして、全てのマイク102−1〜102−mの位置座標及び向きが推定済みであれば、マイク位置座標・向き情報推定部321は処理を終了する。

Next, the microphone position coordinate / orientation

なお、マイク位置座標・向き情報推定部321が、全てのマイク102−1〜102−mについて位置座標及び向きの推定ができていない場合には、音・映像位置較正器200の位置を移動させて(S207)、マイク位置座標・向き情報推定部321は、全てのマイク102−1〜102−mの位置座標及び向きを推定するまで、S201〜S206の処理を繰り返し行う。

When the microphone position coordinate / orientation

なお、S100で求めたグローバル座標系でのカメラ101−iの位置座標及び向きについても、マイク102−jの位置情報及び向きを表す変換行列M_jRg、M_jTと同じ形式(すなわち、変換行列C_jRg、C_jT)でパラメータ保持器104に保存する。

Note that the position coordinates and orientation of the camera 101-i in the global coordinate system obtained in S100 are also in the same format as the transformation matrices M_jRg and M_jT representing the positional information and orientation of the microphone 102-j (that is, the transformation matrices C_jRg and C_jT). ) To the

(A−2−5)パラメータ保持器104に保存される各種パラメータの説明

図11は、パラメータ保持器104に保存されるカメラ101−iの各種パラメータを説明する説明図である。

(A-2-5) Explanation of Various Parameters Saved in

パラメータ保持器104には、全てのカメラ101−1〜101−nの各種パラメータがカメラ101−i毎に保存される。なお、図11では、カメラ101−iの各種パラメータを保存する要素を示す。

The

図11に示すように、変換行列AはCP_iAC_i、外部パラメータR及びTは、C_iRg及びC_iTとして保存される。 As shown in FIG. 11, the transformation matrix A is stored as CP_iAC_i, and the external parameters R and T are stored as C_iRg and C_iT.

また、図11に示すように、角度範囲はα及びβはC_iα及びC_iβとして保存される。パン・チルト有無は、「有」若しくは「無」として保存される。また、パン角度及びチルト角度(図11ではパンチルト角度と表記)ζ及びηはC_iζ及びC_iηとして保存され、距離範囲LはC_iLとして保存される。 Also, as shown in FIG. 11, the angle ranges α and β are stored as C_iα and C_iβ. The presence / absence of pan / tilt is stored as “present” or “not present”. Further, the pan angle and tilt angle (denoted as pan tilt angle in FIG. 11) ζ and η are stored as C_iζ and C_iη, and the distance range L is stored as C_iL.

図12は、パラメータ保持器104に保存されるマイク102−iの各種パラメータを説明する説明図である。

FIG. 12 is an explanatory diagram for explaining various parameters of the microphone 102-i stored in the

パラメータ保持器104には、全てのマイク102−1〜102−nの各種パラメータがマイク102−i毎に保存される。なお、図12では、マイク102−iの各種パラメータを保存する要素を示す。

Various parameters of all the microphones 102-1 to 102-n are stored in the

図12に示すように、パラメータR及びTは、M_jRg及びM_jTgとして保存される。角度範囲α及びβはM_jα及びM_jβとして保存される。距離範囲LはM_jLとして保存される。 As shown in FIG. 12, parameters R and T are stored as M_jRg and M_jTg. Angle range α and β are stored as M_jα and M_jeibeta. The distance range L is stored as M_jL.

(A−2−6)撮影範囲、収音範囲の保存方法

次に、カメラ101−iの撮影範囲や、マイク102−jの収音範囲について、パラメータ推定器103がどのような情報を求めて、パラメータ保持器104に保存するかを図13〜図15、図16〜図18を用いて説明する。

(A-2-6) Method for Saving Shooting Range and Sound Collection Range Next, the

ここでは、カメラ101−iの撮影範囲や、マイク102−jの収音範囲を、情報収集範囲と呼ぶ。 Here, the shooting range of the camera 101-i and the sound collection range of the microphone 102-j are referred to as an information collection range.

なお、カメラ101−iの情報収集範囲は、角度範囲α及びβ、パン角度ζ及びチルト角度η、距離範囲Lを含むものである。また、マイク102−jの情報収集範囲は、角度範囲α及びβ、距離範囲Lを含むものとする。 Note that the information collection range of the camera 101-i includes the angle ranges α and β, the pan angle ζ and the tilt angle η, and the distance range L. Further, the information collection range of the microphone 102-j includes angle ranges α and β and a distance range L.

図13〜図15は、カメラ101−i及びマイク102−jの情報収集範囲を説明する説明図である。 13 to 15 are explanatory diagrams for explaining the information collection ranges of the camera 101-i and the microphone 102-j.

図13では、情報収集範囲が四角錐形で表している。なお、カメラ101−iの撮影範囲の場合、図13のXm−Ym−Zm座標の原点にカメラ101−iが位置しており、カメラ101−iがZm軸方向を撮影画面の中心として撮影する場合とする。また、マイク102−jの収音範囲は、Xm−Ym−Zm座標の原点にマイク102−iが位置しており、マイク102−jがZm軸方向を正面方向として収音する場合とする

図13〜図15において、情報収集範囲は、Zm軸を中心に角度±α及び角度±βの範囲、かつ、原点からZm軸上の距離Lまでの範囲としてモデル化する。Zm軸は、カメラ101−iの撮像画面の中心を通る。

In FIG. 13, the information collection range is represented by a quadrangular pyramid. In the case of the shooting range of the camera 101-i, the camera 101-i is located at the origin of the Xm-Ym-Zm coordinates in FIG. 13, and the camera 101-i takes a picture with the Zm-axis direction as the center of the shooting screen. Suppose. The sound collection range of the microphone 102-j is a case where the microphone 102-i is located at the origin of the Xm-Ym-Zm coordinates and the microphone 102-j collects sound with the Zm-axis direction as the front direction. 13 to 15, the information collection range is modeled as a range of angles ± α and ± β around the Zm axis and a range from the origin to a distance L on the Zm axis. The Zm axis passes through the center of the imaging screen of the camera 101-i.

この情報収集範囲は、カメラ101−i毎やマイク102−j毎に異なっていても良い。カメラパラメータ推定部310では、カメラ撮影範囲情報取得部321が、すべてのカメラ101−iの情報収集範囲を取得し、カメラパラメータ保存部313によって、カメラ101−i毎にパラメータ保持器104に保持する。マイクパラメータ推定部320では、マイク収音範囲情報取得部322がマイク102−jの情報収集範囲を取得し、マイクパラメータ保存部323によって、マイク102−j毎にパラメータ保持部104に保持する。α、βについては、カメラ101−iの情報収集範囲をC_iα、C_iβと表記し、マイク102−jの情報収集範囲をM_jα、M_jβと表記することにする。

This information collection range may be different for each camera 101-i and each microphone 102-j. In the camera

パン・チルトの機能に関する情報をどのような形式で保存するかを図16〜図18を用いて説明する。 The format in which information related to the pan / tilt function is stored will be described with reference to FIGS.

Ym−Zm平面内でのカメラ101−i(若しくはマイク102−j)の傾きをパンとし、パン可能な最大角を±ζとする(図17参照)。 The tilt of the camera 101-i (or microphone 102-j) in the Ym-Zm plane is defined as pan, and the maximum panable angle is defined as ± ζ (see FIG. 17).

Xm−Zm平面内でのカメラ101−i(若しくはマイク102−j)の傾きをチルトとし、チルト可能な最大角を±ηとする(図18参照)。 The tilt of the camera 101-i (or microphone 102-j) in the Xm-Zm plane is defined as tilt, and the maximum tiltable angle is defined as ± η (see FIG. 18).

パンやチルトが可能なカメラ101−iおよびマイク102−jについて、パラメータ推定器103が、それが可能であるというフラグと共に、パン角度最大値ζおよびチルト角度の最大値ηを、カメラ101−i及びマイク102−j毎にパラメータ保持器104に保存する。なお、以降の説明ではカメラのみパン・チルト機能を備えるとして説明をするが、マイクにパン・チルト機能を備える場合も同様に扱える。パン角度ζ及びチルト角度ηは、カメラ101−iのパン可能な角度をC_iζ及びC_iηと表記する。

For the camera 101-i and the microphone 102-j capable of panning and tilting, the

(A−2−7)指定位置の情報を収集可能なカメラとマイクの選択方法

次に、視聴点指示器105による指定位置の情報を収集可能なカメラ101−i及びマイク102−jの選択処理の動作を、図面を参照しながら詳細に説明する。

(A-2-7) Camera and microphone selection method capable of collecting designated position information Next, the selection process of the camera 101-i and microphone 102-j capable of collecting designated position information by the

図19は、視聴点指示器105による指定位置の情報を収集可能なカメラ101−i及びマイク102−jの選択処理の全体的な手順を示すフローチャートである。

FIG. 19 is a flowchart showing an overall procedure of selection processing of the camera 101-i and the microphone 102-j that can collect information on the designated position by the

まず、視聴点指示器105がカメラ101−i及びマイク102−jの処理を開始すると(S300)、視聴点指示器105は、視聴点指定取得部401よりグローバル座標系における指定座標位置の入力を受け受け、指定座標位置を取得する(S301)。

First, when the

視聴点指示器105が指定座標位置を取得すると、視聴点指示器105は、後述するように、パラメータ保持器104に保存される各カメラ101−iのパラメータを参照して、指定された位置の映像を撮像するカメラ101−iを選択する(S400)。

When the

次に、視聴点指示器105は、後述するように、パラメータ保持器104に保存される各マイク102−iのパラメータを参照して、指定された位置の音響を収音するマイク102−jを選択する(S500)。

Next, as will be described later, the

(A−2−8)カメラの選択処理

図20は、視聴点指示器105によるカメラ101−iの選択処理を説明するフローチャートである。

(A-2-8) Camera Selection Processing FIG. 20 is a flowchart for describing the camera 101-i selection processing by the

視聴点指示器105のカメラ選択部402は、パラメータ保持器104に保存される複数のカメラ101−1〜101−nのうち1台を選択し、その選択したカメラ101−iに関するパラメータをパラメータ保持器104から取得する(S401)。

The

カメラ選択部402は、グローバル座標系の指定位置座標を、選択したカメラ101−iのカメラ座標系に変換する(S402)。

The

このとき、カメラ選択部402は、選択されたカメラ101−iのパラメータC_iRg、C_iTを用いて、式(15)に従って、グローバル座標系を当該カメラ101−iのカメラ座標系に変換する変換行列C_iMgを求める。そして、カメラ選択部402は、式(16)に従って、指定位置Vのグローバル座標系の位置座標(gxv,gyv,gzv)Tに基づいて、当該カメラ101−iのカメラ座標系での対応点(C_ixv,C_iyv,C_izv)Tを求める。

次に、カメラ選択部402は、カメラ101−iの撮影範囲に指定した位置座標(当該カメラ101−iのカメラ座標系の位置座標)が含まれているか否かを判断する。つまり、カメラ選択部402は、カメラ101−iのカメラ座標系での指定位置座標(C_ixv,C_iyv,C_izv)Tがカメラ101−iで撮影可能範囲にあるか否かを判断する。

Next, the

まず、カメラ選択部402は、指定位置座標がカメラ101−iの画角内にあるか否かを判断する(S403)。そして、指定位置座標が画角内にある場合、カメラ選択部402は処理をS405に移行させ、指定位置座標が画角内にない場合、カメラ選択部402は処理をS404に移行させる。

First, the

カメラ選択部402は、パラメータ保持器104からカメラ101−iのパラメータを取得し、カメラ101−iの撮影可能な範囲として、左右角を±C_iαとし、上下角を±C_iβとする。また、カメラ101−iから指定位置Vを見たときの角度は左右角をC_iδv、上下角をC_iθvとする。

The

このとき、カメラ選択部402は、式(17)及び式(18)の条件に従って、カメラ101−iの画角内に指定した位置座標が含まれるか否かを判断する。

ここで、カメラ101−iから指定位置Vを見たときの左右角C_iδv、上下角C_iθvは、式(19)及び式(20)の関係がある。従って、カメラ選択部402は、式(21)及び式(22)の条件が成立するか否かを判断し、式(21)及び式(22)の条件が成立する場合、当該カメラ101−iは撮影可能な画角内にあると判断する。

次に、カメラ選択部402は、当該カメラ101−iがパン・チルト可能なカメラであるか否かを判断する。そして、当該カメラ101−iがパン・チルト可能である場合、パン・チルトした場合に指定位置Vを撮影可能か否か判断する(S404)。そして、撮影可能な場合、カメラ選択部402は処理をS405に移行させ、撮影不可能な場合、カメラ選択部402は処理をS407に移行させる。

Next, the

ここで、撮影可能とは、当該カメラ101−iがパン・チルトをすることで指定された位置Vを画面の中央部分に映すことができる場合とする。図16〜図18に示すように、カメラ101−iのパン・チルトの角度範囲を示す。パンは水平方向に±ζ、チルトは垂直方向に±ηの範囲で撮影可能とする。 Here, “capable of photographing” means a case where the camera 101-i can project the position V designated by panning / tilting in the center portion of the screen. As shown in FIGS. 16 to 18, the pan / tilt angle range of the camera 101-i is shown. Pan can be photographed in the range of ± ζ in the horizontal direction and tilt in the range of ± η in the vertical direction.

視聴指示器105は、カメラ101−iのパン角度C_iζ、チルト角度C_iηをパラメータ保持器104から取得し、パン・チルトした位置Vが撮影可能か否かの条件である式(23)及び式(24)を満たすか否かを判断する。

ここで、式(19)、式(20)、式(23)、式(24)から、カメラ選択部402は、式(25)及び式(26)の条件を満たすか否かを判断して、式(25)及び式(26)の条件を満たす場合、撮影可能であると判断する。

S405では、カメラ選択部402が、指定された位置Vがカメラ101−iで撮影可能な距離にあるか否かを判断する(S405)。

In S405, the

指定された位置Vのカメラ101−iからの距離は、{(C_ixv)2+(C_iyv)2+(C_izv)2}1/2で表され、カメラ101−iの撮影可能範囲は、カメラ101−iの原点からC_iLである。従って、撮影可能か否かの条件は式(27)となる。

カメラ選択部402は、式(27)の条件を満たすか否かを判断し、この条件を満たす場合に、当該カメラ101−iは撮影可能なものであると判断し、カメラ選択部402は、当該カメラ101−iを撮影可能なもののリストに追加する(S406)。

The

一方、この条件を満たさない場合に、カメラ選択部402は、当該カメラ101−iは撮影可能なものでないと判断して、処理をS407に移行させる。

On the other hand, when this condition is not satisfied, the

カメラ選択部402は、全てのカメラ101−iについて撮影可能か否かの判断をしたか否かを確認し、全てのカメラ101−iについての判断を行っていない場合には、処理をS401に移行し、次のカメラ101−iを選択して処理を繰り返し行う(S407)。

The

このようにして、指定の位置Vの映像を撮影可能なカメラ101−iは、リストに登録されるため、そのリストから任意に選択又はどのカメラ101−iを選択するかの指示をさせることができる。 In this way, since the camera 101-i capable of shooting the video at the designated position V is registered in the list, it is possible to arbitrarily select from the list or to instruct which camera 101-i to select. it can.

(A−2−9)マイクの選択処理

図21は、視聴点指示器105のマイク選択部403によるマイク102−iの選択処理を説明するフローチャートである。

(A-2-9) Microphone Selection Processing FIG. 21 is a flowchart illustrating the microphone 102-i selection processing by the

マイク選択部403は、パラメータ保持器104に保存される複数のマイク102−1〜102−mのうち1台を選択し、その選択したマイク102−jに関するパラメータをパラメータ保持器104から取得する(S501)。

The

マイク選択部403は、グローバル座標系で指定された位置座標を、当該マイク102−jのマイク座標系に変換する(S502)。

The

ここで、マイク選択部403による指定位置座標のグローバル座標系からマイク座標系への変換方法を説明する。

Here, a method for converting the designated position coordinates from the global coordinate system to the microphone coordinate system by the

選択されたマイク102−jのパラメータM_jRg、M_jTgが、パラメータ保持器104に保存されているため、視聴点指示器105は、当該マイク102−jのパラメータを読み出す。

Since the parameters M_jRg and M_jTg of the selected microphone 102-j are stored in the

このとき、視聴点指示器105は、選択されたマイク102−jのパラメータM_jRg、M_jTgを用いて、式(28)に従って、グローバル座標系を当該マイク102−jのマイク座標系に変換する変換行列M_iMgを求める。

At this time, the

そして、マイク選択部403は、式(29)に従って、指定位置Vのグローバル座標系の位置座標(gxv,gyv,gzv)Tに基づいて、当該マイク102−jのマイク座標系での対応点(M_jxv,M_jyv,M_jzv)Tを求める。

次に、マイク選択部403は、指定された位置Vの音源がマイク102−jの収音可能な角度の範囲にあるか否かを判断する(S503)。そして、位置座標Vの音源がマイク102−jが収音可能は角度の範囲にある場合、マイク選択部403は処理をS504に移行させ、そうでない場合、マイク選択部403は処理をS506に移行させる。

Next, the

ここで、マイク102−jの収音可能な範囲の左右角をM_jα、上下角をM_jβとすると、指定位置のマイク102−jから見たときの角度について左右角をM_jδV、上下角をM_jθVとする。指定位置座標Vの音源がマイク102−jの収音可能な角度内にあるか否かは、マイク102−jの収音可能範囲内に指定した座標Vが含まれているかどうかを判断すればよい。 Here, if the left and right corners of the range in which sound can be collected by the microphone 102-j is M_jα and the top and bottom angles are M_jβ, the left and right angles are M_jδV and the top and bottom angles M_jθV when viewed from the microphone 102-j at the specified position. To do. Whether or not the sound source of the designated position coordinate V is within the angle at which the microphone 102-j can collect sound is determined by determining whether or not the specified coordinate V is included within the sound collection possible range of the microphone 102-j. Good.

つまり、マイク102−jの収音可能な範囲は、左右方向について式(30)の関係にあり、上下方向について式(31)の関係にある。また、指定位置座標Vの音源の位置座標は、式(32)及び式(33)の関係にあるため、マイク102−jの収音可能な左右方向の関係式(30)は式(34)となり、上下方向の関係式(31)は式(35)となる。 That is, the range in which sound can be collected by the microphone 102-j is in the relationship of Expression (30) in the left-right direction and in the relationship of Expression (31) in the up-down direction. Further, since the position coordinates of the sound source of the designated position coordinate V are in the relationship of Expression (32) and Expression (33), the relational expression (30) in the left-right direction that can be picked up by the microphone 102-j is Expression (34). Thus, the relational expression (31) in the vertical direction becomes the expression (35).

従って、マイク選択部403は、式(34)及び式(35)の条件が成立するか否かを判断し、式(34)及び式(35)の条件が成立する場合、当該マイク102−jは収音可能な画角内にあると判断する。

次に、マイク選択部403は、指定された位置座標Vがマイク102−jからの収音可能な距離にあるか否かを判断する(S504)。

Next, the

指定された位置座標Vのマイク102−jからの距離は、{(M_jxv)2+(M_jyv)2+(M_jzv)2}1/2で表され、マイク102−jの収音可能範囲は、マイク102−jの原点からM_jLである。従って、収音可能か否かの条件は式(36)となる。

マイク選択部403は、式(36)の条件を満たすか否かを判断し、この条件を満たす場合に、当該マイク102−jは収音可能なものとしてリストに追加する(S504)。

The

一方、この条件を満たさない場合に、マイク選択部403は、当該マイク102−jは撮影可能なものでないと判断して、処理をS506に移行させる。

On the other hand, when this condition is not satisfied, the

マイク選択部403は、全てのマイク102−jについて撮影可能か否かの判断をしたか否かを確認し、全てのマイク102−jについての判断を行っていない場合には、処理をS501に移行し、次のマイク102−jを選択して処理を繰り返し行う(S506)。

The

このようにして、指定の位置Vの映像を撮影可能なマイク102−jは、リストに登録されるため、そのリストから任意に選択又は指定を受けることができる。 In this way, the microphone 102-j capable of shooting the video at the designated position V is registered in the list, and can be arbitrarily selected or designated from the list.

(A−3)実施形態の効果

以上のように、実施形態によれば、カメラやマイクのグローバル座標系の位置座標や向きを、従来よりも簡単かつ間違いなく推定することができる。

(A-3) Effect of Embodiment As described above, according to the embodiment, the position coordinates and orientation of the global coordinate system of the camera and microphone can be estimated more easily and definitely than before.

(B)他の実施形態

上述した実施形態においても本発明の種々の変形実施形態を説明したが、本発明は、以下の変形実施形態にも広く適用することができる。

(B) Other Embodiments Although various modified embodiments of the present invention have been described in the above-described embodiments, the present invention can be widely applied to the following modified embodiments.

(B−1)上述した実施形態では、図5のS100でカメラ101−iのグローバル座標系での位置座標及び向きを推定する場合を例示した。しかし、カメラ101−iの取り付け位置や向きが予め定まっている場合には、カメラ101−iのグローバル座標系での位置座標及び向きの推定処理を省略するようにしても良い。この場合、予めカメラ101−iのグローバル座標系での位置座標及び向きが判っているから、各カメラ101−iのグローバル座標系での位置座標及び向きをパラメータ保持器104に保存しておくことで、上述した実施形態の動作と同様の効果を得ることができる。

(B-1) In the above-described embodiment, the case where the position coordinates and orientation of the camera 101-i in the global coordinate system are estimated in S100 of FIG. However, when the attachment position and orientation of the camera 101-i are determined in advance, the position coordinate and orientation estimation processing in the global coordinate system of the camera 101-i may be omitted. In this case, since the position coordinates and orientation of the camera 101-i in the global coordinate system are known in advance, the position coordinates and orientation of each camera 101-i in the global coordinate system are stored in the

(B−2)上述した実施形態では、カメラやマイクが複数台ある場合を例示したが、カメラやマイクはそれぞれ1台の場合であっても適用できる。本発明は、相対的な位置関係に基づいて、カメラやマイクのグローバル座標系での位置座標や向きを推定するものであるが、カメラやマイクが1台の場合、予め位置や向きが明らかなものを基準とすることで実現することができる。 (B-2) In the above-described embodiment, the case where there are a plurality of cameras and microphones has been illustrated, but the present invention can be applied even when there is only one camera and microphone. The present invention estimates the position coordinates and orientation of the camera and microphone in the global coordinate system based on the relative positional relationship. However, when there is one camera or microphone, the position and orientation are clear in advance. It can be realized by using things as standards.

(B−3)音・映像位置較正器200が提示する映像情報は、あらかじめ決められた映像や、光の明滅パターンなどカメラから見てその場所が明らかに識別できるものであればなんでもよい。また、音・映像位置較正器200が発する音響情報は、あらかじめ決められた周波数の音や、決められた音階パターンの再生など、などマイクから見て他の音と明らかに識別できるものであればなんでもよい。

(B-3) The video information presented by the sound /

100…キャリブレーションシステム、101−1〜101−n…カメラ、102−1〜102−m…マイク、103…パラメータ推定器、104…パラメータ保持器、105…視聴点指示器、200…音・映像位置較正器。

DESCRIPTION OF

Claims (8)

グローバル座標系における複数のカメラの位置情報及び向きと、上記複数のカメラによって撮像された上記位置較正器を含む映像情報とに基づいて、グローバル座標系における上記位置較正器の位置情報を測定する基準点測定手段と、

グローバル座標系において基準点とする上記位置較正器の位置情報と、音源とする上記位置較正器から発せられた音響の1又は複数のマイクロホンのそれぞれにおける相対的な到来方向を示す到来方向情報とを取得する情報取得手段と、

上記グローバル座標系での音源としての上記位置較正器の位置情報と、上記各マイクロホンにおける上記到来方向情報とに基づいて、上記各マイクロホンのグローバル座標系での位置情報及び向きに関するパラメータを推定するパラメータ推定手段と

を備えること特徴とするパラメータ推定装置。 A parameter estimation device for estimating parameters related to position information and orientation of one or more microphones in a global coordinate system using image information including a position calibrator arranged in space, which is imaged by a plurality of cameras,

A reference for measuring position information of the position calibrator in the global coordinate system based on position information and orientations of the plurality of cameras in the global coordinate system and video information including the position calibrator imaged by the plurality of cameras. Point measuring means;

Position information of the position calibrator serving as a reference point in the global coordinate system, and direction-of-arrival information indicating a relative direction of arrival at each of one or a plurality of microphones of sound emitted from the position calibrator serving as a sound source. Information acquisition means to acquire;

A parameter for estimating parameters related to position information and orientation of each microphone in the global coordinate system based on position information of the position calibrator as a sound source in the global coordinate system and the arrival direction information in each microphone A parameter estimation device comprising: estimation means.

上記グローバル座標系の音源の位置情報と、上記各マイクロホンにおける上記到来方向情報とに基づいて、各マイクロホンのマイク座標系での音源の位置情報を任意の投影面に投影した対応点の位置情報を求め、複数のマイクロホンにおける上記対応点の位置情報を用いて、上記各マイクロホンの位置情報及び向きに関するパラメータを推定するものである

ことを特徴とする請求項1に記載のパラメータ推定装置。 The parameter estimation means is

Based on the position information of the sound source in the global coordinate system and the direction of arrival information in each microphone, the position information of the corresponding point obtained by projecting the position information of the sound source in the microphone coordinate system of each microphone on an arbitrary projection plane is obtained. The parameter estimation device according to claim 1, wherein the parameter regarding the position information and the direction of each microphone is estimated using the position information of the corresponding points in a plurality of microphones.

コンピュータを、

グローバル座標系における複数のカメラの位置情報及び向きと、上記複数のカメラによって撮像された上記位置較正器を含む映像情報とに基づいて、グローバル座標系における上記位置較正器の位置情報を測定する基準点測定手段、

グローバル座標系において基準点とする上記位置較正器の位置情報と、音源とする上記位置較正器から発せられた音響の1又は複数のマイクロホンのそれぞれにおける相対的な到来方向を示す到来方向情報とを取得する情報取得手段、

上記グローバル座標系での音源としての上記位置較正器の位置情報と、上記各マイクロホンにおける上記到来方向情報とに基づいて、上記各マイクロホンのグローバル座標系での位置情報及び向きに関するパラメータを推定するパラメータ推定手段

として機能させることを特徴とするパラメータ推定プログラム。 A parameter estimation program for estimating parameters related to position information and orientation of one or a plurality of microphones in a global coordinate system using image information including a position calibrator arranged in space, which is imaged by a plurality of cameras,

Computer

A reference for measuring position information of the position calibrator in the global coordinate system based on position information and orientations of the plurality of cameras in the global coordinate system and video information including the position calibrator imaged by the plurality of cameras. Point measuring means,

Position information of the position calibrator serving as a reference point in the global coordinate system, and direction-of-arrival information indicating a relative direction of arrival at each of one or a plurality of microphones of sound emitted from the position calibrator serving as a sound source. Information acquisition means to acquire,

A parameter for estimating parameters related to position information and orientation of each microphone in the global coordinate system based on position information of the position calibrator as a sound source in the global coordinate system and the arrival direction information in each microphone A parameter estimation program that functions as an estimation means.

少なくとも、上記マイクパラメータ推定手段により推定された1又は複数のマイクロホンの位置情報及び向きに関するパラメータを保持するマイクパラメータ保持手段と、

グローバル座標系で指定された位置情報を、上記各マイクロホンのマイク座標系における位置情報に変換して、指定された位置の情報を収集するマイクロホンを選択するマイクロホン選択手段と

を備えることを特徴とする機器決定システム。 Microphone parameter estimation means as the parameter estimation device according to any one of claims 1 to 3,

Microphone parameter holding means for holding at least parameters related to position information and orientation of one or more microphones estimated by the microphone parameter estimation means;

A microphone selection unit that converts position information specified in the global coordinate system into position information in the microphone coordinate system of each microphone and selects a microphone that collects information on the specified position; Equipment decision system.

グローバル座標系で指定された位置情報を、上記各カメラのカメラ座標系における位置情報に変換して、指定された位置の情報を収集するカメラを選択するカメラ選択手段と

を備えることを特徴とする請求項5に記載の機器決定システム。 Camera parameter holding means for holding camera parameters for one or more cameras for each camera;

Camera position selection means for converting the position information specified in the global coordinate system into position information in the camera coordinate system of each of the cameras, and selecting a camera that collects the information of the specified position. The device determination system according to claim 5.

上記マイクロホン選択手段が、上記各マイクロホンの情報収集範囲とする角度内に上記マイク座標系における指定位置が含まれており、上記各マイクロホンの情報収集範囲とする収音可能距離内に上記マイク座標系における指定位置があるか否かを判断して、情報収集可能なマイクロホンを選択するものである

ことを特徴とする請求項5又は6に記載の機器決定システム。 The microphone parameter holding means holds the information collection range of one or a plurality of microphones,

The microphone selection means includes a designated position in the microphone coordinate system within an angle that is an information collection range of each microphone, and the microphone coordinate system is within a sound collection possible distance that is an information collection range of each microphone. The device determination system according to claim 5 or 6, wherein a microphone capable of collecting information is selected by determining whether or not there is a designated position.

請求項4に記載のパラメータ推定プログラムとして機能させるマイクパラメータ推定手段、

少なくとも、上記マイクパラメータ推定手段により推定された1又は複数のマイクロホンの位置情報及び向きに関するパラメータを保持するマイクパラメータ保持手段、

グローバル座標系で指定された位置情報を、上記各マイクロホンのマイク座標系における位置情報に変換して、指定された位置の情報を収集するマイクロホンを選択するマイクロホン選択手段

として機能させることを特徴とする機器決定プログラム。 Computer

Microphone parameter estimation means that functions as the parameter estimation program according to claim 4;

Microphone parameter holding means for holding at least parameters relating to position information and orientation of one or more microphones estimated by the microphone parameter estimating means;

The position information specified in the global coordinate system is converted into the position information in the microphone coordinate system of each of the microphones so as to function as a microphone selection unit that selects a microphone that collects information on the specified position. Equipment decision program.

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013049093A JP5924295B2 (en) | 2013-03-12 | 2013-03-12 | Parameter estimation apparatus, parameter estimation program, device determination system, and device determination program |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2013049093A JP5924295B2 (en) | 2013-03-12 | 2013-03-12 | Parameter estimation apparatus, parameter estimation program, device determination system, and device determination program |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2014175996A JP2014175996A (en) | 2014-09-22 |

| JP5924295B2 true JP5924295B2 (en) | 2016-05-25 |

Family

ID=51696809

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2013049093A Active JP5924295B2 (en) | 2013-03-12 | 2013-03-12 | Parameter estimation apparatus, parameter estimation program, device determination system, and device determination program |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP5924295B2 (en) |

Families Citing this family (11)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP6841277B2 (en) * | 2016-03-30 | 2021-03-10 | 日本電気株式会社 | Monitoring equipment, monitoring methods, and programs |

| JP6758956B2 (en) | 2016-06-30 | 2020-09-23 | キヤノン株式会社 | Controls, control methods and programs |

| US10547961B2 (en) | 2016-10-25 | 2020-01-28 | Canon Kabushiki Kaisha | Signal processing apparatus, signal processing method, and storage medium |

| KR102354299B1 (en) * | 2017-03-16 | 2022-01-24 | 한국전자통신연구원 | Camera calibration method using single image and apparatus therefor |

| JP6983583B2 (en) * | 2017-08-30 | 2021-12-17 | キヤノン株式会社 | Sound processing equipment, sound processing systems, sound processing methods, and programs |

| JP6943183B2 (en) * | 2018-01-05 | 2021-09-29 | オムロン株式会社 | Positioning device, position identification method, position identification program and camera device |

| KR102559203B1 (en) * | 2018-10-01 | 2023-07-25 | 삼성전자주식회사 | Method and apparatus of outputting pose information |

| KR102151250B1 (en) * | 2018-12-12 | 2020-09-02 | 서울과학기술대학교 산학협력단 | Device and method for deriving object coordinate |

| CN113218392A (en) * | 2020-01-21 | 2021-08-06 | 富华科精密工业(深圳)有限公司 | Indoor positioning navigation method and navigation device |

| CN112255507B (en) * | 2020-09-10 | 2022-07-22 | 深圳供电局有限公司 | Partial discharge positioning method and device, computer equipment and storage medium |

| WO2023173337A1 (en) * | 2022-03-16 | 2023-09-21 | 北京小米移动软件有限公司 | Method and apparatus for acquiring vehicle-mounted audio signals |

Family Cites Families (6)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2002314994A (en) * | 2001-04-13 | 2002-10-25 | Matsushita Electric Ind Co Ltd | System and method for estimating camera position |

| JP2005136774A (en) * | 2003-10-31 | 2005-05-26 | Casio Comput Co Ltd | Camera surveillance system and program |

| JP2005159731A (en) * | 2003-11-26 | 2005-06-16 | Canon Inc | Imaging apparatus |

| JP2007263614A (en) * | 2006-03-27 | 2007-10-11 | Oki Electric Ind Co Ltd | Device and method for calibrating echo sounder receiver position |

| JP5564873B2 (en) * | 2009-09-25 | 2014-08-06 | 富士通株式会社 | Sound collection processing device, sound collection processing method, and program |

| JP5452158B2 (en) * | 2009-10-07 | 2014-03-26 | 株式会社日立製作所 | Acoustic monitoring system and sound collection system |

-

2013

- 2013-03-12 JP JP2013049093A patent/JP5924295B2/en active Active

Also Published As

| Publication number | Publication date |

|---|---|

| JP2014175996A (en) | 2014-09-22 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP5924295B2 (en) | Parameter estimation apparatus, parameter estimation program, device determination system, and device determination program | |

| JP5624394B2 (en) | Position / orientation measurement apparatus, measurement processing method thereof, and program | |

| JP5538667B2 (en) | Position / orientation measuring apparatus and control method thereof | |

| JP5999615B2 (en) | Camera calibration information generating apparatus, camera calibration information generating method, and camera calibration information generating program | |

| JP6222898B2 (en) | Three-dimensional measuring device and robot device | |

| WO2013125099A1 (en) | Augmented reality image processing device and method | |

| JP6721112B2 (en) | Camera parameter estimation device, method and program | |

| JP2009042162A (en) | Calibration device and method therefor | |

| JP2013042411A (en) | Image processing apparatus, projector and projector system comprising the image processing apparatus, image processing method, program thereof, and recording medium having the program recorded thereon | |

| JP5959311B2 (en) | Data deriving apparatus and data deriving method | |

| JP2017129567A (en) | Information processing apparatus, information processing method, and program | |

| JP2015031601A (en) | Three-dimensional measurement instrument, method, and program | |

| JP2019020778A (en) | Information processing device and information processing method | |

| JP2013036831A (en) | Calibration apparatus and distortion error calculation method | |

| JP2017135495A (en) | Stereoscopic camera and imaging system | |

| JP2017092756A (en) | Image processing system, image processing method, image projecting system and program | |

| JP2014173942A (en) | Radio wave emission source detector and radio wave emission source detection method | |

| JP2017017674A (en) | Vertical axis calibration device, method, and program | |

| CN112969963B (en) | Information processing apparatus, control method thereof, and storage medium | |

| JP5514062B2 (en) | Electronic device, imaging screen display method with information, and program | |

| JP2015038699A (en) | Augmented reality image generation system, three-dimensional shape data generation device, augmented reality presentation device, augmented reality image generation method, and program | |

| JP2018004554A (en) | Device and method for calculating three-dimensional coordinate of a characteristic point of object | |

| JP5901379B2 (en) | Imaging apparatus calibration method and image composition apparatus | |

| JP5638578B2 (en) | Observation support device, observation support method and program | |

| JP7535412B2 (en) | Three-dimensional measurement device, three-dimensional measurement system, and three-dimensional measurement method |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20140725 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20150203 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20150406 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20151222 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20160212 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20160322 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20160404 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 5924295 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |