JP4326585B2 - Information processing program and information processing apparatus - Google Patents

Information processing program and information processing apparatus Download PDFInfo

- Publication number

- JP4326585B2 JP4326585B2 JP2008286793A JP2008286793A JP4326585B2 JP 4326585 B2 JP4326585 B2 JP 4326585B2 JP 2008286793 A JP2008286793 A JP 2008286793A JP 2008286793 A JP2008286793 A JP 2008286793A JP 4326585 B2 JP4326585 B2 JP 4326585B2

- Authority

- JP

- Japan

- Prior art keywords

- virtual

- point

- control

- dog

- mode

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

Images

Landscapes

- Processing Or Creating Images (AREA)

- Position Input By Displaying (AREA)

- User Interface Of Digital Computer (AREA)

Description

本発明は、2次元画面上に表示される3次元空間のオブジェクトを操作するための技術に関する。 The present invention relates to a technique for operating an object in a three-dimensional space displayed on a two-dimensional screen.

従来、マウスやタッチパネル等のポインティングデバイスを用いて2次元画面上の所定座標位置を指示することで、その画面上に表示される仮想的な3次元空間のオブジェクトを操作する技術がある。 2. Description of the Related Art Conventionally, there is a technique for operating a virtual three-dimensional space object displayed on a screen by specifying a predetermined coordinate position on the two-dimensional screen using a pointing device such as a mouse or a touch panel.

例えば、特許文献1には、タッチパネル上の1つの座標位置を指定することで3Dオブジェクトを移動したり、回転させたり、拡大/縮小したりする技術が示されている。 For example, Patent Document 1 discloses a technique for moving, rotating, and enlarging / reducing a 3D object by designating one coordinate position on a touch panel.

また、特許文献2には、オブジェクトが配置された3次元空間内にそのオブジェクトの操作座標系(x軸、y軸、z軸)を設け、所望の1つの軸を回転軸として指定した後、残りのいずれかの軸の矢印の先端部分を所望の回転方向にドローすることで、そのオブジェクトを回転させる技術が示されている。

しかしながら、上記特許文献1に記載の技術では、例えば3Dオブジェクトを移動させるときに、指定された座標位置に応じて3Dオブジェクトの移動方向および移動速度を決定しているに過ぎないため、3Dオブジェクトを実際に手で掴んで移動させているかのような直感的な操作感は得られない。 However, in the technique described in Patent Document 1, for example, when moving a 3D object, only the moving direction and moving speed of the 3D object are determined according to the designated coordinate position. You can't get an intuitive feel as if you were actually grabbing it with your hand.

また、上記特許文献2に記載の技術では、オブジェクトを所望の方向に回転させるときに、まず操作座標系の位置や角度を設定しなければならないため、操作に必要な手順が増えてしまうという問題がある。 In the technique described in Patent Document 2, when the object is rotated in a desired direction, the position and angle of the operation coordinate system must first be set, which increases the number of procedures necessary for the operation. There is.

それ故に、本発明の目的は、ポインティングデバイスを利用して仮想3次元空間内のオブジェクトを操作するときの操作性を向上し、より簡単かつ適切にオブジェクトを操作可能にすることである。 Therefore, an object of the present invention is to improve operability when an object in a virtual three-dimensional space is operated using a pointing device, and to make the object operable more easily and appropriately.

上記の目的を達成するために、本発明は以下のような構成を採用した。なお、括弧内の参照符号は、本発明の理解を助けるために図面との対応関係の一例を示したものであって、本発明の範囲を何ら限定するものではない。 In order to achieve the above object, the present invention employs the following configuration. The reference numerals in parentheses show an example of the correspondence with the drawings in order to help understanding of the present invention, and do not limit the scope of the present invention.

本発明の第1の局面は、コンピュータ(21)に、表示ステップ(S72)、検出ステップ(S14、S22、S38、S48、S56、S76、S88)、変換ステップ(S16、S24、S30、S40、S50、S58、S78、S90)、および制御ステップ(S18、S26、S32、S42、S52、S60、S66、S70、S80、S92)を実行させるための情報処理プログラム(41)である。表示ステップは、仮想3次元空間内に配置されたオブジェクトを仮想カメラから見たときの画像を表示画面(12)に表示するステップである。検出ステップは、ポインティングデバイス(15)からの出力信号に基づいて、2次元座標で表される指示ポイントを検出するステップである。変換ステップは、前記指示ポイントを、所定の演算処理により、3次元座標で表される1つ以上の制御用ポイントに変換するステップである。制御ステップは、前記制御用ポイントを利用して前記オブジェクトの動きを制御するステップである。前記変換ステップで変換される制御用ポイントは、前記表示画面上における前記指示ポイントの位置と同一の位置に表示される仮想3次元空間中のポイントであって、その奥行き方向の位置は、状況に応じて変化する。 The first aspect of the present invention provides a computer (21) with a display step (S72), a detection step (S14, S22, S38, S48, S56, S76, S88) and a conversion step (S16, S24, S30, S40, S50, S58, S78, S90) and an information processing program (41) for executing control steps (S18, S26, S32, S42, S52, S60, S66, S70, S80, S92). The display step is a step of displaying an image when the object arranged in the virtual three-dimensional space is viewed from the virtual camera on the display screen (12). The detecting step is a step of detecting an indication point represented by two-dimensional coordinates based on an output signal from the pointing device (15). The conversion step is a step of converting the indicated point into one or more control points represented by three-dimensional coordinates by a predetermined calculation process. The control step is a step of controlling the movement of the object using the control point. The control point converted in the conversion step is a point in the virtual three-dimensional space displayed at the same position as the indication point on the display screen, and the position in the depth direction depends on the situation. Will change accordingly.

ここで、仮想3次元空間内に配置されたオブジェクトを仮想カメラから見たときの画像を生成する典型的な方法としては、オブジェクトを構成する各ポリゴンの頂点座標(ワールド座標系)をカメラ座標系に変換した後、仮想スクリーンに投影変換する方法が挙げあれる。このような座標変換では、仮想カメラの位置や傾き(回転角度)や向き(視線方向)や視野角などを示すカメラ設定情報が適宜に利用される。 Here, as a typical method for generating an image when an object placed in a virtual three-dimensional space is viewed from a virtual camera, the vertex coordinates (world coordinate system) of each polygon constituting the object are represented by a camera coordinate system. There is a method of projecting and transforming to a virtual screen after converting to. In such coordinate conversion, camera setting information indicating the position, tilt (rotation angle), orientation (gaze direction), viewing angle, etc. of the virtual camera is appropriately used.

また、ポインティングデバイスとしては、一例としてタッチパネルやマウスを利用することができる。 As a pointing device, for example, a touch panel or a mouse can be used.

また、「状況に応じて変化する」とは、制御ステップにおける制御用ポイントの用途に応じて変化することや、制御ステップでの制御対象となるオブジェクトの種類に依存して変化することや、オブジェクトの動作モードに依存して変化することを少なくとも含み、さらには、時間に応じて変化することなども含む。 Also, “changes depending on the situation” means that it changes according to the use of the control point in the control step, changes depending on the type of object to be controlled in the control step, Including at least changing depending on the operation mode, and further including changing with time.

本発明の第2の局面は、上記第1の局面において、前記変換ステップで変換される制御用ポイントの奥行き方向の位置は、前記制御ステップにおける当該制御用ポイントの用途に応じて変化することを特徴とする。 According to a second aspect of the present invention, in the first aspect, the position in the depth direction of the control point converted in the conversion step changes according to the use of the control point in the control step. Features.

本発明の第3の局面は、上記第1の局面において、前記変換ステップで変換される制御用ポイントの奥行き方向の位置は、前記制御ステップでの制御対象となるオブジェクトの種類に依存して変化することを特徴とする。 According to a third aspect of the present invention, in the first aspect, the position in the depth direction of the control point converted in the conversion step varies depending on the type of object to be controlled in the control step. It is characterized by doing.

本発明の第4の局面は、上記第1の局面において、前記情報処理プログラムは、前記オブジェクトの動作モードを設定および更新し、当該設定または更新された動作モードを記憶装置に記憶するステップをさらに前記コンピュータに実行させるものであり、前記変換ステップで変換される制御用ポイントの奥行き方向の位置が、前記記憶装置に記憶されている動作モードに依存して変化することを特徴とする。 According to a fourth aspect of the present invention, in the first aspect, the information processing program further sets and updates the operation mode of the object, and further stores the set or updated operation mode in a storage device. What is executed by the computer is characterized in that the position in the depth direction of the control point converted in the conversion step changes depending on the operation mode stored in the storage device.

本発明の第5の局面は、上記第1の局面において、前記変換ステップは、前記指示ポイントを3次元座標で表される基本制御用ポイントに変換するステップと、当該基本制御用ポイントと仮想カメラの位置とを結んだ直線を求めるステップと、前記直線と仮想3次元空間内に設定された仮想面との交点を求めるステップとを含み(図12)、前記仮想面の位置または形状が、状況に応じて変化することを特徴とする。ここで、仮想面とは、平面であってもよいし曲面であってもよい。 According to a fifth aspect of the present invention, in the first aspect, the converting step includes a step of converting the indication point into a basic control point represented by three-dimensional coordinates, the basic control point, and a virtual camera. A step of obtaining a straight line connecting the positions of the straight line and a step of obtaining an intersection of the straight line and a virtual surface set in a virtual three-dimensional space (FIG. 12), wherein the position or shape of the virtual surface is a situation It changes according to. Here, the virtual surface may be a flat surface or a curved surface.

本発明の第6の局面は、上記第5の局面において、前記情報処理プログラムは、前記オブジェクトの動作モードを設定および更新し(S68)、当該設定または更新された動作モード(51)を記憶装置(24)に記憶するステップをさらに前記コンピュータに実行させるものであり、前記オブジェクトを基準とした前記仮想面の相対位置が、前記記憶装置に記憶されている動作モードに依存して変化することを特徴とする。 In a sixth aspect of the present invention based on the fifth aspect, the information processing program sets and updates the operation mode of the object (S68), and stores the set or updated operation mode (51) in the storage device. The step of storing in (24) is further executed by the computer, and the relative position of the virtual plane with respect to the object changes depending on the operation mode stored in the storage device. Features.

本発明の第7の局面は、上記第1の局面において、前記変換ステップでは、前記検出ステップで検出された指示ポイントが、第1のオブジェクトの制御のための第1の制御用ポ

イントと、第2のオブジェクトの制御のための第2の制御用ポイントとに変換され、前記変換ステップで変換される前記第1の制御用ポイントおよび前記第2の制御用ポイントは、いずれも、前記表示画面上における前記指示ポイントの位置と同一の位置に表示される仮想3次元空間中のポイントであり、前記制御ステップでは、前記第1のオブジェクトおよび前記第2のオブジェクトが、前記第1の制御用ポイントおよび前記第2の制御用ポイントをそれぞれ利用して個別にかつ同時に制御されることを特徴とする(図14)。

According to a seventh aspect of the present invention, in the first aspect, in the conversion step, the indication point detected in the detection step includes a first control point for controlling the first object, The first control point and the second control point that are converted to the second control point for controlling the two objects and converted in the conversion step are both on the display screen. In the virtual three-dimensional space displayed at the same position as the position of the indication point in the control step, and in the control step, the first object and the second object are the first control point and The second control points are used individually and simultaneously for control (FIG. 14).

本発明の第8の局面は、表示画面(12)と、ポインティングデバイス(15)と、表示制御手段(21)と、検出手段(21)と、変換手段(21)と、制御手段(21)とを備えた情報処理装置である。表示制御手段は、仮想3次元空間内に配置されたオブジェクトを仮想カメラから見たときの画像を前記表示画面に表示する手段である。検出手段は、前記ポインティングデバイスからの出力信号に基づいて、2次元座標で表される指示ポイントを検出する手段である。変換手段は、前記指示ポイントを、所定の演算処理により、3次元座標で表される1つ以上の制御用ポイントに変換する手段である。制御手段は、前記制御用ポイントを利用して前記オブジェクトの動きを制御する手段である。前記変換手段によって変換される制御用ポイントは、前記表示画面上における前記指示ポイントの位置と同一の位置に表示される仮想3次元空間中のポイントであって、その奥行き方向の位置は、状況に応じて変化する。 The eighth aspect of the present invention includes a display screen (12), a pointing device (15), a display control means (21), a detection means (21), a conversion means (21), and a control means (21). Is an information processing apparatus. The display control means is means for displaying an image when an object arranged in the virtual three-dimensional space is viewed from the virtual camera on the display screen. The detecting means is means for detecting an indication point represented by two-dimensional coordinates based on an output signal from the pointing device. The converting means is means for converting the indicated point into one or more control points represented by three-dimensional coordinates by a predetermined calculation process. The control means is means for controlling the movement of the object using the control point. The control point converted by the conversion means is a point in the virtual three-dimensional space that is displayed at the same position as the indication point on the display screen, and the position in the depth direction depends on the situation. Will change accordingly.

本発明の第9の局面は、コンピュータ(21)に、表示ステップ、検出ステップ、変換ステップ、および制御ステップを実行させるための情報処理プログラムである。表示ステップは、仮想3次元空間内に配置された1以上のオブジェクトを仮想カメラから見たときの画像を画面(12)に表示するステップである。検出ステップは、ポインティングデバイス(15)からの出力信号に基づいて、2次元座標で表される指示ポイントを検出するステップである。変換ステップは、前記指示ポイントを、所定の演算処理により、3次元座標で表される複数の制御用ポイントに変換するステップである。制御ステップは、前記制御用ポイントを利用して前記1以上のオブジェクトの動きを制御するステップである。前記変換ステップでは、前記検出ステップで検出された指示ポイントが、第1の制御用ポイントと第2の制御用ポイントとに変換され、前記制御ステップでは、前記第1の制御用ポイントおよび前記第2の制御用ポイントを利用して前記1以上のオブジェクトの動きが制御される(図21)。 A ninth aspect of the present invention is an information processing program for causing a computer (21) to execute a display step, a detection step, a conversion step, and a control step. The display step is a step of displaying, on the screen (12), an image when one or more objects arranged in the virtual three-dimensional space are viewed from the virtual camera. The detecting step is a step of detecting an indication point represented by two-dimensional coordinates based on an output signal from the pointing device (15). The conversion step is a step of converting the indicated point into a plurality of control points represented by three-dimensional coordinates by a predetermined calculation process. The control step is a step of controlling movement of the one or more objects using the control point. In the conversion step, the indication point detected in the detection step is converted into a first control point and a second control point, and in the control step, the first control point and the second control point are converted. The movement of the one or more objects is controlled using the control points (FIG. 21).

本発明の第10の局面は、上記第9の局面において、前記制御ステップでは、仮想3次元空間内に配置された第1のオブジェクトおよび第2のオブジェクトが、前記第1の制御用ポイントおよび前記第2の制御用ポイントをそれぞれ利用して個別にかつ同時に制御されることを特徴とする(図21)。 In a tenth aspect of the present invention based on the ninth aspect described above, in the control step, the first object and the second object arranged in the virtual three-dimensional space are the first control point and the Control is performed individually and simultaneously using the second control points (FIG. 21).

本発明の第11の局面は、表示画面(12)と、ポインティングデバイス(15)と、表示制御手段(21)と、検出手段(21)と、変換手段(21)と、制御手段(21)とを備えた情報処理装置である。表示制御手段は、仮想3次元空間内に配置された1以上のオブジェクトを仮想カメラから見たときの画像を前記表示画面に表示する手段である。検出手段は、前記ポインティングデバイスからの出力信号に基づいて、2次元座標で表される指示ポイントを検出する手段である。変換手段は、前記指示ポイントを、所定の演算処理により、3次元座標で表される複数の制御用ポイントに変換する手段である。制御手段は、前記制御用ポイントを利用して前記1以上のオブジェクトの動きを制御する手段である。前記変換手段は、前記検出手段によって検出された指示ポイントを、第1の制御用ポイントと第2の制御用ポイントとに変換し、前記制御手段は、前記第1の制御用ポイントおよび前記第2の制御用ポイントを利用して前記1以上のオブジェクトの動きを制御する(図21)。 The eleventh aspect of the present invention includes a display screen (12), a pointing device (15), display control means (21), detection means (21), conversion means (21), and control means (21). Is an information processing apparatus. The display control means is a means for displaying an image when one or more objects arranged in the virtual three-dimensional space are viewed from the virtual camera on the display screen. The detecting means is means for detecting an indication point represented by two-dimensional coordinates based on an output signal from the pointing device. The conversion means is means for converting the indicated point into a plurality of control points represented by three-dimensional coordinates by a predetermined calculation process. The control means is means for controlling movement of the one or more objects using the control points. The converting means converts the indication point detected by the detecting means into a first control point and a second control point, and the control means includes the first control point and the second control point. The movement of the one or more objects is controlled using the control points (FIG. 21).

本発明の第1の局面によれば、指示ポイントに対応する制御用ポイントの奥行き方向の位置が状況に応じて自動的に変化するため、操作者は、わざわざ奥行き方向の位置を指定したりする手間をかけること無しに、オブジェクトの動きを簡易にかつ適切に制御することができる。 According to the first aspect of the present invention, since the position in the depth direction of the control point corresponding to the indication point automatically changes according to the situation, the operator purposely designates the position in the depth direction. The movement of the object can be easily and appropriately controlled without taking time and effort.

本発明の第2の局面によれば、指示ポイントに対応する制御用ポイントの奥行き方向の位置が、制御用ポイントの用途に応じて変化するため、制御用ポイントが種々の用途で利用される場合においても、操作者は、わざわざ制御用ポイントの奥行き方向の位置を各用途に応じた最適な位置に指定したりする手間をかけること無しに、オブジェクトの動きを簡易にかつ適切に制御することが可能となる。 According to the second aspect of the present invention, since the position in the depth direction of the control point corresponding to the instruction point changes according to the use of the control point, the control point is used for various purposes. However, the operator can easily and appropriately control the movement of the object without having to bother to specify the position of the control point in the depth direction to the optimum position for each application. It becomes possible.

本発明の第3の局面によれば、指示ポイントに対応する制御用ポイントの奥行き方向の位置が、制御対象となるオブジェクトの種類に応じて変化するため、操作者は、わざわざ制御用ポイントの奥行き方向の位置をオブジェクトの種類に応じた最適な位置に指定したりする手間をかけること無しに、オブジェクトの動きを簡易にかつ適切に制御することが可能となる。 According to the third aspect of the present invention, since the position in the depth direction of the control point corresponding to the instruction point changes according to the type of the object to be controlled, the operator has to bother the depth of the control point. It is possible to easily and appropriately control the movement of the object without taking the trouble of designating the position of the direction to the optimum position according to the type of the object.

本発明の第4の局面によれば、指示ポイントに対応する制御用ポイントの奥行き方向の位置が、制御対象となるオブジェクトの動作モードに応じて変化するため、操作者は、わざわざ制御用ポイントの奥行き方向の位置をオブジェクトの動作モードに応じた最適な位置に指定したりする手間をかけること無しに、オブジェクトの動きを簡易にかつ適切に制御することが可能となる。 According to the fourth aspect of the present invention, since the position in the depth direction of the control point corresponding to the instruction point changes according to the operation mode of the object to be controlled, the operator has to bother the control point. It is possible to easily and appropriately control the movement of the object without taking the trouble of designating the position in the depth direction to an optimal position according to the operation mode of the object.

本発明の第5の局面によれば、画一的な手法により指示ポイントを制御用ポイントに変換することができるので、座標変換のためのアルゴリズムをより簡素化できる。 According to the fifth aspect of the present invention, since the indication point can be converted into the control point by a uniform method, the algorithm for coordinate conversion can be further simplified.

本発明の第6の局面によれば、オブジェクトの動作モードに応じてオブジェクトに対する仮想面の相対位置が変化するので、動作モードに応じてオブジェクトの動きをより適切に制御することができる。 According to the sixth aspect of the present invention, since the relative position of the virtual plane with respect to the object changes according to the operation mode of the object, the movement of the object can be controlled more appropriately according to the operation mode.

本発明の第7の局面によれば、ポインティングデバイスを用いて仮想3次元空間内の2つのオブジェクトを同時にかつ互いに同期して動作させることが容易に可能となる。また、指示ポイントとこの指示ポイントに基づく2つの制御用ポイントの画面上の位置が一致しているので、操作者は2つの制御用ポイントの位置を容易に把握することができ、操作性が良い。 According to the seventh aspect of the present invention, it is possible to easily operate two objects in a virtual three-dimensional space simultaneously and in synchronization with each other using a pointing device. In addition, since the position on the screen of the instruction point and the two control points based on the instruction point coincide with each other, the operator can easily grasp the positions of the two control points, and the operability is good. .

本発明の第8の局面によれば、第1の局面と同様の効果が得られる。 According to the eighth aspect of the present invention, the same effect as in the first aspect can be obtained.

本発明の第9の局面によれば、指示ポイントに基づく2つの制御用ポイントを利用して仮想3次元空間内の1以上のオブジェクトを動作させることができるため、1以上のオブジェクトにより多様な動作をさせることが可能となる。 According to the ninth aspect of the present invention, since one or more objects in the virtual three-dimensional space can be operated using two control points based on the indication point, various operations can be performed by one or more objects. It becomes possible to make it.

本発明の第10の局面によれば、ポインティングデバイスを用いて仮想3次元空間内の2つのオブジェクトを同時にかつ互いに同期して動作させることが容易となる。 According to the tenth aspect of the present invention, it becomes easy to operate two objects in a virtual three-dimensional space simultaneously and in synchronization with each other using a pointing device.

本発明の第11の局面によれば、第9の局面と同様の効果が得られる。 According to the eleventh aspect of the present invention, the same effect as in the ninth aspect can be obtained.

以下、本発明の一実施形態に係るゲーム装置の構成および動作を説明する。 The configuration and operation of the game device according to one embodiment of the present invention will be described below.

図1は、本発明の一実施形態に係るゲーム装置の外観図である。図1において、ゲーム装置10は、第1のLCD(Liquid Crystal Display:液晶表示装置)11および第2のLCD12を含む。ハウジング13は上側ハウジング13aと下側ハウジング13bとによって構成されており、第1のLCD11は上側ハウジング13aに収納され、第2のLCD12は下側ハウジング13bに収納される。第1のLCD11および第2のLCD12の解像度はいずれも256dot×192dotである。なお、本実施形態では表示装置としてLCDを用いているが、例えばEL(Electro Luminescence:電界発光)を利用した表示装置など、他の任意の表示装置を利用することができる。また任意の解像度のものを利用することができる。

FIG. 1 is an external view of a game device according to an embodiment of the present invention. In FIG. 1, the

上側ハウジング13aには、後述する1対のスピーカ(図2の30a、30b)からの音を外部に放出するための音抜き孔18a、18bが形成されている。

The

下側ハウジング13bには、入力装置として、十字スイッチ14a、スタートスイッチ14b、セレクトスイッチ14c、Aボタン14d、Bボタン14e、Xボタン14f、Yボタン14g、Lボタン14LおよびRボタン14Rが設けられている。また、さらなる入力装置として、第2のLCD12の画面上にタッチパネル15が装着されている。また、下側ハウジング13bには、電源スイッチ19や、メモリカード17やスティック16を収納するための挿入口も設けられている。

The

タッチパネル15としては、例えば抵抗膜方式や光学式(赤外線方式)や静電容量結合式など、任意の方式のものを利用することができる。タッチパネル15は、その表面をスティック16で触れると、その接触位置に対応する座標データを出力する機能を有している。なお、以下ではプレイヤがタッチパネル15をスティック16で操作するものとして説明を行うが、スティック16の代わりにペン(スタイラスペン)や指でタッチパネル15を操作することももちろん可能である。本実施形態では、タッチパネル15として、第2のLCD12の解像度と同じく256dot×192dotの解像度(検出精度)のものを利用する。ただし、必ずしもタッチパネル15の解像度と第2のLCD12の解像度が一致している必要はない。

As the

メモリカード17はゲームプログラムを記録した記録媒体であり、下部ハウジング13bに設けられた挿入口に着脱自在に装着される。

The

次に、図2を参照してゲーム装置10の内部構成を説明する。

Next, the internal configuration of the

図2において、ハウジング13に収納される電子回路基板20には、CPUコア21が実装される。CPUコア21には、バス22を介して、コネクタ23が接続されるとともに、入出力インターフェース回路(図面ではI/F回路と記す)25、第1GPU(Graphics Processing Unit)26、第2GPU27、RAM24およびLCDコントローラ31が接続される。コネクタ23には、メモリカード17が着脱自在に接続される。メモリカード17は、ゲームプログラムを記憶するROM17aと、バックアップデータを書き換え可能に記憶するRAM17bを搭載する。メモリカード17のROM17aに記憶されたゲームプログラムはRAM24にロードされ、RAM24にロードされたゲームプログラムがCPUコア21によって実行される。RAM24には、ゲームプログラムの他にも、CPUコア21がゲームプログラムを実行して得られる一時的なデータや、ゲーム画像を生成するためのデータが記憶される。I/F回路25には、タッチパネル15、右スピーカ30a、左スピーカ30bおよび図1の十字スイッチ14aやAボタン14d等から成る操作スイッチ部14が接続される。右スピーカ30aと左スピーカ30bは、音抜き孔18a、18bの内側にそれぞれ配置される。

In FIG. 2, a

第1GPU26には、第1VRAM(Video RAM)28が接続され、第2GPU27には、第2VRAM29が接続される。第1GPU26は、CPUコア21からの指示に応じて、RAM24に記憶されているゲーム画像を生成するためのデータに基づいて第1のゲーム画像を生成し、第1VRAM28に描画する。第2GPU27は、同様にCPUコア21からの指示に応じて第2のゲーム画像を生成し、第2VRAM29に描画する。第1VRAM28および第2VRAM29はLCDコントローラ31に接続されている。

A first VRAM (Video RAM) 28 is connected to the

LCDコントローラ31はレジスタ32を含む。レジスタ32はCPUコア21からの指示に応じて0または1の値を記憶する。LCDコントローラ31は、レジスタ32の値が0の場合は、第1VRAM28に描画された第1のゲーム画像を第1のLCD11に出力し、第2VRAM29に描画された第2のゲーム画像を第2のLCD12に出力する。また、レジスタ32の値が1の場合は、第1VRAM28に描画された第1のゲーム画像を第2のLCD12に出力し、第2VRAM29に描画された第2のゲーム画像を第1のLCD11に出力する。

The

なお、上記のようなゲーム装置10の構成は単なる一例に過ぎず、本発明は、ポインティングデバイス(タッチパネルに限らず、例えばマウスやタッチパッドやジョイスティックなどでもよい)と表示装置を有する任意の情報処理装置に適用することができる。また、本発明のゲームプログラムは、メモリカード17などの外部記憶媒体を通じて情報処理装置に供給されるだけでなく、有線または無線の通信回線を通じて情報処理装置に供給されてもよいし、さらには情報処理装置内部の不揮発性記憶装置に予め記録されていてもよい。

Note that the configuration of the

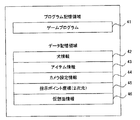

図3に、RAM24のメモリマップを示す。RAM24の記憶領域は、大きく分けると、プログラム記憶領域とデータ記憶領域から成る。

FIG. 3 shows a memory map of the

プログラム記憶領域には、メモリカード17のROM17aからゲームプログラム41がロードされる。

A

データ記憶領域には、犬情報42、アイテム情報43、カメラ設定情報44、指示ポイント座標45、および仮想面情報46が格納される。

In the data storage area,

犬情報42は、仮想3次元空間に存在する犬(より正確には犬を表すオブジェクト)に関する種々の情報であって、具体的には、図4に示すように、形状データ、テクスチャデータ、配置座標、動作モード51、および注目点座標52から成る。本実施形態では、仮想3次元空間に配置された犬は、所定のアルゴリズムに従って、まるで自分の意志で動いているかのように仮想3次元空間内を自律的に移動するものとする。

The

形状データは、オブジェクトの形状に関するデータであって、例えばオブジェクトを構成するポリゴンの頂点座標などである。テクスチャデータは、オブジェクトを構成するポリゴンに貼り付けられる画像データである。配置座標は、仮想3次元空間における犬の配置座標である。 The shape data is data relating to the shape of the object, and is, for example, vertex coordinates of polygons constituting the object. The texture data is image data that is pasted on the polygons that make up the object. The arrangement coordinates are the arrangement coordinates of the dog in the virtual three-dimensional space.

動作モード51は、犬の現在の動作モードであって、動作モードの種類としては、後述するように、平常モード、注目モード、舐めモード、縄回しモード、噛みモード、お回りモードの6つの動作モードが存在する。動作モード51は、前述のアルゴリズムに従って適宜に変化する。例えば、後述するアイテムのうちの「縄」が仮想3次元空間に配置された場合には、犬はその縄に近づいて縄の端を加えるように自動制御される。そして、犬が

縄の端を加えた時点で犬の動作モードが縄回しモードに変更される。

The

注目点座標52は、仮想3次元空間における犬の注目点を示す座標である。この注目点座標52は、犬の動作モードが注目モード、舐めモード、縄回しモードおよびお回りモードのときに利用され、具体的には、犬が注目点座標52を向くように犬の頭部の位置および角度が制御される。 The attention point coordinate 52 is a coordinate indicating the attention point of the dog in the virtual three-dimensional space. The attention point coordinates 52 are used when the operation mode of the dog is the attention mode, the licking mode, the rope turning mode, and the turning mode, and specifically, the dog's head so that the dog faces the attention point coordinates 52. Is controlled in position and angle.

アイテム情報43は、仮想3次元に配置される各種アイテムに関する種々の情報である。本実施形態では、仮想3次元に配置されるアイテムとして、図5に示すように、ボール、縄、タオルがあるものとする。ボールに関する情報としては、形状データ、テクスチャデータ、配置座標53がある。配置座標53は、仮想3次元空間におけるボールの配置座標である。縄に関する情報としては、形状データ、テクスチャデータ、手前端部座標54がある。手前端部座標54は、仮想3次元空間における縄の手前端部(縄の両端部のうち、プレイヤから見たときに手前にあるように表示される端部)の配置座標である。タオルに関する情報としては、形状データ、テクスチャデータ、手前端部座標55、動作モード56がある。手前端部座標55は、仮想3次元空間におけるタオルの手前端部(タオルの両端部のうち、プレイヤから見たときに手前にあるように表示される端部)の配置座標である。

The

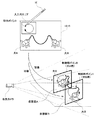

カメラ設定情報44は、仮想3次元空間に配置される仮想カメラに関する種々の設定値から成る情報であって、例えば、仮想カメラの配置座標、傾き(回転角度)、向き(視線方向)、視野角などである。図6に、仮想3次元空間における仮想カメラの配置例を示す。第2のLCD12には、仮想3次元空間に配置された犬やアイテムや地面などのオブジェクトを仮想カメラから見たシーンがゲーム画像として表示される。図7は、図6の仮想カメラに基づいて第2のLCD12に表示されたゲーム画像を示している。仮想カメラに基づいて仮想3次元空間の画像を生成する方法は周知技術であるため、ここではその詳細な説明は省略するが、簡単に説明すると、ワールド座標系で表されている各オブジェクトの頂点座標(より正確にはオブジェクトを構成するポリゴンの頂点座標)を仮想カメラを基準としたカメラ座標系に変換し、さらに透視投影変換を行うことによってそれらの頂点座標が2次元座標に変換される。

The

指示ポイント座標45は、プレイヤが指やスティック16でタッチパネル15に触れたときの接触位置を示す座標であって、2次元座標で表される。この指示ポイント座標45はタッチパネル15の出力信号に基づいて随時更新される。

The designated point coordinates 45 are coordinates indicating a contact position when the player touches the

仮想面情報46は、制御対象オブジェクトの種類および制御対象オブジェクトの動作モードと、仮想3次元空間に設定される仮想面との対応関係を示す情報である。仮想面とは、指示ポイント座標45を、オブジェクトの動きの制御に利用される仮想3次元空間内のポイント(制御用ポイント)に変換するときに利用される仮想的な面であって、平面であっても良いし、曲面であっても良い。また仮想面は、可視であっても良いし、不可視であっても良い。仮想平面を用いた指示ポイント座標45から制御用ポイントへの座標変換の詳細については後述する。

The

図6に、仮想面情報46の一例を示す。この例では、制御対象オブジェクトがボールまたは縄であるときには第1仮想面(図9参照)が上記座標変換の演算に利用される。また、制御対象オブジェクトがタオルであってかつその動作モードが自由モードであるときには第1仮想面が利用され、制御対象オブジェクトがタオルであってかつその動作モードが噛まれモードであるときには第5仮想面が利用される。また、操作対象オブジェクトが犬であってかつその動作モードが注目モードであるときには第2仮想面が利用され、操作対象オブジェクトが犬であってかつその動作モードが舐めモードであるときには第3仮想面が利用され、操作対象オブジェクトが犬であってかつその動作モードが縄回しモードであるときには第4仮想面が利用され、操作対象オブジェクトが犬であってかつその動作モードがお回りモードであるときには第5仮想面が利用される。なお、操作対象オブジェクトが犬であってかつその動作モードが平常モードまたは噛みモードであるときには、犬の動きの制御に制御用ポイントが直接的には利用されないので、仮想面を用いた座標変換は不要である。

FIG. 6 shows an example of the

図9に、上記第1仮想面から第5仮想面の具体的な配置例を示す。第1仮想面は、地面に対して垂直な仮想面であって、その位置は犬の位置に依存することなく仮想3次元空間において常に一定である。第2仮想面、第3仮想面および第4仮想面は、地面に対して垂直な仮想面であって、その位置は制御対象となる犬の位置を基準として、犬の位置からそれぞれ所定距離だけ仮想カメラ方向にずらした位置に配置される。つまり、これらの3つの仮想面の位置は、制御対象となる犬の位置に依存して変化する。図9に示すように、これらの3つの仮想面のうち、第2仮想面は犬から最も離れ、かつ仮想カメラに最も近い位置に配置され、第4仮想面は犬に最も近く、かつ仮想カメラから最も遠い位置に配置される。第5仮想面は、犬の動作モードが噛みモードのとき(つまりタオルの動作モードが噛まれモードのとき)と、犬の動作モードがお回りモードのときに利用される仮想面であって、犬の上方にかつ地面に対して水平に配置される。第5仮想面の位置も、犬の位置に依存することなく仮想3次元空間において常に一定である。なお、第5仮想面が利用されるとき(すなわち犬の動作モードが噛みモードまたはお回りモードのとき)には、仮想カメラの位置が図9に示すように犬を上から見下ろすような位置に一時的に変更される。 FIG. 9 shows a specific arrangement example of the first to fifth virtual surfaces. The first virtual plane is a virtual plane perpendicular to the ground, and its position is always constant in the virtual three-dimensional space without depending on the position of the dog. The second virtual plane, the third virtual plane, and the fourth virtual plane are virtual planes perpendicular to the ground, and their positions are a predetermined distance from the dog position with reference to the dog position to be controlled. It is arranged at a position shifted in the virtual camera direction. That is, the positions of these three virtual surfaces change depending on the position of the dog to be controlled. As shown in FIG. 9, among these three virtual planes, the second virtual plane is located farthest from the dog and closest to the virtual camera, the fourth virtual plane is closest to the dog, and the virtual camera Placed farthest from the center. The fifth virtual plane is a virtual plane used when the dog operation mode is the chewing mode (that is, when the towel operation mode is the chewing mode) and when the dog operation mode is the turn mode, Located above the dog and horizontally with respect to the ground. The position of the fifth virtual plane is also always constant in the virtual three-dimensional space without depending on the position of the dog. When the fifth virtual plane is used (that is, when the dog operation mode is the chewing mode or the turn mode), the virtual camera is positioned so as to look down on the dog as shown in FIG. Temporarily changed.

以下、図10〜図15を参照して、第1仮想面から第5仮想面の各仮想面の利用例を説明する。 Hereinafter, with reference to FIGS. 10 to 15, a usage example of each virtual surface from the first virtual surface to the fifth virtual surface will be described.

図10は、第1仮想面の利用例を示す図である。第1仮想面は、プレイヤが仮想3次元空間においてアイテムとしてボールや縄やタオルを使用するときに利用される仮想面である。より具体的に説明すると、プレイヤは、操作スイッチ部14を操作することによってアイテム選択画面を呼び出し、そのアイテム選択画面においてボールか縄かタオルのいずれかを選択し、その後、スティック16をタッチパネル15上の所望の位置に接触させることによって、その位置に対応する仮想3次元空間内のポイントに、選択したアイテムを配置することができる。図10は、プレイヤがボールを配置する場合の例である。タッチパネル15上の各点は、第1仮想面上の各点に一対一にそれぞれ対応付けられており(すなわち一対一の写像の関係)、スティック16の接触位置(指示ポイント)に対応する第1仮想面上の点(制御用ポイント)にボールが配置される。そして、プレイヤがタッチパネル15上でスティック16をすべらせると、それに応じて第1仮想面上のボールの位置も移動する。なお、指示ポイントから制御用ポイントへの座標変換は、予め用意したマッピングデータを利用して行ってもよいし、行列を用いた演算によって行ってもよい。

FIG. 10 is a diagram illustrating a usage example of the first virtual surface. The first virtual surface is a virtual surface used when the player uses a ball, a rope or a towel as an item in the virtual three-dimensional space. More specifically, the player calls an item selection screen by operating the

図11は、第2仮想面の利用例を示す図である。第2仮想面は、犬の動作モードが注目モードのときに、この犬の動きを制御するために利用される仮想面である。注目モードとは、例えば犬がプレイヤに少しだけ興味を抱いているときの犬の動作モードであって、この注目モードでは、プレイヤがタッチした点に注目するように、犬の動き(特に頭部の動き)が制御される。なお、犬がプレイヤに全く興味を抱いていないときには、プレイヤがタッチパネル15にタッチしても犬は無視し(平常モード)、犬がプレイヤに大いに興味を抱いているときには、プレイヤがタッチした点を舐めるようになる(後述する舐めモード)。なお、プレイヤに対する犬の興味度合は種々の条件に応じて随時変化し、その変化に応じて犬の動作モードが随時更新されるものとする。

FIG. 11 is a diagram illustrating an example of using the second virtual surface. The second virtual surface is a virtual surface used for controlling the movement of the dog when the dog operation mode is the attention mode. The attention mode is an operation mode of the dog when the dog is slightly interested in the player, for example. In this attention mode, the movement of the dog (particularly the head) Is controlled). When the dog is not interested in the player at all, even if the player touches the

注目モード時には、図11に示すようにプレイヤがスティック16をタッチパネル15

上の所望の位置に接触させると、その接触位置(指示ポイント)に対応する第2仮想面上の点(制御用ポイント)が、犬の注目点として設定される。なお、タッチパネル15上の各点が第2仮想面上の各点に一対一にそれぞれ対応付けられている点は、第1仮想面と同様であり、さらにこれは第3仮想面から第5仮想面についても同様である。第2仮想面上の制御用ポイントが犬の注目点として設定された結果、犬は、その制御用ポイントを注目しているかのように、その動きが制御される。そして、プレイヤがタッチパネル15上でスティック16をすべらせると、その接触位置を目で追うように犬は動作する。

In the attention mode, the player holds the

When contact is made with a desired position above, a point (control point) on the second virtual plane corresponding to the contact position (instruction point) is set as a point of interest of the dog. Note that each point on the

なお、指示ポイントから制御用ポイントへの座標変換は、予め用意したマッピングデータを利用して行ってもよいし、行列を用いた演算によって行ってもよい。さらには、図12に示すように、図10を用いて説明した要領で指示ポイントに対応する第1仮想面上の点を一旦求めた後、この点(以下、基本制御用ポイントと称す)と仮想カメラの位置とを結ぶ直線を求め、この直線と第2仮想面との交点(この交点が第2仮想面上の制御用ポイントとなる)を演算によって求めるようにしてもよい。これは、指示ポイントを第3仮想面および第4仮想面における制御用ポイントに変換する場合にも同様である。このような変換方法によれば、基本制御用ポイントから第2〜第4仮想面の各仮想面上の制御用ポイントへの変換処理は、非常に単純な演算によって実現できるため、例えば、指示ポイントを基本制御用ポイントに変換する処理をゲームプログラム41のメインルーチンに組み込んでおくことで、第2〜第4仮想面の各仮想面上の制御用ポイントを求める必要が生じたときに、すでに得られている基本制御用ポイントを利用して制御用ポイントを簡単に求めることができ、ゲームプログラム41の構造を簡素化することができる。なお、基本制御用ポイントは必ずしも第1仮想面上に設定される必要はなく、第1仮想面とは別の仮想面上に設定されてもよい。その場合には、基本制御用ポイントを用いて第1仮想面上の制御用ポイントを簡単に求めることができる。

Note that the coordinate conversion from the instruction point to the control point may be performed using mapping data prepared in advance, or may be performed by calculation using a matrix. Furthermore, as shown in FIG. 12, after obtaining a point on the first virtual plane corresponding to the designated point once in the manner described with reference to FIG. 10, this point (hereinafter referred to as a basic control point) A straight line connecting the position of the virtual camera may be obtained, and an intersection between the straight line and the second virtual surface (this intersection becomes a control point on the second virtual surface) may be obtained by calculation. The same applies to the case where the indication points are converted into control points on the third virtual plane and the fourth virtual plane. According to such a conversion method, the conversion process from the basic control point to the control point on each virtual surface of the second to fourth virtual surfaces can be realized by a very simple calculation. By incorporating the process of converting the point into the basic control point into the main routine of the

図13は、第3仮想面の利用例を示す図である。第3仮想面は、犬の動作モードが舐めモードのときに、この犬の動きを制御するために利用される仮想面である。注目モードとは、例えば犬がプレイヤに大いに興味を抱いているときの犬の動作モードであって、この舐めモードでは、プレイヤがタッチした点を舌で舐めるように、犬の動き(特に頭部の動き)が制御される。なお、注目モード時の仮想面の位置を舐めモード時と比べて犬から離しているのは、その方が第2のLCD12に表示される犬の挙動が違和感が無くなるためである。例えば、注目モード時の仮想面の位置を舐めモード時と同じ位置に設定すると、プレイヤにとっては、犬が接触点から少しだけずれた方向を向いているように見えてしまい、違和感を覚える。

FIG. 13 is a diagram illustrating a usage example of the third virtual surface. The third virtual surface is a virtual surface used for controlling the movement of the dog when the dog operation mode is the licking mode. The attention mode is, for example, a dog operation mode when the dog is greatly interested in the player. In this licking mode, the dog movement (especially the head) is used to lick the point touched by the player with the tongue. Is controlled). The reason why the position of the virtual plane in the attention mode is farther from the dog than in the licking mode is that the behavior of the dog displayed on the

図14は、第4仮想面の利用例を示す図である。第4仮想面は、犬の動作モードが縄回しモードのときに、この犬の動きを制御するために利用される仮想面である。縄回しモードとは、プレイヤが仮想3次元空間に配置した縄の端(奥端部)を犬がくわえたときの犬の動作モードであって、この縄回しモードでは、指示ポイントに対応する第4仮想面上の制御用ポイントが犬の注目点として設定される。一方、縄の手前端部については、図10と同様に、指示ポイントに対応する第1仮想面上の制御用ポイントに配置される。また、縄の中央部分については、端部の動きに追従するようにその座標が随時更新され、実際の縄のような動きをする。その結果、プレイヤがタッチパネル15上で円を描くようにスティック16をすべらせると、このスティック16の動きに連動して、接触位置に表示される縄の手間端部と、縄の奥側端部をくわえている犬の頭部とが動作し、犬と一緒に縄を回している感覚をプレイヤに与えることができる。なお、第4仮想面の位置を第2仮想面および第3仮想面よりも犬寄りにしているのは、縄の奥側端部の動きを大きくするためである。縄の奥側端部の動きが大きくなると、縄の中央部分も動きやすくなり、縄が回りやすくなる。

FIG. 14 is a diagram illustrating an example of use of the fourth virtual surface. The fourth virtual surface is a virtual surface used for controlling the movement of the dog when the dog operation mode is the rope-turning mode. The rope rotation mode is a dog operation mode when the dog holds the end (back end) of the rope arranged in the virtual three-dimensional space by the player. In this rope rotation mode, 4. A control point on the virtual plane is set as a point of interest of the dog. On the other hand, the front end portion of the rope is arranged at a control point on the first virtual plane corresponding to the instruction point, as in FIG. Further, the coordinates of the central portion of the rope are updated at any time so as to follow the movement of the end portion, and move like an actual rope. As a result, when the player slides the

図15は、第5仮想面の利用例を示す図である。第5仮想面は、プレイヤが図10のようにして仮想3次元空間の第1仮想面上にタオルを配置した後、このタオルの端を犬がくわえたとき(すなわち噛まれモードのとき)に利用される仮想面である。また、第5仮想面は、プレイヤが操作スイッチ部14を操作することによってモード選択画面を呼び出し、そのモード選択画面においてお回りモードを選択したときにも利用される。噛まれモードでは、指示ポイントが第5仮想面上の制御用ポイントに変換され、この制御用ポイントにタオルの手前端部が配置される。なお、タオルの奥側端部は犬に噛まれているため、プレイヤがタッチパネル15上でスティック16をスライドさせることによってタオルが移動し、さらにタオルに引きずられるようにして犬も移動する。また、お回りモードでは、指示ポイントが第5仮想面上の制御用ポイントに変換され、この制御用ポイント犬の注目点として設定され、犬はその注目点の方向に顔と体を向けるように移動制御される。よって、プレイヤがタッチパネル15上で円を描くようにスティック16をスライドさせれば、犬はその接触位置を追って回転(すなわちお回り)する。

FIG. 15 is a diagram illustrating a usage example of the fifth virtual surface. The fifth virtual plane is when the player places a towel on the first virtual plane of the virtual three-dimensional space as shown in FIG. 10 and then the dog holds the end of the towel (that is, in the biting mode). It is a virtual surface used. The fifth virtual surface is also used when the player calls the mode selection screen by operating the

以下、図16〜図20のフローチャートを参照して、ゲームプログラム41に従ったCPUコア21の処理の流れを説明する。

Hereinafter, the processing flow of the

図16において、ゲームが開始されると、まずステップS10でCPUコア21は仮想3次元空間において仮想カメラとオブジェクト(犬、地面)をそれぞれの初期位置に配置する。

In FIG. 16, when the game is started, first, in step S10, the

ステップS12では、プレイヤによってボールが使用されている(すなわち図10の状態)かどうかを判断し、ボールが使用されている場合にはステップS14に進み、ボールが使用されていない場合にはステップS20に進む。なお、図16〜図20のフローチャートでは、プレイヤがアイテム選択画面を呼び出してアイテムを選択したり、モード選択画面を呼び出してお回りモードを選択したりといった処理については省略している。 In step S12, it is determined whether or not the ball is used by the player (that is, the state shown in FIG. 10). If the ball is used, the process proceeds to step S14. If the ball is not used, step S20 is performed. Proceed to In the flowcharts of FIGS. 16 to 20, processes such as the player calling an item selection screen to select an item or calling a mode selection screen to select a rotation mode are omitted.

ステップS14では、タッチパネル15の出力信号に基づいて指示ポイントを検出し、図5の指示ポイント座標としてRAM24に記憶する。

In step S14, an instruction point is detected based on the output signal of the

ステップS16では、ステップS14で検出した指示ポイントを前述した方法で第1仮想面上の制御用ポイントに変換する。 In step S16, the indication point detected in step S14 is converted into a control point on the first virtual plane by the method described above.

ステップS18では、ステップS16で求めた第1仮想面上の制御用ポイントにボールを配置する。より具体的には、ステップS16で求めた制御用ポイントを、図5の配置座標53としてRAM24に格納する。この配置座標53は、後述する図18のステップS72でゲーム画像を生成するときに参照され、その結果、図10のようにボールが第2のLCD12に表示されることになる。

In step S18, the ball is placed at the control point on the first virtual plane obtained in step S16. More specifically, the control point obtained in step S16 is stored in the

ステップS20では、プレイヤによって縄が使用されているかどうかを判断し、縄が使用されている場合にはステップS22に進み、縄が使用されていない場合には図17のステップS34に進む。 In step S20, it is determined whether or not the rope is used by the player. If the rope is used, the process proceeds to step S22. If the rope is not used, the process proceeds to step S34 in FIG.

ステップS22およびステップS24は、前述のステップS14およびステップS16とそれぞれ同じ処理である。 Steps S22 and S24 are the same processes as steps S14 and S16, respectively.

ステップS26では、ステップS24で求めた第1仮想面上の制御用ポイントに縄の手前端部を配置する。より具体的には、ステップS24で求めた制御用ポイントを、縄の手前端部座標54としてRAM24に格納する。この手前端部座標54は、後述する図18のステップS72でゲーム画像を生成するときに利用される。

In step S26, the front end portion of the rope is arranged at the control point on the first virtual plane obtained in step S24. More specifically, the control point obtained in step S24 is stored in the

ステップS28では、RAM24の犬情報42の動作モード51を参照して、犬の動作モードが縄回しモードかどうかを判断し、縄回しモードである場合にはステップS30に進み、縄回しモードでない場合には図17のステップS34に進む。

In step S28, with reference to the

ステップS30では、ステップS22で検出した指示ポイントを前述した方法で第4仮想面上の制御用ポイントに変換する。 In step S30, the indication point detected in step S22 is converted into a control point on the fourth virtual plane by the method described above.

ステップS32では、ステップS30で求めた第4仮想面上の制御用ポイントを犬の注目点に設定する。より具体的には、ステップS30で求めた制御用ポイントを、犬の注目点座標52としてRAM24に格納する。この注目点座標52は、後述する図18のステップS66で犬の動きを自動制御するときに利用される。

In step S32, the control point on the fourth virtual plane obtained in step S30 is set as the point of interest of the dog. More specifically, the control points obtained in step S30 are stored in the

図17のステップS34では、プレイヤによってタオルが使用されているかどうかを判断し、タオルが使用されている場合にはステップS36に進み、タオルが使用されていない場合にはステップS46に進む。 In step S34 of FIG. 17, it is determined whether or not the towel is used by the player. If the towel is used, the process proceeds to step S36, and if the towel is not used, the process proceeds to step S46.

ステップS36では、タオルの奥側端部が犬に噛まれている(すなわち噛まれモード)かどうかを判断し、噛まれモードでない場合にはステップS38に進み、噛まれモードである場合にはステップS44に進む。 In step S36, it is determined whether or not the back end of the towel is bitten by the dog (that is, biting mode). If not, the process proceeds to step S38. Proceed to S44.

ステップS38およびステップS40は、前述のステップS14およびステップS16とそれぞれ同じ処理である。 Steps S38 and S40 are the same processes as steps S14 and S16, respectively.

ステップS42では、ステップS40で求めた第1仮想面上の制御用ポイントにタオルの手前端部を配置する。より具体的には、ステップS40で求めた制御用ポイントを、タオルの手前端部座標55としてRAM24に格納する。この手前端部座標55は、後述する図18のステップS72でゲーム画像を生成するときに利用される。

In step S42, the front end portion of the towel is placed at the control point on the first virtual surface obtained in step S40. More specifically, the control point obtained in step S40 is stored in the

ステップS44では、噛まれモード処理を実行する。この噛まれモード処理の詳細な処理については後述する。 In step S44, the biting mode process is executed. Detailed processing of the biting mode processing will be described later.

ステップS46では、RAM24の犬情報42の動作モード51を参照して、犬の動作モードが注目モードかどうかを判断し、注目モードである場合にはステップS48に進み、注目モードでない場合には図18のステップS54に進む。

In step S46, the

ステップS48は、前述のステップS14と同じ処理である。 Step S48 is the same process as step S14 described above.

ステップS50では、ステップS48で検出した指示ポイントを前述した方法で第2仮想面上の制御用ポイントに変換する。ただし、プレイヤがタッチパネル15に触れていない場合(すなわちステップS48で指示ポイントが検出されなかった場合)には、このステップS50と次のステップS52の処理は省略される。 In step S50, the instruction point detected in step S48 is converted into a control point on the second virtual surface by the method described above. However, when the player is not touching the touch panel 15 (that is, when the instruction point is not detected in step S48), the processing in step S50 and the next step S52 is omitted.

ステップS52では、ステップS50で求めた第2仮想面上の制御用ポイントを犬の注目点に設定する。 In step S52, the control point on the second virtual plane obtained in step S50 is set as the point of interest of the dog.

図18のステップS54では、RAM24の犬情報42の動作モード51を参照して、犬の動作モードが舐めモードかどうかを判断し、舐めモードである場合にはステップS56に進み、舐めモードでない場合にはステップS62に進む。

In step S54 of FIG. 18, it is determined whether or not the dog operation mode is the licking mode by referring to the

ステップS56は、前述のステップS14と同じ処理である。 Step S56 is the same process as step S14 described above.

ステップS58では、ステップS56で検出した指示ポイントを前述した方法で第3仮想面上の制御用ポイントに変換する。ただし、プレイヤがタッチパネル15に触れていない場合(すなわちステップS56で指示ポイントが検出されなかった場合)には、このステップS58と次のステップS60の処理はスキップされる。 In step S58, the instruction point detected in step S56 is converted into a control point on the third virtual plane by the method described above. However, when the player is not touching the touch panel 15 (that is, when the instruction point is not detected in step S56), the processing in step S58 and the next step S60 is skipped.

ステップS60では、ステップS58で求めた第3仮想面上の制御用ポイントを犬の注目点に設定する。 In step S60, the control point on the third virtual plane obtained in step S58 is set as the point of interest of the dog.

ステップS62では、プレイヤによってお回りモードが選択されたかどうかを判断し、お回りモードが選択された場合にはステップS64に進み、お回りモードが選択されていない場合にはステップS66に進む。 In step S62, it is determined whether or not the turn mode has been selected by the player. If the turn mode has been selected, the process proceeds to step S64, and if the turn mode has not been selected, the process proceeds to step S66.

ステップS64では、お回りモード処理を実行する。このお回りモード処理の詳細な処理については後述する。 In step S64, a turning mode process is executed. Detailed processing of the turn mode processing will be described later.

ステップS66では、RAM24の犬情報42の注目点座標52を適宜に参照して、所定の自動制御アルゴリズムに基づいて犬の動きを自動制御する。より具体的には、犬の配置座標や、犬の各部の座標が更新される。

In step S66, the movement of the dog is automatically controlled based on a predetermined automatic control algorithm with reference to the point-of-interest coordinates 52 of the

ステップS68では、ステップS66の自動制御の結果に応じて犬の動作モードを必要に応じて変更し、RAM24の犬情報42の動作モード51を更新する。

In step S68, the operation mode of the dog is changed as necessary according to the result of the automatic control in step S66, and the

ステップS70では、RAM24のアイテム情報43の縄の手前端部座標54またはタオルの手前端部座標55を参照して、縄またはタオルの動きを制御(すなわち繩またはタオルの配置座標や各部の座標を計算)する。なお、犬の動作モードが縄回しモードまたは噛みモードの場合には、ステップS66で制御された犬の動きにも依存して縄またはタオルの形状が制御される。なお、縄もタオルも使用されていないときには、このステップS70の処理はスキップされる。

In step S70, the movement of the rope or towel is controlled with reference to the front end coordinate 54 of the rope or the front end coordinate 55 of the towel in the

ステップS72では、ステップS66およびステップS70の処理結果と、RAM24のカメラ設定情報44に基づいて、仮想カメラから見た仮想3次元空間の様子を示すゲーム画像を生成してフレームバッファ(図示せず)に格納し、ステップS12に戻る。こうして生成されたゲーム画像は適宜のタイミングで第2のLCD12に出力する。

In step S72, based on the processing results of steps S66 and S70 and the

次に、図19を参照して、プレイヤが使用しているタオルの奥側端部を犬がくわえたときの噛まれモードの詳細を説明する。 Next, with reference to FIG. 19, the details of the biting mode when the dog holds the back end of the towel used by the player will be described.

噛まれモードでは、まずCPUコア21はステップS74で、仮想カメラを図9に示すように犬を上から見下ろす位置に移動させる。これは、具体的にはRAM24のカメラ設定情報44を変えることによって行われる。

In the biting mode, first, in step S74, the

ステップS76は、前述のステップS14と同じ処理である。 Step S76 is the same process as step S14 described above.

ステップS78では、ステップS76で検出した指示ポイントを前述した方法で第5仮想面上の制御用ポイントに変換する。 In step S78, the indication point detected in step S76 is converted into a control point on the fifth virtual plane by the method described above.

ステップS80では、ステップS78で求めた第5仮想面上の制御用ポイントにタオルの手前端部を配置する。より具体的には、ステップS78で求めた制御用ポイントを、タ

オルの手前端部座標55としてRAM24に格納する。

In step S80, the front end portion of the towel is arranged at the control point on the fifth virtual surface obtained in step S78. More specifically, the control point obtained in step S78 is stored in the

ステップS82〜S88の処理は、前述のステップS66〜S72とほぼ同じである。 Steps S82 to S88 are substantially the same as steps S66 to S72 described above.

ステップS90では、噛まれモードが終了したかどうかを判断する。噛まれモードが終了するタイミングは、例えば、プレイヤがスティック16をタッチパネル15から離すことによってタオルの手前端部が第5仮想面から離れて自由に移動可能になったときや、犬がタオルを離したときである。そして、噛まれモードが終了していない場合にはステップS76に戻り、噛まれモードが終了した場合にはステップS92に進む。

In step S90, it is determined whether or not the biting mode has ended. The timing at which the biting mode is ended is, for example, when the player releases the

ステップS92では、ステップS74で変更したカメラ設定情報44を元に戻すことによって、仮想カメラの位置を元に戻し、噛まれモード処理を終了する。

In step S92, the

次に、図20を参照して、お回りモードの詳細を説明する。 Next, the details of the turning mode will be described with reference to FIG.

ステップS94〜S98の処理は、前述のステップS74〜S78と同じ処理である。 Steps S94 to S98 are the same as steps S74 to S78 described above.

ステップS100では、ステップS98で求めた第5仮想面上の制御用ポイントを犬の注目点に設定する。 In step S100, the control point on the fifth virtual plane obtained in step S98 is set as the point of interest of the dog.

ステップS102およびステップS104の処理は、それぞれ前述のステップS66およびステップS72と同じである。 Steps S102 and S104 are the same as steps S66 and S72, respectively.

ステップS106では、お回りモードが終了したかどうかを判断する。お回りモードが終了するタイミングは、例えば、プレイヤが操作スイッチ部14を操作することによってモード選択画面を呼び出し、そのモード選択画面においてお回りモードの終了を指示したときである。そして、お回りモードが終了していない場合にはステップS96に戻り、お回りモードが終了した場合にはステップS108に進む。

In step S106, it is determined whether or not the turning mode has ended. The timing when the rotation mode ends is, for example, when the player calls the mode selection screen by operating the

ステップS108では、ステップS94で変更したカメラ設定情報44を元に戻すことによって、仮想カメラの位置を元に戻し、お回りモード処理を終了する。

In step S108, the

以上のように、本実施形態によれば、ポインティングデバイスによってプレイヤによって指示された表示画面上の指示ポイントを常に一定の仮想面上の制御用ポイントに割り当てるのではなく、その制御用ポイントの用途に応じて、例えば犬に縄回しをさせたい場合には指示ポイントを第4仮想面上の制御用ポイントに変換するというように、状況に応じて異なる仮想面上の制御用ポイントに変換することにより、プレイヤは、わざわざ奥行き方向の位置を指定したりする手間をかけること無しに、オブジェクトの動きを簡易にかつ適切に制御することができる。 As described above, according to the present embodiment, the instruction point on the display screen instructed by the player with the pointing device is not always assigned to the control point on the certain virtual plane, but is used for the control point. In response, for example, when the dog wants to run a rope, the instruction point is converted to a control point on the fourth virtual surface, so that it is converted to a control point on a different virtual surface depending on the situation. The player can easily and appropriately control the movement of the object without bothering to specify the position in the depth direction.

また、図14のように、共通の指示ポイントを少なくとも2つの制御用ポイントに変換し、これらの2つの制御用ポイントを利用して複数のオブジェクトを同時に同期して動作させることもできる。 Further, as shown in FIG. 14, a common instruction point can be converted into at least two control points, and a plurality of objects can be operated simultaneously in synchronization using these two control points.

なお、別の実施形態として、共通の指示ポイントを少なくとも2つの制御用ポイントに変換するが、これらの2つの制御用ポイントが必ずしも表示画面上で指示ポイントと同じ位置に表示されない場合の例を図21に示す。図21の例では、タッチパネル15上に所定の入力用エリアが設定されており、仮想3次元空間内にはこの入力用エリアとそれぞれ一対一の写像の関係にある2つの仮想面A,Bが配置されている。仮想面Aは、犬Aの動きを制御するための制御用ポイントが設定される仮想面であり、仮想面Bは、犬Bの動き

を制御するための制御用ポイントが設定される仮想面である。具体的には、仮想面A上の制御用ポイントは、犬Aの注目点として利用され、仮想面B上の制御用ポイントは、犬Bの注目点として利用される。そして、犬Aおよび犬Bは1本の縄の一端および他端をそれぞれくわえており、プレイヤがタッチパネル15上の所定の入力用エリア内でスティック16をスライドさせると、そのスティック16の動きにあわせて犬Aと犬Bが首を振り、うまく縄を回すことができる。この例では、指示ポイントから変換される少なくとも2つの制御用ポイントが必ずしも表示画面上で指示ポイントと同じ位置に表示されるわけではないが、このように、共通の指示ポイントを少なくとも2つの制御用ポイントに変換し、これらの2つの制御用ポイントを利用して仮想3次元空間内のオブジェクトを制御することによって、プレイヤは複雑な操作を簡単に行うことができるようになる。なお、図21の例では、タッチパネル15の一部の領域を入力エリアとしているが、もちろん、前述の実施形態のように、タッチパネル15の全面を入力エリアとしてもよい。

As another embodiment, an example in which a common instruction point is converted into at least two control points, but these two control points are not necessarily displayed at the same position as the instruction point on the display screen. 21. In the example of FIG. 21, a predetermined input area is set on the

10 ゲーム装置

11 第1のLCD

12 第2のLCD

13 ハウジング

13a 上側ハウジング

13b 下側ハウジング

14 操作スイッチ部

14a 十字スイッチ

14b スタートスイッチ

14c セレクトスイッチ

14d Aボタン

14e Bボタン

14f Xボタン

14g Yボタン

14L Lボタン

14R Rボタン

15 タッチパネル

16 スティック

17 メモリカード

17a ROM

17b RAM

18a,18b 音抜き孔

19 電源スイッチ

10

12 Second LCD

13

17b RAM

18a, 18b

Claims (4)

仮想3次元空間内に配置された第1オブジェクトを仮想カメラから見たときの画像を表示画面に表示する第1表示ステップ、

ポインティングデバイスからの出力信号に基づいて、2次元座標で表される指示ポイントを検出する検出ステップ、

前記仮想カメラと前記第1オブジェクトとの間に、所定の仮想面を設定する仮想面設定ステップ、

前記検出ステップで検出された指示ポイントを、所定の演算処理により、前記仮想面設定ステップで設定された仮想面上における任意の3次元座標で表される制御用ポイントに変換する変換ステップ、

前記仮想3次元空間内の前記制御用ポイントで示される位置に、前記第1オブジェクトとは異なる第2オブジェクトを表示する第2表示ステップ、

前記変換ステップで変換して得られた制御用ポイントに基づいて、前記第1オブジェクトの動きを制御する第1制御ステップ、および

前記第1制御ステップで制御される前記第1オブジェクトの動きに応じて前記第2オブジェクトの動きを制御する第2制御ステップを実行させるための情報処理プログラム。 On the computer,

A first display step of displaying an image when the first object arranged in the virtual three-dimensional space is viewed from the virtual camera on the display screen;

A detection step of detecting an indication point represented by two-dimensional coordinates based on an output signal from the pointing device;

A virtual surface setting step of setting a predetermined virtual surface between the virtual camera and the first object;

A conversion step of converting the indication point detected in the detection step into a control point represented by an arbitrary three-dimensional coordinate on the virtual surface set in the virtual surface setting step by a predetermined calculation process;

A second display step of displaying a second object different from the first object at a position indicated by the control point in the virtual three-dimensional space;

Based on the control point obtained by the conversion in the conversion step, a first control step for controlling the movement of the first object, and according to the movement of the first object controlled in the first control step An information processing program for executing a second control step for controlling the movement of the second object.

表示画面上の任意のポイントを操作者が指示するためのポインティングデバイス、

前記ポインティングデバイスからの出力信号に基づいて、2次元座標で表される指示ポイントを検出する検出手段、

前記仮想カメラと前記第1オブジェクトとの間に、所定の仮想面を設定する仮想面設定手段、

前記検出手段で検出された指示ポイントを、所定の演算処理により、前記仮想面設定手段で設定された仮想面上における任意の3次元座標で表される制御用ポイントに変換する変換手段、

前記仮想3次元空間内の前記制御用ポイントで示される位置に、前記第1オブジェクトとは異なる第2オブジェクトを表示する第2表示手段、

前記変換手段で変換して得られた制御用ポイントに基づいて、前記第1オブジェクトの動きを制御する第1制御手段、および

前記第1制御手段によって制御される前記第1オブジェクトの動きに応じて前記第2オブジェクトの動きを制御する第2制御手段を備える情報処理装置。 Table 1 示手 stage for displaying an image when viewed first object placed in a virtual three-dimensional space from a virtual camera on a display screen,

A pointing device for the operator to indicate any point on the display screen,

Detecting means for detecting an indication point represented by two-dimensional coordinates based on an output signal from the pointing device;

Virtual surface setting means for setting a predetermined virtual surface between the virtual camera and the first object;

Conversion means for converting the indicated point detected by the detection means into a control point represented by arbitrary three-dimensional coordinates on the virtual plane set by the virtual plane setting means by a predetermined calculation process;

Second display means for displaying a second object different from the first object at a position indicated by the control point in the virtual three-dimensional space;

Based on the control point obtained by the conversion by the conversion means, a first control means for controlling the movement of the first object, and according to the movement of the first object controlled by the first control means An information processing apparatus comprising second control means for controlling the movement of the second object.

Priority Applications (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2008286793A JP4326585B2 (en) | 2008-11-07 | 2008-11-07 | Information processing program and information processing apparatus |

Applications Claiming Priority (1)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2008286793A JP4326585B2 (en) | 2008-11-07 | 2008-11-07 | Information processing program and information processing apparatus |

Related Parent Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2005057659A Division JP4319156B2 (en) | 2005-03-02 | 2005-03-02 | Information processing program and information processing apparatus |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP2009048658A JP2009048658A (en) | 2009-03-05 |

| JP4326585B2 true JP4326585B2 (en) | 2009-09-09 |

Family

ID=40500744

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2008286793A Active JP4326585B2 (en) | 2008-11-07 | 2008-11-07 | Information processing program and information processing apparatus |

Country Status (1)

| Country | Link |

|---|---|

| JP (1) | JP4326585B2 (en) |

Families Citing this family (5)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| EP2228110B1 (en) | 2009-03-09 | 2017-08-30 | Nintendo Co., Ltd. | Coordinate calculation apparatus and storage medium having coordinate calculation program stored therein |

| JP2009266251A (en) * | 2009-07-01 | 2009-11-12 | Shigeo Nakaishi | Methods for displaying electronic function graph and acquiring coordinate, device for displaying electronic function graph and acquiring coordinate, and program |

| JP5800501B2 (en) | 2010-03-12 | 2015-10-28 | 任天堂株式会社 | Display control program, display control apparatus, display control system, and display control method |

| JP6021296B2 (en) * | 2010-12-16 | 2016-11-09 | 任天堂株式会社 | Display control program, display control device, display control system, and display control method |

| JP6042394B2 (en) * | 2014-09-30 | 2016-12-14 | 任天堂株式会社 | Coordinate calculation apparatus and coordinate calculation program |

-

2008

- 2008-11-07 JP JP2008286793A patent/JP4326585B2/en active Active

Also Published As

| Publication number | Publication date |

|---|---|

| JP2009048658A (en) | 2009-03-05 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP4319156B2 (en) | Information processing program and information processing apparatus | |

| JP4244040B2 (en) | Input processing program and input processing apparatus | |

| JP4335160B2 (en) | Collision judgment program and collision judgment device | |

| JP4358181B2 (en) | GAME PROGRAM AND GAME DEVICE | |

| JP4326568B2 (en) | Information processing apparatus and information processing program | |

| US9354839B2 (en) | Storage medium storing object movement controlling program and information processing apparatus | |

| JP4489800B2 (en) | Image generating apparatus and method, program, and recording medium | |

| JP4863435B2 (en) | GAME PROGRAM, GAME DEVICE, GAME SYSTEM, AND GAME PROCESSING METHOD | |

| JP2003290550A (en) | Game device and game program | |

| JP4326585B2 (en) | Information processing program and information processing apparatus | |

| JP2005245619A (en) | Game device and game program | |

| JP2006314632A (en) | Game program and game device | |

| JP4134191B2 (en) | GAME DEVICE, CHARACTER DISPLAY METHOD, PROGRAM, AND RECORDING MEDIUM | |

| JP4875175B2 (en) | Information processing program, information processing apparatus, information processing method, and information processing system | |

| JP3001538B1 (en) | VIDEO GAME DEVICE, MODEL DISPLAY METHOD FOR VIDEO GAME, AND READABLE RECORDING MEDIUM ON WHICH MODEL DISPLAY PROGRAM FOR VIDEO GAME IS RECORDED | |

| JP2009116906A (en) | Information processor and information processing program | |

| JP4488534B2 (en) | Information processing program and information processing apparatus | |

| JP2013225321A (en) | Information processing program, information processing apparatus, information processing system, and information processing method | |

| JP5224535B2 (en) | Collision determination program, collision determination device, collision determination system, and collision determination method | |

| JP4753442B2 (en) | GAME PROGRAM AND GAME DEVICE | |

| JP7579371B2 (en) | Information processing program, information processing system, and information processing method | |

| JP5738351B2 (en) | Information processing program, information processing apparatus, information processing system, and information processing method | |

| JP5827671B2 (en) | GAME PROGRAM AND GAME DEVICE | |

| JP4879952B2 (en) | Input processing program and input processing apparatus | |

| JP5705671B2 (en) | GAME PROGRAM AND GAME DEVICE |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20081202 |

|

| A621 | Written request for application examination |

Free format text: JAPANESE INTERMEDIATE CODE: A621 Effective date: 20081202 |

|

| A871 | Explanation of circumstances concerning accelerated examination |

Free format text: JAPANESE INTERMEDIATE CODE: A871 Effective date: 20081202 |

|

| A975 | Report on accelerated examination |

Free format text: JAPANESE INTERMEDIATE CODE: A971005 Effective date: 20081219 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20081226 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20090224 |

|

| A131 | Notification of reasons for refusal |

Free format text: JAPANESE INTERMEDIATE CODE: A131 Effective date: 20090319 |

|

| A521 | Request for written amendment filed |

Free format text: JAPANESE INTERMEDIATE CODE: A523 Effective date: 20090428 |

|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20090608 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20090609 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20120619 Year of fee payment: 3 |

|

| R150 | Certificate of patent or registration of utility model |

Ref document number: 4326585 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20120619 Year of fee payment: 3 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20120619 Year of fee payment: 3 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20130619 Year of fee payment: 4 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20130619 Year of fee payment: 4 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20130619 Year of fee payment: 4 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |