CN108604413B - 显示装置的控制方法及显示装置 - Google Patents

显示装置的控制方法及显示装置 Download PDFInfo

- Publication number

- CN108604413B CN108604413B CN201680079338.8A CN201680079338A CN108604413B CN 108604413 B CN108604413 B CN 108604413B CN 201680079338 A CN201680079338 A CN 201680079338A CN 108604413 B CN108604413 B CN 108604413B

- Authority

- CN

- China

- Prior art keywords

- state

- agent

- vehicle

- detected

- host vehicle

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Active

Links

- 238000000034 method Methods 0.000 title claims abstract description 28

- 238000001514 detection method Methods 0.000 claims abstract description 207

- 230000014509 gene expression Effects 0.000 claims abstract description 132

- 210000001747 pupil Anatomy 0.000 claims description 38

- 239000003795 chemical substances by application Substances 0.000 description 177

- 230000006870 function Effects 0.000 description 112

- 238000010586 diagram Methods 0.000 description 27

- 238000012545 processing Methods 0.000 description 10

- 210000004709 eyebrow Anatomy 0.000 description 8

- 230000008569 process Effects 0.000 description 7

- 239000003550 marker Substances 0.000 description 6

- 230000007246 mechanism Effects 0.000 description 6

- 230000008859 change Effects 0.000 description 5

- 241001465754 Metazoa Species 0.000 description 4

- 230000002093 peripheral effect Effects 0.000 description 4

- 238000013459 approach Methods 0.000 description 3

- 238000002485 combustion reaction Methods 0.000 description 2

- 238000002474 experimental method Methods 0.000 description 2

- 230000035945 sensitivity Effects 0.000 description 2

- 241000282326 Felis catus Species 0.000 description 1

- 230000001133 acceleration Effects 0.000 description 1

- 230000009471 action Effects 0.000 description 1

- 230000005540 biological transmission Effects 0.000 description 1

- 230000004397 blinking Effects 0.000 description 1

- 238000004891 communication Methods 0.000 description 1

- 238000007796 conventional method Methods 0.000 description 1

- 238000013461 design Methods 0.000 description 1

- 230000000694 effects Effects 0.000 description 1

- 230000008451 emotion Effects 0.000 description 1

- 238000005516 engineering process Methods 0.000 description 1

- 230000000193 eyeblink Effects 0.000 description 1

- 230000001815 facial effect Effects 0.000 description 1

Images

Classifications

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60W—CONJOINT CONTROL OF VEHICLE SUB-UNITS OF DIFFERENT TYPE OR DIFFERENT FUNCTION; CONTROL SYSTEMS SPECIALLY ADAPTED FOR HYBRID VEHICLES; ROAD VEHICLE DRIVE CONTROL SYSTEMS FOR PURPOSES NOT RELATED TO THE CONTROL OF A PARTICULAR SUB-UNIT

- B60W50/00—Details of control systems for road vehicle drive control not related to the control of a particular sub-unit, e.g. process diagnostic or vehicle driver interfaces

- B60W50/08—Interaction between the driver and the control system

- B60W50/14—Means for informing the driver, warning the driver or prompting a driver intervention

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60K—ARRANGEMENT OR MOUNTING OF PROPULSION UNITS OR OF TRANSMISSIONS IN VEHICLES; ARRANGEMENT OR MOUNTING OF PLURAL DIVERSE PRIME-MOVERS IN VEHICLES; AUXILIARY DRIVES FOR VEHICLES; INSTRUMENTATION OR DASHBOARDS FOR VEHICLES; ARRANGEMENTS IN CONNECTION WITH COOLING, AIR INTAKE, GAS EXHAUST OR FUEL SUPPLY OF PROPULSION UNITS IN VEHICLES

- B60K35/00—Instruments specially adapted for vehicles; Arrangement of instruments in or on vehicles

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60K—ARRANGEMENT OR MOUNTING OF PROPULSION UNITS OR OF TRANSMISSIONS IN VEHICLES; ARRANGEMENT OR MOUNTING OF PLURAL DIVERSE PRIME-MOVERS IN VEHICLES; AUXILIARY DRIVES FOR VEHICLES; INSTRUMENTATION OR DASHBOARDS FOR VEHICLES; ARRANGEMENTS IN CONNECTION WITH COOLING, AIR INTAKE, GAS EXHAUST OR FUEL SUPPLY OF PROPULSION UNITS IN VEHICLES

- B60K35/00—Instruments specially adapted for vehicles; Arrangement of instruments in or on vehicles

- B60K35/20—Output arrangements, i.e. from vehicle to user, associated with vehicle functions or specially adapted therefor

- B60K35/21—Output arrangements, i.e. from vehicle to user, associated with vehicle functions or specially adapted therefor using visual output, e.g. blinking lights or matrix displays

- B60K35/22—Display screens

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60K—ARRANGEMENT OR MOUNTING OF PROPULSION UNITS OR OF TRANSMISSIONS IN VEHICLES; ARRANGEMENT OR MOUNTING OF PLURAL DIVERSE PRIME-MOVERS IN VEHICLES; AUXILIARY DRIVES FOR VEHICLES; INSTRUMENTATION OR DASHBOARDS FOR VEHICLES; ARRANGEMENTS IN CONNECTION WITH COOLING, AIR INTAKE, GAS EXHAUST OR FUEL SUPPLY OF PROPULSION UNITS IN VEHICLES

- B60K35/00—Instruments specially adapted for vehicles; Arrangement of instruments in or on vehicles

- B60K35/50—Instruments characterised by their means of attachment to or integration in the vehicle

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60K—ARRANGEMENT OR MOUNTING OF PROPULSION UNITS OR OF TRANSMISSIONS IN VEHICLES; ARRANGEMENT OR MOUNTING OF PLURAL DIVERSE PRIME-MOVERS IN VEHICLES; AUXILIARY DRIVES FOR VEHICLES; INSTRUMENTATION OR DASHBOARDS FOR VEHICLES; ARRANGEMENTS IN CONNECTION WITH COOLING, AIR INTAKE, GAS EXHAUST OR FUEL SUPPLY OF PROPULSION UNITS IN VEHICLES

- B60K35/00—Instruments specially adapted for vehicles; Arrangement of instruments in or on vehicles

- B60K35/80—Arrangements for controlling instruments

- B60K35/81—Arrangements for controlling instruments for controlling displays

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06F—ELECTRIC DIGITAL DATA PROCESSING

- G06F3/00—Input arrangements for transferring data to be processed into a form capable of being handled by the computer; Output arrangements for transferring data from processing unit to output unit, e.g. interface arrangements

- G06F3/01—Input arrangements or combined input and output arrangements for interaction between user and computer

- G06F3/048—Interaction techniques based on graphical user interfaces [GUI]

- G06F3/0481—Interaction techniques based on graphical user interfaces [GUI] based on specific properties of the displayed interaction object or a metaphor-based environment, e.g. interaction with desktop elements like windows or icons, or assisted by a cursor's changing behaviour or appearance

-

- G—PHYSICS

- G06—COMPUTING; CALCULATING OR COUNTING

- G06V—IMAGE OR VIDEO RECOGNITION OR UNDERSTANDING

- G06V20/00—Scenes; Scene-specific elements

- G06V20/50—Context or environment of the image

- G06V20/56—Context or environment of the image exterior to a vehicle by using sensors mounted on the vehicle

- G06V20/58—Recognition of moving objects or obstacles, e.g. vehicles or pedestrians; Recognition of traffic objects, e.g. traffic signs, traffic lights or roads

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/01—Detecting movement of traffic to be counted or controlled

- G08G1/0104—Measuring and analyzing of parameters relative to traffic conditions

- G08G1/0108—Measuring and analyzing of parameters relative to traffic conditions based on the source of data

- G08G1/0112—Measuring and analyzing of parameters relative to traffic conditions based on the source of data from the vehicle, e.g. floating car data [FCD]

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/01—Detecting movement of traffic to be counted or controlled

- G08G1/0104—Measuring and analyzing of parameters relative to traffic conditions

- G08G1/0125—Traffic data processing

- G08G1/0133—Traffic data processing for classifying traffic situation

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/01—Detecting movement of traffic to be counted or controlled

- G08G1/015—Detecting movement of traffic to be counted or controlled with provision for distinguishing between two or more types of vehicles, e.g. between motor-cars and cycles

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/09—Arrangements for giving variable traffic instructions

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/09—Arrangements for giving variable traffic instructions

- G08G1/0962—Arrangements for giving variable traffic instructions having an indicator mounted inside the vehicle, e.g. giving voice messages

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/16—Anti-collision systems

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/16—Anti-collision systems

- G08G1/161—Decentralised systems, e.g. inter-vehicle communication

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/16—Anti-collision systems

- G08G1/161—Decentralised systems, e.g. inter-vehicle communication

- G08G1/163—Decentralised systems, e.g. inter-vehicle communication involving continuous checking

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/16—Anti-collision systems

- G08G1/165—Anti-collision systems for passive traffic, e.g. including static obstacles, trees

-

- G—PHYSICS

- G08—SIGNALLING

- G08G—TRAFFIC CONTROL SYSTEMS

- G08G1/00—Traffic control systems for road vehicles

- G08G1/16—Anti-collision systems

- G08G1/166—Anti-collision systems for active traffic, e.g. moving vehicles, pedestrians, bikes

-

- H—ELECTRICITY

- H04—ELECTRIC COMMUNICATION TECHNIQUE

- H04N—PICTORIAL COMMUNICATION, e.g. TELEVISION

- H04N7/00—Television systems

- H04N7/18—Closed-circuit television [CCTV] systems, i.e. systems in which the video signal is not broadcast

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60K—ARRANGEMENT OR MOUNTING OF PROPULSION UNITS OR OF TRANSMISSIONS IN VEHICLES; ARRANGEMENT OR MOUNTING OF PLURAL DIVERSE PRIME-MOVERS IN VEHICLES; AUXILIARY DRIVES FOR VEHICLES; INSTRUMENTATION OR DASHBOARDS FOR VEHICLES; ARRANGEMENTS IN CONNECTION WITH COOLING, AIR INTAKE, GAS EXHAUST OR FUEL SUPPLY OF PROPULSION UNITS IN VEHICLES

- B60K37/00—Dashboards

- B60K37/20—Dashboard panels

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60W—CONJOINT CONTROL OF VEHICLE SUB-UNITS OF DIFFERENT TYPE OR DIFFERENT FUNCTION; CONTROL SYSTEMS SPECIALLY ADAPTED FOR HYBRID VEHICLES; ROAD VEHICLE DRIVE CONTROL SYSTEMS FOR PURPOSES NOT RELATED TO THE CONTROL OF A PARTICULAR SUB-UNIT

- B60W50/00—Details of control systems for road vehicle drive control not related to the control of a particular sub-unit, e.g. process diagnostic or vehicle driver interfaces

- B60W50/08—Interaction between the driver and the control system

- B60W50/14—Means for informing the driver, warning the driver or prompting a driver intervention

- B60W2050/146—Display means

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60W—CONJOINT CONTROL OF VEHICLE SUB-UNITS OF DIFFERENT TYPE OR DIFFERENT FUNCTION; CONTROL SYSTEMS SPECIALLY ADAPTED FOR HYBRID VEHICLES; ROAD VEHICLE DRIVE CONTROL SYSTEMS FOR PURPOSES NOT RELATED TO THE CONTROL OF A PARTICULAR SUB-UNIT

- B60W2420/00—Indexing codes relating to the type of sensors based on the principle of their operation

- B60W2420/40—Photo, light or radio wave sensitive means, e.g. infrared sensors

- B60W2420/403—Image sensing, e.g. optical camera

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60W—CONJOINT CONTROL OF VEHICLE SUB-UNITS OF DIFFERENT TYPE OR DIFFERENT FUNCTION; CONTROL SYSTEMS SPECIALLY ADAPTED FOR HYBRID VEHICLES; ROAD VEHICLE DRIVE CONTROL SYSTEMS FOR PURPOSES NOT RELATED TO THE CONTROL OF A PARTICULAR SUB-UNIT

- B60W2554/00—Input parameters relating to objects

-

- B—PERFORMING OPERATIONS; TRANSPORTING

- B60—VEHICLES IN GENERAL

- B60W—CONJOINT CONTROL OF VEHICLE SUB-UNITS OF DIFFERENT TYPE OR DIFFERENT FUNCTION; CONTROL SYSTEMS SPECIALLY ADAPTED FOR HYBRID VEHICLES; ROAD VEHICLE DRIVE CONTROL SYSTEMS FOR PURPOSES NOT RELATED TO THE CONTROL OF A PARTICULAR SUB-UNIT

- B60W2555/00—Input parameters relating to exterior conditions, not covered by groups B60W2552/00, B60W2554/00

- B60W2555/60—Traffic rules, e.g. speed limits or right of way

Landscapes

- Engineering & Computer Science (AREA)

- Physics & Mathematics (AREA)

- General Physics & Mathematics (AREA)

- Chemical & Material Sciences (AREA)

- Transportation (AREA)

- Mechanical Engineering (AREA)

- Theoretical Computer Science (AREA)

- Combustion & Propulsion (AREA)

- General Engineering & Computer Science (AREA)

- Human Computer Interaction (AREA)

- Automation & Control Theory (AREA)

- Analytical Chemistry (AREA)

- Multimedia (AREA)

- Signal Processing (AREA)

- Traffic Control Systems (AREA)

- User Interface Of Digital Computer (AREA)

- Control Of El Displays (AREA)

- Instrument Panels (AREA)

- Digital Computer Display Output (AREA)

- Measuring Pulse, Heart Rate, Blood Pressure Or Blood Flow (AREA)

- Closed-Circuit Television Systems (AREA)

- Controls And Circuits For Display Device (AREA)

Abstract

一种显示控制方法,使用在显示装置(14)上显示的智能体,使检测周围的对象物的检测器(11)的检测状态显示在显示装置(14)上,其中,基于检测器(11)的检测结果,判定检测器(11)的检测状态,基于检测器(11)的检测状态,设定智能体的表情。

Description

技术领域

本发明涉及显示装置的控制方法及显示装置。

背景技术

目前,公知的是向用户可视地显示车载摄像头的检测灵敏度的技术(例如专利文献1)。

专利文献1:(日本)特开2012-73926号公报

根据上述现有技术,能够使驾驶员把握车载摄像头的检测灵敏度的好坏。但是,在上述现有技术中,不能使驾驶员直观地把握车载摄像头为搜索对象物的状态或检测对象物的状态等车载摄像头的检测状态。

发明内容

本发明要解决的课题在于提供可使驾驶员直观地把握周围检测传感器的检测状态的显示装置的控制方法及显示装置。

本发明基于检测器的检测结果,判定检测器的检测状态,基于检测器的检测状态设定对至少包含眼睛的面部进行了模仿的的图像的表情中眼睛的显示方式,通过在显示装置显示该对面部进行了模仿的图像,解决上述课题。

根据本发明,能够通过对至少包含眼睛的面部进行了模仿的图像的表情中眼睛的显示方式表现周围检测传感器的检测状态,能够使驾驶员直观地把握周围检测传感器的检测状态。

附图说明

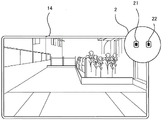

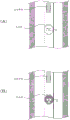

图1是表示本发明实施方式的自动驾驶装置的构成图;

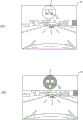

图2是表示在本发明实施方式的显示器上显示的画面例的图;

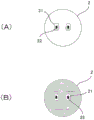

图3是表示本发明实施方式的智能体的表情之一例的图;

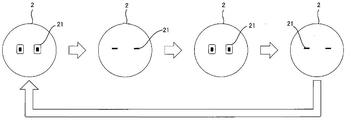

图4是表示在本发明的实施方式中,搜索对象物的智能体的表情之一例的图;

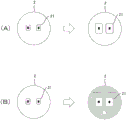

图5是表示在本发明的实施方式中,检测到对象物的智能体的表情之一例的图;

图6是用于说明在本发明的实施方式中,对象物的位置和智能体的表情的关系的图;

图7是表示在本发明的实施方式中,追踪对象物的智能体的表情之一例的图;

图8是表示在本发明的实施方式中,看丢了对象物的情况的智能体的表情之一例的图;

图9是表示在本发明的实施方式中,不能进行对象物的检测的情况的智能体的表情之一例的图;

图10是表示在本发明的实施方式中,在显示器上显示拍摄到对象物的图像的情况的智能体的显示例的图;

图11是表示在本发明的实施方式中,在显示器显示模仿了对象物的图像的情况的智能体的显示例的图;

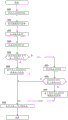

图12是表示本发明第一实施方式的自动驾驶处理之一例的流程图;

图13是表示在本发明的实施方式中,显在判定值高的情况的智能体的表情之一例的图;

图14是表示在本发明的实施方式中,潜在判定值高的情况的智能体的表情之一例的图;

图15是用于说明在本发明的实施方式中,显在对象物的位置和智能体的表情的关系的图;

图16是表示在本发明的实施方式中,在显示器上显示拍摄到显在对象物的图像的情况的智能体的显示例的图;

图17是表示在本发明的实施方式中,在显示器上显示模仿了显在对象物的图像的情况的智能体的显示例的图;

图18是表示本发明第二实施方式的自动驾驶处理之一例的流程图。

标记说明

1:自动驾驶装置

11:周围检测传感器

12:车速传感器

13:本车位置检测装置

14:显示器

15:驱动控制装置

16:控制装置

2:智能体

21:眼睛

22:瞳孔

3:对象物

具体实施方式

以下,基于附图说明本发明的实施方式。此外,在本实施方式中,示例在搭载于车辆的自动驾驶装置1中应用本发明的显示装置的控制方法及显示装置的情况进行说明。

《第一实施方式》

图1是表示本发明实施方式的自动驾驶装置1的构成的图。如图1所示,本实施方式的自动驾驶装置1具有周围检测传感器11、车速传感器12、本车位置检测装置13、显示器14、驱动控制装置15、控制装置16。为了相互进行信息的接收发送,这些各装置通过CAN(Controller Area Network)等其它的车载LAN连接。

周围检测传感器11进行在本车辆的周边存在的对象物3的检测。作为这种周围检测传感器11,可列举出对本车辆的前方进行拍摄的前方摄像头、对本车辆的后方进行拍摄的后方摄像头、检测本车辆前方的障碍物的前方雷达、检测本车辆后方的障碍物的后方雷达及检测在本车辆侧方存在的障碍物的侧方雷达等。另外,作为周围检测传感器11检测的对象物3的例子,可列举行人、自行车、摩托车、汽车、路上障碍物、构造物、交通信号灯、道路标识、车道标志、道路边缘(路缘石或护栏)、及道路形状(转弯)等。此外,作为周围检测传感器11,既可以构成为使用上述多个传感器中一个,也可以构成为组合两种以上的传感器而使用。周围检测传感器11的检测结果被向控制装置16输出。

车速传感器12测量驱动轴等驱动系的转速,基于此检测车辆的行驶速度(以下,也称为车速)。通过车速传感器12检测到的车速信息被向控制装置16输出。

本车位置检测装置13由GPS单元、陀螺传感器等构成,由GPS单元检测从多个卫星通信发送的电波,周期性取得对象车辆(本车辆)的位置信息。而且,基于取得的对象车辆的位置信息、由陀螺传感器取得的角度变化信息、由车速传感器12取得的车速,检测对象车辆的当前位置。由本车位置检测装置13检测到的对象车辆的位置信息被向控制装置16输出。

显示器14例如是导航装置具备的显示器、组装入后视镜的显示器、组装入仪表板的仪表部的显示器、在前挡风玻璃映出的平视显示器等装置。显示器14根据控制装置16的控制,在显示器14的画面上显示后述的智能体2。

驱动控制装置15控制本车辆的行驶。例如,在本车辆具备自动追随先行车辆的模式的情况下,驱动控制装置15以本车辆与先行车辆的车间距离为一定距离的方式控制用于实现加减速度及车速的驱动机构的动作(在发动机汽车中,内燃机的动作、电动汽车系中包含电动机动作,在混合动力汽车还包含内燃机和电动机的转矩分配)及制动动作。另外,在本车辆具备进行右转或左转或车道变更等自动掌舵的模式的情况下,驱动控制装置15控制转向促动器的动作而控制车轮的动作,由此,执行本车辆的转向控制。此外,驱动控制装置15通过后述的控制装置16的指示控制本车辆的行驶。另外,作为通过驱动控制装置15的行驶控制方法,还能够使用其它公知的方法。

控制装置16由下述部件构成:ROM(Read Only Memory),其存储用于在显示器14上显示表示周围检测传感器11的检测状态(扫描状态)的智能体2(详细后述)的程序;CPU(Central Processing Unit),其执行存储于该ROM的程序;RAM(Random Access Memory),其作为可存取的存储装置发挥功能。此外,作为动作电路,能够代替CPU(CentralProcessing Unit)或与其一同使用MPU(Micro Processing Unit)、DSP(Digital SignalProcessor)、ASIC(Application Specific Integrated Circuit)、FPGA(FieldProgrammable Gate Array)等。

控制装置16实现下述功能:通过利用CPU执行存储于ROM的程序,取得周围检测传感器11的检测结果的检测结果取得功能;基于周围检测传感器11的检测结果,判定周围检测传感器11的检测状态的检测状态判定功能;在显示器14上显示智能体2的智能体显示功能;基于周围检测传感器11的检测状态,设定在显示器14显示的智能体2的表情的表情设定功能;控制自动驾驶行驶的行驶控制功能。以下,对控制装置16具备的各功能进行说明。

控制装置16通过检测结果取得功能,能够由周围检测传感器11取得检测结果。例如,控制装置16通过检测结果取得功能,能够将通过前方摄像头及后方摄像头拍摄到的车辆外部的图像信息或前方雷达、后方雷达及侧方雷达的检测结果作为周围检测传感器11的检测结果而取得。

控制装置16通过检测状态判定功能,基于通过检测结果取得功能取得的周围检测传感器11的检测结果,能够判定周围检测传感器11的检测状态(扫描状态)。具体而言,控制装置16能够通过检测状态判定功能,基于周围检测传感器11的检测结果判定是搜索对象物3的状态、检测对象物3的状态、追踪对象物3的状态、看丢对象物3的状态及不能进行对象物3的检测的状态中哪一检测状态。另外,控制装置16通过检测状态判定功能,在本车辆是检测到对象物3的状态或追踪对象物3的状态的情况下,能够算出检测出的对象物3的位置。

在此,搜索对象物3的状态是指虽然在对象物3的检测的执行中,但对象物3一个也没有检测到的状态。检测到对象物3的状态是指新检测到对象物3的状态。检测到对象物3的状态持续了一定时间后,进入追踪对象物3的状态。追踪对象物3的状态是指以一定时间间隔反复检测一次检测到的对象物3的状态。看丢了对象物3的状态是指在检测到对象物3之后,不能检测该对象物3的状态。在本实施方式中,在对象物3一个也没有检测到的情况下,成为看丢对象物3的状态。不能进行对象物3的检测的状态是指因雾、雨、雪等天气或夜晚等周围的亮度的原因,难以进行对象物3的检测的环境的状态。

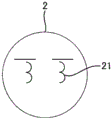

控制装置16通过智能体显示功能,在显示器14的画面上显示表示周围检测传感器11的检测状态的智能体。本实施方式的智能体2是指用于向驾驶员显示周围检测传感器11的检测状态的信息传递介质的一种。特别是在本实施方式中采用被拟人化的人物图像以使驾驶员能够直观地把握周围检测传感器11的检测状态这种信息内容。图2是表示在显示器14显示的画面例的图,图3是表示智能体2的显示例的图。本实施方式的拟人化的智能体2例如如图2及图3所示,优选至少具有模仿了眼睛的部分21(以下,简称为“眼睛21”)。

本实施方式的被拟人化的智能体2的形状或形式没有特别限定,例如如图2及图3所示,也可以是模仿了人或人的面部的图像。另外,被拟人化的智能体2虽然说不只限于人,也可以是模仿狗或猫等其它动物或动物的面部的图像。这是因为,一般在人以外的动物中,很少在相貌或手势中表示表情即心中的感情、情绪,但只要在人以外的动物的图像中设定类似于人的表情的表情,就能够得到与人的图像相同的作用效果。因此,本实施方式的智能体2包含拟动物化的形式。

另外,优选智能体2至少具有相当于眼睛21的部位,对于其它的部位能够适当设定。例如,如图3(A)所示,也可以是具有面部轮廓的构成,虽未作图示,但也可以是具有身体的构成。另外,如图3(B)所示,也可以是具有眉或嘴的构成。另外,如图3(B)所示,也可以基于周围检测传感器11的检测状态使面部的颜色变化。以下,将图3(A)或图3(B)所示的智能体2的表情作为初始状态的表情进行说明。

控制装置16通过表情设定功能,设定智能体2的表情。具体而言,控制装置16通过表情设定功能,基于周围检测传感器11的检测状态,能够设定智能体2的表情。以下,对基于各检测状态的智能体2的表情的设定方式进行说明。

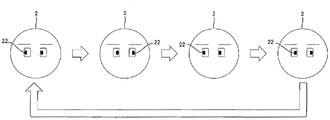

图4是表示周围检测传感器11搜索对象物3的情况的智能体2的显示之一例的图。控制装置16通过表情设定功能,在周围检测传感器11搜索对象物3的情况下,例如如图4所示,智能体2使睁开眼睛21的状态和闭上眼睛21的状态反复即眨巴眼睛,由此,设定为智能体2有意图地眨眼的表情。人在注视周围时因更好地进行眨巴眼睛,所以通过这样的表情的设定,能够使驾驶员直观把握周围检测传感器11搜索在本车辆的周围存在的对象物3。

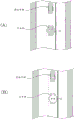

图5是表示周围检测传感器11检测到对象物3的情况的智能体2的表情之一例的图。控制装置16通过表情设定功能,在周围检测传感器11检测到对象物3的情况下,例如如图5(A)所示,设定为大大睁开智能体2的眼睛21的表情。另外,例如如图5(B)所示,在智能体2上加上眉或张开的嘴,并且在规定时间(例如数秒),使智能体2的面部的颜色变化为黄色(在图5(B)所示例中,用细斜线表示。以下,图6(A)、图10(A)、图11(A)、图14(B)也同样)等。人注意到在周围有对象物3时,因更好地进行或形成睁大眼睛而稍微惊讶的表情,或改变颜色,所以利用这样的表情的设定,能够使驾驶员直观地把握周围检测传感器11检测到对象物。

图6是用于说明对象物3的位置和智能体2的表情的关系的图。此外,在图6所示例中,示例在设置于仪表板内的显示器14上显示智能体2的情形,但为了便于理解地说明智能体2的表情,与实际相比,放大表示显示器14和智能体2(图7,图15中也同样)。控制装置16通过表情设定功能,在周围检测传感器11检测到对象物3的情况下,基于检测到的对象物3存在的位置,也能够设定智能体2的表情。

即,控制装置16通过表情设定功能,在周围检测传感器11检测到对象物3的情况下,例如如图6(A)所示,也能够以智能体2的视线朝向检测到的对象物3存在的方向的方式设定智能体2的瞳孔22的位置。具体而言,控制装置16通过表情设定功能,在对象物3为行人、自行车、摩托车、汽车、路上障碍物、构造物、交通信号灯、道路标识的情况下,如图6(A)所示,也能够以从对象物3至智能体2的瞳孔22的距离最短的方式设定智能体2的瞳孔22的位置。换言之,也能够以智能体2的视线朝向对象物3存在的方向的方式设定眼睛21中的瞳孔22的位置。另外,控制装置16通过表情设定功能,在对象物3为车道标志或道路边缘的情况下,也能够以车道标志或道路边缘的中心位置与智能体2的瞳孔22的距离最短的方式设定智能体2的瞳孔22的位置。换言之,也能够以智能体2的视线朝向车道标志或道路边缘的中心位置的方向的方式设定眼睛21中的瞳孔22的位置。

另外,控制装置16通过表情设定功能,检测对象物3后经过一定时间,周围检测传感器11的检测状态从检测到对象物3的状态向追踪对象物3的状态转换时,如图6(B)所示,智能体2的表情返回初始状态(图3(A)所示的表情)。该情况下同样,控制装置16通过表情设定功能,也能够以智能体2的视线朝向检测到的对象物3存在的方向的方式设定智能体2的瞳孔22的位置。

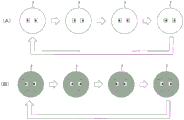

接着,对周围检测传感器11追踪对象物3的情况的智能体2的表情的设定方法进行说明。图7是表示周围检测传感器11追踪对象物3的情况的智能体2的表情之一例的图。控制装置16通过表情设定功能,在周围检测传感器11追踪对象物3的情况下,例如如图7(A)~(C)所示,也能够以智能体2的视线追随对象物3移动的方式使智能体2的瞳孔22的位置移动。在本实施方式中,周围检测传感器11以规定时间间隔反复进行本车辆的周围的检测,将该检测结果周期性向控制装置16发送。另外,在本实施方式中,周围检测传感器11及控制装置16通过存储一次检测到的对象物3的特征(形状或色彩等),能够继续检测(追踪)检测到的对象物3。控制装置16通过表情设定功能,基于取得的周围检测传感器11的检测结果,反复检测对象物3(包含追踪中的对象物3)的位置,在对象物3和智能体2的瞳孔22为最短的位置反复设定瞳孔22。由此,控制装置16通过表情设定功能,如图7(A)~(C)所示,也能够以智能体2的视线追随对象物3移动的方式设定智能体2的表情。

此外,控制装置16通过表情设定功能,在周围检测传感器11检测到多个对象物3的情况下,也能够以智能体2交替观察多个对象物3的方式设定智能体2的表情。例如,在周围检测传感器110检测到对象物3A、3B两个对象物3的情况下,通过表情设定功能,在对象物3A和智能体2的瞳孔22为最短的位置设定智能体2的瞳孔22。另外,通过表情设定功能,在规定时间后,也能够在对象物3B和智能体2的瞳孔22为最短的位置使智能体2的瞳孔22移动。之后也同样,通过表情设定功能,在规定时间后智能体2的瞳孔22移动到对象物3A和智能体2的瞳孔22为最短的位置,在其规定时间后,也能够反复进行使智能体2的瞳孔22移动到对象物3B和智能体2的瞳孔22为最短的位置。此外,上述规定时间没有特别限定,例如能够为1秒钟。

图8是表示周围检测传感器11看丢了对象物3的情况的智能体2的表情之一例的图。在周围检测传感器11看丢了对象物3的情况下,控制装置16通过表情设定功能,例如如图8所示,通过使智能体2的瞳孔22的位置左右交替地移动,也能够将智能体2的表情设定为探寻对象物3的表情。人在看丢了对象物3的情况下,大多东张西望,因此能够使驾驶员直观地把握周围检测传感器11看丢了对象物3的情况。

图9是示例了周围检测传感器11不能进行对象物3的检测的情况的智能体2的表情之一例的图。因雨、雪、雾等天气或夜间等行驶环境、或附着于周围检测传感器11的污物等,周围检测传感器11往往不能进行对象物3的检测。该情况下,控制装置16通过表情设定功能,例如如图9所示,设定为闭上(关闭)智能体2的眼睛21的表情。在人的眼睛闭上的状态下,看不到周围的对象物,由此能够使驾驶员直观地把握周围检测传感器11不能进行对象物3的检测的情况。

在上述的实施方式中,在配置于本车辆的仪表板的显示器14上显示智能体2,另一方面,示例了拍摄本车辆的周围的图像没有在显示器14上显示的结构。该情况下,如图6(A)、(B)所示,行人(对象物3)在本车辆的左前方被检测到的情况下,以智能体2的视线朝向本车辆的左前方的方式设定智能体2的表情。然而,不限于这样的构成,也可以为以下的构成。

图10是表示在显示器14上显示拍摄本车辆的周围的图像的情况的智能体2的显示例的图。在显示器14上显示拍摄了本车辆周围的图像的情况下,控制装置16通过表情设定功能,也能够以智能体2的视线朝向在显示器14上显示的对象物3的方向的方式设定智能体2的表情。在图10(A)、(B)所示例中,智能体2显示在显示器14的上部,在显示器14的下部显示拍摄了本车辆周围的图像。该情况下,通过表情设定功能,如图10(A)、(B)所示,以智能体2的视线朝向在显示器14的下部显示的对象物3(在图示例中为先行车辆)的方向的方式设定智能体2的表情。具体而言,通过表情设定功能,在拍摄图像内显示的对象物3(图示例中为先行车辆)与智能体2的瞳孔22的距离最短的位置设定智能体2的瞳孔22。

另外,控制装置16通过表情设定功能,在检测到对象物3的情况下,如图10(A)所示,也可以增大智能体2的眼睛21,并且在智能体2上增加眉或张开的嘴,将智能体2的颜色设定为黄色。而且,经过规定时间,周围检测传感器11的检测状态从检测到对象物3的状态向追踪对象物3的状态过渡的情况下,通过表情设定功能,如图10(B)所示,也可以使智能体2的表情返回到初始状态。

图11是示例了在显示器14上显示模仿在本车辆周围存在的对象物3的图像的情形的图。在图11所示例中,在显示器14显示包含对本车辆进行了模仿的图像和对在本车辆周围存在的对象物3(他车辆)进行了模仿的图像的俯瞰图像。在图11所示例中,对其他车辆进行了模仿的图像的配置位置为本车辆与其他车辆的实际的相对位置及与相对距离对应的画面上的位置。例如,在图11所示例中,由于其他车辆在本车辆的前方行驶,故而模仿了其他车辆的图像配置在模仿了本车辆的图像的前方位置。

在显示器14上显示模仿了在本车辆周围存在的对象物的图像的情况下,也可以在模仿了本车辆的图像之上重叠显示智能体2。此时,控制装置16通过表情设定功能,也能够基于其他车辆的位置设定智能体2的表情。具体而言,控制装置16通过表情设定功能,如图11(A)、(B)所示,以智能体2的视线朝向在本车辆前方存在的其他车辆3的方向的方式设定智能体2的表情。

在图11所示的情形下,控制装置16通过表情设定功能,在检测到对象物3的情况下,如图11(A)所示,也可以扩大智能体2的眼睛21,并且在智能体2增加眉或张开的嘴,将智能体2的颜色设定为黄色等。而且,经过规定时间,周围检测传感器11的检测状态从检测到对象物3的状态向追踪对象物3的状态过渡的情况下,如图11(B)所示,也可以使智能体2的表情返回到初始状态。

控制装置160通过行驶控制功能,能够控制本车辆的自动驾驶行驶。具体而言,控制装置16通过行驶控制功能,基于周围检测传感器11的检测结果和规定的行驶条件(交通法规及预定行驶路径等),通过使驱动控制装置15控制发动机或制动器等驱动机构及转向促动器等转舵机构,自动地执行驾驶员通常进行的驾驶操作。例如,控制装置16通过行驶控制功能,以本车辆在车道内行驶的方式使驱动控制装置15控制转向促动器等的动作,从而进行控制本车辆的宽度方向的行驶位置的车道保持控制。另外,控制装置16通过行驶控制功能,以本车辆和先行车辆以一定的车间距离行驶的方式通过使驱动控制装置15控制发动机或制动器等驱动机构的动作,也能够进行自动追随先行车辆的追随行驶控制。另外,控制装置16通过行驶控制功能,基于周围检测传感器11的检测结果或规定的行驶条件,通过控制发动机或制动器等驱动机构及转向促动器等转舵机构,也能够自动执行在十字路口右转弯或左转弯、车道变更及驻停车等。

接着,参照图12对第一实施方式的自动驾驶处理进行说明。图12是表示第一实施方式的自动驾驶处理之一例的流程图。此外,以下说明的自动驾驶处理通过控制装置16执行。首先,在步骤S101中,通过行驶控制功能开始自动驾驶行驶。例如,通过行驶控制功能,在驾驶员将自动驾驶开关(未图示)接通的情况下,从自动驾驶开关取得自动驾驶行驶的开始信号,开始自动驾驶行驶。

在步骤S102中,通过检测结果取得功能,取得周围检测传感器11的检测结果。而且,在步骤S103中,通过检测状态判定功能,基于在步骤S102中取得的周围检测传感器11的检测结果,判定周围检测传感器11的检测状态。

在步骤S104中,通过表情设定功能,基于在步骤S103判定的周围检测传感器11的检测状态,进行智能体2的表情设定。例如,通过表情设定功能,如图4~图9所示,将智能体2的表情设定为与步骤S103中判定的周围检测传感器11的检测状态对应的表情。

在步骤S105中,通过智能体显示功能,进行以步骤S104中设定的智能体2的表情将智能体2显示在显示器14的画面上的处理。

以上,在本实施方式中,基于周围检测传感器11的检测状态,设定在显示器14显示的智能体2的表情。另外,在本实施方式中,智能体2至少具有相当于眼睛21的部位,根据周围检测传感器11的检测状态设定智能体2的眼睛21的显示方式,由此,能够表现周围检测传感器11的检测状态。例如,在周围检测传感器11搜索对象物3的情况下,如图4所示,设定为使睁开眼睛的状态和闭上眼睛的状态反复,智能体2搜索对象物3的表情。另外,在周围检测传感器11检测到对象物的情况下,如图5(A)所示,设定为通过增大智能体2的眼睛,智能体2发觉了什么的表情。另外,在周围检测传感器11追踪对象物3的情况下,如图7(A)~(C)所示,以智能体2的瞳孔22追随对象物3移动的方式设定智能体2的表情。另外,在周围检测传感器11看丢了对象物3的情况下,如图8所示,通过使智能体2的瞳孔22左右交替移动,设定为智能体2寻找看丢了对象物3的表情。另外,在周围检测传感器11不能执行对象物3的检测的情况下,如图9所示,设定为闭上(关闭)智能体2的眼睛21的表情。这样,能够利用智能体2的表情表现周围检测传感器11的检测状态,因此,能够使驾驶员直观地把握周围检测传感器11的检测状态。

另外,在进行自动驾驶行驶时,在驾驶员不能把握周围检测传感器11的检测状态的情况下,驾驶员难以预测本车辆通过自动驾驶行驶是如何驾驶行驶的?或是否进行对象物的避让等必要的驾驶行驶。然而,在本实施方式的自动驾驶装置1中进行自动驾驶行驶时,因被拟人化的智能体2作为媒介物显示周围检测传感器11的检测状态,能够使驾驶员直观地把握周围检测传感器11的检测状态。其结果,能够预测驾驶员通过自动驾驶行驶进行的驾驶行驶,例如相对于行人或自行车窜出的急停止等,能够给驾驶员带来对自动驾驶的安心感。并且,在周围检测传感器11未检测到检测对象物的情况下,能够使驾驶员直观地把握周围检测传感器110未检测到对象物,因此,在周围检测传感器11未检测到的对象物3接近本车辆的情况下,例如能够使驾驶员进行制动操作等必要的驾驶操作。

另外,在本实施方式中,在周围检测传感器11检测到对象物的情况下,如图6及图7所示,也能够以智能体2的视线朝向对象物3存在的方向的方式设定智能体2的瞳孔22的位置。由此,能够使驾驶员适当把握周围检测传感器11检测到的对象物3(对象物的位置)。

而且,在本实施方式中,通过使用智能体2显示周围检测传感器11的检测状态,与不使用智能体2的情况相比,还能够将由周围检测传感器11检测到的对象物3的信息集中地传递给驾驶员。例如,如在显示器14显示的拍摄图像中,如由周围检测传感器11检测到的对象物3上重叠表示被检测的对象物的框线而显示的情况,在未使用智能体2的情况下,周围检测传感器11的检测精度越高,向驾驶员提示的信息量越多。即,由于复杂地显示拍摄图像的信息、与其重叠显示的框线,难以使驾驶员直观地把握周围检测传感器11的检测状态。在这种情况下,由于使用智能体2集中显示周围检测传感器11的检测状态,驾驶员无法从拍摄图像全体读取检测状态,能够使驾驶员直观地把握周围检测传感器11的检测状态。

《第二实施方式》

对第二实施方式的自动驾驶装置进行说明。第二实施方式的自动驾驶装置1具有与图1所示的第一实施方式的自动驾驶装置1同样的构成,除了如以下说明地进行动作之外,与上述的第一实施方式同样地动作。

第二实施方式的控制装置16除了第一实施方式的功能之外,还具有基于由周围检测传感器11检测的对象物(以下,称为显在对象物),算出用于判定是否对驾驶员进行唤起注意的显在判定值的显在判定值算出功能和算出推定是否存在由周围检测传感器11未检测到的对象物(以下,称为潜在对象物),用于判定是否对驾驶员进行唤起注意的潜在判定值的潜在判定值算出功能。

首先,对控制装置16的显在判定值算出功能进行说明。显在判定值算出功能是基于周围检测传感器11的检测结果,将由周围检测传感器11检测到的对象物3特定为显在对象物的功能。作为这种显在对象物,例如列举由周围检测传感器11检测到的行人、自行车、摩托车、汽车、路上障碍物、构造物、交通信号灯、道路标识、车道标志及道路边缘等。

而且,控制装置16在显在对象物为行人、自行车、摩托车、汽车、路上障碍物、构造物等路上立体物的情况下,通过显在判定值算出功能算出本车辆与显在对象物的接近度。具体而言,控制装置16通过显在判定值算出功能,基于由周围检测传感器11检测到的显在对象物的位置信息及速度信息、由本车位置检测装置13检测到的本车辆的位置信息、及由车速传感器12检测到的本车辆的速度信息,算出从本车辆至显在对象物的距离、相对于显在对象物的TTC(Time to Contact)、或THW(Time Headway)。而且,控制装置16通过显在判定值算出功能,基于从本车辆至显在对象物的距离、TTC、或THW,算出本车辆与显在对象物的接近度(接近可能性)并将其作为显在判定值。例如,控制装置16通过显在判定值算出功能,从本车辆至显在对象物的距离越短,或相对于显在对象物的TTC越短,或相对于显在对象物的THW(Time Headway)越短,算出显在判定值越高。

另外,在显在对象物为车道标志或道路边缘等线状平面物的情况下,控制装置16通过显在判定值算出功能,能够算出从本车辆至显在对象物的最短距离、或本车辆和显在对象物的TLC(Time to Lane Crossing)。而且,控制装置16通过显在判定值算出功能,基于本车辆与显在对象物的最短距离或TLC,能够算出显在判定值。例如,控制装置16通过显在判定值算出功能,从本车辆至显在对象物的最短距离越短,另外TLC越短,算出显在判定值越高。

另外,在显在对象物是交通信号灯的情况下,控制装置16通过显在判定值算出功能,基于交通信号灯的信号颜色,能够算出显在判定值。例如,控制装置16通过显在判定值算出功能,在交通信号灯的信号颜色为黄色的情况下,比交通信号灯的信号的颜色为绿色(绿)的情况更高精度地算出显在判定值。另外,在交通信号灯的信号颜色为红色的情况下,控制装置16通过显在判定值算出功能,与交通信号灯的信号的颜色为黄色的情况相比,更高精度地算出显在判定值。另外,在交通信号灯的信号的颜色为红色的情况下,控制装置16通过显在判定值算出功能,本车辆的行驶速度越快,另外自本车辆至停止线的距离越短,越高地算出显在判定值。

而且,控制装置16通过显在判定值算出功能,在显在对象物为道路标识的情况下,基于法定速度与本车辆的行驶速度之差,能够算出显在判定值。例如,控制装置16通过显在判定值算出功能,法定速度与本车辆的行驶速度之差(本车辆的行驶速度-法定速度)越大,越高地算出显在判定值。

此外,在检测有多个显在对象物的情况下,控制装置16通过显在判定值算出功能,能够相对于每一个显在对象物算出显在判定值,将算出的多个显在判定值中最高的显在判定值选择为最终的显在判定值。

这样,控制装置16通过显在判定值算出功能,基于由周围检测传感器11检测到的显在对象物,能够将本车辆与显在对象物的接近度、本车辆从车道或道路偏离的可能性、本车辆违反交通法规的可能性作为显在判定值而进行评价。

接着,对控制装置16的潜在判定值算出功能进行说明。潜在判定值算出功能是推定由周围检测传感器11未检测到的对象物(潜在对象物)是否存在,算出用于判定是否对驾驶员进行唤起注意的潜在判定值的功能。

具体而言,控制装置16通过潜在判定值算出功能,由于行人或自行车等潜在对象物没有从停车中的公共汽车或驻车车辆的后面窜出,所以进行停车中的公共汽车或驻车车辆的检测。而且,在检测到停车中的公共汽车或驻车车辆的情况中,控制装置16通过潜在判定值算出功能,推定为停车中的公共汽车或驻车车辆的后面行人或自行车等潜在对象物存在,与没有检测到停车中的公共汽车或驻车车辆的情况相比,快速算出潜在判定值。另外,控制装置16通过潜在判定值算出功能,推定为在没有交通信号灯的人行横道或十字路口行人或自行车等潜在对象物窜出,在接近没有交通信号灯的人行横道或十字路口的情况下,与不接近没有交通信号灯的人行横道或十字路口的情况相比,也可以较高地算出潜在判定值。

另外,控制装置16通过潜在判定值算出功能,基于由周围检测传感器11未检测到的潜在对象物,预测将来本车辆偏离车道或道路的可能性的程度(可能性的程度也可称为现象的发生概率),基于预测的可能性的程度,算出潜在判定值。例如,控制装置16通过潜在判定值算出功能,根据地图信息判断在本车辆的前方是否有转弯,在本车辆的前方有转弯的情况下,与本车辆的前方无转弯的情况相比,判断出将来本车辆偏离车道或道路的可能性的程度(发生概率)变高,较高地算出潜在判定值。另外,控制装置16通过潜在判定值算出功能,转弯的曲率越高,另外从本车辆至转弯的距离越短或本车辆的速度越快,越高地算出潜在判定值。

这样,控制装置16通过潜在判定值算出功能,推定由周围检测传感器11未检测到的潜在对象物的存在(假定有对象物3),算出本车辆和潜在对象物接近的可能性的程度、本车辆将来从车道或道路偏离的可能性的程度作为用于判定是否向驾驶员唤起注意的潜在判定值。

另外,第二实施方式的控制装置16通过表情设定功能,能够基于通过显在判定值算出功能算出的显在判定值及通过潜在判定值算出功能算出的潜在判定值,设定智能体2的表情。

控制装置16通过表情设定功能,在显在判定值为规定的第一阈值以上的情况下,例如,如图13(A)所示,通过增大智能体2的眼睛21,设定为智能体2惊讶的表情。另外,控制装置16通过表情设定功能,在显在判定值为规定的第一阈值以上的情况下,例如如图13(B)所示,在智能体2上追加眉和张开的嘴,另外,还能够用将智能体2的面部的颜色设定为红色(图13(B)中用粗线斜线智能体2的面部的颜色。以下,图15(B)、图16(B)、图17(B)也同样)。由此,能够对驾驶员唤起对由周围检测传感器11检测到的显在对象物的注意。

另外,控制装置16通过表情设定功能,在潜在判定值为规定的第二阈值以上的情况下,例如如图14(A)所示,通过使智能体2的瞳孔22向左右移动,将智能体2设定为不安的表情。另外,控制装置16通过表情设定功能,例如如图14(B)所示,也可以使智能体2的瞳孔22向左右移动,并且使眉稍下降,嘴角下降,另外面部的颜色设定为黄色。由此,能够对驾驶员唤起对通过周围检测传感器11未检测到的潜在对象物的注意。

另外,控制装置16通过表情设定功能,在显在判定值为第一阈值以上的情况下,例如如图15(A)所示,也可以以显在对象物与智能体2的瞳孔22的距离最短的方式设定智能体2的瞳孔22的位置。由此,能够使驾驶员把握周围检测传感器11检测到的显在对象物(显在对象物的位置)。另外,控制装置16通过表情设定功能,例如如图15(B)所示,还能够增大智能体2的眼睛21、追加眉及张开的嘴,另外将智能体2的颜色设定为红色。由此,能够更进一步督促驾驶员的注意唤起。

此外,在显在对象物移动的情况下,控制装置16通过表情设定功能,也可以以智能体2的视线追随显在对象物的方式设定智能体2的表情。例如,控制装置16通过表情设定功能,通过在显在对象物与智能体2的瞳孔22最短的位置使智能体2的瞳孔22反复移动,也可以使智能体2的视线追随显在对象物。

另外,控制装置16通过表情设定功能,在显示器14上显示摄像头拍摄的显在对象物的情况下,例如如图16(A)所示,也可以以智能体2的视线朝向在显示器14上显示的显在对象物(该图的对象物3为先行车辆)的方向的方式设定智能体2的表情。控制装置16通过表情设定功能,例如显在对象物即先行车辆紧急减速,或显在对象物即其他车辆向本车辆的前方紧急超车而使相对于先行车辆的显在判定值为第一阈值以上的情况下,如图16(A)所示,也可以增大智能体2的眼睛21,并且以智能体2的视线朝向在显示器14显示的显在对象物3的方向的方式设定智能体2的表情。另外,该情况下,控制装置16通过表情设定功能,如图16(B)所示,还能够增大智能体2的眼睛21,并且追加眉及张开状态的嘴,另外,将智能体2的颜色变更为红色。

另外,控制装置16通过表情设定功能,在显示器14显示对本车辆周围存在的显在对象物进行了模仿的图像的情况下,能够以智能体2的视线朝向在显示器14中描画的显在对象物的图像存在的方向的方式设定智能体2的表情。控制装置16通过表情设定功能,例如,显在对象物即先行车辆紧急减速,或显在对象物即其他车辆向本车辆的前方紧急超车而相对于先行车辆的显在判定值为第一阈值以上的情况下,如图17(A)所示,能够以智能体2的视线朝向在显示器14显示的显在对象物3的图像存在的方向的方式设定智能体2的表情。另外,该情况下,控制装置16通过表情设定功能,如图17(B)所示,能够增大智能体2的眼睛21,追加眉及张开的嘴,另外还能够将智能体2的颜色变更为红色。

接着,对第二实施方式的自动驾驶处理进行说明。图18是表示第二实施方式的自动驾驶处理之一例的流程图。此外,以下说明的自动驾驶处理由控制装置16执行。

在步骤S201~S203中进行与第一实施方式的步骤S101~S103同样的处理。即,自动驾驶行驶开始时(步骤S201),进行在本车辆周围存在的对象物3的检测(步骤S202),取得其检测结果(步骤S203)。

在步骤S204中,通过显在判定值算出功能,基于在步骤S203检测的周围检测传感器11的检测结果,进行显在判定值的算出。例如,通过显在判定值算出功能,算出从本车辆至显在对象物的距离、相对于显在对象物的TTC或THW并将其作为显在判定值。

而且,在步骤S205中,通过显在判定值算出功能,进行在步骤S204算出的显在判定值是否为第一阈值以上的判断。第一阈值没有特别限定,但在显在判定值为第一阈值以上的情况下,优选通过实验等适当设定适于提醒驾驶员注意的值。显在判定值为第一阈值以上的情况下,进入步骤S206,显在判定值小于第一阈值的情况下,进入步骤S207。

在步骤S206中,通过表情设定功能,基于在步骤S204算出的显在判定值,设定智能体2的表情。例如,通过表情设定功能,如图15(A)、图16(A)或图17(A)所示,增大智能体2的眼睛21,或如图15(B)、图16(B)、图17(B)所示,在智能体2的面部增加眉及张开的嘴,另外,将智能体2的颜色变更为红色。另外,通过表情设定功能,以智能体2的瞳孔22与显在对象物的距离最短的方式再设定智能体2的瞳孔22的位置。

另一方面,在步骤S205中,在判定为显在判定值小于第一阈值的情况下,进入步骤S207。在步骤S207中,通过潜在判定值算出功能,基于在步骤S203取得的检测结果,进行潜在判定值的算出。例如,通过潜在判定值算出功能推定为具有由周围检测传感器11未检测到的潜在对象物,算出本车辆与潜在对象物的接近度或本车辆将来偏离车道或道路边缘的可能性的程度并将其作为潜在判定值。

而且,在步骤S208中,通过潜在判定值算出功能,进行在步骤S207算出的潜在判定值是否为第二阈值以上的判断。第二阈值没有特别限定,优选在潜在判定值为第二阈值以上的情况下,通过实验等适当设定适于唤起驾驶员的注意的值。在潜在判定值为第二阈值以上的情况下进入步骤S209。在步骤S209中,通过表情设定功能,基于潜在判定值设定智能体2的表情。例如,通过表情设定功能,如图14(A)、图14(B)所示,将智能体2设定为不安的表情。另一方面,在潜在判定值小于第二阈值的情况下,智能体2的表情被设定在初始状态,之后进入步骤S210。

在步骤S210中,通过智能体显示功能,利用在步骤S206或步骤S209设定的表情,在显示器14的画面上显示智能体2。

如上,在第二实施方式中,将由周围检测传感器11检测到的对象物3特定为显在对象物,并算出本车辆与显在对象物的接近度、本车辆为显在对象物的车道标志或跨越道路边缘偏离车道或道路的可能性的程度、及本车辆是显在对象物的交通信号灯或违反速度标识所示的交通法规的可能性的程度并将其作为显在判定值。而且,在显在判定值为第一阈值以上的情况下,如图13(A)、(B)所示,将智能体2设定为惊讶的表情。由此,能够使驾驶员直观地把握本车辆与显在对象物会接近、本车辆会从车道或道路偏离、及本车辆会违反交通法规,能够唤起驾驶员注意。

另外,在第二实施方式中,推定由周围检测传感器11未检测到的潜在对象物的存在,算出本车辆与潜在对象物(例如行人或自行车)的接近度、本车辆跨越潜在对象物(车道标志或道路边缘)偏离车道或道路的可能性的程度并将其作为潜在判定值。而且,在潜在判定值为第二阈值以上的情况下,如图14(A)、(B)所示,将智能体2设定为不安的表情。由此,即使在由周围检测传感器11未检测到对象物3的情况,也能够使驾驶员直观地把握本车辆和潜在对象物会接近、及本车辆将来会偏离车道或道路,能够唤起驾驶员注意。

此外,以上说明的实施方式是为了容易理解而进行记载的,不是为了限定本发明而进行的记载。因此,上述实施方式公开的各要素还包含属于本发明的技术范围的全部的设计变更或同等物的意思。

例如,在上述第一实施方式中示例了在周围检测传感器11检测到对象物3的情况下,如图5(A)、(B)所示地设定智能体2的表情的构成,但代替该构成,或除了该构成外,在行人或自行车等对象物3突然窜出的情况下,如图5(A)、(B)所示,也可以将智能体2设定为惊讶的表情。此外,行人或自行车等对象物3是否突然窜出的判断方法没有特别限定,例如,基于对象物3的识别结果或对象物3接近本车辆的速度等能够判断。

另外,在上述第二实施方式中示例了在显在判定值为规定的第一阈值以上的情况下,如图13(A)、(B)所示地将智能体2设定为惊讶的表情的构成,但不限于该构成,例如,也能够设为以下的构成。即,从本车辆至显在对象物的距离、TTC、或THW为规定值以下的情况下,如图14(A)、(B)所示,将智能体2设定为不安的表情,在先行车辆的紧急减速、其他车辆的紧急超车、行人或自行车的突然窜出的情况下,如图13(A)、(B)所示,也可以将智能体2设定为惊讶的表情。

另外,在上述实施方式中示例了在显示器14中平面地显示智能体2的构成,但不限于该构成,例如,也可以为利用3D显示器立体地显示智能体2的构成、由立体物显示智能体2的构成。另外,通过利用机器人、智能体及其它的立体物等构成智能体2,也可以将智能体2自身视为显示装置。

此外,上述实施方式的周围检测传感器11相当于本发明的检测器,显示器14相当于本发明的显示部或显示装置,控制装置16相当于本发明的控制器。

Claims (12)

1.一种显示装置的控制方法,该显示装置将对至少包含眼睛的面部进行了模仿的图像向驾驶员提示,其中,

在对车辆进行自动驾驶行驶控制的情况下,使用检测所述车辆的周围的对象物的检测器,检测如下状态中的任一状态,即,搜索所述对象物的状态、检测所述对象物的状态、追踪所述对象物的状态、看丢了所述对象物的状态、不能进行所述对象物的检测的状态,基于所述检测器的检测结果,判定所述检测器的检测状态,

基于所判定的检测状态,设定所述眼睛的显示方式。

2.一种显示装置的控制方法,该显示装置将对至少包含眼睛的面部进行了模仿的图像向驾驶员提示,其中,

在对车辆进行自动驾驶行驶控制的情况下,使用检测所述车辆的周围的对象物的检测器,至少检测如下的状态,即,检测到所述对象物的状态及不能进行所述对象物的检测的状态,基于所述检测器的检测结果,判定所述检测器的检测状态,

在所判定的检测状态为检测到所述对象物的情况下,设为将所述眼睛睁开的显示方式,

在所判定的检测状态为不能进行所述对象物的检测的情况下,设为将所述眼睛闭上的显示方式。

3.如权利要求1或2所述的显示装置的控制方法,其中,

所述眼睛包含瞳孔,

根据被检测到的对象物的位置,将所述瞳孔配置在所述对象物与所述瞳孔的距离最短的位置。

4.如权利要求1或2所述的显示装置的控制方法,所述显示装置设置在本车辆中,其中,

将由设置于所述本车辆的所述检测器检测到的所述本车辆周围的对象物特定为显在对象物,

基于所述本车辆与所述显在对象物的接近度、所述本车辆跨过所述显在对象物的可能性的程度、及所述本车辆违反所述显在对象物表示的交通法规的可能性的程度中至少任一种,算出显在判定值,

基于所述显在判定值,设定对面部进行了模仿的所述图像的表情。

5.如权利要求4所述的显示装置的控制方法,其中,

在所述显在对象物为路上的立体物的情况下,算出所述本车辆与所述立体物的接近度并将其作为所述显在判定值。

6.如权利要求4所述的显示装置的控制方法,其中,

在所述显在对象物为路上的车道标志或道路边缘的情况下,算出所述本车辆跨越所述车道标志或所述道路边缘的可能性的程度并将其作为所述显在判定值。

7.如权利要求4所述的显示装置的控制方法,其中,

在所述显在对象物为交通信号灯的情况下,基于所述交通信号灯的信号的颜色,算出所述本车辆违反所述交通法规的可能性的程度并将其作为所述显在判定值。

8.如权利要求1或2所述的显示装置的控制方法,所述显示装置设置在本车辆中,其中,

推定是否存在设置于所述本车辆的所述检测器未检测到的所述本车辆周围的潜在对象物,

在所述潜在对象物存在的情况下,基于所述本车辆与所述潜在对象物的接近度及所述本车辆跨越所述潜在对象物的可能性的程度中的至少任一项,算出潜在判定值,

基于所述潜在判定值,设定对面部进行了模仿的所述图像的表情。

9.如权利要求1或2所述的显示装置的控制方法,所述显示装置设置在本车辆中,其中,

在对所述本车辆进行自动驾驶行驶控制的情况下,基于设置于所述本车辆的所述检测器的检测状态,设定对面部进行了模仿的所述图像的表情。

10.如权利要求1或2所述的显示装置的控制方法,其中,

在所述检测状态为所述对象物的搜索中的情况下,设为将所述眼睛眨眼的显示方式,

在所述检测状态为检测到所述对象物的情况下,设为将所述眼睛睁开的显示方式,

在所述检测状态为追随所述对象物的情况下,设为所述眼睛的视线随着所述对象物移动的显示方式。

11.一种显示装置,其中,具备:

检测器,检测车辆的周围的对象物;

显示部,其将对至少包含眼睛的面部进行了模仿的图像向驾驶员提示;

控制器,其将所述检测器的检测状态以模仿了面部的所述图像为媒介物显示于所述显示部,

在对所述车辆进行自动驾驶行驶控制的情况下,所述检测器检测如下状态中的任一状态,即,搜索所述对象物的状态、检测所述对象物的状态、追踪所述对象物的状态、看丢了所述对象物的状态、不能进行所述对象物的检测的状态,

所述控制器基于所述检测器的检测结果判定所述检测器的检测状态,

基于所判定的检测状态设定所述眼睛的显示方式。

12.一种显示装置,其中,具备:

检测器,检测车辆的周围的对象物;

显示部,其将对至少包含眼睛的面部进行了模仿的图像向驾驶员提示;

控制器,其将所述检测器的检测状态以模仿了面部的所述图像为媒介物显示于所述显示部,

在对所述车辆进行自动驾驶行驶控制的情况下,所述检测器至少检测如下的状态,即,检测到所述对象物的状态及不能进行所述对象物的检测的状态,

所述控制器基于所述检测器的检测结果判定所述检测器的检测状态,

在所判定的检测状态为检测到所述对象物的情况下,设为将所述眼睛睁开的显示方式,

在所判定的检测状态为不能进行所述对象物的检测的情况下,设为将所述眼睛闭上的显示方式。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2016007580 | 2016-01-19 | ||

| JP2016-007580 | 2016-01-19 | ||

| PCT/JP2016/085047 WO2017126221A1 (ja) | 2016-01-19 | 2016-11-25 | 表示装置の制御方法および表示装置 |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| CN108604413A CN108604413A (zh) | 2018-09-28 |

| CN108604413B true CN108604413B (zh) | 2020-06-16 |

Family

ID=59362353

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| CN201680079338.8A Active CN108604413B (zh) | 2016-01-19 | 2016-11-25 | 显示装置的控制方法及显示装置 |

Country Status (11)

| Country | Link |

|---|---|

| US (1) | US10522041B2 (zh) |

| EP (1) | EP3407325A4 (zh) |

| JP (1) | JP6604388B2 (zh) |

| KR (1) | KR101999079B1 (zh) |

| CN (1) | CN108604413B (zh) |

| BR (1) | BR112018014530A2 (zh) |

| CA (1) | CA3011209A1 (zh) |

| MX (1) | MX371255B (zh) |

| MY (1) | MY194457A (zh) |

| RU (1) | RU2731676C2 (zh) |

| WO (1) | WO2017126221A1 (zh) |

Families Citing this family (8)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP7095337B2 (ja) * | 2018-03-19 | 2022-07-05 | トヨタ自動車株式会社 | 表示制御装置および表示制御方法 |

| JP2019209917A (ja) * | 2018-06-07 | 2019-12-12 | 本田技研工業株式会社 | 車両制御装置、車両制御方法、及びプログラム |

| JP2021072039A (ja) * | 2019-11-01 | 2021-05-06 | 株式会社東海理化電機製作所 | 提示装置 |

| CN114730520B (zh) * | 2019-11-12 | 2023-07-04 | 日产自动车株式会社 | 信号机识别方法及信号机识别装置 |

| JP7241005B2 (ja) * | 2019-11-27 | 2023-03-16 | 京セラ株式会社 | ヘッドアップディスプレイシステムおよび移動体 |

| JP7310705B2 (ja) * | 2020-05-18 | 2023-07-19 | トヨタ自動車株式会社 | エージェント制御装置、エージェント制御方法、及びエージェント制御プログラム |

| JP7515384B2 (ja) * | 2020-11-30 | 2024-07-12 | 本田技研工業株式会社 | 表示方法、及びシステム |

| JP2022119496A (ja) | 2021-02-04 | 2022-08-17 | 本田技研工業株式会社 | 車両用シートベルト装置 |

Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2009265330A (ja) * | 2008-04-24 | 2009-11-12 | Panasonic Electric Works Co Ltd | 映像表示装置 |

| EP2639781A1 (en) * | 2012-03-14 | 2013-09-18 | Honda Motor Co., Ltd. | Vehicle with improved traffic-object position detection |

| CN103732480A (zh) * | 2011-06-17 | 2014-04-16 | 罗伯特·博世有限公司 | 用于在行车道上车辆的线路引导中辅助驾驶员的方法和设备 |

| WO2015135621A1 (de) * | 2014-03-12 | 2015-09-17 | Daimler Ag | Verfahren und vorrichtung zur unterstützung eines fahrers beim führen eines fahrzeugs |

Family Cites Families (22)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP3873386B2 (ja) * | 1997-07-22 | 2007-01-24 | 株式会社エクォス・リサーチ | エージェント装置 |

| US6249720B1 (en) | 1997-07-22 | 2001-06-19 | Kabushikikaisha Equos Research | Device mounted in vehicle |

| JP2000267039A (ja) * | 1999-03-15 | 2000-09-29 | Shimadzu Corp | ヘッドアップディスプレイ |

| JP2002046501A (ja) | 2001-06-13 | 2002-02-12 | Hitachi Ltd | 自動車の走行制御装置 |

| JP2003291688A (ja) * | 2002-04-03 | 2003-10-15 | Denso Corp | 表示方法、運転支援装置、プログラム |

| US7242312B2 (en) * | 2002-05-29 | 2007-07-10 | Yamaha Hatsudoki Kabushiki Kaisha | Product state display system, and program and recording medium for the same |

| JP2006284454A (ja) | 2005-04-01 | 2006-10-19 | Fujitsu Ten Ltd | 車載用エージェントシステム |

| JP2006315489A (ja) * | 2005-05-11 | 2006-11-24 | Toyota Motor Corp | 車両周囲警報装置 |

| JP4720386B2 (ja) * | 2005-09-07 | 2011-07-13 | 株式会社日立製作所 | 運転支援装置 |

| JP4952421B2 (ja) * | 2007-07-18 | 2012-06-13 | 株式会社デンソー | 運転支援システム |

| JP5055166B2 (ja) * | 2008-02-29 | 2012-10-24 | キヤノン株式会社 | 眼の開閉度判定装置、方法及びプログラム、撮像装置 |

| JP5187517B2 (ja) | 2008-11-27 | 2013-04-24 | 株式会社デンソーアイティーラボラトリ | 情報提供装置、情報提供方法およびプログラム |

| JP2010173342A (ja) | 2009-01-27 | 2010-08-12 | Nissan Motor Co Ltd | 情報提供装置及び情報提供方法 |

| US8384532B2 (en) * | 2009-04-02 | 2013-02-26 | GM Global Technology Operations LLC | Lane of travel on windshield head-up display |

| CN101692980B (zh) * | 2009-10-30 | 2011-06-08 | 深圳市汉华安道科技有限责任公司 | 疲劳驾驶检测方法及装置 |

| JP5723561B2 (ja) | 2010-09-29 | 2015-05-27 | 富士重工業株式会社 | 運転支援装置 |

| CN103609101A (zh) * | 2011-06-16 | 2014-02-26 | 爱信精机株式会社 | 车辆周边监视装置 |

| JP5616531B2 (ja) | 2011-09-21 | 2014-10-29 | 本田技研工業株式会社 | 車両周辺監視装置 |

| US9396401B2 (en) * | 2011-11-01 | 2016-07-19 | Aisin Seiki Kabushiki Kaisha | Obstacle alarm device |

| US9200790B2 (en) * | 2012-06-29 | 2015-12-01 | Hallmark Cards, Incorporated | Decorative object that produces a complimentary shadow design |

| JP6537780B2 (ja) | 2014-04-09 | 2019-07-03 | 日立オートモティブシステムズ株式会社 | 走行制御装置、車載用表示装置、及び走行制御システム |

| US10446055B2 (en) * | 2014-08-13 | 2019-10-15 | Pitchvantage Llc | Public speaking trainer with 3-D simulation and real-time feedback |

-

2016

- 2016-11-25 RU RU2018129960A patent/RU2731676C2/ru active

- 2016-11-25 MY MYPI2018702314A patent/MY194457A/en unknown

- 2016-11-25 CN CN201680079338.8A patent/CN108604413B/zh active Active

- 2016-11-25 BR BR112018014530-0A patent/BR112018014530A2/pt not_active Application Discontinuation

- 2016-11-25 CA CA3011209A patent/CA3011209A1/en active Pending

- 2016-11-25 US US16/069,567 patent/US10522041B2/en active Active

- 2016-11-25 WO PCT/JP2016/085047 patent/WO2017126221A1/ja active Application Filing

- 2016-11-25 MX MX2018008214A patent/MX371255B/es active IP Right Grant

- 2016-11-25 JP JP2017562455A patent/JP6604388B2/ja active Active

- 2016-11-25 KR KR1020187020114A patent/KR101999079B1/ko active IP Right Grant

- 2016-11-25 EP EP16886460.1A patent/EP3407325A4/en not_active Ceased

Patent Citations (4)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP2009265330A (ja) * | 2008-04-24 | 2009-11-12 | Panasonic Electric Works Co Ltd | 映像表示装置 |

| CN103732480A (zh) * | 2011-06-17 | 2014-04-16 | 罗伯特·博世有限公司 | 用于在行车道上车辆的线路引导中辅助驾驶员的方法和设备 |

| EP2639781A1 (en) * | 2012-03-14 | 2013-09-18 | Honda Motor Co., Ltd. | Vehicle with improved traffic-object position detection |

| WO2015135621A1 (de) * | 2014-03-12 | 2015-09-17 | Daimler Ag | Verfahren und vorrichtung zur unterstützung eines fahrers beim führen eines fahrzeugs |

Also Published As

| Publication number | Publication date |

|---|---|

| EP3407325A4 (en) | 2019-07-03 |

| RU2731676C2 (ru) | 2020-09-07 |

| CA3011209A1 (en) | 2017-07-27 |

| EP3407325A1 (en) | 2018-11-28 |

| JP6604388B2 (ja) | 2019-11-20 |

| RU2018129960A (ru) | 2020-02-20 |

| BR112018014530A2 (pt) | 2018-12-11 |

| JPWO2017126221A1 (ja) | 2018-12-06 |

| KR20180094992A (ko) | 2018-08-24 |

| KR101999079B1 (ko) | 2019-07-10 |

| MY194457A (en) | 2022-11-30 |

| MX371255B (es) | 2020-01-23 |

| US20190027039A1 (en) | 2019-01-24 |

| CN108604413A (zh) | 2018-09-28 |

| US10522041B2 (en) | 2019-12-31 |

| MX2018008214A (es) | 2018-09-07 |

| RU2018129960A3 (zh) | 2020-04-17 |

| WO2017126221A1 (ja) | 2017-07-27 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| CN108604413B (zh) | 显示装置的控制方法及显示装置 | |

| JP7416176B2 (ja) | 表示装置 | |

| US11008016B2 (en) | Display system, display method, and storage medium | |

| CN106873580B (zh) | 基于感知数据在交叉口处自主驾驶 | |

| JP7517835B2 (ja) | 不明瞭な路上障害物の回避 | |

| CN109515434B (zh) | 车辆控制装置、车辆控制方法及存储介质 | |

| US9734390B2 (en) | Method and device for classifying a behavior of a pedestrian when crossing a roadway of a vehicle as well as passenger protection system of a vehicle | |

| US10754335B2 (en) | Automated driving system | |

| US11225266B2 (en) | Systems and methods for improving visual scanning behavior associated with controlling a vehicle | |

| CN111824126B (zh) | 车辆控制系统 | |

| US20200066160A1 (en) | Lane Change Assistance Method and Lane Change Assistance Device | |

| CN111746511A (zh) | 车辆控制系统 | |

| CN109318894B (zh) | 车辆驾驶辅助系统、车辆驾驶辅助方法及车辆 | |

| CN110281934B (zh) | 车辆控制装置、车辆控制方法及存储介质 | |

| US20190147264A1 (en) | Concentration determination apparatus, concentration determination method, and program for concentration determination | |

| CN113401056A (zh) | 显示控制装置、显示控制方法以及计算机可读取存储介质 | |

| CN115257813A (zh) | 通过施工障碍物的智能驾驶控制方法及车辆 | |

| US10766412B1 (en) | Systems and methods for notifying other road users of a change in vehicle speed | |

| JP7548847B2 (ja) | 運転支援装置 | |

| US20230264697A1 (en) | Varying extended reality content based on driver attentiveness | |

| JP2022123940A (ja) | 車両制御装置 | |

| CN118850064A (zh) | 车辆变道控制方法、装置、计算机设备以及存储介质 |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| PB01 | Publication | ||

| PB01 | Publication | ||

| SE01 | Entry into force of request for substantive examination | ||

| SE01 | Entry into force of request for substantive examination | ||

| GR01 | Patent grant | ||

| GR01 | Patent grant |