- Chinese version of GPT2 training code, using BERT tokenizer or BPE tokenizer. It is based on the extremely awesome repository from HuggingFace team Transformers. Can write poems, news, novels, or train general language models. Support char level, word level and BPE level. Support large training corpus.

- 中文的GPT2训练代码,使用BERT的Tokenizer或Sentencepiece的BPE model(感谢kangzhonghua的贡献,实现BPE模式需要略微修改train.py的代码)。可以写诗,新闻,小说,或是训练通用语言模型。支持字为单位或是分词模式或是BPE模式(需要略微修改train.py的代码)。支持大语料训练。

-

本项目新增了通用中文GPT-2预训练模型、通用中文GPT-2预训练小模型、中文歌词GPT-2预训练模型和文言文GPT-2预训练模型。模型由UER-py项目训练得到,欢迎大家使用。 此外,模型上传到了Huggingface Model Hub中。更多模型的细节请参考gpt2-chinese-cluecorpussmall、gpt2-distil-chinese-cluecorpussmall、gpt2-chinese-lyric和gpt2-chinese-ancient。

在使用所有模型进行生成时,需要在输入的文本前加入一个起始符,如:若要输入“最美的不是下雨天,是曾与你躲过雨的屋檐”,正确的格式为“[CLS]最美的不是下雨天,是曾与你躲过雨的屋檐”。

-

本项目新增了古诗词GPT-2预训练模型和对联GPT-2预训练模型。模型由UER-py项目训练得到,欢迎大家使用。 此外,模型上传到了Huggingface Model Hub中。更多模型的细节请参考gpt2-chinese-poem和gpt2-chinese-couplet。

在使用古诗词模型进行生成时,需要在输入的文本前加入一个起始符,如:若要输入“梅山如积翠,”,正确的格式为“[CLS]梅山如积翠,”。

对联模型训练时使用的语料格式为“上联-下联”,在使用对联模型进行生成时,需要在输入的文本前加入一个起始符,如:若要输入“丹枫江冷人初去-”,正确的格式为“[CLS]丹枫江冷人初去-”。

- CDial-GPT(可用本代码载入)已发布。本项目包含一个经过严格清洗的大规模放开域中文对话数据集,本项目还包含在此数据集上训练的GPT对话预训练模型,以及生成样例,欢迎大家参观。

- 新项目GPT2-chitchat已发布,部分基于本项目代码。包含训练GPT2对话模型的代码与与训练模型,以及生成样例,欢迎大家参观。

- 新项目Decoders-Chinese-TF2.0同样支持GPT2的中文训练,在使用上更加简单,不易产生各种问题。目前还在测试阶段,欢迎大家提出意见。

- GPT2-ML(与本项目无任何直接关联)已发布,包含1.5B中文GPT2模型。大家如有兴趣或需要可将其转换为本项目支持的Pytorch格式进行进一步训练或生成测试。

- 本项目第一个预训练模型已公布,为散文生成模型,具体可查看README模型分享部分。

- 在本项目公布时,中文的GPT2资源几乎为零,而现在情况已有所不同。其次项目功能已经基本稳定,因此目前本项目暂已停止更新。我写下这些代码的初衷是练习Pytorch的使用,即使后期做了一些填坑工作,难免还是有很多不成熟的地方,也请谅解。

- 在项目根目录建立data文件夹。将训练语料以train.json为名放入data目录中。train.json里是一个json列表,列表的每个元素都分别是一篇要训练的文章的文本内容(而不是文件链接)。

- 运行train.py文件,勾选 --raw ,会自动预处理数据。

- 预处理完成之后,会自动执行训练。

python ./generate.py --length=50 --nsamples=4 --prefix=xxx --fast_pattern --save_samples --save_samples_path=/mnt/xx- --fast_pattern (由LeeCP8贡献):如果生成的length参数比较小,速度基本无差别,我个人测试length=250时,快了2秒,所以如果不添加--fast_pattern,那么默认不采用fast_pattern方式。

- --save_samples:默认将输出样本直接打印到控制台,传递此参数,将保存在根目录下的samples.txt。

- --save_samples_path:可自行指定保存的目录,默认可递归创建多级目录,不可以传递文件名称,文件名称默认为samples.txt。

- generate.py 与 train.py 分别是生成与训练的脚本。

- train_single.py 是 train.py的延伸,可以用于一个很大的单独元素列表(如训练一本斗破苍穹书)。

- eval.py 用于评估生成模型的ppl分值。

- generate_texts.py 是 generate.py 的延伸,可以以一个列表的起始关键词分别生成若干个句子并输出到文件中。

- train.json 是训练样本的格式范例,可供参考。

- cache 文件夹内包含若干BERT词表,make_vocab.py 是一个协助在一个train.json语料文件上建立词表的脚本。 vocab.txt 是原始BERT词表, vocab_all.txt 额外添加了古文词, vocab_small.txt 是小词表。

- tokenizations 文件夹内是可以选用的三种tokenizer,包括默认的Bert Tokenizer,分词版Bert Tokenizer以及BPE Tokenizer。

- scripts 内包含了样例训练与生成脚本

- 本项目使用Bert的tokenizer处理中文字符。

- 如果不使用分词版的tokenizer,不需要自己事先分词,tokenizer会帮你分。

- 如果使用分词版的tokenizer,最好先使用cache文件夹内的make_vocab.py文件建立针对你的语料的词表。

- 模型需自行运算。各位如果完成了预训练的话欢迎进行交流。

- 如果你的内存非常大或者语料较小的话,可以改掉train.py内build files内的对应代码,不做拆分直接预处理语料。

- 若使用BPE Tokenizer,需自己建立中文词表

- 我在train.py文件中加入了fp16与gradient accumulation支持,如果你安装了apex并且知道fp16是什么的话,可以修改变量fp16=True来启用。但是目前fp16可能不收敛,原因不明。

- Mail:[email protected]

@misc{GPT2-Chinese,

author = {Zeyao Du},

title = {GPT2-Chinese: Tools for training GPT2 model in Chinese language},

year = {2019},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {\url{https://github.com/Morizeyao/GPT2-Chinese}},

}

| 模型名称 | 模型介绍 | 分享者 | 链接地址1 | 链接地址2 |

|---|---|---|---|---|

| 散文模型 | 使用130MB的名家散文、情感散文和散文诗歌训练所得 。 | hughqiu | 百度网盘【fpyu】 | GDrive |

| 诗词模型 | 使用180MB的约80万首古诗词训练所得。 | hhou435 | 百度网盘【7fev】 | GDrive |

| 对联模型 | 使用40MB的约70万条对联训练所得。 | hhou435 | 百度网盘【i5n0】 | GDrive |

| 通用中文模型 | 使用CLUECorpusSmall语料训练所得。 | hhou435 | 百度网盘【n3s8】 | GDrive |

| 通用中文小模型 | 使用CLUECorpusSmall语料训练所得。 | hhou435 | 百度网盘【rpjk】 | GDrive |

| 中文歌词模型 | 使用140MB的约15万首中文歌词训练所得。 | hhou435 | 百度网盘【0qnn】 | GDrive |

| 文言文模型 | 使用1.8GB的约300万篇文言文训练所得。 | hhou435 | 百度网盘【ek2z】 | GDrive |

此处为热情大方的git友训练所得的模型文件,公开给所有朋友使用,同时也欢迎各位伙伴将自己训练完毕的模型公开于此处。

- 由用户JamesHujy根据本仓库改版代码训练得到的模型作为律诗与绝句后台,新版九歌诗歌生成器已经上线。

- 由leemengtaiwan贡献,提供文章直觀介紹 GPT-2 以及如何視覺化自注意力機制。另提供 Colab 筆記本與模型供任何使用者一鍵生成新樣例。

-以下为文学散文的生成样例,由hughqiu贡献,模型已经分享于模型分享列表。语料130MB,Batch size 16,10层深度下训练10轮所得。

- 下为斗破苍穹的生成样例,使用约50M参数的GPT2以32Batch Size在16MB斗破苍穹小说内容上训练得到。此处[SEP]表示换行。

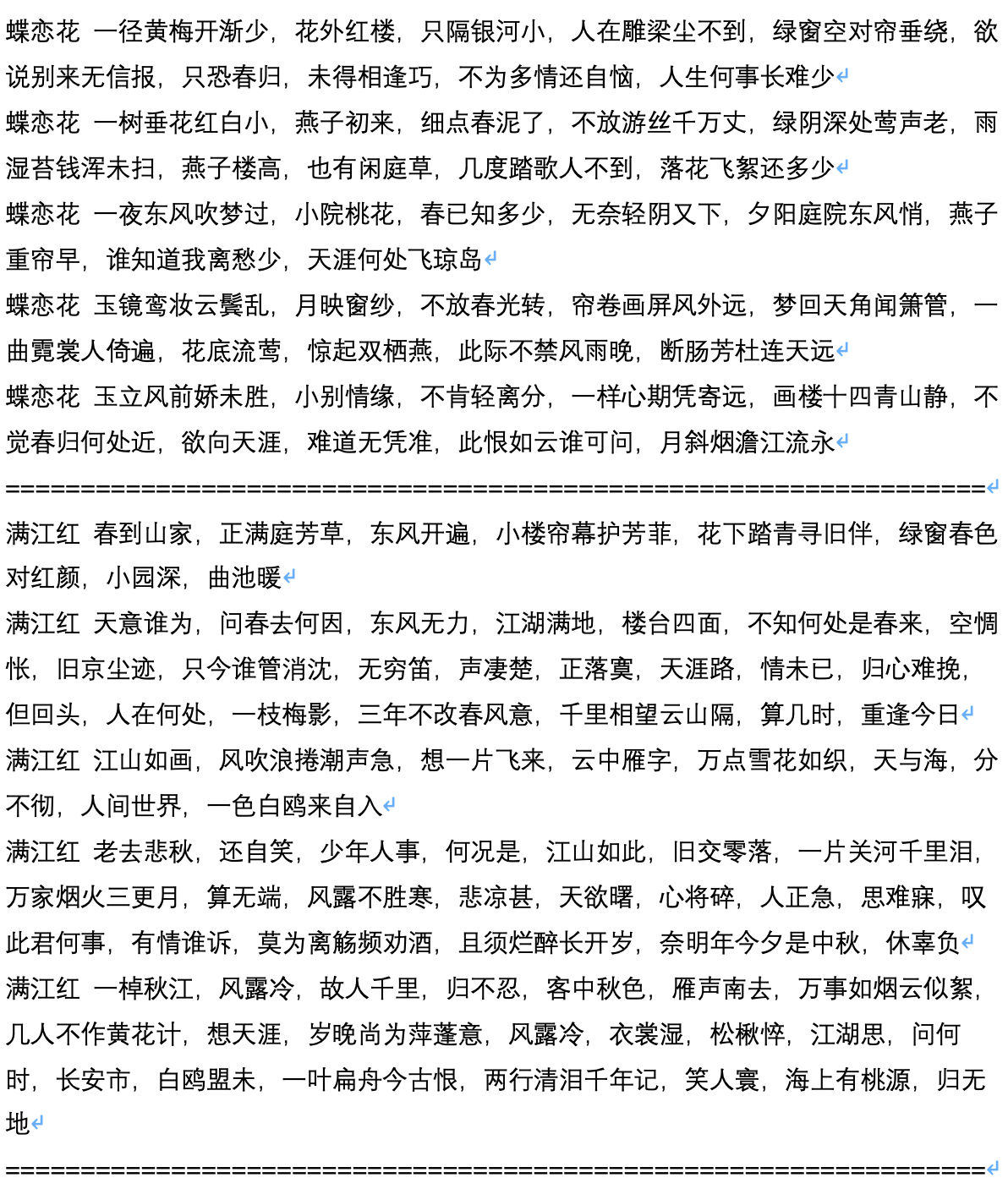

- 下为古诗词的生成样例,由用户JamesHujy运算并贡献。

- 下为古诗限定了生成体裁后的生成样例,由用户JamesHujy运算并贡献。

-

下为生成剧本的样例文本,由用户chiangandy运算并贡献

-

下為金庸武俠小說的生成樣例,由leemengtaiwan贡献。模型大小約 82M,語料 50 MB,Batch size 16。提供文章直觀介紹 GPT-2 以及如何視覺化自注意力機制。另提供 Colab 筆記本與模型供任何使用者一鍵生成新樣例。