[PT-BR] Este projeto foi desenvolvido durante o Summer Institute in Computational Social Sciences (SICSS) 2024, Brazil. Siga as instruções em português aqui.

[EN] This project was developed during the Summer Institute in Computational Social Sciences (SICSS) 2024, Brazil. Follow the instructions in English here.

Ele consiste em um sumarizador de artigos científicos em português. O projeto faz o scraping do conteúdo do artigo no site da SciELO e gera um sumário personalizado para o usuário utilizando Large Language Models (LLMs), especificamente o Llama3.

Para rodar o projeto localmente, você precisa ter tanto o Python 3.8 ou superior quanto o Llama3 instalado. Também é possível rodar o projeto no Google Colab, seguindo este link.

Para rodar o projeto no Google Colab, você pode usar o seguinte link. Isso abrirá o projeto no Google Colab, e você poderá rodar as células para gerar os sumários.

Siga as instruções no notebook para rodar o projeto. Por exemplo, você precisará fazer o upload do arquivo utils.py para o ambiente do Colab para rodar o projeto.

Para instalar as dependências, rode o seguinte comando:

pip install -r requirements.txtEste projeto utiliza o modelo Llama3, um Large Language Model (LLM) de última geração desenvolvido pela Meta. Nós instalamos o modelo utilizando o pacote ollama, que é um wrapper em Python para o Llama3. Para instalar o ollama, rode o seguinte comando:

pip install ollamaDepois de instalar o ollama, você pode baixar o modelo Llama3 seguindo as instruções no repositório oficial. As instruções podem variar dependendo do seu sistema operacional.

Para rodar o projeto, execute o seguinte comando:

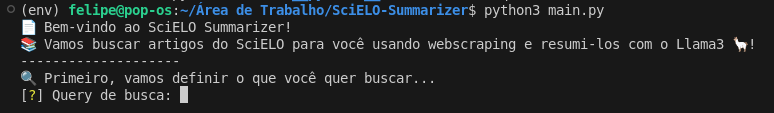

python main.pyEste comando iniciará o programa, e você será solicitado a inserir a consulta de pesquisa.

Você também será solicitado a inserir o número de artigos que deseja extrair, o critério de ordenação e o intervalo de tempo. Você também pode escolher entre os métodos de sumarização disponíveis. Isso contém a opção de sumarizar o artigo usando o texto completo, ou sumarizar o artigo seção por seção.

Você também pode inserir um link para um servidor remoto (que deve ter o modelo Llama3 instalado) para rodar a sumarização. Isso é especialmente útil se você deseja rodar o projeto em um servidor com mais poder computacional. Mas lembre-se de que é possível utilizar o Google Colab, conforme mencionado anteriormente.

Ao final da execução, o programa gerará um sumário dos artigos e gerará um arquivo .xlsx com os sumários, que pode ser encontrado na pasta resumos.

This project was developed during the Summer Institute in Computational Social Sciences (SICSS) 2024, Brazil.

It consists of a summarizer for scientific articles in Portuguese. It scrapes the content of the article from the SciELO website and generates a personalized summary for the user using Large Language Models (LLMs), especifically Llama3.

To run the project locally, you need to have both Python 3.8 or higher and Llama3 installed. It is also possible to run the project on Google Colab, following this link.

To run the project on Google Colab, you can use the following link. This will open the project in Google Colab, and you can run the cells to generate the summaries.

Follow the instructions in the notebook to run the project. For instance, you will need to upload the utils.py file to the Colab environment to run the project.

To install the dependencies, run the following command:

pip install -r requirements.txtThis project uses the Llama3 model, a state-of-the-art Large Language Model (LLM) developed by Meta. We installed the model using the ollama package, which is a Python wrapper for Llama3. To install ollama, run the following command:

pip install ollamaAftar installing ollama, you can download the Llama3 model following the instructions in the official repository. The instructions may vary depending on your operating system.

To run the project, execute the following command:

python main.pyThis command will start the program, and you will be prompted to enter the search query.

You will also be prompted to enter the number of papers you want to extract, the sortin criteria and the time range. You can also choose between the summarization methods available. This contains the option of summarizing the paper using the full text, or summarizing the paper section by section.

You can also input a link to a remote server (which should have the Llama3 model installed) to run the summarization. This is especially useful if you want to run the project on a server with more computational power. But remember that you can use Google Colab, as mentioned earlier.

By the end of the execution, the program will generate a summary of the articles and output an .xlsx file with the summaries, which can be found in the resumos folder.