JP4355772B2 - 力み変換装置、音声変換装置、音声合成装置、音声変換方法、音声合成方法およびプログラム - Google Patents

力み変換装置、音声変換装置、音声合成装置、音声変換方法、音声合成方法およびプログラム Download PDFInfo

- Publication number

- JP4355772B2 JP4355772B2 JP2009500111A JP2009500111A JP4355772B2 JP 4355772 B2 JP4355772 B2 JP 4355772B2 JP 2009500111 A JP2009500111 A JP 2009500111A JP 2009500111 A JP2009500111 A JP 2009500111A JP 4355772 B2 JP4355772 B2 JP 4355772B2

- Authority

- JP

- Japan

- Prior art keywords

- phoneme

- speech

- force

- voice

- input

- Prior art date

- Legal status (The legal status is an assumption and is not a legal conclusion. Google has not performed a legal analysis and makes no representation as to the accuracy of the status listed.)

- Expired - Fee Related

Links

- 238000006243 chemical reaction Methods 0.000 title claims description 124

- 238000000034 method Methods 0.000 title claims description 44

- 230000015572 biosynthetic process Effects 0.000 title claims description 31

- 238000003786 synthesis reaction Methods 0.000 title claims description 29

- 238000001308 synthesis method Methods 0.000 title claims description 5

- 230000000737 periodic effect Effects 0.000 claims description 85

- 238000012545 processing Methods 0.000 claims description 57

- 238000004458 analytical method Methods 0.000 claims description 40

- 230000001755 vocal effect Effects 0.000 description 68

- 238000012986 modification Methods 0.000 description 36

- 230000004048 modification Effects 0.000 description 36

- 238000010586 diagram Methods 0.000 description 35

- 230000014509 gene expression Effects 0.000 description 28

- 210000000056 organ Anatomy 0.000 description 22

- 230000005236 sound signal Effects 0.000 description 22

- 230000008451 emotion Effects 0.000 description 17

- 230000008859 change Effects 0.000 description 16

- 230000007274 generation of a signal involved in cell-cell signaling Effects 0.000 description 13

- 238000002474 experimental method Methods 0.000 description 12

- 230000002996 emotional effect Effects 0.000 description 10

- 230000002123 temporal effect Effects 0.000 description 10

- 230000010363 phase shift Effects 0.000 description 7

- 230000008569 process Effects 0.000 description 6

- 238000012706 support-vector machine Methods 0.000 description 6

- 238000005516 engineering process Methods 0.000 description 5

- 230000001965 increasing effect Effects 0.000 description 5

- 238000011002 quantification Methods 0.000 description 5

- 238000001228 spectrum Methods 0.000 description 5

- 238000007796 conventional method Methods 0.000 description 4

- 230000007423 decrease Effects 0.000 description 4

- 238000013461 design Methods 0.000 description 4

- 230000008921 facial expression Effects 0.000 description 4

- 230000000877 morphologic effect Effects 0.000 description 4

- 239000011435 rock Substances 0.000 description 4

- 230000001771 impaired effect Effects 0.000 description 3

- 238000011160 research Methods 0.000 description 3

- 230000004044 response Effects 0.000 description 3

- 238000005728 strengthening Methods 0.000 description 3

- 230000000694 effects Effects 0.000 description 2

- 238000003825 pressing Methods 0.000 description 2

- 238000007619 statistical method Methods 0.000 description 2

- 230000001131 transforming effect Effects 0.000 description 2

- 239000013598 vector Substances 0.000 description 2

- 206010013952 Dysphonia Diseases 0.000 description 1

- 238000013528 artificial neural network Methods 0.000 description 1

- 230000008901 benefit Effects 0.000 description 1

- 230000002146 bilateral effect Effects 0.000 description 1

- 230000005540 biological transmission Effects 0.000 description 1

- 238000004364 calculation method Methods 0.000 description 1

- 238000004891 communication Methods 0.000 description 1

- 230000001419 dependent effect Effects 0.000 description 1

- 238000001514 detection method Methods 0.000 description 1

- 239000012636 effector Substances 0.000 description 1

- 230000002708 enhancing effect Effects 0.000 description 1

- 239000000284 extract Substances 0.000 description 1

- 210000004704 glottis Anatomy 0.000 description 1

- 208000027498 hoarse voice Diseases 0.000 description 1

- 230000003993 interaction Effects 0.000 description 1

- 210000000867 larynx Anatomy 0.000 description 1

- 239000000463 material Substances 0.000 description 1

- 230000007246 mechanism Effects 0.000 description 1

- 239000000203 mixture Substances 0.000 description 1

- 238000012544 monitoring process Methods 0.000 description 1

- 230000008447 perception Effects 0.000 description 1

- 230000033764 rhythmic process Effects 0.000 description 1

- 238000005070 sampling Methods 0.000 description 1

- 230000003595 spectral effect Effects 0.000 description 1

- 238000010183 spectrum analysis Methods 0.000 description 1

- 230000002194 synthesizing effect Effects 0.000 description 1

- 230000007704 transition Effects 0.000 description 1

- 210000001260 vocal cord Anatomy 0.000 description 1

Images

Classifications

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L13/00—Speech synthesis; Text to speech systems

- G10L13/02—Methods for producing synthetic speech; Speech synthesisers

- G10L13/033—Voice editing, e.g. manipulating the voice of the synthesiser

-

- G—PHYSICS

- G10—MUSICAL INSTRUMENTS; ACOUSTICS

- G10L—SPEECH ANALYSIS TECHNIQUES OR SPEECH SYNTHESIS; SPEECH RECOGNITION; SPEECH OR VOICE PROCESSING TECHNIQUES; SPEECH OR AUDIO CODING OR DECODING

- G10L21/00—Speech or voice signal processing techniques to produce another audible or non-audible signal, e.g. visual or tactile, in order to modify its quality or its intelligibility

- G10L21/003—Changing voice quality, e.g. pitch or formants

- G10L21/007—Changing voice quality, e.g. pitch or formants characterised by the process used

- G10L21/013—Adapting to target pitch

- G10L2021/0135—Voice conversion or morphing

Landscapes

- Engineering & Computer Science (AREA)

- Computational Linguistics (AREA)

- Health & Medical Sciences (AREA)

- Audiology, Speech & Language Pathology (AREA)

- Human Computer Interaction (AREA)

- Physics & Mathematics (AREA)

- Acoustics & Sound (AREA)

- Multimedia (AREA)

- Electrically Operated Instructional Devices (AREA)

- Stereophonic System (AREA)

Description

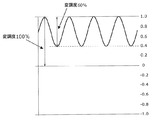

図1は、実施の形態1の音声変換装置または音声合成装置の一部である、力み変換部の構成を示す機能ブロック図である。図2は、「力み」音声の波形の一例を示す図である。図3Aは、実際の音声に含まれる力みのない音声の波形と波形の包絡の概形を示す図である。図3Bは、実際の音声に含まれる力みのある音声の波形と波形の包絡の概形を示す図である。図4Aは、男性話者について、実音声中に観察された「力み」音声の振幅包絡の変動周波数の分布を示した図である。図4Bは、女性話者について、実音声中に観察された「力み」音声の振幅包絡の変動周波数の分布を示した図である。図5は、通常発声の音声に「力み」の変換処理を行った音声波形の一例を示す図である。図6は、通常発声の音声と「力み」変換処理を行った音声とを聞き比べる聴取実験の結果を示したグラフである。図7は、聴取実験により確認された「力み」音声に聞こえる振幅変動周波数の範囲を示すグラフである。図8は、振幅変動の変調度を説明するための図である。図9は、聴取実験により確認された、「力み」音声に聞こえる振幅変動の変調度の範囲を示すグラフである。図10は、力み変換部の動作を示すフローチャートである。

図11は実施の形態1の力み変換部の変形例の機能ブロック図であり、図12は実施の形態1の力み変換部の変形例の動作を示すフローチャートである。図1および図6と同じ構成要素については同じ符号を用い、その詳細な説明は繰り返さない。

図13は、実施の形態2の音声変換装置または音声合成装置の一部である、力み変換部の構成を示す機能ブロック図である。図14は本実施の形態の力み変換部の動作を示すフローチャートである。図1および図10と同じ構成要素については同じ符号を用い、その詳細な説明は繰り返さない。

図15は実施の形態2の力み変換部の変形例の機能ブロック図であり、図16は実施の形態2の力み変換部の変形例の動作を示すフローチャートである。図7および図8と同じ構成要素については同じ符号を用い、その詳細な説明は繰り返さない。

図17は実施の形態3の音声変換装置の構成を示す機能ブロック図である。図18は本実施の形態の同左を示すフローチャートである。図1および図10と同じ構成要素については同じ符号を用い、その詳細な説明は繰り返さない。

図19は実施の形態3の音声変換装置の変形例の機能ブロック図であり、図20は実施の形態3の音声変換装置の変形例の動作を示すフローチャートである。図9および図10と同じ構成要素については同じ符号を用い、その詳細な説明は繰り返さない。

図21は、実施の形態4の音声合成装置の構成を示す機能ブロック図である。図22は本実施の形態の同左を示すフローチャートである。図23は本実施の形態の1の変形例の音声合成装置の構成を示す機能ブロック図である。図24および図25は変形例の音声合成装置への入力例を示す図である。図21および図22について、図1および図10と同じ構成要素については同じ符号を用い、その詳細な説明は繰り返さない。

図26は実施の形態4の音声合成装置の他の変形例の機能ブロック図であり、図27は実施の形態4の音声合成装置の他の変形例の動作を示すフローチャートである。図13および図14と同じ構成要素については同じ符号を用い、その詳細な説明は繰り返さない。

11 力み音韻位置決定部

12 力み実時間範囲決定部

13 周期信号生成部

14 振幅変調部

21 オールパスフィルタ

22、34、45、48 スイッチ

23 加算器

31 音素認識部

32 韻律分析部

33、44 力み範囲指定入力部

40 テキスト入力部

41 言語処理部

42 韻律生成部

43 波形生成部

46 力み音韻位置指定部

47 切り替え入力部

51 力み範囲指定取得部

Claims (22)

- 変換の対象となる音声中の力み音声に変換すべき音韻を指定する力み音韻位置指定手段と、

前記力み音韻位置指定手段により指定された音韻を表す音声波形に、40Hz以上でかつ120Hz以下の周波数の周期的な振幅変動を伴う変調を施す変調手段とを備える

ことを特徴とする力み変換装置。 - 前記変調手段は、前記力み音韻位置指定手段により指定された音韻を表す音声波形に、振幅の変動幅を百分率で定義した周期的な振幅変動の変調度が40%以上でかつ80%以下となる、周期的な振幅変動を伴う変調を施す

ことを特徴とする請求項1に記載の力み変換装置。 - 前記変調手段は、周期信号を音声波形に乗ずることにより周期的な振幅変動を伴う変調を前記音声波形に施す

ことを特徴とする請求項1または2に記載の力み変換装置。 - 前記変調手段は、

前記力み音韻位置指定手段により指定された音韻を表す音声波形の位相をずらすオールパスフィルタと、

前記力み音韻位置指定手段により指定された音韻を表す音声波形に、前記オールパスフィルタにより位相がずらされた音声波形を加算する加算手段とを備える

ことを特徴とする請求項1または2に記載の力み変換装置。 - さらに、前記力み音韻位置指定手段によって指定される、変換の対象となる音声中の音韻を含み得る音声の範囲を指定する力み範囲指定手段を備える

ことを特徴とする請求項1または2に記載の力み変換装置。 - 音声波形を受付ける入力手段と、

力み音声に変換すべき音韻を指定する力み音韻位置指定手段と、

前記力み音韻位置指定手段による力み音声に変換すべき音韻の指定に従って、前記入力手段で受付けられた音声波形のうち、前記力み音韻位置指定手段によって指定された前記力み音声に変換すべき音韻を表す音声波形の部分に、40Hz以上でかつ120Hz以下の周波数の周期的な振幅変動を伴う変調を施す変調手段とを備える

ことを特徴とする音声変換装置。 - さらに、前記力み音韻位置指定手段によって指定される、変換の対象となる音韻を含み得る音声の範囲を指定する力み範囲指定入力手段を備える

ことを特徴とする請求項6に記載の音声変換装置。 - さらに、

前記音声波形の音韻列を認識する音韻認識手段と、

前記音声波形の韻律情報を抽出する韻律分析手段とを備え、

前記力み音韻位置指定手段は、前記音韻認識手段により認識された入力音声の音韻列と前記韻律分析手段により抽出された韻律情報とに基づいて力み音声に変換すべき音韻を指定する

ことを特徴とする請求項6に記載の音声変換装置。 - 音声波形を受付ける入力手段と、

使用者による力み音声に変換すべき音韻を指定する入力を受け付ける力み音韻位置入力手段と、

前記力み音韻位置入力手段による力み音声に変換すべき音韻の指定に従って、前記入力手段で受付けられた音声波形のうち、前記力み音韻位置指定手段によって指定された前記力み音声に変換すべき音韻を表す音声波形の部分に、40Hz以上でかつ120Hz以下の周波数の周期的な振幅変動を伴う変調を施す変調手段とを備える

ことを特徴とする音声変換装置。 - テキストを受付ける入力手段と、

前記入力手段で受付けられた前記テキストを解析して読み情報と韻律情報とを生成する言語処理手段と、

前記読み情報と韻律情報とに従って音声波形を生成する音声合成手段と、

力み音声に変換すべき音韻を指定する力み音韻位置指定手段と、

前記音声合成手段で合成された音声波形のうち、前記力み音韻位置指定手段より指定された音韻を表す音声波形に、40Hz以上でかつ120Hz以下の周波数の周期的な振幅変動を伴う変調を施す変調手段とを備える

ことを特徴とする音声合成装置。 - さらに、前記力み音韻位置指定手段によって指定される力み音声を生成すべき音韻を含み得る範囲を指定する力み範囲指定入力手段を備える

ことを特徴とする請求項10に記載の音声合成装置。 - 前記入力手段は、変換すべき内容と共に、合成する音声の特性を指定する情報を含み、かつ当該情報は前記力み音声を生成すべき音韻を含みうる範囲の情報を含む、テキストを受付け、

前記音声合成装置は、前記入力手段で受付けられた前記テキストを解析して前記力み音声を生成すべき音韻を含みうる範囲を取得する力み範囲指定取得手段を備える

ことを特徴とする請求項10に記載の音声合成装置。 - 前記力み音韻位置指定手段は、前記言語処理手段により生成された読み情報と韻律情報とに基づいて力み音声に変換すべき音韻を指定する

ことを特徴とする請求項10に記載の音声合成装置。 - 前記力み音韻位置指定手段は、前記言語処理手段により生成された読み情報と前記音声合成手段により生成された音声波形の基本周波数、パワー、振幅、音韻時間長の少なくとも何れか一つとに基づいて、力み音声に変換すべき音韻を指定する

ことを特徴とする請求項10に記載の音声合成装置。 - さらに、使用者による力み音声に変換すべき音韻を指定する入力を受け付ける力み音韻位置入力手段を備え、

前記変調手段は、前記音声合成手段で合成された音声波形のうち、前記力み音韻位置入力手段により指定された音韻を表す音声波形に、周期的な振幅変動を伴う変調を施す

ことを特徴とする請求項10に記載の音声合成装置。 - 変換の対象となる音声中の力み音声に変換すべき部分を音韻単位で指定し、

前記指定された音韻位置において、40Hz以上でかつ120Hz以下の周波数の周期的な振幅変動を伴う変調を音声波形に施す

ことを特徴とする音声変換方法。 - 力み音声を生成すべき音韻を指定し、

前記指定された音韻位置において、40Hz以上でかつ120Hz以下の周波数の周期的な振幅変動を伴う変調を音声波形に施した合成音声を生成する

ことを特徴とする音声合成方法。 - 変換の対象となる音声中の力み音声に変換すべき部分を音韻単位で指定するステップと、

前記指定された音韻位置において、40Hz以上でかつ120Hz以下の周波数の周期的な振幅変動を伴う変調を音声波形に施すステップとをコンピュータに実行させる

ことを特徴とする音声変換プログラム。 - 力み音声を生成すべき音韻を指定するステップと、

前記指定された音韻位置において、40Hz以上でかつ120Hz以下の周波数の周期的な振幅変動を伴う変調を音声波形に施した合成音声を生成するステップとをコンピュータに実行させる

ことを特徴とする音声合成プログラム。 - 音声変換プログラムを記録したコンピュータ読取可能な記録媒体であって、

前記音声変換プログラムは、

変換の対象となる音声中の力み音声に変換すべき部分を音韻単位で指定するステップと、

前記指定された音韻位置において、40Hz以上でかつ120Hz以下の周波数の周期的な振幅変動を伴う変調を音声波形に施すステップとをコンピュータに実行させるためのプログラムである

ことを特徴とするコンピュータ読取可能な記録媒体。 - 音声合成プログラムを記録したコンピュータ読取可能な記録媒体であって、

前記音声合成プログラムは、

力み音声を生成すべき音韻を指定するステップと、

前記指定された音韻位置において、40Hz以上でかつ120Hz以下の周波数の周期的な振幅変動を伴う変調を音声波形に施した合成音声を生成するステップとをコンピュータに実行させるためのプログラムである

ことを特徴とするコンピュータ読取可能な記録媒体。 - 変換の対象となる音声中の力み音声に変換すべき音韻を指定する力み音韻位置指定手段と、

前記力み音韻位置指定手段により指定された音韻を表す音声波形の音源信号に、40Hz以上でかつ120Hz以下の周波数の周期的な振幅変動を伴う変調を施す変調手段とを備える

ことを特徴とする力み変換装置。

Applications Claiming Priority (3)

| Application Number | Priority Date | Filing Date | Title |

|---|---|---|---|

| JP2007038315 | 2007-02-19 | ||

| JP2007038315 | 2007-02-19 | ||

| PCT/JP2008/050815 WO2008102594A1 (ja) | 2007-02-19 | 2008-01-22 | 力み変換装置、音声変換装置、音声合成装置、音声変換方法、音声合成方法およびプログラム |

Publications (2)

| Publication Number | Publication Date |

|---|---|

| JP4355772B2 true JP4355772B2 (ja) | 2009-11-04 |

| JPWO2008102594A1 JPWO2008102594A1 (ja) | 2010-05-27 |

Family

ID=39709873

Family Applications (1)

| Application Number | Title | Priority Date | Filing Date |

|---|---|---|---|

| JP2009500111A Expired - Fee Related JP4355772B2 (ja) | 2007-02-19 | 2008-01-22 | 力み変換装置、音声変換装置、音声合成装置、音声変換方法、音声合成方法およびプログラム |

Country Status (4)

| Country | Link |

|---|---|

| US (1) | US8898062B2 (ja) |

| JP (1) | JP4355772B2 (ja) |

| CN (1) | CN101606190B (ja) |

| WO (1) | WO2008102594A1 (ja) |

Families Citing this family (40)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| JP5119700B2 (ja) * | 2007-03-20 | 2013-01-16 | 富士通株式会社 | 韻律修正装置、韻律修正方法、および、韻律修正プログラム |

| CN101578659B (zh) * | 2007-05-14 | 2012-01-18 | 松下电器产业株式会社 | 音质转换装置及音质转换方法 |

| JP5582135B2 (ja) * | 2009-02-18 | 2014-09-03 | 日本電気株式会社 | 動作対象制御装置、動作対象制御システム、動作対象制御方法及びプログラム |

| JP5625482B2 (ja) * | 2010-05-21 | 2014-11-19 | ヤマハ株式会社 | 音響処理装置、音処理システムおよび音処理方法 |

| US10002608B2 (en) * | 2010-09-17 | 2018-06-19 | Nuance Communications, Inc. | System and method for using prosody for voice-enabled search |

| US20140207456A1 (en) * | 2010-09-23 | 2014-07-24 | Waveform Communications, Llc | Waveform analysis of speech |

| US20130030789A1 (en) * | 2011-07-29 | 2013-01-31 | Reginald Dalce | Universal Language Translator |

| WO2013018294A1 (ja) * | 2011-08-01 | 2013-02-07 | パナソニック株式会社 | 音声合成装置および音声合成方法 |

| CN105122351B (zh) * | 2013-01-18 | 2018-11-13 | 株式会社东芝 | 声音合成装置及声音合成方法 |

| JP6263868B2 (ja) * | 2013-06-17 | 2018-01-24 | 富士通株式会社 | 音声処理装置、音声処理方法および音声処理プログラム |

| US9310800B1 (en) * | 2013-07-30 | 2016-04-12 | The Boeing Company | Robotic platform evaluation system |

| US9484036B2 (en) * | 2013-08-28 | 2016-11-01 | Nuance Communications, Inc. | Method and apparatus for detecting synthesized speech |

| WO2015057661A1 (en) * | 2013-10-14 | 2015-04-23 | The Penn State Research Foundation | System and method for automated speech recognition |

| JP6497025B2 (ja) * | 2013-10-17 | 2019-04-10 | ヤマハ株式会社 | 音声処理装置 |

| JP2016080827A (ja) * | 2014-10-15 | 2016-05-16 | ヤマハ株式会社 | 音韻情報合成装置および音声合成装置 |

| JP6507579B2 (ja) * | 2014-11-10 | 2019-05-08 | ヤマハ株式会社 | 音声合成方法 |

| JP5995226B2 (ja) * | 2014-11-27 | 2016-09-21 | インターナショナル・ビジネス・マシーンズ・コーポレーションInternational Business Machines Corporation | 音響モデルを改善する方法、並びに、音響モデルを改善する為のコンピュータ及びそのコンピュータ・プログラム |

| JP2016186516A (ja) * | 2015-03-27 | 2016-10-27 | 日本電信電話株式会社 | 疑似音声信号生成装置、音響モデル適応装置、疑似音声信号生成方法、およびプログラム |

| CN106531191A (zh) * | 2015-09-10 | 2017-03-22 | 百度在线网络技术(北京)有限公司 | 用于提供危险报告信息的方法和装置 |

| CN106980624B (zh) * | 2016-01-18 | 2021-03-26 | 阿里巴巴集团控股有限公司 | 一种文本数据的处理方法和装置 |

| EP3537432A4 (en) * | 2016-11-07 | 2020-06-03 | Yamaha Corporation | LANGUAGE SYNTHESIS PROCEDURE |

| WO2018090356A1 (en) * | 2016-11-21 | 2018-05-24 | Microsoft Technology Licensing, Llc | Automatic dubbing method and apparatus |

| US10872598B2 (en) * | 2017-02-24 | 2020-12-22 | Baidu Usa Llc | Systems and methods for real-time neural text-to-speech |

| JP2018159759A (ja) * | 2017-03-22 | 2018-10-11 | 株式会社東芝 | 音声処理装置、音声処理方法およびプログラム |

| JP6646001B2 (ja) * | 2017-03-22 | 2020-02-14 | 株式会社東芝 | 音声処理装置、音声処理方法およびプログラム |

| US10818308B1 (en) * | 2017-04-28 | 2020-10-27 | Snap Inc. | Speech characteristic recognition and conversion |

| US10896669B2 (en) | 2017-05-19 | 2021-01-19 | Baidu Usa Llc | Systems and methods for multi-speaker neural text-to-speech |

| US10796686B2 (en) | 2017-10-19 | 2020-10-06 | Baidu Usa Llc | Systems and methods for neural text-to-speech using convolutional sequence learning |

| US10872596B2 (en) | 2017-10-19 | 2020-12-22 | Baidu Usa Llc | Systems and methods for parallel wave generation in end-to-end text-to-speech |

| US11017761B2 (en) | 2017-10-19 | 2021-05-25 | Baidu Usa Llc | Parallel neural text-to-speech |

| KR102348124B1 (ko) * | 2017-11-07 | 2022-01-07 | 현대자동차주식회사 | 차량의 기능 추천 장치 및 방법 |

| EP3739572A4 (en) * | 2018-01-11 | 2021-09-08 | Neosapience, Inc. | METHOD AND DEVICE FOR TEXT-TO-LANGUAGE SYNTHESIS USING MACHINE LEARNING AND COMPUTER-READABLE STORAGE MEDIUM |

| JP6902485B2 (ja) * | 2018-02-20 | 2021-07-14 | 日本電信電話株式会社 | 音声信号解析装置、方法、及びプログラム |

| US10981073B2 (en) * | 2018-10-22 | 2021-04-20 | Disney Enterprises, Inc. | Localized and standalone semi-randomized character conversations |

| CN110136687B (zh) * | 2019-05-20 | 2021-06-15 | 深圳市数字星河科技有限公司 | 一种基于语音训练克隆口音及声韵方法 |

| JP2021135729A (ja) * | 2020-02-27 | 2021-09-13 | パナソニックIpマネジメント株式会社 | 料理レシピ表示システム、料理レシピの表示方法及びプログラム |

| JP7394411B2 (ja) * | 2020-09-08 | 2023-12-08 | パナソニックIpマネジメント株式会社 | 音信号処理システム、及び、音信号処理方法 |

| JP2022081790A (ja) * | 2020-11-20 | 2022-06-01 | 株式会社日立製作所 | 音声合成装置、音声合成方法、および音声合成プログラム |

| US11948550B2 (en) * | 2021-05-06 | 2024-04-02 | Sanas.ai Inc. | Real-time accent conversion model |

| CN113793598B (zh) * | 2021-09-15 | 2023-10-27 | 北京百度网讯科技有限公司 | 语音处理模型的训练方法和数据增强方法、装置及设备 |

Family Cites Families (40)

| Publication number | Priority date | Publication date | Assignee | Title |

|---|---|---|---|---|

| US3510588A (en) * | 1967-06-16 | 1970-05-05 | Santa Rita Technology Inc | Speech synthesis methods and apparatus |

| JPS5331323B2 (ja) * | 1972-11-13 | 1978-09-01 | ||

| JPH03174597A (ja) | 1989-12-04 | 1991-07-29 | Ricoh Co Ltd | 音声合成装置 |

| JP3070127B2 (ja) * | 1991-05-07 | 2000-07-24 | 株式会社明電舎 | 音声合成装置のアクセント成分制御方式 |

| US5748838A (en) * | 1991-09-24 | 1998-05-05 | Sensimetrics Corporation | Method of speech representation and synthesis using a set of high level constrained parameters |

| US5559927A (en) * | 1992-08-19 | 1996-09-24 | Clynes; Manfred | Computer system producing emotionally-expressive speech messages |

| JPH0772900A (ja) | 1993-09-02 | 1995-03-17 | Nippon Hoso Kyokai <Nhk> | 音声合成の感情付与方法 |

| FR2717294B1 (fr) * | 1994-03-08 | 1996-05-10 | France Telecom | Procédé et dispositif de synthèse dynamique sonore musicale et vocale par distorsion non linéaire et modulation d'amplitude. |

| JPH086591A (ja) * | 1994-06-15 | 1996-01-12 | Sony Corp | 音声出力装置 |

| JP3910702B2 (ja) * | 1997-01-20 | 2007-04-25 | ローランド株式会社 | 波形発生装置 |

| JPH10319947A (ja) * | 1997-05-15 | 1998-12-04 | Kawai Musical Instr Mfg Co Ltd | 音域制御装置 |

| US6304846B1 (en) * | 1997-10-22 | 2001-10-16 | Texas Instruments Incorporated | Singing voice synthesis |

| JP3502247B2 (ja) * | 1997-10-28 | 2004-03-02 | ヤマハ株式会社 | 音声変換装置 |

| US6353671B1 (en) * | 1998-02-05 | 2002-03-05 | Bioinstco Corp. | Signal processing circuit and method for increasing speech intelligibility |

| JP3587048B2 (ja) * | 1998-03-02 | 2004-11-10 | 株式会社日立製作所 | 韻律制御方法及び音声合成装置 |

| TW430778B (en) * | 1998-06-15 | 2001-04-21 | Yamaha Corp | Voice converter with extraction and modification of attribute data |

| US6289310B1 (en) * | 1998-10-07 | 2001-09-11 | Scientific Learning Corp. | Apparatus for enhancing phoneme differences according to acoustic processing profile for language learning impaired subject |

| US6865533B2 (en) * | 2000-04-21 | 2005-03-08 | Lessac Technology Inc. | Text to speech |

| JP2002006900A (ja) * | 2000-06-27 | 2002-01-11 | Megafusion Corp | 音声還元再生システム及び音声還元再生方法 |

| JP4651168B2 (ja) * | 2000-08-23 | 2011-03-16 | 任天堂株式会社 | 合成音声出力装置およびその方法並びに記録媒体 |

| JP3716725B2 (ja) * | 2000-08-28 | 2005-11-16 | ヤマハ株式会社 | 音声処理装置、音声処理方法および情報記録媒体 |

| US7139699B2 (en) * | 2000-10-06 | 2006-11-21 | Silverman Stephen E | Method for analysis of vocal jitter for near-term suicidal risk assessment |

| US6629076B1 (en) * | 2000-11-27 | 2003-09-30 | Carl Herman Haken | Method and device for aiding speech |

| JP3703394B2 (ja) | 2001-01-16 | 2005-10-05 | シャープ株式会社 | 声質変換装置および声質変換方法およびプログラム記憶媒体 |

| JP2002258886A (ja) * | 2001-03-02 | 2002-09-11 | Sony Corp | 音声合成装置および音声合成方法、並びにプログラムおよび記録媒体 |

| JP2002268699A (ja) | 2001-03-09 | 2002-09-20 | Sony Corp | 音声合成装置及び音声合成方法、並びにプログラムおよび記録媒体 |

| US20030093280A1 (en) * | 2001-07-13 | 2003-05-15 | Pierre-Yves Oudeyer | Method and apparatus for synthesising an emotion conveyed on a sound |

| JP3967571B2 (ja) * | 2001-09-13 | 2007-08-29 | ヤマハ株式会社 | 音源波形生成装置、音声合成装置、音源波形生成方法およびプログラム |

| US7562018B2 (en) * | 2002-11-25 | 2009-07-14 | Panasonic Corporation | Speech synthesis method and speech synthesizer |

| JP3706112B2 (ja) | 2003-03-12 | 2005-10-12 | 独立行政法人科学技術振興機構 | 音声合成装置及びコンピュータプログラム |

| CN100550131C (zh) * | 2003-05-20 | 2009-10-14 | 松下电器产业株式会社 | 用于扩展音频信号的频带的方法及其装置 |

| JP4177751B2 (ja) | 2003-12-25 | 2008-11-05 | 株式会社国際電気通信基礎技術研究所 | 声質モデル生成方法、声質変換方法、並びにそれらのためのコンピュータプログラム、当該プログラムを記録した記録媒体、及び当該プログラムによりプログラムされたコンピュータ |

| US8023673B2 (en) * | 2004-09-28 | 2011-09-20 | Hearworks Pty. Limited | Pitch perception in an auditory prosthesis |

| US7561709B2 (en) * | 2003-12-31 | 2009-07-14 | Hearworks Pty Limited | Modulation depth enhancement for tone perception |

| JP4829477B2 (ja) | 2004-03-18 | 2011-12-07 | 日本電気株式会社 | 声質変換装置および声質変換方法ならびに声質変換プログラム |

| JP3851328B2 (ja) | 2004-09-15 | 2006-11-29 | 独立行政法人科学技術振興機構 | 音声データの息漏れ領域自動検出装置および息漏れ領域自動検出プログラム |

| JP4701684B2 (ja) | 2004-11-19 | 2011-06-15 | ヤマハ株式会社 | 音声処理装置およびプログラム |

| JP2006227589A (ja) | 2005-01-20 | 2006-08-31 | Matsushita Electric Ind Co Ltd | 音声合成装置および音声合成方法 |

| US8073696B2 (en) * | 2005-05-18 | 2011-12-06 | Panasonic Corporation | Voice synthesis device |

| WO2007010680A1 (ja) * | 2005-07-20 | 2007-01-25 | Matsushita Electric Industrial Co., Ltd. | 声質変化箇所特定装置 |

-

2008

- 2008-01-22 JP JP2009500111A patent/JP4355772B2/ja not_active Expired - Fee Related

- 2008-01-22 US US12/438,860 patent/US8898062B2/en not_active Expired - Fee Related

- 2008-01-22 WO PCT/JP2008/050815 patent/WO2008102594A1/ja active Application Filing

- 2008-01-22 CN CN2008800010519A patent/CN101606190B/zh not_active Expired - Fee Related

Also Published As

| Publication number | Publication date |

|---|---|

| WO2008102594A1 (ja) | 2008-08-28 |

| CN101606190B (zh) | 2012-01-18 |

| JPWO2008102594A1 (ja) | 2010-05-27 |

| CN101606190A (zh) | 2009-12-16 |

| US8898062B2 (en) | 2014-11-25 |

| US20090204395A1 (en) | 2009-08-13 |

Similar Documents

| Publication | Publication Date | Title |

|---|---|---|

| JP4355772B2 (ja) | 力み変換装置、音声変換装置、音声合成装置、音声変換方法、音声合成方法およびプログラム | |

| JP4125362B2 (ja) | 音声合成装置 | |

| US8719030B2 (en) | System and method for speech synthesis | |

| US8898055B2 (en) | Voice quality conversion device and voice quality conversion method for converting voice quality of an input speech using target vocal tract information and received vocal tract information corresponding to the input speech | |

| JP4327241B2 (ja) | 音声強調装置および音声強調方法 | |

| JP4456537B2 (ja) | 情報伝達装置 | |

| JP2004522186A (ja) | 音声合成器の音声固有化 | |

| JP5039865B2 (ja) | 声質変換装置及びその方法 | |

| JPH031200A (ja) | 規則型音声合成装置 | |

| JP2010014913A (ja) | 声質変換音声生成装置および声質変換音声生成システム | |

| JP2001034280A (ja) | 電子メール受信装置および電子メールシステム | |

| JP2006227589A (ja) | 音声合成装置および音声合成方法 | |

| JP2904279B2 (ja) | 音声合成方法および装置 | |

| Pfitzinger | Unsupervised speech morphing between utterances of any speakers | |

| JP2013033103A (ja) | 声質変換装置および声質変換方法 | |

| JP2006030609A (ja) | 音声合成データ生成装置、音声合成装置、音声合成データ生成プログラム及び音声合成プログラム | |

| JP3437064B2 (ja) | 音声合成装置 | |

| JP3785892B2 (ja) | 音声合成装置及び記録媒体 | |

| JP3575919B2 (ja) | テキスト音声変換装置 | |

| JP3394281B2 (ja) | 音声合成方式および規則合成装置 | |

| JP3967571B2 (ja) | 音源波形生成装置、音声合成装置、音源波形生成方法およびプログラム | |

| JP2004004952A (ja) | 音声合成装置および音声合成方法 | |

| Lavner et al. | Voice morphing using 3D waveform interpolation surfaces and lossless tube area functions | |

| Thakur et al. | Study of various kinds of speech synthesizer technologies and expression for expressive text to speech conversion system | |

| Venkatagiri | Digital speech technology: An overview |

Legal Events

| Date | Code | Title | Description |

|---|---|---|---|

| TRDD | Decision of grant or rejection written | ||

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 Effective date: 20090707 |

|

| A01 | Written decision to grant a patent or to grant a registration (utility model) |

Free format text: JAPANESE INTERMEDIATE CODE: A01 |

|

| A61 | First payment of annual fees (during grant procedure) |

Free format text: JAPANESE INTERMEDIATE CODE: A61 Effective date: 20090803 |

|

| R150 | Certificate of patent or registration of utility model |

Free format text: JAPANESE INTERMEDIATE CODE: R150 Ref document number: 4355772 Country of ref document: JP Free format text: JAPANESE INTERMEDIATE CODE: R150 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20120807 Year of fee payment: 3 |

|

| FPAY | Renewal fee payment (event date is renewal date of database) |

Free format text: PAYMENT UNTIL: 20130807 Year of fee payment: 4 |

|

| S111 | Request for change of ownership or part of ownership |

Free format text: JAPANESE INTERMEDIATE CODE: R313113 |

|

| R350 | Written notification of registration of transfer |

Free format text: JAPANESE INTERMEDIATE CODE: R350 |

|

| R250 | Receipt of annual fees |

Free format text: JAPANESE INTERMEDIATE CODE: R250 |

|

| LAPS | Cancellation because of no payment of annual fees |