本文档提供了各种人类偏好对齐算法的训练脚本。若您希望深入了解更详尽的算法信息及其选择方法,请参考文档

# 设置pip全局镜像 (加速下载)

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple/

# 安装ms-swift

git clone https://github.com/modelscope/swift.git

cd swift

pip install -e '.[llm]'

# 环境对齐 (通常不需要运行. 如果你运行错误, 可以跑下面的代码, 仓库使用最新环境测试)

pip install -r requirements/framework.txt -U

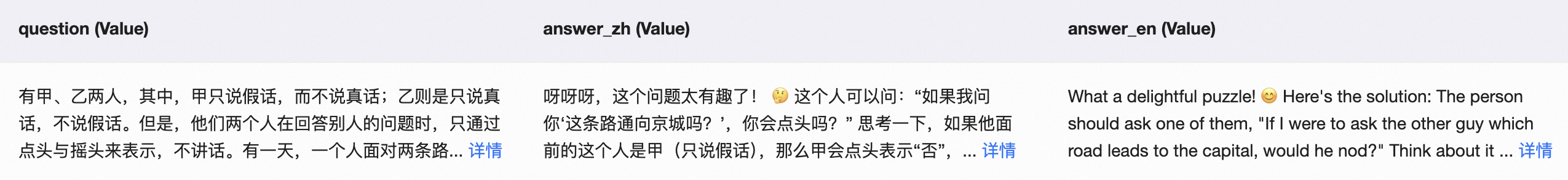

pip install -r requirements/llm.txt -U人类偏好对齐训练一般需要

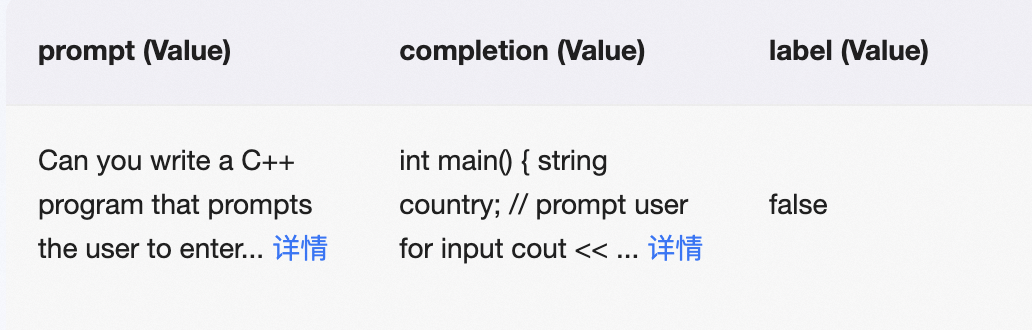

其中KTO算法的数据比较特殊,只需要$(x,y,\text{label})$格式的数据,其中$x$表示模型输入,$y$表示模型输出,label表示回答是否符合人类偏好

比如

KTO也可以使用第一种数据格式进行训练,训练脚本上的差异见KTO章节。

训练提示:

- 如果用带有history的数据训练base模型,需要指定支持多轮对话的template(base模型往往不支持多轮对话),对于这种情况我们默认设置了

chatmltemplate,你也可以使用--model_type来选择训练模型的template - 使用自定义数据集进行训练请参考自定义与拓展

- 下面的训练脚本使用

--lora_target_modules ALL来训练模型的全部线性层,你也可以设置--lora_target_modules DEFAULT只训练模型的QKV矩阵

超参

beta:KL正则系数,值越大表示对偏离参考模型的惩罚越大。默认为0.1

建议在开始DPO训练之前,使用偏好数据集中的偏好回答部分进行SFT训练,以确保数据符合DPO算法的分布要求。

我们也在DPO loss中混合了sft loss来稳定训练,你可以通过设置超参sft_beta来调整sft loss的系数,默认为0.1

训练脚本, 这里我们提供单卡/多卡device map/多卡ddp的版本,简洁起见,后续算法只给出单卡版本。

# Experimental environment: A100

# Memory usage: 40G

CUDA_VISIBLE_DEVICES=0 \

swift rlhf \

--rlhf_type dpo \

--model_type llama3-8b-instruct \

--beta 0.1 \

--sft_beta 0.1 \

--sft_type lora \

--dataset shareai-llama3-dpo-zh-en-emoji \

--num_train_epochs 2 \

--lora_target_modules ALL \

--gradient_checkpointing true \

--batch_size 1 \

--learning_rate 5e-5 \

--gradient_accumulation_steps 16 \

--warmup_ratio 0.03 \

--save_total_limit 2

# MP(device map)

# Memory usage: 2*24G

CUDA_VISIBLE_DEVICES=0,1 \

swift rlhf \

--rlhf_type dpo \

--model_type llama3-8b-instruct \

--beta 0.1 \

--sft_beta 0.1 \

--sft_type lora \

--dataset shareai-llama3-dpo-zh-en-emoji \

--num_train_epochs 2 \

--lora_target_modules ALL \

--gradient_checkpointing true \

--batch_size 1 \

--learning_rate 5e-5 \

--gradient_accumulation_steps 16 \

--warmup_ratio 0.03 \

--save_total_limit 2

# DDP + MP

# Memory usage: 4*24G

CUDA_VISIBLE_DEVICES=0,1,2,3 \

NPROC_PER_NODE=2 \

swift rlhf \

--rlhf_type dpo \

--model_type llama3-8b-instruct \

--beta 0.1 \

--sft_beta 0.1 \

--sft_type lora \

--dataset shareai-llama3-dpo-zh-en-emoji \

--num_train_epochs 2 \

--lora_target_modules ALL \

--gradient_checkpointing true \

--batch_size 1 \

--learning_rate 5e-5 \

--gradient_accumulation_steps $(expr 16 / $nproc_per_node) \

--warmup_ratio 0.03 \

--save_total_limit 2训练后的模型推理和部署可以参考LLM推理文档和VLLM推理加速与部署文档

超参

- beta: KL正则系数,值越大表示对偏离参考模型的惩罚越大。默认为0.1

- desirable_weight :损失函数中的$\lambda_D$项,偏好回答样本的损失权重, 默认为1.0

- undesirable_weight :损失函数中的$\lambda_U$项,拒绝回答样本的损失权重,默认为1.0

用

训练脚本

使用

CUDA_VISIBLE_DEVICES=0 \

swift rlhf \

--rlhf_type kto \

--model_type llama3-8b-instruct \

--beta 0.1 \

--desirable_weight 1.0 \

--undesirable_weight 1.0 \

--sft_type lora \

--dataset ultrafeedback-kto \

--num_train_epochs 2 \

--lora_target_modules ALL \

--gradient_checkpointing true \

--batch_size 1 \

--learning_rate 5e-5 \

--gradient_accumulation_steps 16 \

--warmup_ratio 0.03 \

--save_total_limit 2使用$(x,y_w,y_l)$格式数据训练

CUDA_VISIBLE_DEVICES=0 \

swift rlhf \

--rlhf_type dpo \

--loss_type kto_pair \

--model_type llama3-8b-instruct \

--beta 0.1 \

--desirable_weight 1.0 \

--undesirable_weight 1.0 \

--sft_type lora \

--dataset shareai-llama3-dpo-zh-en-emoji \

--num_train_epochs 2 \

--lora_target_modules ALL \

--gradient_checkpointing true \

--batch_size 1 \

--learning_rate 5e-5 \

--gradient_accumulation_steps 16 \

--warmup_ratio 0.03 \

--save_total_limit 2论文arvix 超参

- beta:隐含奖励前的系数,默认为0.1

训练脚本

CUDA_VISIBLE_DEVICES=0 \

swift rlhf \

--rlhf_type cpo \

--model_type llama3-8b-instruct \

--beta 0.1 \

--sft_type lora \

--dataset shareai-llama3-dpo-zh-en-emoji \

--num_train_epochs 2 \

--lora_target_modules ALL \

--gradient_checkpointing true \

--batch_size 1 \

--learning_rate 5e-5 \

--gradient_accumulation_steps 16 \

--warmup_ratio 0.03 \

--save_total_limit 2超参

- lambda: Odds Ratio loss系数

注意:ORPO使用参数--beta传入超参lambda

CUDA_VISIBLE_DEVICES=0 \

swift rlhf \

--rlhf_type orpo \

--model_type llama3-8b-instruct \

--beta 0.1 \

--sft_type lora \

--dataset shareai-llama3-dpo-zh-en-emoji \

--num_train_epochs 2 \

--lora_target_modules ALL \

--gradient_checkpointing true \

--batch_size 1 \

--learning_rate 5e-5 \

--gradient_accumulation_steps 16 \

--warmup_ratio 0.03 \

--save_total_limit 2论文arvix 超参

- beta:隐含奖励前的系数,默认为2.0

- simpo_gamma:reward margin项,默认为1.0

CUDA_VISIBLE_DEVICES=0 \

swift rlhf \

--rlhf_type simpo \

--model_type llama3-8b-instruct \

--beta 2.0 \

--simpo_gamma 1.0 \

--sft_type lora \

--dataset shareai-llama3-dpo-zh-en-emoji \

--num_train_epochs 2 \

--lora_target_modules ALL \

--gradient_checkpointing true \

--batch_size 1 \

--learning_rate 5e-5 \

--gradient_accumulation_steps 16 \

--warmup_ratio 0.03 \

--save_total_limit 2